Deep Learning的数学思考

2017-11-06 10:56

120 查看

本博文总结了deep learning中的一些数学思考!!!

残差是观测值和回归预测值之差。一般认为残差服从N(0,sigma2)分布,sigma是标准差。

(2)标准残差

标准残差是残差与残差的标准差的比值:r/(sigma),标准残差可以用来分析异常值(outlier),因为标准残差服从N(0,1)标准正太分布,可以认为,标准残差如果大于阈值(3 sigma原则),那么我们有很大概率认为(超过99%)它是一个outlier。

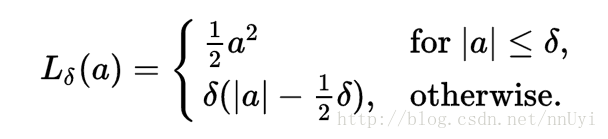

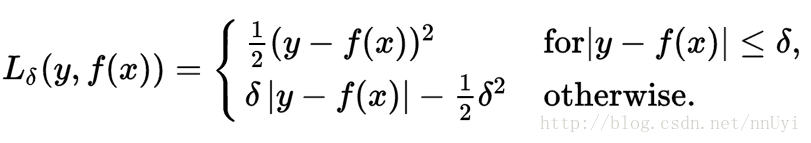

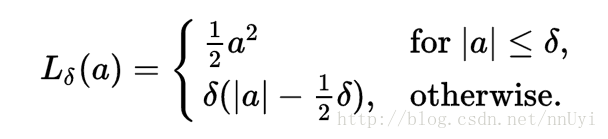

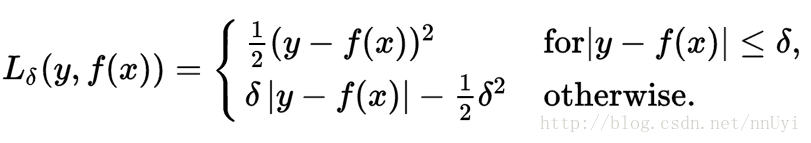

Huber loss函数是一个平滑性比较好的,变化速度平缓的函数。一般可以用于描述残差r,也即可以将a设置为r。就可以得到下面的式子:

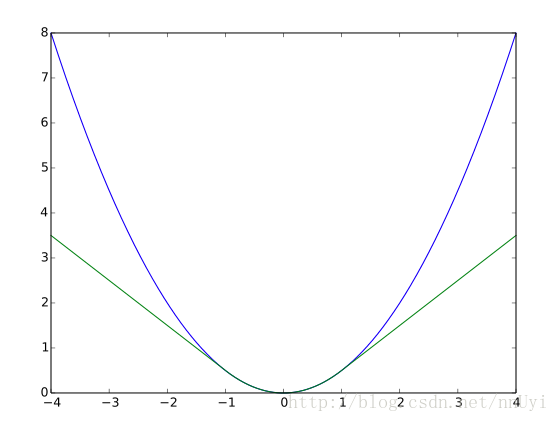

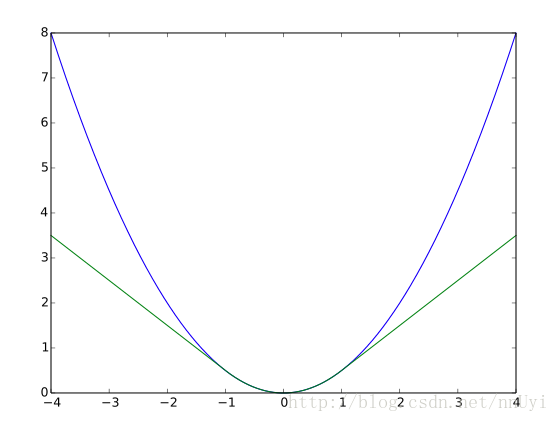

Huber loss函数用于描述残差r具有较好的性质,其一,当残差很大的时候,如果使用的是二次函数,由于二次函数在远离对称轴的值会被迅速放大,很容易造成一个outlier严重影响了整个loss的情况。而Huber loss函数可以减缓outlier对全局的影响,Huber loss和二次函数的比较如下图所示:

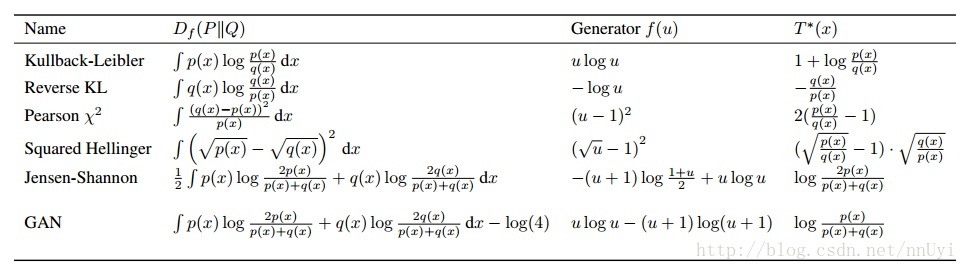

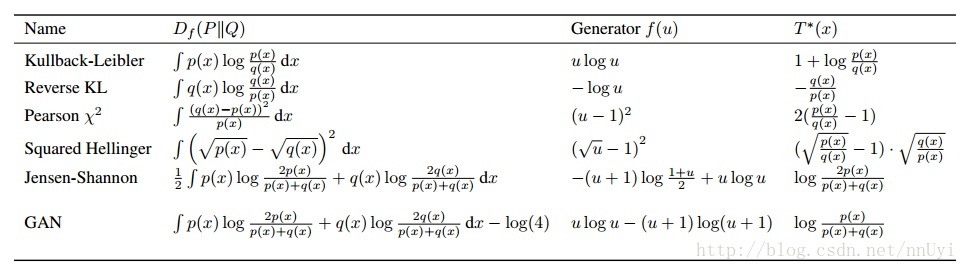

生成对抗网络中使用到的各种散度如上图所示,原始GAN优化G实际上是最小化JS散度,而LSGAN(least-square)优化G实际上是最小化X2Pearson散度

未完待续。。。

参考文献

1.https://en.wikipedia.org/wiki/Huber_loss

1.残差和标准残差

(1)残差残差是观测值和回归预测值之差。一般认为残差服从N(0,sigma2)分布,sigma是标准差。

(2)标准残差

标准残差是残差与残差的标准差的比值:r/(sigma),标准残差可以用来分析异常值(outlier),因为标准残差服从N(0,1)标准正太分布,可以认为,标准残差如果大于阈值(3 sigma原则),那么我们有很大概率认为(超过99%)它是一个outlier。

2.Huber Loss

Huber loss函数是一个平滑性比较好的,变化速度平缓的函数。一般可以用于描述残差r,也即可以将a设置为r。就可以得到下面的式子:

Huber loss函数用于描述残差r具有较好的性质,其一,当残差很大的时候,如果使用的是二次函数,由于二次函数在远离对称轴的值会被迅速放大,很容易造成一个outlier严重影响了整个loss的情况。而Huber loss函数可以减缓outlier对全局的影响,Huber loss和二次函数的比较如下图所示:

3.divergence

生成对抗网络中使用到的各种散度如上图所示,原始GAN优化G实际上是最小化JS散度,而LSGAN(least-square)优化G实际上是最小化X2Pearson散度

未完待续。。。

参考文献

1.https://en.wikipedia.org/wiki/Huber_loss

相关文章推荐

- 一道数学题引发的思考

- 程序员的数学之余数:星期数的思考

- 深度学习(Deep Learning)读书思考三:正则化

- 离散数学引发的脑科学思考

- HP49G+ 一个能够重新让你思考什么是数学的计算器

- 一个MIT计算机博士对数学的思考

- 数学闯关引发的思考

- 2017.8.7 数学作业 思考记录

- word2vec中数学原理详解以及原理思考

- 深度学习(Deep Learning)读书思考四:模型训练优化

- 深度学习(Deep Learning)读书思考五:卷积神经网络(CNN)

- 2017.9.5 组合数学 思考记录

- 林达华 Dahua Lin 对数学的新思考

- 组队完成任务的数学思考

- 深度学习(Deep Learning)读书思考六:循环神经网络一(RNN)

- 一道数学题的思考

- 行列式的各种疑问和数学自己思考的疑问

- 组队完成任务的数学思考

- 深度学习(Deep Learning)读书思考七:循环神经网络二(LSTM)

- 数学是一种思考方式