聚类

在“无监督学习”(ps:有x无y类型的数据)中,训练样本的标记信息是未知的,目标是通过对无标记训练样本的学习来揭示数据的内在性质及规律,为进一步得到数据分析提供基础。这类学习任务中研究最多、应用最广的是“聚类”。聚类试图将数据集中的样本划分若干个通常是不相交的子集,每个子集称之为一个簇。通过这样的划分,每个簇可能对应于一些潜在的概念或类别。注意:这些概念对聚类算法而言事先是未知的,聚类过程仅能自动形成簇结构,簇所对应的概念语义需由使用者来把握和命名。

基于不同的学习策略,人们设计出多种类型的聚类算法。在介绍相应的算法之前,我们先讨论聚类算法涉及到的性能度量和距离计算,在接着介绍相关的聚类算法。

1. 性能度量

也称为“有效性指标”,来评估聚类结果好坏,也可以直接将其作为聚类过程的优化目标,从而很好地得到符合要求的聚类结果。

直观上看,聚类是“物以类聚”,即同一簇的样本尽可能彼此相似,不同簇的样本尽可能不同。总之,聚类结果的“簇内相似度”高且“簇间相似度”低。

聚类性能度量大致有两类:

- 将聚类结果与某个参考模型进行比较-----外部指标;常用的聚类性能度量外部指标有:

1. Jaccard系数(Jaccard Coeffecient,JC)

2. FM指数(Fowlkes and Mallows Index, FMI)

3. Rand指数(Rand Index, RI)

上述性能度量的结果值均在[0,1]区间,值越大越好。

- 直接考察聚类结果而不利用任何参考模型----内部指标。

1. DB指数(Davies-Bouldin Index, BDI)

2. Dunn指数(Dunn Index, DI)

DBI的值越小越好,而DI则相反,值越大越好。

2. 距离计算

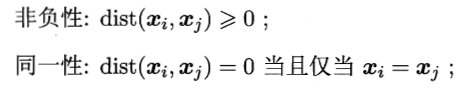

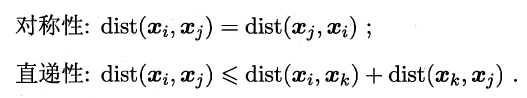

距离度量需满足一些基本性质:

最常用的是“闵可夫斯基距离”(Minkowski distance),给定样本

,距离为:

,距离为:

这个式子,当p≥1时,满足距离度量的基本性质。距离越大,相似度越小。特别地,当p=2时,闵可夫斯基距离就是欧式距离;当p=1时,闵可夫斯基距离就是曼哈顿距离。

3. 聚类算法

3.1 原型聚类

原型聚类即“基于原型的聚类”,此类算法假设聚类结构能通过一组原型刻画,在现实聚类任务中极为常用。算法先对原型进行初始化,然后对原型进行迭代更新求解。采用不同的原型表示、不同的求解方式,将产生不同的算法。

(1)k均值算法:对聚类所得簇划分以最小化平方误差的方式训练模型,采用贪心策略,通过迭代优化来近似求解。

(2)学习向量量化:Leaening Vector Quantization, LVQ, 与k均值算法类似,也是试图尝试找到一组原型向量来刻画聚类结构,但与一般聚类算法不用,LVQ假设数据样本带有类别标记,学习过程利用样本的这些监督信息来辅助聚类。

(3)高斯混合聚类:采用概率模型来表达聚类原型,簇划分则由原型对应后验概率确定。

3.2 密度聚类

也称“基于密度的聚类”,此算法假设聚类结构能通过样本分布的紧密程度确定。通常情形下,密度聚类算法从样本密度的角度来考察样本之间的可连接性,并基于可连接样本不断扩展聚类簇以获得最终的聚类结果。-DBSCAN算法等。

3.3 层次聚类

试图在不同层次对数据集进行划分,从而形成树形的聚类结构。数据集的划分可采用自底向上得到聚合策略,也可采用自顶向下的分拆策略。--AGNES算法等。

- 空间聚类(等回来之后完成)

- 聚类方法初探

- 聚类基本数学模型

- 大地__对于数据的聚类参与相关性的获取

- 图像颜色聚类分割算法_KMean

- 《数据挖掘概念与技术》学习笔记第8章(8/10)聚类分析

- 聚类分析、判别分析、相关分析、回归分析、因子分析、生存分析、方差分析简单定义

- K-means聚类的java实现

- 随机计算TFIDF作为权重,然后利用余弦距离进行聚类,用的是简单k-means算法。

- 聚类存储过程分析

- 分类和聚类的区别

- K-means算法的java实现,聚类分析681个三国武将

- 分类与聚类的区别

- Mahout聚类

- 模糊数学聚类分析之葡萄酒分级

- 检索结果聚类

- 中文文本聚类小尝试(Text Clustering in R)

- mahout读书笔记 -- 聚类(1)

- 大数据:聚类

- R语言之聚类