贝叶斯分类器

贝叶斯决策论:是概率框架下实施决策的基本方法。对分类任务来说,在所有相关概率都已知的理想情形下,贝叶斯决策论考虑如何基于这些概率和误判损失来选择最优的类别标记。

1. 贝叶斯优化目标:

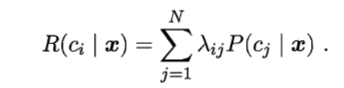

样本x上的“条件风险”为:

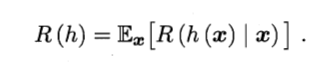

我们的任务是寻找一个判定准则h:X——Y以最小化总体风险:

显然,对每个样本x,若h能最小化条件风险

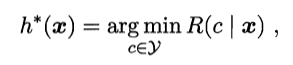

,则总体风险R(h)也将被最小化。--------产生了贝叶斯判定准则:为最小化总体风险,只需在每个样本上选择那个能使条件风险R(c|x)最小的类别标记,即

,则总体风险R(h)也将被最小化。--------产生了贝叶斯判定准则:为最小化总体风险,只需在每个样本上选择那个能使条件风险R(c|x)最小的类别标记,即

此时,h*称为贝叶斯最优分类器,与之对应的总体风险R(h*)称贝叶斯风险。1 - R(h*)反映了分类器所能达到得到最好性能,即通过机器学习所能产生的模型精度的理论上限。

简而言之:最小化分类错误率。

不难看出,欲使用贝叶斯判定准则来最小化决策风险,首先要获得后验概率P(c|x)。然而,在现实任务中这通常难以直接获得。从这个角度来看,机器学习所要实现的是基于有限的训练样本集尽可能准确地估计出这个后验概率。大体说来,主要有两种策略:

- 判别式模型:给定x,可用过直接建模该后验概率来预测c,这样得到的是“判别式模型”;-----代表:决策树、BP神经网络、支持向量机等。

- 生成式模型:先对联合概率分布P(x,c)建模,然后再由此获得P(c|x),这样得到的是“生成式模型”。----代表:贝叶斯分类。

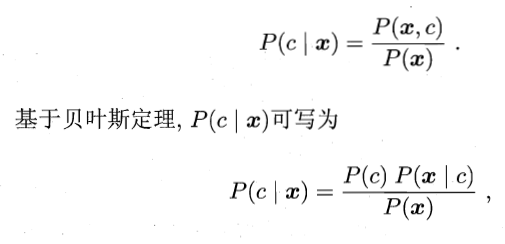

重点讲解一下生成式模型,必然考虑

其中, P(c):是类“先验”概率;(表达了样本空间中各类样本所占的比例,根据大树定律,当训练集包含充足的独立用分布样本时,它可以通过各类样本出现的频率来进行估计。)

P(x|c):是样本x相对于类标记c的类条件概率,或称为“似然”;

P(x):是用于归一化的“证据”因子。对给定样本x,证据因子P(x)与类标记无关,

因此估计P(c|x)的问题就转化为如何给予训练数据来估计先验P(c)和似然P(x|c)。

现在的难点就变成了如何得到P(x|c),由于它涉及关于x所有属性的联合概率,直接根据样本出现的频率来估计将会遇到严重的困难。。。。。

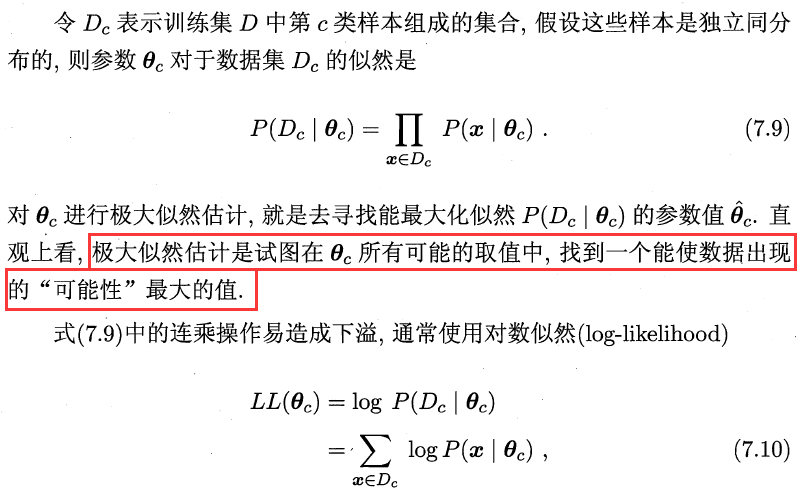

一般估计类条件概率的一种常用策略是先假定其具有某种确定的概率分布形式,再基于训练样本对概率分布的参数进行估计。事实上,概率模型的训练过程就是参数估计过程。

有两种解决学派:

- 频率主义学派:认为参数虽然未知,但确实客观存在的固定值,因此,可以用过优化似然函数等准则来确定参数值;

- 贝叶斯学派:认为参数时未观察到随机变量,其本身也可有分布,因此,可假定参数服从一个先验分布,然后基于观测到的数据来计算参数的后验分布。

本节主要介绍一个频率学派的极大似然估计,这是根据数据采样来估计概率分布参数的经典方法。

此时参数θc的极大似然估计

为

为

需要注意的是:这种参数化的方法虽能使类条件概率估计变得相对简单,但是估计结果的准确性严重依赖于所假设的概率分布形式是否古河潜在的真实数据分布。在现实生活中,欲做出能较好地接近潜在真实分布的假设,往往需在一定程度上利用关于应用任务本身的经验知识,否则若仅凭“猜测”来假设概率分布形式,很可能产生误导性的结果。

2. 朴素贝叶斯分类器:

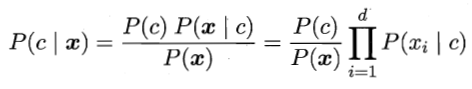

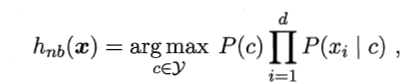

从上面可知,估计后验概率的主要困难在于:类条件概率是所有属性上的联合概率,难以从有限的训练样本直接估计而得。因此,为了避免这个障碍,朴素贝叶斯分类器采用了“属性条件独立性假设”:对已知类别,假设所有属性相互独立,换言之,假设每个属性独立地对分类结果发生影响。

假设成立的话,

其中d为属性数目,xi为x在第i个属性上的取值。由于对所有类别来说P(x)相同,因此上式的贝叶斯判定准则有:

这就是朴素贝叶斯分类器的表达式。

注意:为了避免其他属性携带的信息被训练集中未出现的属性值“抹去”,在估计概率值时通常要进行“平滑”,常用“拉普拉斯修正”。显然,拉普拉斯修正避免了因训练集样本不充分而导致概率估值为零的问题,并且在训练集变大时,修正过程所引入的先验的影响也会逐渐变得可忽略,使得估计渐趋向于实际概率值。

补充:

由于朴素贝叶斯分类器采用了属性条件独立性假设,但在现实任务中这个假设往往很难成立,于是,人们尝试对属性条件独立性假设进行一定程度的放松,由此产生了一类称为“半朴素贝叶斯分类器”。

基本思想:适当考虑一部分属性间的相互依赖信息,从而既不需要进行完全联合概率计算,又不至于彻底忽略了比较强的属性依赖关系。“独依赖估计”是半朴素贝叶斯分类器最常用的一种策略,就是假设每个属性在类别之外最多仅依赖于一个其他属性。

所有的讨论是假设样本中所有属性变量的值都已被观测到,即训练样本是“完整的”,但在现实应用中往往会遇到“不完整”的训练样本,---EM算法是常用的估计参数隐变量的利器,它是一种迭代式的方法,

其基本想法是:

- 算法总结1---贝叶斯分类器

- 贝叶斯分类器--文本分类应用

- 社交平台舆情分析项目的总结和感想(SELENIUM,NLTK,贝叶斯分类器)(一)

- Bayes classifier(贝叶斯分类器)

- 神经网络与机器学习笔记——贝叶斯分类器

- Python实现贝叶斯分类器

- 贝叶斯分类器中离散属性与连续属性的讨论

- 贝叶斯分类器

- 贝叶斯分类器及EM算法

- 机器学习笔记(六)贝叶斯分类器

- 机器学习之用 Python 从零实现贝叶斯分类器

- 贝叶斯分类器

- 贝叶斯分类器Matlab

- matlab 实现贝叶斯分类器

- 西瓜书贝叶斯分类器(总结)

- 7.3 朴素贝叶斯分类器

- 贝叶斯分类器

- 贝叶斯分类器

- 贝叶斯分类器--原理流程应用

- 贝叶斯分类器