Nvidia推边缘运算平台EGX 未来将提供企业AI模型参考框架

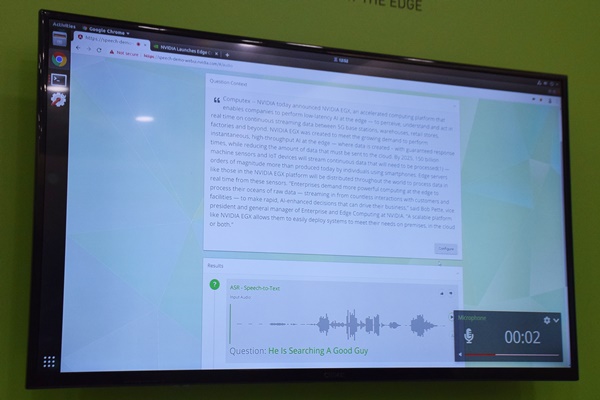

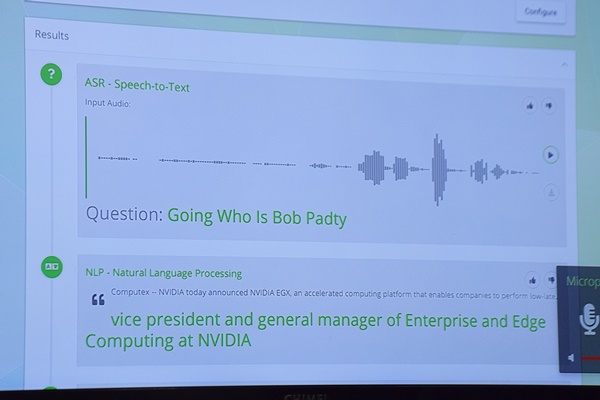

Nvidia在COMPUTEX期间,展示了新推出的边缘运算平台EGX在不同场景中的应用,包括监测路况的实时影像分析与对话式AI客服等。EGX平台也能与Azure、AWS的云端运算服务兼容,企业可先在云端AI模型,再部署到本地端来应用。现场展示的对话式AI客服,是在顾客说话提问后,透过语音识别(Automatic Speech Recognition,ASR)将语言转化为文字,再经由自然语言处理(Natural Language Processing,NLP)到文本内容中寻找答案,最后运用文字转语音(Text To Speech,TTS)的技术回答顾客问题。而这整个流程,都是透过边缘运算完成。Nvidia表示,Chatbot常用三种AI技术中,训练ASR模型和TTS模型,适合在本地端,前者不用上传大量声音档案,后者则可避免网络的延迟性导致声音断断续续、或发音不完整,不过,要训练NLP模型则因运算量较大,可先在云端训练。

Nvidia也示范用只一篇新闻稿来展示用EGX平台训练这三种Chatbot所需模型的情况,首先让NLP模型来分析新闻稿文字。

示范人员实际提问:Who is Bob Pette?

这个示范系统会将从NLP模型找出来的答案,透过TTS模型生成语音来回答顾客;若无法在数据文本中找到答案,则会提供制式回答「Empty、No answer。」

Nvidia表示,未来提供企业的EGX平台,会包括执行边缘运算的硬件以及AI模型的参考框架。硬件的部分,EGX平台有强大的扩充性,可以支持体积极小、运算可达5 TOPS的Nvidia Jetson Nano,同时也能支持一整柜的Nvidia T4服务器,提供超过10,000 TOPS的效能。除了硬件之外,Nvidia也会释出的AI模型的参考框架,如应用案例中的NLP模型,是用目前最新、准确率最高、由google开源释出的NLP模型BERT来做,未来释出参考框架(Example model)后,可以让客户在平台上用自家数据来训练,也可以直接将训练好的模型替换到平台上。但参考框架会如何做、EGX平台未来会支持哪些深度学习框架,Nvidia并无透露。EGX平台的软件架构(Nvidia Edge Stack)与AWS、Azure的IoT云端服务相连,让企业能自行在云端建立AI模型,再部署到平台来应用,而在平台上建立的模型也能链接到云端使用,Nvidia产品营销部经理Paresh Kharya也表示,企业可以透过AWS IoT Greengrass和微软Azure IoT Edge来管理这些服务。更多相关人工智能信息:仲博虚拟体验馆 http://pharmacycentral.net/

(adsbygoogle = window.adsbygoogle || []).push({});- 数据是企业和社会发展的重要动力,AI从边缘发展到主流,未来十年信息技术将带来巨大“红利” | 大咖周语录

- 【人工智能】未来企业建设AI需三大平台;仅靠算法不能落地智能,企业需要AI核心系统

- Silverlight企业应用快速开发平台框架设计(三)分析-页面模型

- 商务参考体系结构:企业对消费者(B2C电子商务解决实践) 第 1 章:业务需求和设计模型

- 哪些编程语言、框架/平台最受企业青睐?

- 框架、平台和智能应用(大数据创新在中国的重点和未来)

- [安卓,android源码] Android平台替代虚拟按键悬浮球,参考魅族悬浮球设计。捡代码论坛整理提供

- 企业架构研究总结(30)——TOGAF架构内容框架之内容元模型(上)

- 多备份:云端数据物流平台为企业提供云备份服务(通过增值服务盈利,数据备份相当于买保险)

- 什么是CUDA?显卡厂商NVidia推出的运算平台

- BSP提供“企业BLOG平台”的构思

- 基于中型企业的数据库平台更具未来

- 企业架构研究总结(11)——联邦企业架构之FEA及参考模型(上)

- 联邦企业架构之FEA及参考模型(中)

- Spring企业业务快速开发平台应该具备的基本框架

- .net 平台下的AI框架

- 科赛Kesci宣布正式更名为和鲸HeyWhale,专注为企业提供数据化及AI转型解决方案

- 互联网平台通用运营模型框架及方法论

- 商务参考体系结构:企业对消费者(B2C电子商务解决实践) 第 1 章:业务需求和设计模型

- 英特尔科再奇:AI战略决定每家企业的未来胜负