七月机器学习之决策树随机森林和adaboost11

2017-03-31 23:12

197 查看

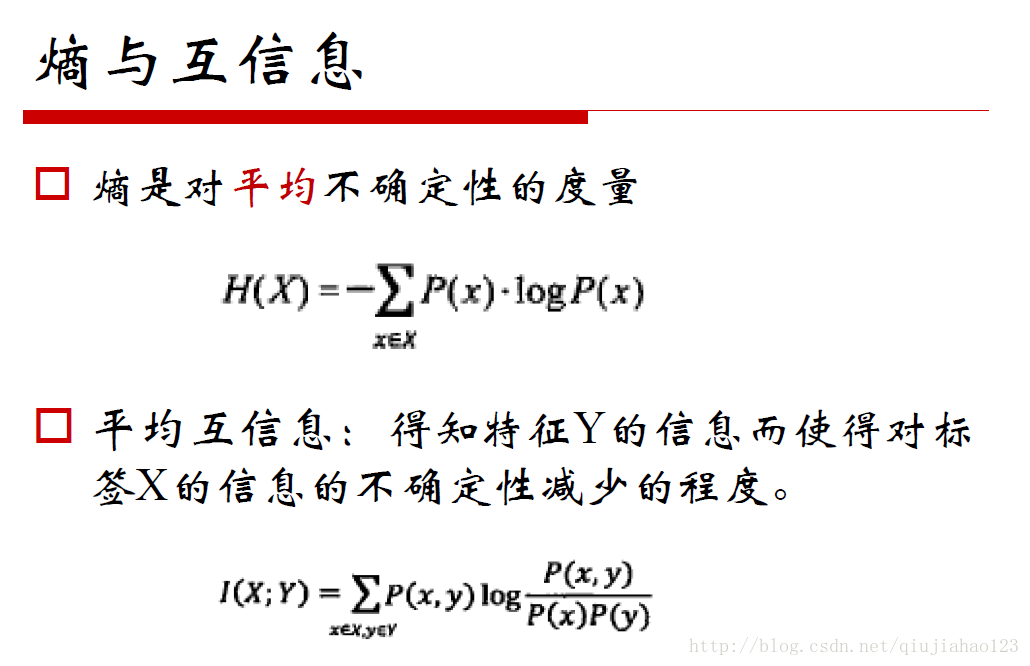

信息是对不确定性的度量

平均互信息是衡量两个概率分布之间的相似性,互信息高那么相似性就比较大

他们之间的运算关系都在这个图里

I是互信息

熵减去条件熵就是互信息

条件熵是衡量差异性的

也就是说,之前的不确定性减去之后的不确定性等于不确定性的减少,不确定性的减少意味着确定性的增加,实际上就是我们寻找的相关性

主要理解ID3即可

A是特征,D是标签label

决策树的面试会问

由以下公式可知,基尼系数实际上是熵的一种近似

Pk是某一个样本基于这一类特征属于某一类的概率

0.5时取最大值

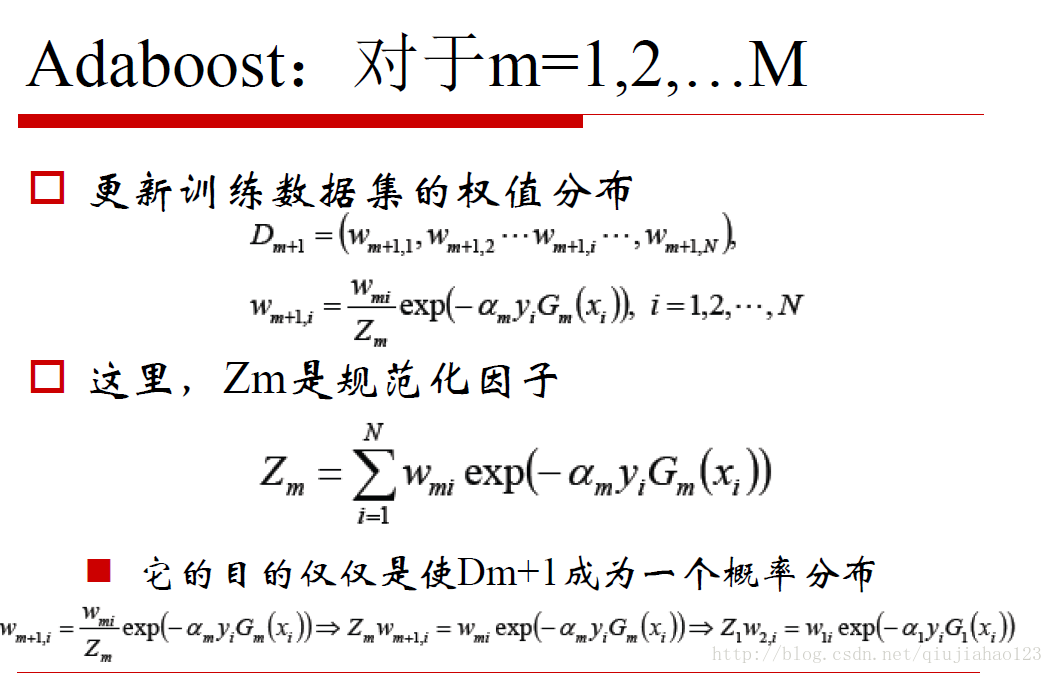

adaboost实际上是对不同的分类器设置权重,如果所有的分类器都是决策树的话,那么实际上bagging就变成了随机森林,随机森林的随机是样本的选取是随机的,特征的选取是随机的,样本的随机抽取是有放回的。随机森林对分类器没有权重,对样本有权重

G和阿尔法都是需要选择的

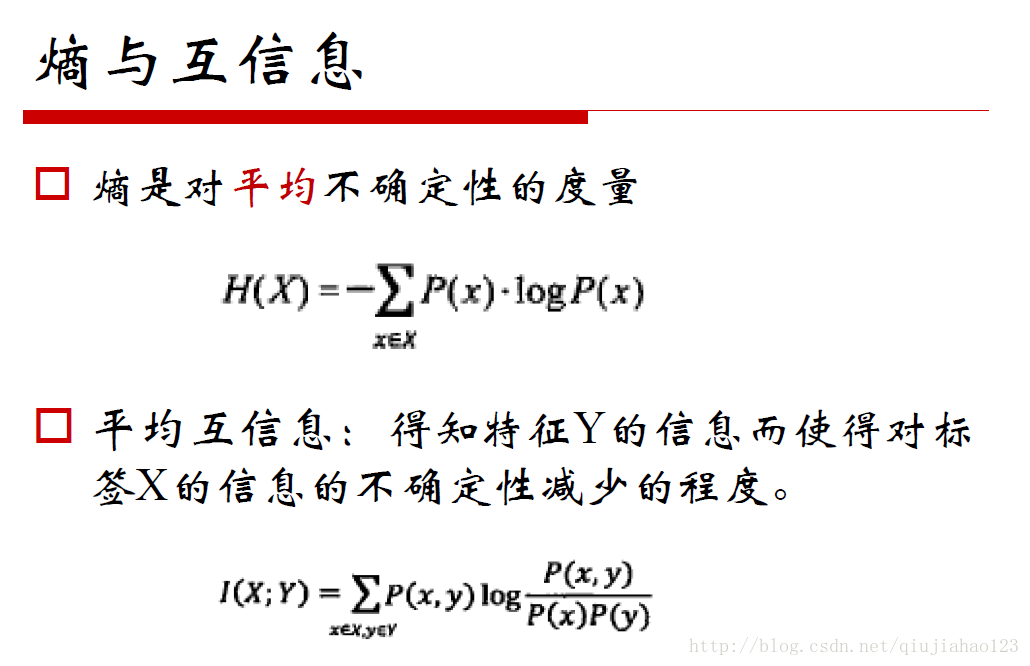

平均互信息是衡量两个概率分布之间的相似性,互信息高那么相似性就比较大

他们之间的运算关系都在这个图里

I是互信息

熵减去条件熵就是互信息

条件熵是衡量差异性的

也就是说,之前的不确定性减去之后的不确定性等于不确定性的减少,不确定性的减少意味着确定性的增加,实际上就是我们寻找的相关性

主要理解ID3即可

A是特征,D是标签label

决策树的面试会问

由以下公式可知,基尼系数实际上是熵的一种近似

Pk是某一个样本基于这一类特征属于某一类的概率

0.5时取最大值

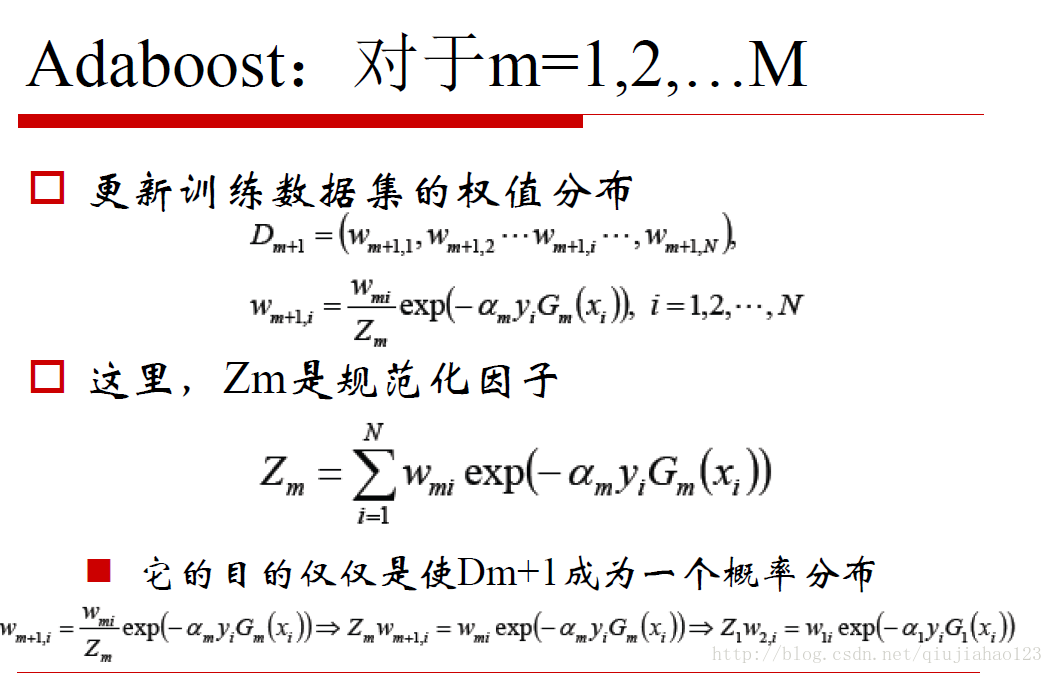

adaboost实际上是对不同的分类器设置权重,如果所有的分类器都是决策树的话,那么实际上bagging就变成了随机森林,随机森林的随机是样本的选取是随机的,特征的选取是随机的,样本的随机抽取是有放回的。随机森林对分类器没有权重,对样本有权重

G和阿尔法都是需要选择的

相关文章推荐

- 机器学习 —— 决策树及其集成算法(Bagging、随机森林、Boosting)

- 机器学习之决策树和随机森林及代码示例

- 机器学习实战--笔记3(决策树与随机森林)

- 机器学习之决策树和随机森林

- 机器学习总结(四)——随机森林与GBDT(梯度提升决策树)

- 机器学习之决策树(Decision Tree)&随机森林(Random forest)

- 【机器学习】决策树与随机森林

- 关于机器学习中决策树的相关问题也谈随机森林

- 机器学习-采用正态贝叶斯分类器、决策树、随机森林对wine数据集分类

- 机器学习 —— 决策树及其集成算法(Bagging、随机森林、Boosting)

- 机器学习-决策树和随机森林

- 机器学习总结8_从决策树到随机森林

- 机器学习利器——决策树和随机森林

- [机器学习]决策树和随机森林

- Spark 机器学习 —— 从决策树到随机森林

- 机器学习实战笔记3(决策树与随机森林)

- 机器学习-采用正态贝叶斯分类器、决策树、随机森林对abalone数据集分类

- 机器学习——决策树与随机森林

- 机器学习(五)-决策树和随机森林

- 机器学习利器——决策树和随机森林