TensorFlow框架做实时人脸识别小项目

人脸识别是深度学习最有价值也是最成熟的的应用之一。在研究环境下,人脸识别已经赶上甚至超过了人工识别的精度。一般来说,一个完整的人脸识别项目会包括两大部分:人脸检测与人脸识别。下面就我近期自己练习写的一个“粗糙”的人脸识别小项目讲起,也算是做一个学习记录。

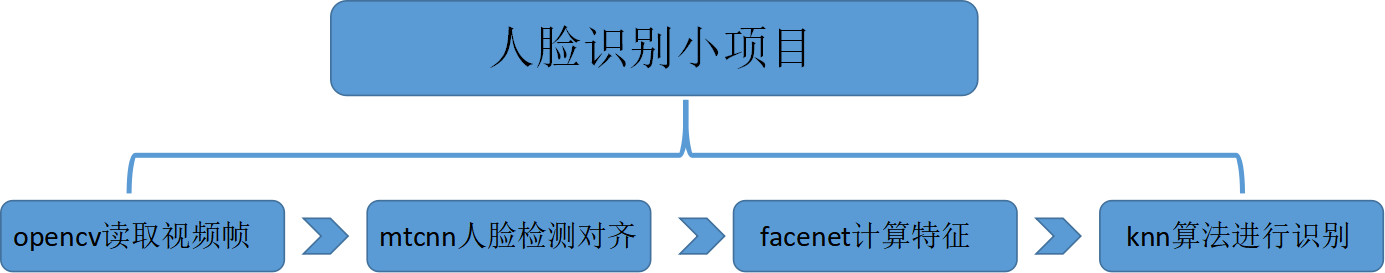

首先 ,整个项目的框架包括四个主要的部分:(1)利用opencv从图像传感器处(比如电脑摄像头)实时的读入视频帧;(2)使用mtcnn网络做人脸检测和对齐;(3)利用facenet网络计算人脸特征,也就是embedding;(4)knn算法进行具体的人脸识别。如下图所示:

其中的mtcnn的人脸检测是很关键的一步,它检测定位的人脸准确与否直接影响到后面的特征计算与识别;facenet实际是一个对人脸进行特征编码的网络,具体的实现后面会讨论;knn的分类算法在用于真正的识别前要经过训练,训练的样本的质量好坏与数量也会对识别的 结果产生很大的影响。今天在这只讨论mtcnn网络的人脸检测对齐部分。

mtcnn网络全称为multi-task convolutinal neural network,意为多任务卷积神经网络。mtcnn由三个神经网络组成,分别是P-Net, R-Net, O-Net。在使用这些网络之前,首先要将原始图片缩放到不同尺寸,形成一个图像金字塔,接着会对每个尺寸的图片通过神经网络计算一遍。其目的在于兼顾图片中的不同大小的人脸,在统一的尺度下检测人脸。

如果你觉得这篇文章看起来稍微还有些吃力,或者想要系统地学习人工智能,那么推荐你去看床长人工智能教程。非常棒的大神之作,教程不仅通俗易懂,而且很风趣幽默。点击这里可以查看教程。

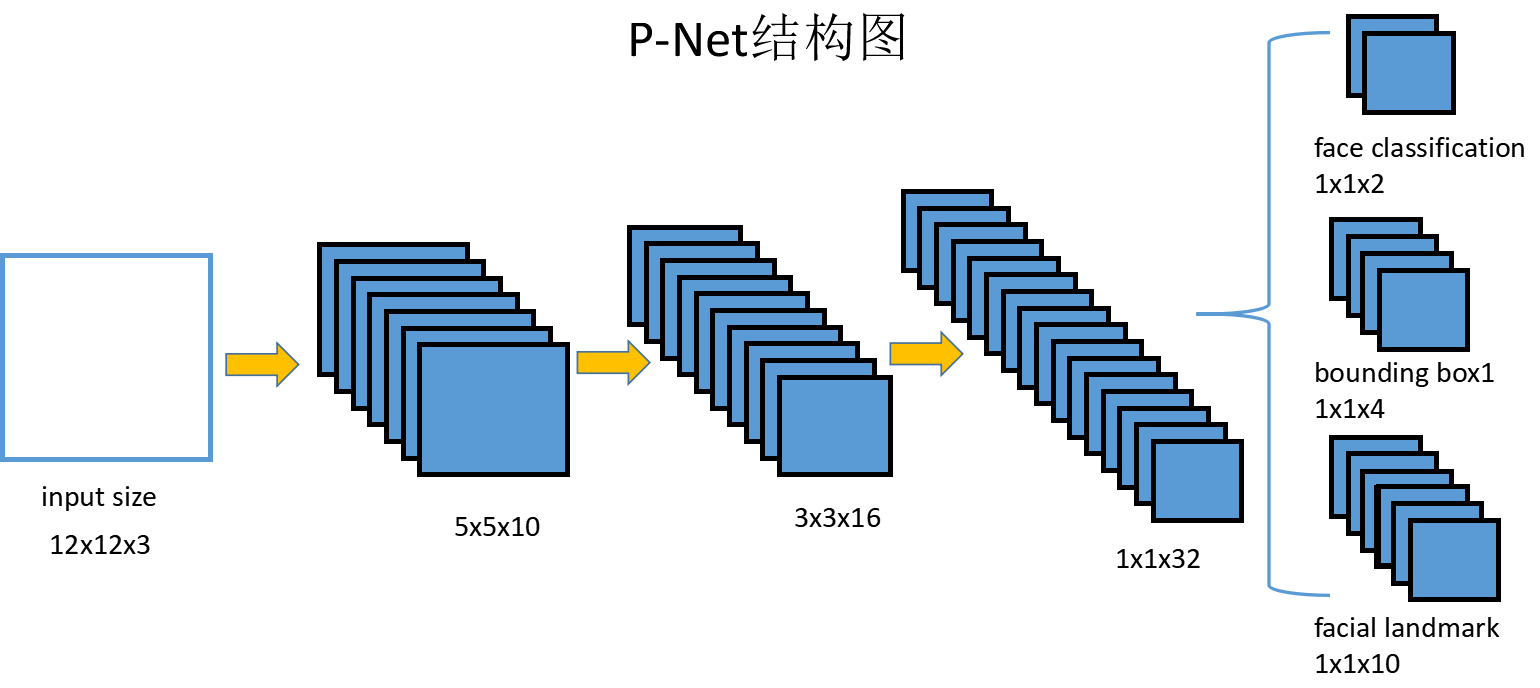

第一个网络P-Net的结构如下图所示:

P-Net的输入是一个12x12的3通道RGB图像,它的作用是要判断这个网络中是否有人脸,并且给出人脸框和关键点位置。第一个部分face classification输出的是判断是人脸的概率和不是人脸的概率,两个值加起来严格等于1;第二个部分输出的是框的精确位置,4个值分别是框的左上角二维坐标和框的高度与宽度;第三个部分输出的是人脸5个关键点:左眼,右眼,鼻子,左嘴角,右嘴角的位置的二维坐标。

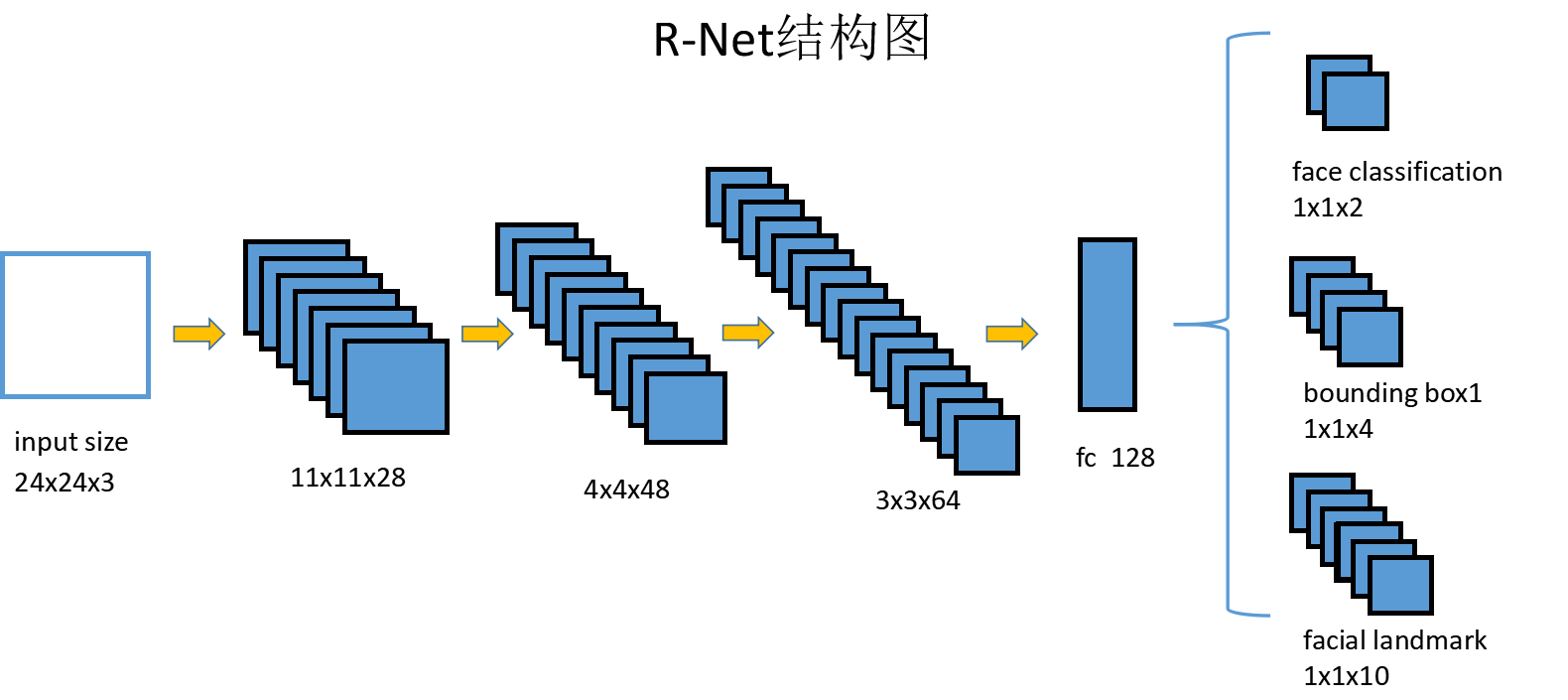

第二个网络R-Net的网络结构与P-Net差别不大,如下图:

除了输入大小与中间层大小不同,R-Net的结构与P-Net非常相似,只是在最后的输出层前多加入了一个全连接层。R-Net的输出完全与P-Net一样,同样由人脸判别,框回归,关键点位置预测三部分组成。

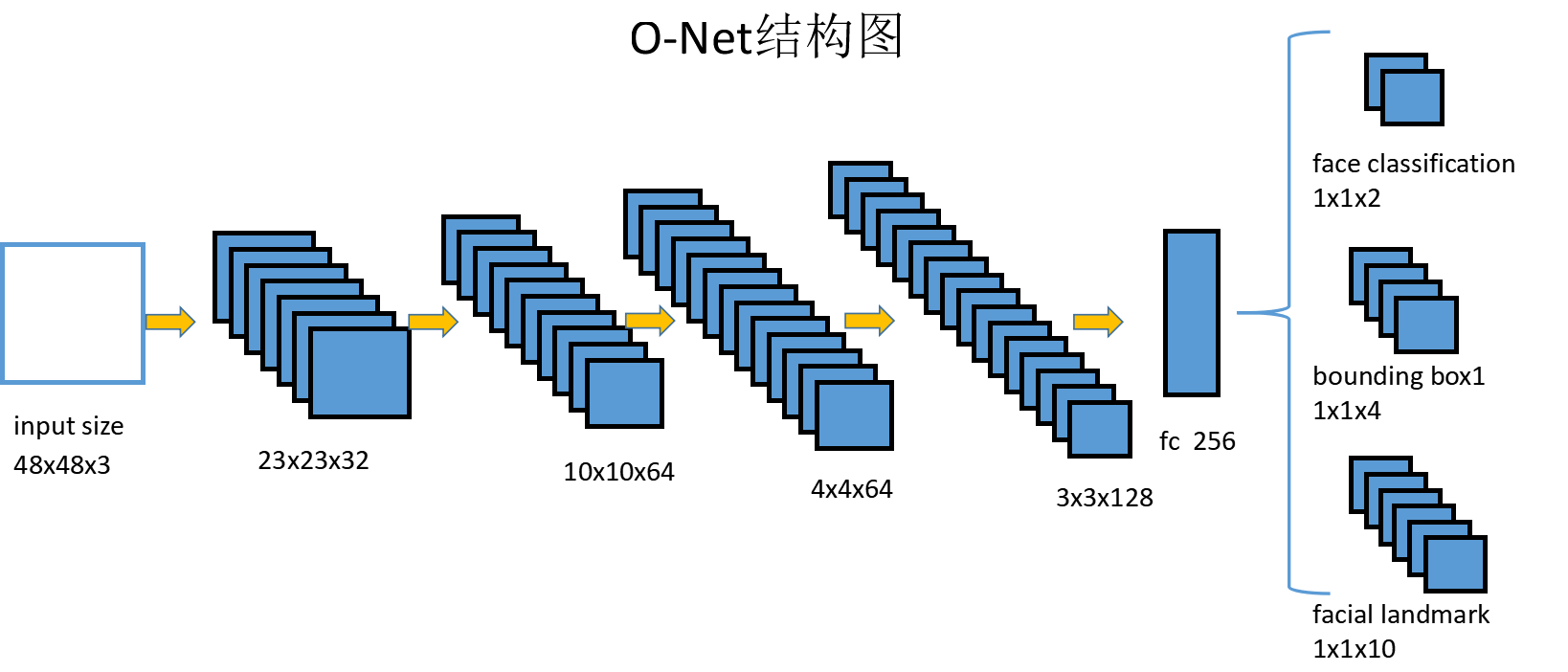

第三个网络O-Net结构如下:

O-Net相比R-Net在结构上又多出一个中间层,但是输出结果还是一样的。

从P-Net到R-Net,再到O-Net,网络输入的图片越来越大,中间层的通道数越来越多,识别人脸的准确度也越来越高。实际上mtcnn的工作原理就是P-Net先做一遍过滤,将过滤后的结果交给R-Net进行过滤,最后再将过滤的结果交给O-Net进行判别。它是层层递进的一个筛查机制。

mtcnn中每个网络都有三部分输出,因此训练时损失的定义也由三部分组成。针对人脸判别face classification,使用交叉熵损失,针对框和回归点的判定,直接使用L2损失。最后这三部分损失各自乘以自身的权重再加起来,形成最后的总损失。P-Net和R-Net网络关心框位置的准确性,O-Net关心关键点判定,它们三部分的各自权重是不一样的。

mtcnn网络需要大量的人脸数据进行训练,才能得到合适的网络参数,达到较好的检测效果。在github上有已经训练好的mtcnn模型可以直接使用,点这里可以直达。其中的src/align/detect_face.py与det1.npy,det2.npy,det3.npy就是mtcnn网络的结构与训练模型,可以直接使用。

测试mtcnn的部分代码:

- def test():

- video = cv2.VideoCapture(0)

- print('Creating networks and loading parameters')

- with tf.Graph().as_default():

- gpu_options = tf.GPUOptions(per_process_gpu_memory_fraction=1.0)

- sess = tf.Session(config=tf.ConfigProto(gpu_options=gpu_options, log_device_placement=False))

- with sess.as_default():

- pnet, rnet, onet = detect_face.create_mtcnn(sess, None)

- minsize = 20

- threshold = [0.6, 0.7, 0.7]

- factor = 0.709

- while True:

- ret, frame = video.read()

- &nb 3ff7 sp; bounding_boxes, _ = detect_face.detect_face(frame, minsize, pnet, rnet, onet, threshold, factor)

- nrof_faces = bounding_boxes.shape[0]

- print('找到人脸数目为:{}'.format(nrof_faces))

- for face_position in bounding_boxes:

- face_position = face_position.astype(int)

- cv2.rectangle(frame, (face_position[0], face_position[1]),(face_position[2], face_position[3]), (0, 255, 0), 2)

- cv2.imshow('show', frame)

- if cv2.waitKey(5) & 0xFF == ord('q'):

- break

- video.release()

- cv2.destroyAllWindows()

- 1

- TensorFlow框架做实时人脸识别小项目

- TensorFlow框架做实时人脸识别小项目

- TensorFlow框架做实时人脸识别小项目

- TensorFlow框架做实时人脸识别小项目

- TensorFlow框架做实时人脸识别小项目

- linux下使用pycharm 的tensorflow框架来开发python项目踩坑实时更新

- 人脸识别完整项目实战(14):实时人脸特征点标定程序设计

- TensorFlow实现人脸识别(5)-------利用训练好的模型实时进行人脸检测

- 人脸识别完整项目实战(13):实时人脸检测程序设计

- TensorFlow 深度学习框架(6)-- mnist 数字识别及不同模型效果比较

- C++开发人脸性别识别教程(9)——搭建MFC框架之显示图片

- [Tensorflow]基于slim框架下inception模型的植物识别

- 02:一文全解:利用谷歌深度学习框架Tensorflow识别手写数字图片(初学者篇)

- TensorFlow 人脸识别网络与对抗网络搭建

- TensorFlow脑洞人脸识别(一)

- tensorflow下基于DNN实现实时分辨人脸微表情

- TensorFlow 深度学习框架(6)-- mnist 数字识别及不同模型效果比较

- 集天气预报,TTS,深度学习人脸识别,邮件发送,温湿度采集,消息推送,lcd1602一体的树莓派开源项目

- 深度学习框架Tensorflow学习--CNN实现识别数字

- 一文全解:利用谷歌深度学习框架Tensorflow识别手写数字图片(初学者篇)