Python学习爬虫(7)——爬取豆瓣书名(入门实战)以及 SSLError错误解决

2019-04-09 18:00

309 查看

作者:IT小样

实例:爬取豆瓣书名

URL: https://book.douban.com/tag/漫画

目的:爬取当前页面的所有的书名。

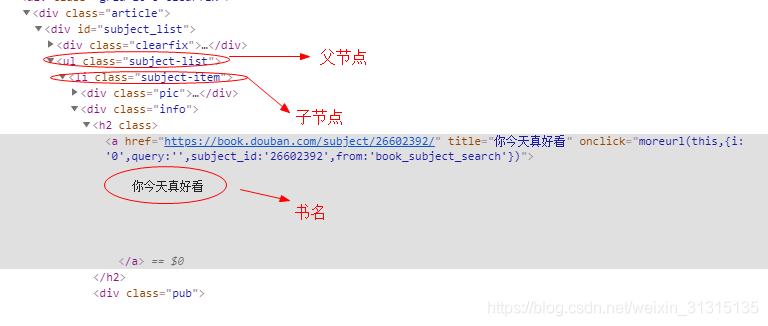

首先放上该网页所需爬取信息的网页源码图:

从网页源码可以得知,找到父节点后,遍历’ li '子节点,可以在子节点中获取书名;首先放上最简单的实现代码:

import requests

from bs4 import BeautifulSoup

url = "https://book.douban.com/tag/%E6%BC%AB%E7%94%BB"

response = requests.get(url,verify=False)

soup = BeautifulSoup(response.text,"lxml")

book_div = soup.find(attrs={"class":"subject-list"})

book_a = book_div.find_all('li',attrs={"class":"subject-item"})

for book in book_a:

print (book.find('h2').get_text().replace(' ','').replace('\n',''))

这段代码实现的很简单,找到信息后,直接打印出来,没有对数据进行保存,在实现过程中,也没有对函数进行封装。之后会出更深阶的实战示例。

注意事项:在发起requests请求之中,如果出现SSLError,SSL:CERTIFICATION_VERIFY_FAILED错我,详细报错见下图:

解决方法为:在requests请求中,加上参数:verify=False,加上改参数后,会跳过对SSL证书的验证。

相关文章推荐

- Python学习爬虫(9)--实战高阶:爬取豆瓣书名(多线程)

- Python爬虫(入门+进阶)学习笔记 1-3 使用Requests爬取豆瓣短评

- python3[爬虫基础入门实战] 爬取豆瓣电影排行top250

- Python爬虫入门学习实战项目(一)

- Python爬虫(入门+进阶)学习笔记 1-5 使用pandas保存豆瓣短评数据

- 【python爬虫学习笔记】06 正则表达式以及Re库入门

- python3 [入门基础实战] 爬虫入门之xpath的学习

- python 爬虫学习三(Scrapy 实战,豆瓣爬取电影信息)

- python3 [入门基础实战] 爬虫入门之智联招聘的学习(一)

- Python爬虫入门 | 7 分类爬取豆瓣电影,解决动态加载问题

- python3 [入门基础实战] 爬虫入门之智联招聘的学习(一)

- 学习Python就业有哪些方向?附加视频教程(python3从入门到进阶(面向对象),实战(爬虫,飞机游戏,GUI)视频教程)

- Python爬虫(入门+进阶)学习笔记 1-4 使用Xpath解析豆瓣短评

- Python爬虫入门学习实战项目(二)

- python3 [入门基础实战] 爬虫入门之爬取豆瓣阅读中文电子书[热门排序]

- Python 爬虫如何入门学习?

- Python爬虫框架Scrapy 学习笔记 10.2 -------【实战】 抓取天猫某网店所有宝贝详情

- python3 [入门基础实战] 爬虫之四季花果园的采果模块

- Python爬虫框架Scrapy 学习笔记 10.2 -------【实战】 抓取天猫某网店所有宝贝详情

- Python的爬虫程序编写框架Scrapy入门学习教程