Python3.6下安装Scrapy框架及其基本使用

2019-03-08 12:08

453 查看

1 利用anaconda安装scrapy框架

conda install scrapy

会出现很多的依赖包要求更新和下载,输入y:

等待下载即可

输出scrapy命令,出现如下表示安装成功

2 Scrapy基本使用

创建Scrapy项目

首先进入你要进入你要创建爬虫项目的目录的文件夹,然后执行命令:

scrapy startproject myspiders(项目名)

创建好的项目目录如下:

-

文件说明:

scrapy.cfg :项目的配置信息,主要为Scrapy命令行工具提供一个基础的配置信息。(真正爬虫相关的配置信息在settings.py文件中)

items.py: 设置数据存储模板,用于结构化数据,如:Django的Model

pipelines: 数据处理行为,如:一般结构化的数据持久化

settings.py: 配置文件,如:递归的层数、并发数,延迟下载等

spiders: 爬虫目录,如:创建文件,编写爬虫规则 -

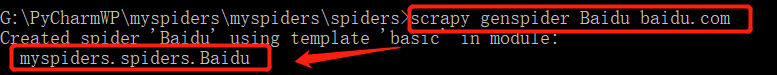

创建爬虫文件

进入爬虫目录文件夹

cd myspiders\spiders

再生成爬虫文件

scrapy genspider Baidu baidu.com

爬虫名为Baidu

在Pycharm中显示如下:

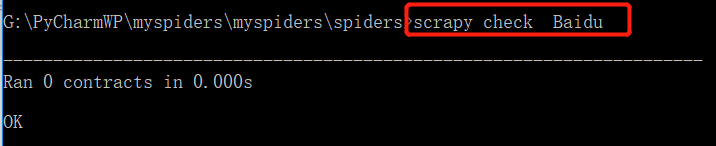

- 检查爬虫

当再次使用scrapy命令时,会出现新的命令,如下:

检查爬虫:

scrapy check Baidu

例如,爬出页面相应体,修改Baidu.py文件

- 运行爬虫

scrapy crawl Baidu

结果如下:

相关实例更新中。。。。。。。。

参考

[1] https://blog.csdn.net/qq_42543250/article/details/81347368

[2] https://www.geek-share.com/detail/2700479006.html

[3] https://www.cnblogs.com/jiangzijiang/p/8459669.html

[4] https://www.geek-share.com/detail/2703311903.html

相关文章推荐

- Python爬虫 --- 2.1 Scrapy 爬虫框架的安装与基本介绍

- Python之Scrapy爬虫框架安装及使用详解

- Python开源框架Scrapy安装及使用

- 从零开始写Python爬虫 --- 2.1 Scrapy 爬虫框架的安装与基本介绍

- 在Anaconda3(Python3.6)下安装Scrapy框架

- Python之Scrapy爬虫框架安装及简单使用详解

- python scrapy框架的安装和简单使用

- Python爬虫框架Scrapy安装使用步骤

- Python3.6安装Scrapy爬虫框架

- Python之Scrapy爬虫框架安装及简单使用

- Python爬虫框架Scrapy安装使用步骤

- 基于Python3.6使用Django框架连接mysql数据库的驱动模块安装解决办法

- Python爬虫框架Scrapy安装使用步骤

- Python 3.6 性能测试框架Locust安装及使用方法(详解)

- 爬虫Scrapy框架的安装和使用(Python)

- Python之Scrapy爬虫框架安装及简单使用

- windows7下安装python3的scrapy框架

- 【window10下python的对elcel表格操作xlrd和xlwt模块的下载与安装及基本的使用】

- redhat系统安装scrapy爬虫框架步骤Python版

- win7 32bit python3.6下安装scrapy