SVM支持向量机原理及核函数

小编前几天一直在研究SVM的原理,看了李宏毅老师的视频和浏览量很多的大神博客,总感觉不是很系统,前后连不起来,无意间发现了大神的主页,这里安利下,同时将大神关于SVM的讲解进行copy下,作为学习笔记.

更推荐原文链接:http://ihoge.cn/2018/SVM.html,界面简洁,赏心悦目

支持向量机原理

大距离分类算法

1、名词解释:

-

分割超平面:如下图所示,构造一个分割线把圆形的点和方形的点分开,这个线称为分割超平面。

-

支持向量:离分割超平面最近的点

-

间距:支持向量到分割超平面距离的两倍

SVM算法的原理就是找到一个分割超平面,它能把数据正确的分类,并且间距最大!

2、计算间距

在而为空间里,可以使用方程

来表示分割超平面。针对高纬度空间,可以写成一般化的向量形式,即

来表示分割超平面。针对高纬度空间,可以写成一般化的向量形式,即

。这里画出与分割线超平面平行的两条直线,分别穿过两个类别的支持向量。这两条直线的方程分别为

。这里画出与分割线超平面平行的两条直线,分别穿过两个类别的支持向量。这两条直线的方程分别为

。如下图所示:

。如下图所示:

根据点到直线的距离公式,可以算出支持向量A到分割超平面的距离为:

由于点AA在直线

在,代入可的支持向量AA到分割超平面的距离为

在,代入可的支持向量AA到分割超平面的距离为

。为了使间距最大,只需找到合适的参数

。为了使间距最大,只需找到合适的参数

最大即可。

最大即可。

,计算公式为:

,计算公式为:

。除了间距最大,分割超平面更能用来解决分类问题!回到上图,

。除了间距最大,分割超平面更能用来解决分类问题!回到上图,

,必须满足

,必须满足

的约束条件。针对圆形的点必须满足

的约束条件。针对圆形的点必须满足

的约束条件。

的约束条件。

类别是离散的值,分别使用-1表示圆点类别,1表示方点类别,即y∈(−1,1)y∈(−1,1)。针对数据集中的所有样本

,只要满足以下约束条件,则由以下参数ww和参数bb定义的分割超平面进行分类:

,只要满足以下约束条件,则由以下参数ww和参数bb定义的分割超平面进行分类:

松弛系数

针对现行不可分的数据集,上面的方法就不能用了。解决这个问题的办法就是引入一个参数ϵ,称为松弛系数。然后把优化的目标函数变为:

其中m为数据集的个数,R为算法参数,其约束条件变为:

理解松弛系数:

违反一大间距规则的程度。针对大多数满足约束条件的样本

违反一大间距规则的程度。针对大多数满足约束条件的样本

。而对部分违反最大间距规则的样本ε>0。参数R则表示对违反约束的样本的”惩罚”。R越大对违反约束的点“惩罚力度”越大反之越小 。这样模型就会倾向于允许部分点违反最大间距规则。

。而对部分违反最大间距规则的样本ε>0。参数R则表示对违反约束的样本的”惩罚”。R越大对违反约束的点“惩罚力度”越大反之越小 。这样模型就会倾向于允许部分点违反最大间距规则。

上图可以看出,针对哪些没有违反约束条件的样本,其成本为0。违反了约束条件的样本其成本与ε成正比,斜线的斜率为R。

因此,引入松弛系数类似于逻辑回归的成本函数引入正则项,目的是为了纠正过拟合问题,让SVM对噪声数据由更强的忍耐性。如上上图所示,当出现违反大间距规则的噪声样本出现时,仍能让分割超平面是原来的样子,这就是松弛系数的作用。

核函数

核函数是特征转换函数。

最简单的核函数

回顾上面内容,我们的任务是找出合适的参数w,b,使得分割超平面间距最大,且能正确对数据进行分类。间距最大是我们的优化目标。真确地对数据分类是约束条件。即在满足约束条件

的前提下,求解

的前提下,求解

的最小值。

的最小值。

拉格朗日乘子法是解决约束条件下求函数极值的理想方法。其方法是引入非负系数α来作为约束条件的权重:

由于极值的偏导数为0,因此这需要让L对w求导使之为0得到w和α对关系:

接着继续求L对b对偏导数得出:

把这两个式子代入L通过数学运算得出:

这个公式的最小值求解这里就不说明了。最后求出的aa有个明显的特点。即大部分

。因为只有那些支持向量所对应的样本直接决定了间隙的大小。实际上以上推导出这个公式就是为了引入支持向量机的另外一个核心概念:核函数:

。因为只有那些支持向量所对应的样本直接决定了间隙的大小。实际上以上推导出这个公式就是为了引入支持向量机的另外一个核心概念:核函数:

相似性函数

假设数据集已有一个数图特征,如下图,如何进行分类。

解决这个问题的方式是:用一定规则把这些无法进行线性分割的样本映射到更高纬度的空间里,然后找出超平面。

SVM的核函数就是为了实现这种相似性映射。最简单的核函数是

,它衡量的是两个输入特征向量的相似性。可以通过定义和函数

,它衡量的是两个输入特征向量的相似性。可以通过定义和函数

来重新定义相似性,从而得到想要的映射。例如在基因测试领域,我们需要根据DNA分子的特征来定义相似性函数,即和函数。在文本处理领域,也可以自己定义和函数来衡量两个词之间的相似性。

来重新定义相似性,从而得到想要的映射。例如在基因测试领域,我们需要根据DNA分子的特征来定义相似性函数,即和函数。在文本处理领域,也可以自己定义和函数来衡量两个词之间的相似性。

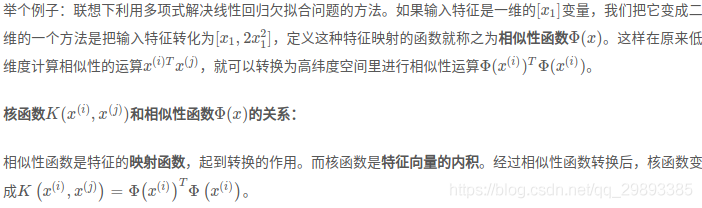

怎么把低维度的空间映射到高纬度的空间呢?

常用核函数

核函数一般和应用场景相关,在不同领域所应用的核函数可能也不相同。但是实际上也有一些通用核函数“万金油”,一般有两种:多项式核函数和高斯核函数。

1、多项式核函数:

2、高斯核函数:

如果输入的特征是一维的标量,那么高斯核函数对应的形状就是一个反钟形的曲线,其参数σ控制反钟形的宽度。如下图所示:

由于

,经过合适的数学变换,可得高斯核函数对应的特征转换函数为:

,经过合适的数学变换,可得高斯核函数对应的特征转换函数为:

前面无限多项的累加器,其物理意义就是把特征向量转换到无限多维向量空间里,即高斯函数可以吧输入特征扩展到无限多维空间里。公式的推导公式会用到泰勒公式。

核函数的对比

1、线性核函数:这是最简单的核函数,它直接计算两个输入特征向量的内积。

- 优点:简单高效,结果易解释,总能生成一个最简洁的线性分割超平面

- 缺点:只适用线性可分的数据集

2、多项式核函数:通过多项式来作为特征映射函数

- 优点:可以拟合出复杂的分割超平面。

- 缺点:参数太多。有

,三个参数要选择,选择起来比较困难;另外多项式的阶数不宜太高否则会给模型求解带来困难。

,三个参数要选择,选择起来比较困难;另外多项式的阶数不宜太高否则会给模型求解带来困难。

3、高斯核函数:

- 优点:可以把特征映射到无限多维,并且没有多项式计算那么困难,参数也比较好选择。

- 缺点:不容易解释,计算速度比较慢,容易过拟合。

核函数的选择

1、最一般的选择原则是针对数据量很大的时候,可以选择复杂一点的模型。虽然复杂模型容易过拟合,但由于数据量很大,可以有效弥补过拟合问题。如果数据集较小选择简单点的模型,否则很容易过拟合,此时特别要注意模型是否欠拟合,如果欠拟合可以增加多项式纠正欠拟合。

2、根据样本量m和特征量n进行选择:

- 特征相比样本较大(如m=10~1000,n=10000):选逻辑回归或者线性函数SVM

- 特征较少,样本量中(如m=10~10000,n=1~1000):选择高斯SVM

- 特征量少,样本多(如m=50000+,n=1~1000):选多项式或高斯SVM

- SVM支持向量机原理(三)线性不可分支持向量机与核函数

- <基础原理进阶>机器学习算法python实现【4】--文本分析之支持向量机SVM【上】

- 机器学习--SVM(支持向量机)核函数原理以及高斯核函数

- 机器学习之支持向量机SVM Support Vector Machine (二) 非线性SVM模型与核函数

- SVM-支持向量机原理详解与实践

- SVM 支持向量机 介绍与原理

- 转:SVM与SVR支持向量机原理学习与思考(一)

- 支持向量机SVM算法原理笔记2

- SVM -支持向量机原理与实践之实践篇

- 支持向量机原理(三)线性不可分支持向量机与核函数

- 支持向量机(SVM)(三)----核函数及正则化

- 支持向量机原理(三)线性不可分支持向量机与核函数

- SVM(support vector machine)支持向量机原理详解

- 支持向量机SVM(三)核函数

- 分类算法----线性可分支持向量机(SVM)算法的原理推导

- 支持向量机(SVM)算法原理

- 支持向量机SVM原理

- 第八篇:支持向量机 (SVM)分类器原理分析与基本应用

- Kernel SVM (核函数支持向量机)

- 为何引入核函数的理解(在理解SVM原理的前提下阅读)推荐看:http://blog.csdn.net/v_july_v/article/details/7624837