机器学习:分类(Classification)算法

2018-03-17 09:54

141 查看

在目前的机器学习工作中,最常见的三种任务就是:回归分析

分类分析

聚类分析

这篇文章的重点是分类(Classification)在机器学习领域中的应用。

判断在线交易是否存在潜在风险

判断肿瘤为良性还是恶性等等

由此可见,逻辑回归(Logistic Regression)就是一种分类分析,它有正向类和负向类,即:y ∈ {0, 1},其中 0 代表负向类,1 代表正向类。当面对一个分类问题:y = 0 或 1,可能出现的情况是:

> 1 或 < 0,就无法进行结果的归纳。此时就需要采用逻辑回归,得到的结果可以满足:

.可以说逻辑回归是一种特殊的分类算法,同理,更普遍的分类算法中可能有更多的类别,即:y ∈ {0, 1, 2, 3 ...} .

的假设函数:

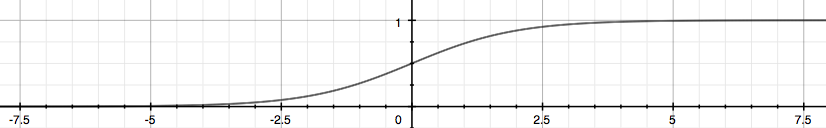

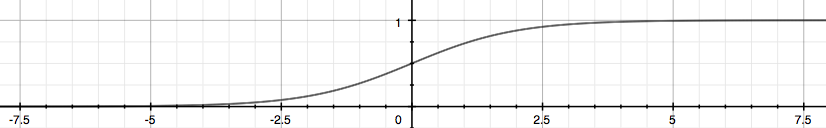

其中,X 为特征向量,g 为逻辑函数,也叫做S形函数(Sigmoid Function),它具体为:

逻辑函数在图像上具体是这样子的:

Sigmoid Function不难看出逻辑函数左侧无限趋近 0,右侧无限趋近 1,这正符合我们所需要的模型的输出值介于 0 和 1 之间。讲上面两个式子结合一下,我们的假设函数也可以写作:

的作用是,根据设定的参数,输入给定的变量,计算输出变量的值为 1 的可能性(Estimated Probablity),即 :

假设

,表示 y 属于正向类的可能性为 70%,同理,我们也可以计算 y=0 的概率。

,参数

为向量 [-3; 1; 1]。当 -3+x1+x2 大于等于 0,即 x1+x2 大于等于 3 时,模型预测 y = 1。则 x1+x2=3 这条线便是我们的决策边界,将预测值为 1 和 0 的两个区域区分开来。

还有更加复杂的情况,如果数据像这样分布呢:

则需要曲线才能将两个类区分开来,就需要用到二次方,如:

,若此时参数

为向量 [-1; 0; 0; 1; 1],则曲线正好是以原点为圆心,1 为半径的圆。我们可以用任意复杂的曲线作为分布复杂的数据的决策边界。

分类分析

聚类分析

这篇文章的重点是分类(Classification)在机器学习领域中的应用。

什么是「分类」

虽然我们人类都不喜欢被分类,被贴标签,但数据研究的基础正是给数据“贴标签”进行分类。类别分得越精准,我们得到的结果就越有价值。分类是一个有监督的学习过程,目标数据库中有哪些类别是已知的,分类过程需要做的就是把每一条记录归到对应的类别之中。由于必须事先知道各个类别的信息,并且所有待分类的数据条目都默认有对应的类别,因此分类算法也有其局限性,当上述条件无法满足时,我们就需要尝试聚类分析。区分「聚类」与「分类」

聚类和分类是两种不同的分析。分类的目的是为了确定一个点的类别,具体有哪些类别是已知的,常用的算法是 KNN (k-nearest neighbors algorithm),是一种有监督学习。聚类的目的是将一系列点分成若干类,事先是没有类别的,常用的算法是 K-Means 算法,是一种无监督学习。两者也有共同点,那就是它们都包含这样一个过程:对于想要分析的目标点,都会在数据集中寻找离它最近的点,即二者都用到了 NN (Nears Neighbor) 算法。应用场景

判断邮件是否为垃圾邮件判断在线交易是否存在潜在风险

判断肿瘤为良性还是恶性等等

由此可见,逻辑回归(Logistic Regression)就是一种分类分析,它有正向类和负向类,即:y ∈ {0, 1},其中 0 代表负向类,1 代表正向类。当面对一个分类问题:y = 0 或 1,可能出现的情况是:

> 1 或 < 0,就无法进行结果的归纳。此时就需要采用逻辑回归,得到的结果可以满足:

.可以说逻辑回归是一种特殊的分类算法,同理,更普遍的分类算法中可能有更多的类别,即:y ∈ {0, 1, 2, 3 ...} .

假说表示

由于逻辑回归要求我们的输出值在 0 和 1 之间,因此我们需要有一个满足的假设函数:

其中,X 为特征向量,g 为逻辑函数,也叫做S形函数(Sigmoid Function),它具体为:

逻辑函数在图像上具体是这样子的:

Sigmoid Function不难看出逻辑函数左侧无限趋近 0,右侧无限趋近 1,这正符合我们所需要的模型的输出值介于 0 和 1 之间。讲上面两个式子结合一下,我们的假设函数也可以写作:

的作用是,根据设定的参数,输入给定的变量,计算输出变量的值为 1 的可能性(Estimated Probablity),即 :

假设

,表示 y 属于正向类的可能性为 70%,同理,我们也可以计算 y=0 的概率。

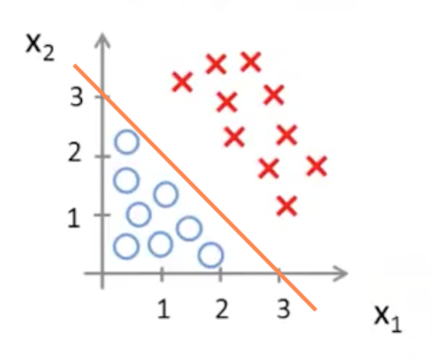

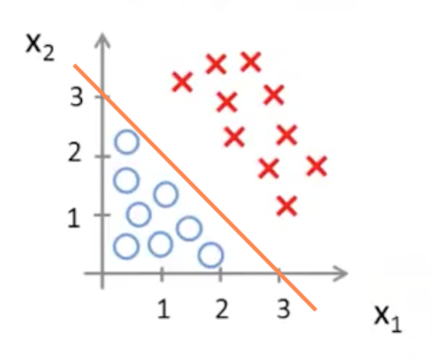

决策边界

决策边界(Decision Boundary)由假设函数决定,理论上可以为任意曲线,也就是说根据模型计算得到的值再由决策边界进行决定最终属于正向类还是负向类。假设我们有一个模型:,参数

为向量 [-3; 1; 1]。当 -3+x1+x2 大于等于 0,即 x1+x2 大于等于 3 时,模型预测 y = 1。则 x1+x2=3 这条线便是我们的决策边界,将预测值为 1 和 0 的两个区域区分开来。

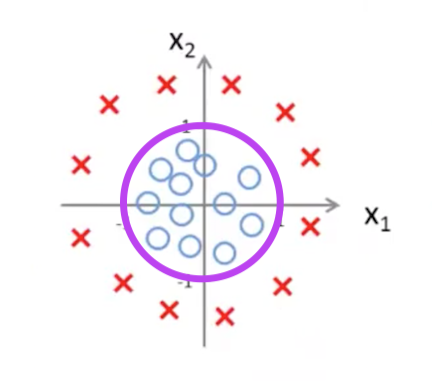

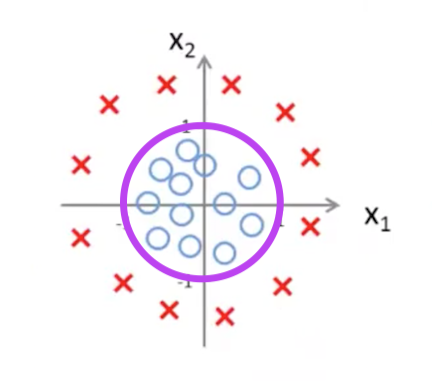

还有更加复杂的情况,如果数据像这样分布呢:

则需要曲线才能将两个类区分开来,就需要用到二次方,如:

,若此时参数

为向量 [-1; 0; 0; 1; 1],则曲线正好是以原点为圆心,1 为半径的圆。我们可以用任意复杂的曲线作为分布复杂的数据的决策边界。

相关文章推荐

- 机器学习常见算法分类汇总

- 用Python开始机器学习(2:决策树分类算法)

- 机器学习常见算法分类汇总

- Google---机器学习速成课程(十)- 分类 (Classification)

- 机器学习:SVM做多分类问题

- 机器学习系列之分类

- 机器学习常见算法分类汇总

- 机器学习中的分类、回归、标注

- 图像分类 | 深度学习PK传统机器学习

- 机器学习基础 维基翻译 典则相关分析 多标签分类 及简单的sklearn例子

- 机器学习之监督学习-分类

- 【机器学习】回归分析、过拟合、分类

- 开发一个应用程序,使用 Python、NLTK 和机器学习对 RSS 提要进行分类

- 【机器学习】multi-label 分类

- 机器学习直播第三弹:Caffe图像分类(基础篇)直播招募

- 机器学习之K-最近邻规则分类(KNN)算法

- 机器学习——最邻近规则分类(K Nearest Neighbor)KNN算法

- 机器学习——分类算法2:决策树 思想和代码解释

- 机器学习经典算法详解及Python实现---朴素贝叶斯分类及其在文本分类、垃圾邮件检测中的应用

- 从GLM广义线性模型到线性回归、二项式及多项式分类——机器学习笔记整理(一)