吴恩达深度学习--激活函数

2018-01-25 23:00

204 查看

四种常用的激活函数

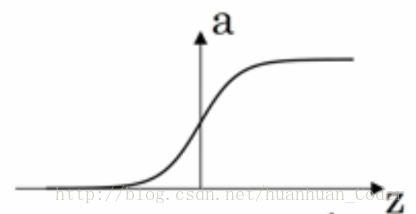

(1)sigmoid函数

函数的表达式为:a=11+e−za=11+e−z

导函数:g′(z)=a(1−a)g′(z)=a(1−a)

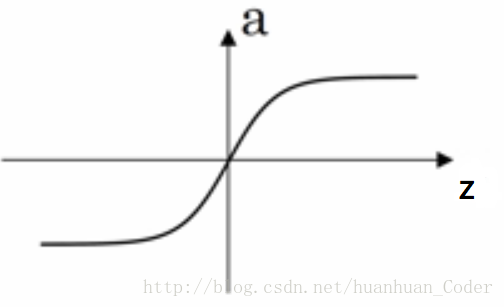

(2)tanh函数

- 函数的表达式为:a=ez−e−zez+e−za=ez−e−zez+e−z

- 导函数:g′(z)=1−a2g′(z)=1−a2

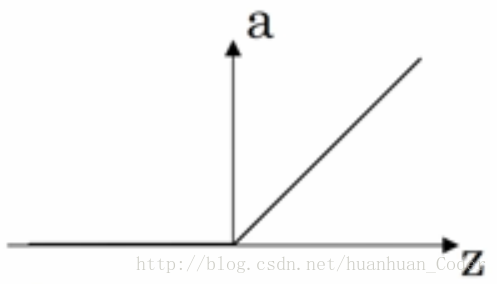

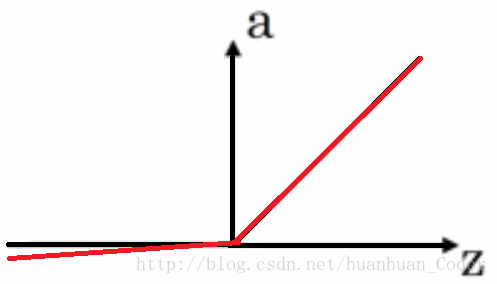

(3)ReLU函数

- 函数的表达式为:a=max(0,z)a=max(0,z)

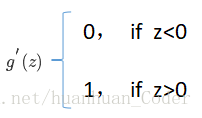

- 导函数:

- 当z=0时是不可导的,此时区导数为0或者1即可。

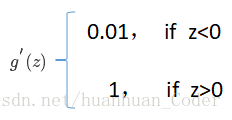

(4)Leaky ReLU

- 函数的表达式为:a=max(0.01z,z)a=max(0.01z,z)。这里可以写0.02z,0.01z只是举个栗子,目的是让ReLU函数在自变量小于0的时候有一定的斜率。

- 导函数:

四种激活函数的应用与比较

(1)相比于sigmoid函数,tanh函数几乎在所有场合都更优越。(2)sigmoid函数用在二元分类的输出层。

(3)默认的激活函数是ReLU函数,当不确定激活函数用哪个时,可以选择ReLU函数。

(4)Leaky ReLu函数的效果比ReLU要好,但是ReLU函数更常用。

(5)使用ReLU函数和Leaky ReLU的好处是:神经网络的学习速度比tanh函数或者sigmoid函数会快的多。

(6)sigmoid函数和tanh函数的缺点是:当z特别大或者特别小时,导数的梯度(函数的斜率)就会很小。

相关文章推荐

- 系统学习深度学习(九)--激活函数总结

- 深度学习---之激活函数的作用

- 深度学习中的激活函数导引

- 深度学习中激活函数的选择

- 深度学习激活函数比较

- 深度学习---之几种激活函数的区别

- 深度学习总结(二)——激活函数的介绍

- 深度学习常用激活函数之— Sigmoid & ReLU & Softmax

- 深度学习笔记六:常见激活函数总结

- 〔转载〕深度学习中的几种激活函数

- 深度学习常用激活函数之— Sigmoid & ReLU & Softmax

- 机器学习/深度学习测试题(一) —— 单层感知器的激活函数

- 【深度学习】深入理解ReLU(Rectifie Linear Units)激活函数

- 深度学习:激活函数的比较和优缺点,sigmoid,tanh,relu

- 深度学习: 激活函数 (Activation Functions)

- 深度学习基础(三):激活函数和损失函数

- 深度学习笔记7:激活函数层的实现

- [深度学习]网络结构,权重初始化,激活函数,fine-tune

- 深度学习---激活函数

- 深度学习中激活函数