python3 [爬虫入门实战]爬取熊猫直播用户信息

2017-08-06 10:07

567 查看

爬取国内各大直播平台直播信息是以后要做的一个功课,还必须是做成一个系列的,可能远没有其他大神那么厉害,毕竟自己经历过的就是有用的,在此做个记录一下

首先我们需要爬取的内容:

这里我们要爬取的有

直播房间名称,直播主播,直播等级,直播第一截屏(这个是动态的图片,要想获取最新的,必须重新进行爬取),直播人数,直播标签,直播类型(分类),暂且就提取了这些,这些内容都可以进行提取。本来一开始是用scrapy框架进行提取的,也可以进行提取,后来发现有点大才了,直接找到返回的json 串就可以了 。

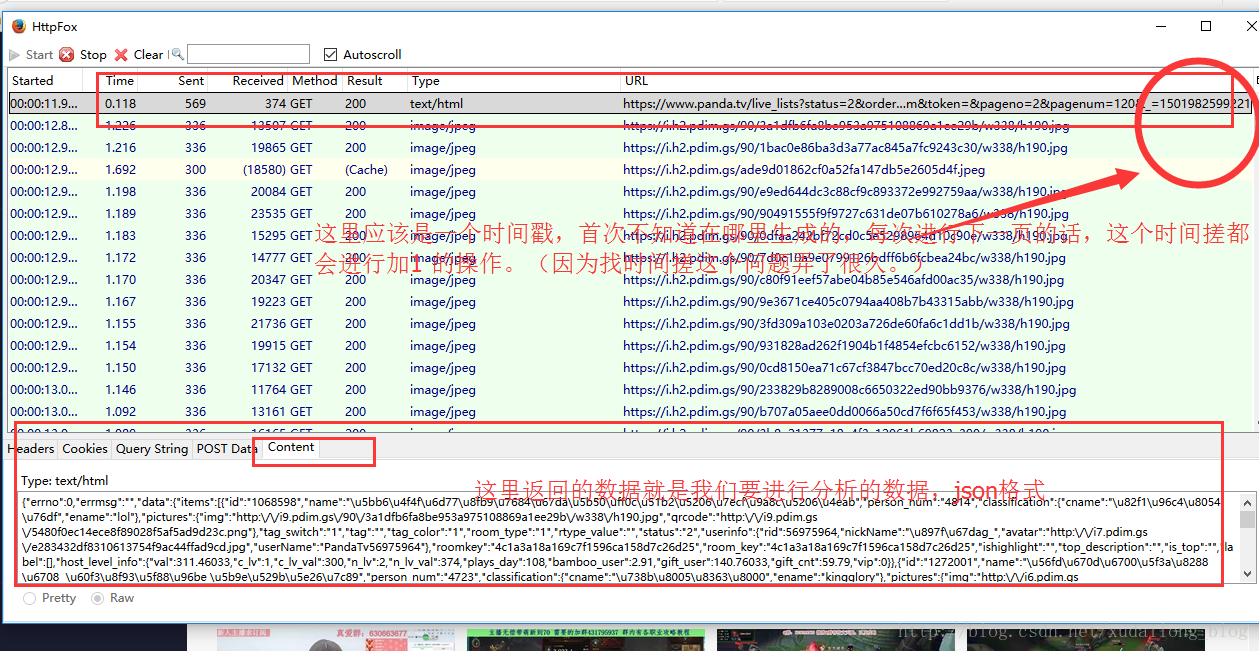

第一次使用Httpfox 感觉真吊,挺爽的,也不用一个一个的标签下面进行解析去了。步骤1:

打开https://www.panda.tv/all 进入熊猫直播的全部目录,然后打开httpfox,清空一下,点击下一页或者2,然后查看httpfox里面的内容,这时候我们会发现

一开始很纠结这个时间戳是怎么来的,看了查看源代码里面的js代码中的function,可能只是单纯的一个new Date()然后再拼接一下其他的取舍问题出来的吧

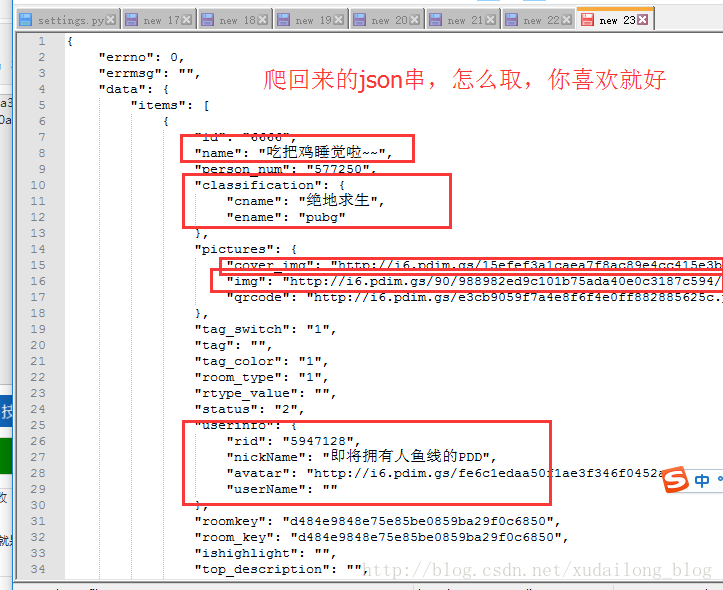

下面我们把这个json串给格式化一下,然后复制到notepad++上,SO,里面你想要什么样的字段都可以,难道不是吗?哈哈

下面上一份代码:

只是打印出来一下数据,可能看着有些简陋

[code]# encoding=utf8

import requests

import json

url = "https://www.panda.tv/live_lists?status=2&order=person_num&token=&pageno=%d&pagenum=120&_=%d".format(a=range(0,35),b=range(1501946526480,1501946526880))

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64; rv:54.0) Gecko/20100101 Firefox/54.0'

,

'Cookie': '__guid=96554777.3243119502220345300.1500627276199.6702; smid=608e0bde-ffe2-4251-90ca-2938cabdc074; monitor_count=18'

,

}

def getHtml(url):

print('##'*30)

req = requests.get(url, headers=headers)

print(req.text)

return req.text

data = getHtml(url)

def printInfos(data):

jsondata = json.loads(data, "utf-8")

print(jsondata)

itemsinfo = jsondata['data']['items']

for pinfo in itemsinfo:

name = pinfo['name']

person_num = pinfo['person_num']

nickName = pinfo['userinfo']['nickName']

lelvel = pinfo['host_level_info']

lable = pinfo['label']

print(lable)

cname = pinfo['classification']

print(cname)

print(name)

print(person_num)

print(nickName)

print(lelvel)

def mainStart():

for n in range(0, 50):

pageindex = 1 + n

pagetime = int(1501946526480 + n)

url = "https://www.panda.tv/live_lists?status=2&order=person_num&token=&pageno=%d&pagenum=120&_=%d"%(pageindex,pagetime)

data = getHtml(url)

printInfos(data)

mainStart()

有点小麻烦的是:

url = “[url="https://www.panda.tv/live_lists?status=2&order=person_num&token=&pageno=%d&pagenum=120&

相关文章推荐

- Python爬虫从入门到放弃(十八)之 Scrapy爬取所有知乎用户信息(上)

- python爬虫实战笔记---以轮子哥为起点Scrapy爬取知乎用户信息

- Python爬虫从入门到放弃(十九)之 Scrapy爬取所有知乎用户信息(下)

- Python爬虫从入门到放弃(十九)之 Scrapy爬取所有知乎用户信息(下)

- 爬虫入门:python+pycharm,豆瓣电影信息,短评,分页爬取,mysql数据库连接

- Python爬虫框架Scrapy实战之定向批量获取职位招聘信息

- Python爬虫入门之get网页信息并作为文本输出

- Python爬虫框架Scrapy实战 - 抓取BOSS直聘招聘信息

- Python爬虫实战入门六:提高爬虫效率—并发爬取智联招聘

- Python爬虫入门 | 5 爬取小猪短租租房信息

- Python爬虫实战入门五:获取JS动态内容—爬取今日头条

- 趣味实战!Python爬虫爬取丁香园用户主页(第一节)

- python--字典--实战分析--用户信息查询接口设计

- python爬虫之爬取捞月狗直播信息

- python3 [爬虫入门实战]scrapy爬取盘多多五百万数据并存mongoDB

- Python爬虫框架Scrapy实战之批量抓取招聘信息

- python爬虫实战 | 爬取豆瓣TOP250排名信息

- python3 [爬虫入门实战]爬虫之scrapy爬取中国医学人才网

- Python爬虫实战一之使用Beautiful Soup抓取百度招聘信息并存储excel文件