CentOS下配置完全分布Hadoop-2.6.0-cdh5.6.0(2)

2017-06-15 11:37

453 查看

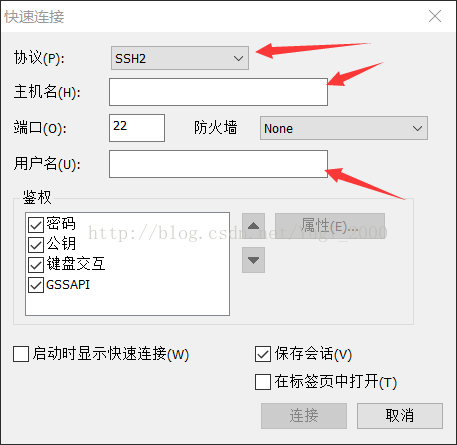

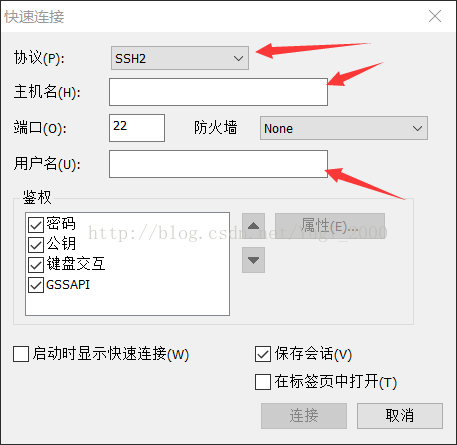

关于SecureCRT的使用

主机名为IP地址,我们之前配置的静态IP就是为了使用这个软件来进行hadoop的远程操作

(假如你是使用root用户来配置hadoop)用户名为root 登陆会要求输入密码。

准备JAVA环境

下载好JDK,使用SecureCRT传入虚拟机,之后,使用解压命令解压到公共文件夹(新建一个usr/local/app)

使用命令mkdir /usr/local/app tar -zxvf 文件名 -C 想解压的目录

解压成功之后

配置环境变量

vi /etc/profile

添加JAVA_HOME跟PATH环境

export JAVA_HOME=/usr/local/app/jdk1.7.0_79

export PATH=$PATH:$JAVA_HOME/bin

之后保存退出,再source /etc/profile

可以echo $JAVA_HOME 查看一下环境变量

到这里JAVA环境就搭配好了。

安装hadoop

先在官网下下载hadoop,记得下载稳定版本

之后使用CRT传入虚拟机,运行解压文件,解压到/usr/local/app

解压完成之后 进去hadoop目录下的etc目录修改hadoop-env.sh这个配置文件

vi /etc/hadoop-env.sh

修改JAVA_HOME为JDK目录,保存退出

之后修改core-site.xml

<property>

<name>fs.defaultFS</name>(默认用哪一个作为我们hadoop的文件系统,用自己自带的hdfs,用URI表示,写主节点(也就是主机名))

<value>hdfs://hadoop-server-00:9000/</value>

</property>

<property>

<name>hadoop.tmp.dir</name>(hadoop运行时的暂时存放路径,存放一些数据或者文件)

<value>/usr/local/app/hadoop-2.6.0-cdh5.6.0/tmp/</value>

</property>

保存退出之后,再修改hdfs相关配置

hdfs.site.xml修改如下

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

表示hdfs使用时默认的备份文件数量,我们为开发测试环境不需要很大,所以1够了

接下来配置MapReduce相关文件

首先mv mapred-site.xml.template mapred-site.xml

之后vi mapred-site.xml<property>

<name>mapreduce.framework.name</name>

<value>yarn</value> (yarn是执行服务的平台 ,配置一下)

</property>

之后再去配置yarn文件(服务组件)

yarn-stie.xml

<property>

<name>yarn.resourcemanager.hostname</name>

(用哪一台机器作用yarn的主节点(也就是进程))

<value>hadoop-server-00</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

到目前为止基本上配置好了 现在要去配置一些小文件

vi slaves 修改localhost为hadoop-server-00

好了 hadoop的配置到此就结束了 接下来尝试启动hadoop

主机名为IP地址,我们之前配置的静态IP就是为了使用这个软件来进行hadoop的远程操作

(假如你是使用root用户来配置hadoop)用户名为root 登陆会要求输入密码。

准备JAVA环境

下载好JDK,使用SecureCRT传入虚拟机,之后,使用解压命令解压到公共文件夹(新建一个usr/local/app)

使用命令mkdir /usr/local/app tar -zxvf 文件名 -C 想解压的目录

解压成功之后

配置环境变量

vi /etc/profile

添加JAVA_HOME跟PATH环境

export JAVA_HOME=/usr/local/app/jdk1.7.0_79

export PATH=$PATH:$JAVA_HOME/bin

之后保存退出,再source /etc/profile

可以echo $JAVA_HOME 查看一下环境变量

到这里JAVA环境就搭配好了。

安装hadoop

先在官网下下载hadoop,记得下载稳定版本

之后使用CRT传入虚拟机,运行解压文件,解压到/usr/local/app

解压完成之后 进去hadoop目录下的etc目录修改hadoop-env.sh这个配置文件

vi /etc/hadoop-env.sh

修改JAVA_HOME为JDK目录,保存退出

之后修改core-site.xml

<property>

<name>fs.defaultFS</name>(默认用哪一个作为我们hadoop的文件系统,用自己自带的hdfs,用URI表示,写主节点(也就是主机名))

<value>hdfs://hadoop-server-00:9000/</value>

</property>

<property>

<name>hadoop.tmp.dir</name>(hadoop运行时的暂时存放路径,存放一些数据或者文件)

<value>/usr/local/app/hadoop-2.6.0-cdh5.6.0/tmp/</value>

</property>

保存退出之后,再修改hdfs相关配置

hdfs.site.xml修改如下

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

表示hdfs使用时默认的备份文件数量,我们为开发测试环境不需要很大,所以1够了

接下来配置MapReduce相关文件

首先mv mapred-site.xml.template mapred-site.xml

之后vi mapred-site.xml<property>

<name>mapreduce.framework.name</name>

<value>yarn</value> (yarn是执行服务的平台 ,配置一下)

</property>

之后再去配置yarn文件(服务组件)

yarn-stie.xml

<property>

<name>yarn.resourcemanager.hostname</name>

(用哪一台机器作用yarn的主节点(也就是进程))

<value>hadoop-server-00</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

到目前为止基本上配置好了 现在要去配置一些小文件

vi slaves 修改localhost为hadoop-server-00

好了 hadoop的配置到此就结束了 接下来尝试启动hadoop

相关文章推荐

- CentOS下配置完全分布式hadoop2.6.0-cdh5.6.0(1)

- CentOS 7伪分布式方式安装Hadoop-2.6.0-cdh5.6.0并且通过主机浏览器访问hadoop工作台

- Centos 7 搭建hadoop-2.6.0和spark1.6.0完全分布式集群教程 (最小化配置)

- Centos6.4 +Hadoop 1.2.1集群完全分布模式配置

- Hadoop2.6.0完全分布式的安装与配置(Centos)

- Hadoop学习6_CentOS6.5系统下Hadoop2.6.0完全分布式环境安装与配置信息介绍

- Hadoop的完全分布模式配置——以普通用户'hadoop'启动

- 64位 CentOS6.6+7.1 配置Hadoop-2.6.0集群

- hadoop完全分布式配置+wordcount示例(ubuntu14.04+hadoop2.6.0)

- CentOS 6.3下hadoop完全分布式配置心得

- CentOS 6.5 配置hadoop 2.6.0伪分布式

- Hbase完全分布式集群安装配置(Hbase1.0.0,Hadoop2.6.0)

- Hbase完全分布式集群安装配置(Hbase1.0.0,Hadoop2.6.0)

- linux(CentOS 7)下eclipse配置maven-3.3.3 和新建maven项目开发hadoop-2.6.0接口

- 【hadoop之翊】——基于CentOS的hadoop2.4.0伪分布安装配置

- CentOS 64位安装配置Hadoop-2.6.0

- HBase入门笔记(三)-- 完全分布模式Hadoop集群安装配置

- Ubuntu14安装配置Hadoop2.6.0(完全分布式)与 wordcount实例运行

- CentOS安装配置Hadoop 1.2.1(伪分布模式)

- 完全分布模式hadoop集群安装配置之二 添加新节点组成分布式集群