机器学习笔记 - 线性可分问题

2017-02-25 16:47

176 查看

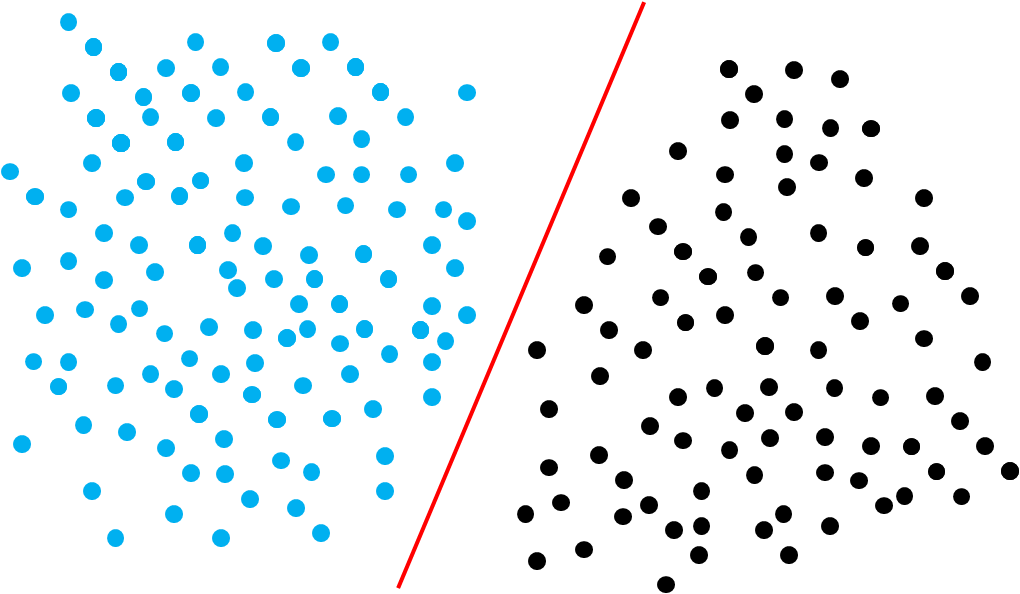

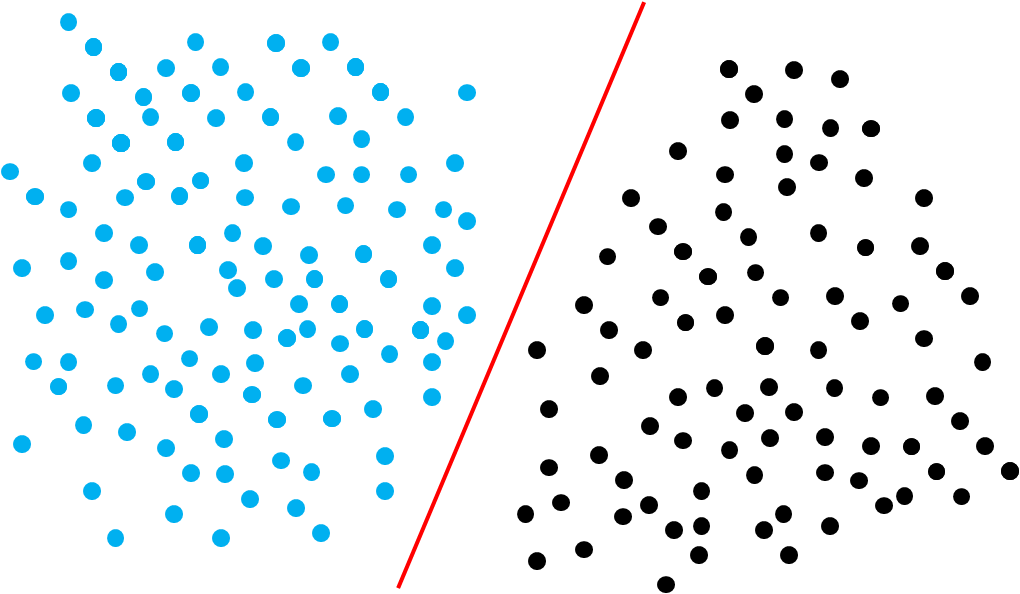

给定训练样本集 D={(x1,y1),(x2,y2),...,(xm,ym)},y∈{−1,1}, 分类学习最基本的想法就是在样本空间D找一个划分超平面, 将不同类型的样本分开, 如下图所示.

在样本空间中, 划分超平面可以用线性方程来描述:

wTx+b=0

所以超平面可以用{w,b}来描述, 样本空间中任意点x到超平面{w,b}的距离为:

r=|wTx+b|||w||

若此超平面可以将训练样本正确分类, 那即对于(xi,yi)∈D, 若 yi=1,则有wTx+b>0,若yi=−1,则有wTx+b<0

则存在两条平行线

wTxi+b>=C,yi=1

wTxi+b<=−C,yi=−1

通过缩放, 可得

wTxi+b>=1,yi=1

wTxi+b<=−1,yi=−1

这两条平行线的距离为

γ=2||w||

于是, 为了达到最优划分, 需要最大化 γ, 也就是

maxw,b2||w||,

s.t. yi(wTxi+b)>=1

这个等价于

minw,b12||w||2

s.t. yi(wTxi+b)>=1

这就是支持向量机SVM的基本型.

Reference:

1. 机器学习 - 周志华 清华大学出版社

2. http://blog.csdn.net/liangdas/article/details/44251469

在样本空间中, 划分超平面可以用线性方程来描述:

wTx+b=0

所以超平面可以用{w,b}来描述, 样本空间中任意点x到超平面{w,b}的距离为:

r=|wTx+b|||w||

若此超平面可以将训练样本正确分类, 那即对于(xi,yi)∈D, 若 yi=1,则有wTx+b>0,若yi=−1,则有wTx+b<0

则存在两条平行线

wTxi+b>=C,yi=1

wTxi+b<=−C,yi=−1

通过缩放, 可得

wTxi+b>=1,yi=1

wTxi+b<=−1,yi=−1

这两条平行线的距离为

γ=2||w||

于是, 为了达到最优划分, 需要最大化 γ, 也就是

maxw,b2||w||,

s.t. yi(wTxi+b)>=1

这个等价于

minw,b12||w||2

s.t. yi(wTxi+b)>=1

这就是支持向量机SVM的基本型.

Reference:

1. 机器学习 - 周志华 清华大学出版社

2. http://blog.csdn.net/liangdas/article/details/44251469

相关文章推荐

- 机器学习笔记 - 线性分割对偶问题

- 机器学习笔记(X)线性模型(VI)类别不平衡问题

- 0044算法笔记——【随机化算法】舍伍德(Sherwood)算法和线性时间选择问题

- 【机器学习-斯坦福】学习笔记4 ——牛顿方法;指数分布族; 广义线性模型(GLM)

- 机器学习问题分类--机器学习基石笔记

- 机器学习笔记 线性判别分析(中)

- 机器学习笔记 线性判别分析(上)

- 机器学习 -- SVM:线性可分性问题(转载)

- 机器学习笔记_回归_1:线性回归

- 线性代数笔记(特征问题与矩阵相似)

- 机器学习笔记(一)线性回归

- 机器学习笔记 线性判别分析(上)

- 【机器学习-斯坦福】学习笔记7 - 最优间隔分类器问题

- 机器学习基石笔记1——学习问题

- 斯坦福机器学习-week 3 学习笔记(2)——Matlab最优问题求解

- Stanford机器学习课程笔记——LR的公式推导和过拟合问题解决方案

- 【机器学习-斯坦福】学习笔记7 - 最优间隔分类器问题

- 加州理工学院公开课:机器学习与数据挖掘课程笔记(一)学习问题

- 【机器学习-斯坦福】学习笔记7 - 最优间隔分类器问题

- 【机器学习-斯坦福】学习笔记7 - 最优间隔分类器问题