spark学习5(hbase集群搭建)

2016-12-15 21:57

387 查看

第一步:Hbase安装

hadoop,zookeeper前面都安装好了将hbase-1.1.3-bin.tar.gz上传到/usr/HBase目录下

[root@spark1 HBase]# chmod u+x hbase-1.1.3-bin.tar.gz [root@spark1 HBase]# tar -zxvf hbase-1.1.3-bin.tar.gz [root@spark1 HBase]# mv hbase-1.1.3 hbase-1.1 [root@spark1 ~]# vi/etc/profile #配置环境变量 export HBASE_HOME=/usr/HBase/hbase-1.1 export PATH=$PATH:$HBASE_HOME/bin [root@spark1 ~]# source /etc/profile #使其生效

第二步:修改配置文件

编辑 hbase-env.xml

[root@spark1 conf]# vi hbase-env.sh # The java implementation to use. Java 1.7+ required. export JAVA_HOME=/usr/java/jdk # Extra Java CLASSPATH elements. Optional. export HBASE_CLASSPATH=/usr/HBase/hbase-1.1/conf # Tell HBase whether it should manage it's own instance of Zookeeper or not. export HBASE_MANAGES_ZK=false 使用HBASE自带的zookeeper管理集群用true,自己安装的用false

编辑 hbase-site.xml

[root@spark1 hbase-1.1]# mkdir tmp

[root@spark1 hbase-1.1]# cd conf [root@spark1 conf]# vi hbase-site.xml <property> <name>hbase.tmp.dir</name> <value>/usr/HBase/hbase-1.1/tmp</value> </property> <!-- 指定hbase在HDFS上存储的路径 --> <property> <name>hbase.rootdir</name> <value>hdfs://spark1:9000/hbase</value> </property> <!-- 打开 hbase 分布模式 --> <property> <name>hbase.cluster.distributed</name> <value>true</value> </property> <!-- 指定zk的地址,多个用“,”分割 --> <property> <name>hbase.zookeeper.quorum</name> <value>spark1,spark2,spark3</value> </property>

编辑 regionservers

[root@spark1 conf]# vi regionservers #添加从节点 spark2 spark3

第三步:搭建hbase集群

[root@spark1 usr]# scp -r HBase root@spark2:/usr/ [root@spark1 usr]# scp -r HBase root@spark3:/usr/ [root@spark1 ~]# scp -r /etc/profile root@spark2:/etc/ [root@spark1 ~]# scp -r /etc/profile root@spark3:/etc/ [root@spark2 ~]# source /etc/profile [root@spark3 ~]# source /etc/profile

第四步:启动 / 关闭 Hbase 数据库集群

启动前我先把hadoop启动和zookeeper启动[root@spark1 ~]# zkServer.sh start #三个节点都要启动 [root@spark1 ~]# zkServer.sh status #查看是否启动成功 [root@spark1 ~]# start-all.sh #启动hadoop [root@spark1 ~]# start-hbase.sh [root@spark1 ~]# stop-hbase.sh

第五步:验证启动

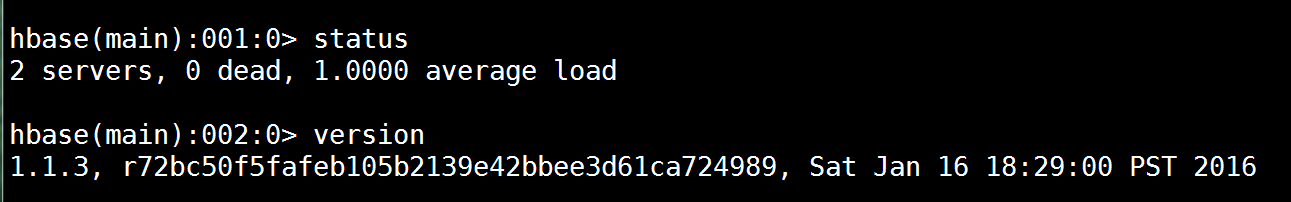

查看jps和hbase shell

[root@spark1 ~]# jps [root@spark1 ~]# hbase shell status #查看状态 version #查看版本

相关文章推荐

- 大数据学习系列之七 ----- Hadoop+Spark+Zookeeper+HBase+Hive集群搭建 图文详解

- [置顶] 大数据学习系列之七 ----- Hadoop+Spark+Zookeeper+HBase+Hive集群搭建 图文详解

- HBase-1.0.1学习笔记(一)集群搭建

- Spark生态之Alluxio学习8---集群版搭建问题之集群无法全部启动

- Hadoop-2.6.0+Zookeeper-3.4.6+Spark-1.5.0+Hbase-1.1.2+Hive-1.2.0集群搭建

- Spark源码学习-windows使用idea搭建源码阅读集群

- Docker下HBase学习,三部曲之二:集群HBase搭建

- Hadoop2.2.0 HA高可用分布式集群搭建(hbase,hive,sqoop,spark)

- ganglia学习1之ganglia集群版搭建(支持hadoop和spark)

- hadoop、zookeeper、hbase、spark集群环境搭建

- spark学习4(zookeeper3.4集群搭建)

- 大数据1-hadoop、zookeeper、hbase、spark集群环境搭建

- 搭建大数据处理集群(Hadoop,Spark,Hbase)

- hbase学习01-集群搭建

- Hadoop学习之HBase的集群环境搭建

- Spark生态之Alluxio学习6---集群版搭建和运行(Tachyon)

- Hadoop-2.6.0+Zookeeper-3.4.6+Spark-1.5.0+Hbase-1.1.2+Hive-1.2.0集群搭建

- Hadoop2.7.0学习——Hbase-0.98.13集群搭建

- Spark学习之(一) HDFS 集群环境搭建

- hadoop、zookeeper、hbase、spark集群环境搭建