孙其功陪你学之——基于IDEA使用Spark API开放Spark程序(3)

2015-01-16 14:05

369 查看

《Spark亚太研究院系列丛书——Spark实战高手之路 从零开始》本书通过Spark的shell测试Spark的工作;使用Spark的cache机制观察一下效率的提升构建Spark的IDE开发环境;通过Spark的IDE搭建Spark开发环境;测试Spark IDE开发环境等等。本节为大家介绍基于IDEA使用Spark

API开放Spark程序。

基于IDEA使用Spark API开放Spark程序(3)

把名称改为FirstSparkAppJar:

因为每台机器上都安装了Scala和Spark,所以可以把Scala和Spark相关的jar文件都删除掉:

接下来进行Build:

选择“Build Artifacts”:

第一次是选择Build,以后同一个工程要选择Rebuild,然后等待编译完成:

进入其编译后目录查看编译完成的文件:

接下来使用spark-submit运行该程序:

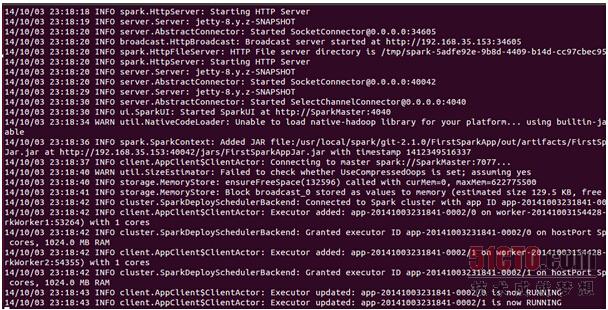

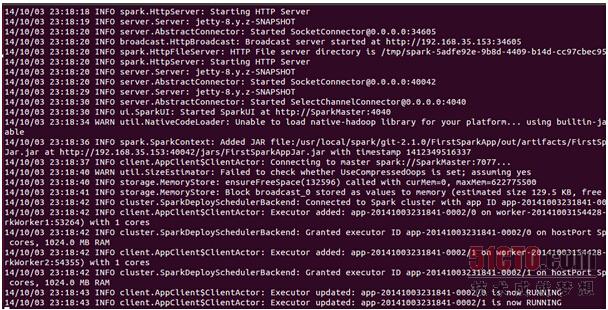

此时查看控制台:

最后运行完成任务:

我们到HDFS控制台查看运行结果:

进入SogouQResult文件夹:

查看执行结果:

这个内容和我们前面完全spark-shell的执行时一样的。

API开放Spark程序。

基于IDEA使用Spark API开放Spark程序(3)

把名称改为FirstSparkAppJar:

因为每台机器上都安装了Scala和Spark,所以可以把Scala和Spark相关的jar文件都删除掉:

接下来进行Build:

选择“Build Artifacts”:

第一次是选择Build,以后同一个工程要选择Rebuild,然后等待编译完成:

进入其编译后目录查看编译完成的文件:

接下来使用spark-submit运行该程序:

此时查看控制台:

最后运行完成任务:

我们到HDFS控制台查看运行结果:

进入SogouQResult文件夹:

查看执行结果:

这个内容和我们前面完全spark-shell的执行时一样的。

相关文章推荐

- 孙其功陪你学之——基于IDEA使用Spark API开放Spark程序(1)

- 孙其功陪你学之——基于IDEA使用Spark API开放Spark程序(2)

- Spark API编程动手实战-08-基于IDEA使用Spark API开发Spark程序-01

- Spark API编程动手实战-08-基于IDEA使用Spark API开发Spark程序-02

- Spark API编程动手实战-08-基于IDEA使用Spark API开发Spark程序-02

- Spark API编程动手实战-08-基于IDEA使用Spark API开发Spark程序-01

- 基于IDEA使用Spark API开发Spark程序

- 使用IDEA编写基于Scala的spark程序中的常见问题

- 使用IDEA运行Spark程序

- 使用idea编辑sparkSql的程序运行出现java.lang.IllegalArgumentException: java.net.URISyntaxException

- 使用Idea提交Spark程序

- Spark一千篇旅游日记0002 之 使用idea开发spark程序

- 使用IDEA进行Spark开发(二)-第一个scala程序

- 使用IDEA运行Spark程序

- 启动Spark Shell,在Spark Shell中编写WordCount程序,在IDEA中编写WordCount的Maven程序,spark-submit使用spark的jar来做单词统计

- 使用IDEA开发spark程序

- Learning Spark笔记13-基于分区工作、通过管道使用外部程序、数字RDD操作

- Learning Spark——使用Intellij Idea开发基于Maven的Spark程序

- intelliji idea 基于maven运行spark程序

- 使用IDEA运行Spark程序