hadoop安装

Hadoop 安装

1、安装java jdk

版本 jdk1.8.0_141

步骤:

1、创建 /opt/SoftWare/java 并将jar包拉进去

命令 tar -zxvf jdk1.8.0_141.tar.gz 解压

2、配置

vi /etc/profile

#set java environment export JAVA_HOME=/opt/software/java/jdk1.8.0_141 export JRE_HOME=/opt/software/java/jdk1.8.0_141/jre export CLASSPATH=.:$JRE_HOME/lib/rt.jar:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar export PATH=$PATH:$JAVA_HOME/bin:$JRE_HOME/bin

3、 重新加载 命令 : source /etc/profile

4、 java -version 查看

2、安装Hadoop

版本:hadoop-2.7.3

步骤:

1、创建 /opt/SoftWare/hadoop 并将jar包拉进去

命令 tar -zxvf hadoop-2.7.3.tar.gz 解压

2、配置

#hadoop export HADOOP_HOME=/opt/software/hadoop/hadoop-2.7.3 export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

3、 重新加载 命令 : source /etc/profile

4、hadoop version

Hadoop单机集群安装:

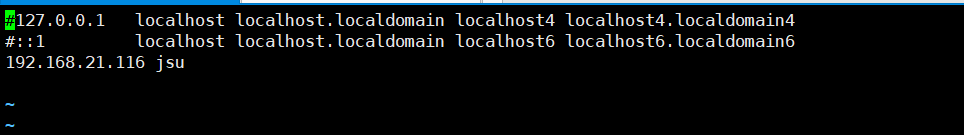

1. 修改主机名和ip映射

vi /etc/hosts 192.168.233.128 jsu

注释掉前两行

2、 修改配置文件

进入 cd /opt/software/hadoop/hadoop-2.7.3/etc/hadoop目录下

伪分布式需要修改5个配置文件

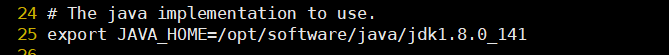

2.1 第一个:hadoop-env.sh

vi hadoop-env.sh

自己jdk的位置

2.2 第二个:core-site.xml

vi core-site.xml

<!-- 指定集群的文件系统类型:分布式文件系统 HDFS的老大(NameNode)的地址 --> <property> <name>fs.defaultFS</name> <value>hdfs://jsu:9000</value> </property> <!-- 指定hadoop运行时产生文件的存储目录[能自动生成目录] --> <property> <name>hadoop.tmp.dir</name> <value>/jsu/hadoop/tmp</value> </property>

2.3 第三个:hdfs-site.xml

vi hdfs-site.xml

<!-- 指定HDFS副本的数量 --> <property> <name>dfs.replication</name> <value>1</value> </property> <!-- 下面的配置可不加 --> <property> <name>dfs.namenode.name.dir</name> <value>/usr/local/hadoop/tmp/dfs/name</value> </property> <property> <name>dfs.datanode.data.dir</name> <value>/usr/local/hadoop/tmp/dfs/data</value> </property>

2.4 第四个:mapred-site.xml

移动文件 mv mapred-site.xml.template mapred-site.xml

vi mapred-site.xml

<!-- 指定mr运行在yarn上 --> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property>

2.5 第五个yarn-site.xml

<!-- 指定YARN的老大(ResourceManager)的地址 --> <property> <name>yarn.resourcemanager.hostname</name> <value>jsu</value> </property> <!-- reducer获取数据的方式 --> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property>

3、格式化namenode

hadoop namenode -format

4、启动hadoop

#先启动HDFS sbin/start-dfs.sh #再启动YARN sbin/start-yarn.sh #一路yes 加上输入自己的root密码

5、验证是否启动成功

[root@jsu sbin]# jps 3912 DataNode 4378 Jps 4331 NodeManager 4093 SecondaryNameNode 3822 NameNode 4239 ResourceManager

6. 关闭防火墙

#停止firewall systemctl stop firewalld systemctl disable firewalld.service #禁止firewall开机启动

7. 浏览器查看

http://192.168.21.116:50070 (HDFS管理界面)

http://192.168.21.116:8088 yarn管理界面)

SSH免密登录

cd ~/.ssh ssh-keygen -t rsa (四个回车) 执行完这个命令后,会生成两个文件id_rsa(私钥)、id_rsa.pub(公钥) 将公钥拷贝到要免登陆的机器上 ssh-copy-id 192.168.233.128 #ip

HDFS shell常用命令

hadoop fs -help [cmd] #显示命令的帮助信息 hadoop fs -ls(r)<path> #显示当前目录下所有文件 hadoop fs -du(s)<path> #显示目录中所有文件大小 hadoop fs -count[-q] <path> #显示目录中文件数量 hadoop fs -mv <src> <dst> #移动多个文件到目标目录 hadoop fs -cp<src> <dst> #复制多个文件到目标目录 hadoop fs -rmr /t1 #删除文件(夹) hadoop fs -put <localsrc> <dst> #本地文件复制到hdfs hadoop fs -copyFromLocal #同put hadoop fs -moveFromLocal #从本地文件移动到hdfs hadoop fs -get [-ignoreCrc] <src> <localdst> #复制文件到本地,可以忽略crc校验 hadoop fs -getmerge <src> <localdst> #将源目录中的所有文件排序合并到一个文件中 hadoop fs -cat <src> #在终端显示文件内容 hadoop fs -ls / #查看HDFS系统根目录 hadoop fs -ls hdfs://192.168.233.129:9000/ hadoop fs -ls hdfs://zhiyou01:9000/ hadoop fs -mkdir /a #创建文件夹 hadoop fs -mkdir -p /aa/bb/cc #创建级联文件夹 hadoop fs -ls -R /aa #查看系统根目录下的所有文件包括子文件夹里面的文件 hadoop fs -put words.txt /aa #上传文件 hadoop fs -copyFromLocal words.txt /aa/bb #上传文件

:9000/

hadoop fs -mkdir /a #创建文件夹

hadoop fs -mkdir -p /aa/bb/cc #创建级联文件夹

hadoop fs -ls -R /aa #查看系统根目录下的所有文件包括子文件夹里面的文件

hadoop fs -put words.txt /aa #上传文件

hadoop fs -copyFromLocal words.txt /aa/bb #上传文件

- cdh安装hadoop平台根目录空间不足如何解决

- Windows安装hadoop

- hadoop2.2完全分布式安装文档

- hadoop 安装和配置

- hadoop基本介绍及简单安装配置

- Hadoop安装

- Hadoop2.0单机环境安装部署

- hadoop+zookeeper+hbase安装、配置及应用实例

- CentOS6.5+hadoop1.2.1安装配置测试记录

- 【hadoop】hadoop安装篇

- CentOS环境下安装Hadoop集群

- hadoop 1.2.1 安装步骤 伪分布式

- Hadoop 2.4.x集群安装配置问题总结

- oozie on yarn oozie 4.0.1 hadoop2.3.0 安装笔记

- Hadoop本地模式的安装与配置及官测试方WordCount程序

- hadoop,hbase,hive安装全记录 (转)

- ubuntu 12.04下安装并运行hadoop

- Hadoop学习笔记(7)-HIVE安装

- Ubuntu Kylin16.04 安装Hadoop2.7.4 伪分布式

- Hadoop 2.2.0和HBase-0.98 安装snappy