Mac平台上Spark和PySpark的安装

2020-04-15 14:50

92 查看

基于python3和pip3已安装的基础上:

-

官网下载并安装jdk(https://www.oracle.com/java/technologies/javase-downloads.html),跟着默认步骤走就可以

-

下载spark(http://spark.apache.org/downloads.html)

下载完成后解压并移动到/usr/local文件夹。

下载完成后解压并移动到/usr/local文件夹。sudo mv spark-3.0.0-preview2-bin-hadoop2.7 /usr/local

在spark的安装路径(/usr/local)中找到./conf/spark-env.sh.template重命名为spark-env.sh。

sudo cp spark-env.sh.template spark-env.sh

执行which python3拿到python3的路径(/usr/local/bin/python3)

which python3

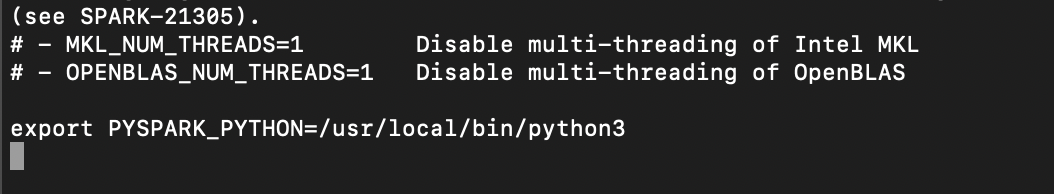

并添加python3路径 export PYSPARK_PYTHON=/usr/local/bin/python3 到spark-env.sh

vim ~/.bash_profile在文件中添加export SPARK_HOME=/usr/local/spark-3.0.0-preview2-bin-hadoop2.7 export PATH=$PATH:$SPARK_HOME/bin

然后执行source ~/.bash_profile

-

安装pyspark

pip install pyspark

可能比较慢,耐心等待

-

在terminal中执行pyspark

相关文章推荐

- 在Windows 和Mac平台上破解安装Flash Builder 4

- 基于pyspark 和scala spark的jupyter notebook 安装

- Mac下安装mysql5.7 完整步骤以及 Mac平台重新设置MySQL的root密码等问题汇总

- Mac Apache-spark 单机安装

- spark(pyspark)安装和部署(Linux,windows)

- Win7 单机Spark和PySpark安装

- Mac下安装Spark开发环境(Linux系统可参照)

- Mac平台下boost安装及使用

- Mac 安装 hadoop+hive+hbase+spark

- mac下安装配置Spark

- mac平台安装配置TomCat

- Mac下安装Spark开发环境(Linux系统可参照)

- Mac平台上Docker安装与使用

- mac本机pySpark配置并且能在本地远程调用服务器Spark以及文件

- MySql下载安装(Mac平台) 终端启动 XMAPP启动

- bigdata_mac下安装spark_scala

- 电商用户行为分析大数据平台相关系列7-spark安装

- 在Mac平台上安装配置ELK时的一些总结

- Mac端pycharm平台下pyenv和pyenv-virtualenv管理python版本的安装和简单实用

- Mac下安装Spark开发环境(Linux系统可参照)