「初级算法学习小组」任务1——线性回归算法梳理

2019-03-29 15:59

393 查看

1. 机器学习基础概念

1.1 监督与无监督

监督学习研究的是属性x和输出值y之间的关系。

无监督研究的是属性和属性之间的关系,这时候没有输出值或者标签值y。

1.2 泛化能力

我们学得的模型,它作用于新样本的表现能力,称为泛化能力。

1.3 过拟合欠拟合

模型对训练集适配得很好,模拟得很好,在测试集上却表现很差,叫作过拟合。这时候方差会比较大。

过拟合是无法完全避免的,只能尽可能去减少过拟合的风险。

模型对训练集都模拟不好,就叫欠拟合。这时候偏差会很大。

解决方法:增加训练集样本数、增加训练次数,在决策树中,我们可以增加训练的分支数。

方差、偏差 各自解决办法

1.4 交叉验证

将样本划分成k个大小相似的互斥子集。(尽量保证每个子集与总体分布一致)

每次使用k-1个子集训练模型,剩下的子集作为测试集。如此进行k次训练、测试,最终返回k次测试结果的均值。

2. 线性回归原理

线性回归是一种通过构建线性模型来进行预测的回归分析。它的基本形式是属性的线性组合函数:

3.线性回归损失函数、目标函数

3.1 损失函数、代价函数

损失函数讲的是单个样本的误差。

代价函数是训练集所有样本误差的均值。

Tips:最小二乘法:

基于均方误差最小化来求解模型的方法叫作“最小二乘法”。在线性回归中,最小二乘法就是试图找到一条直线,使所有样本到直线上的欧式距离之和最小。这时候对应的参数值,就是我们要找的最有参数。

Tips:欧氏距离:

也叫欧几里得距离,两点之间的真实距离。(对应坐标之差的平方和)

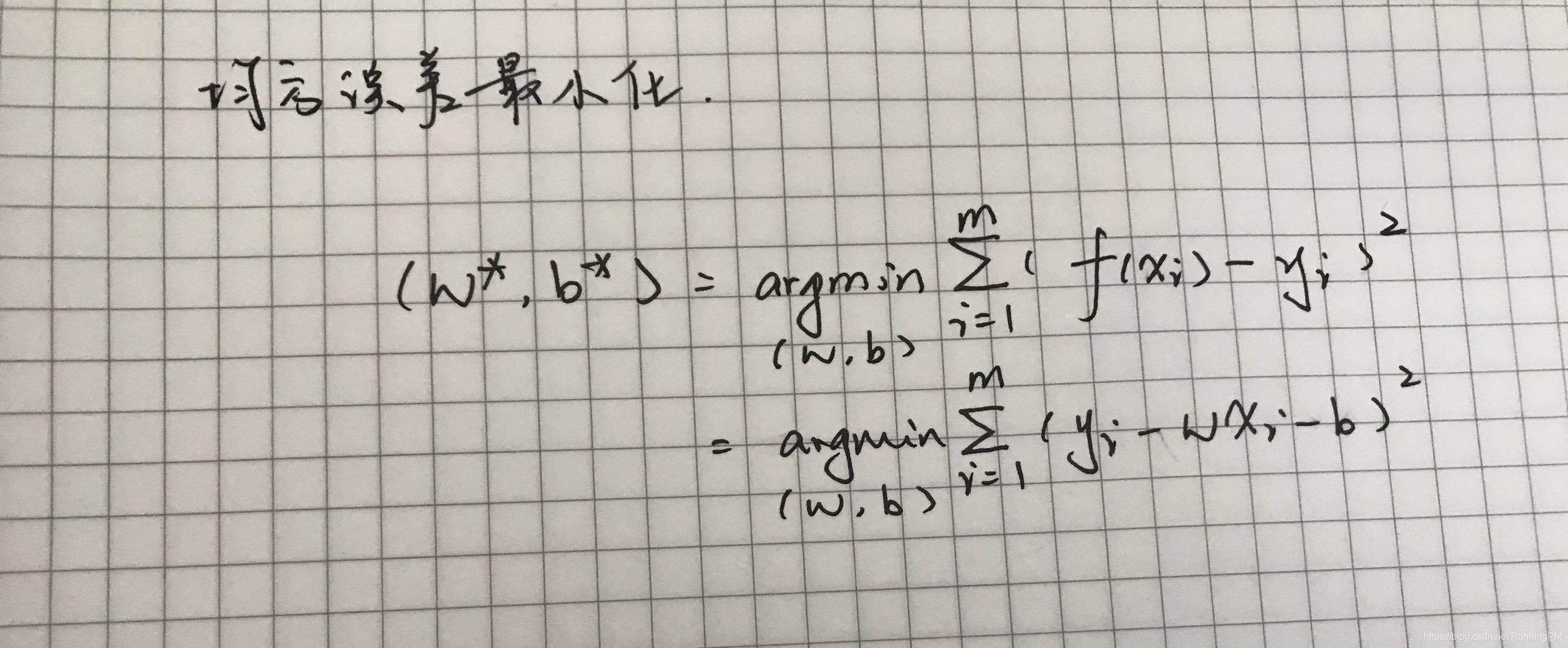

3.2 目标函数

也就是优化的目标是谁。可以直接是损失函数,也可以是损失函数+正则项。

4. 优化方法

4.1 梯度下降

一种迭代方法,不断更新参数,找到使得目标函数最小的最优参数。

4.2 牛顿法

求解导数为0的点。

4.3 拟牛顿法

牛顿法在每次迭代时需要计算出Hessian矩阵,然后求解一个以该矩阵为系数矩阵的线性方程组。

5. 评估指标

MESE、RMSE、R方 等指标。

6. sklearn参数详解

sklearn.linear_model.LinearRegression4000

相关文章推荐

- 初级算法梳理 任务一 线性回归算法梳理

- 第六期-初级算法梳理-任务一 线性回归算法梳理

- Datawhale 初级算法梳理 - 线性回归算法梳理

- 初级算法梳理任务2打卡

- Datawhale-初级算法梳理-Day1-线性回归算法梳理

- 初级算法梳理(Day1)

- NENU 17级算法学习小组 Round 5 0627

- 多任务学习算法及代码实现

- 任务二 逻辑回归算法梳理

- 【算法学习】-线性回归算法

- freeCodeCamp学习记录——初级算法[01]翻转字符串

- NENU 17级算法学习小组 Roun4 0620

- 算法学习之旅,初级篇(22)--循环队列

- 机器学习初级算法梳理二

- 增强学习Reinforcement Learning经典算法梳理1:policy and value iteration

- 算法学习之旅,初级篇(7)--数字塔

- 算法学习之旅,初级篇(9)--字符串逆序

- 机器学习初级算法梳理一

- Datawhale-初级算法梳理-Day2-逻辑回归算法梳理

- 算法学习之旅,初级篇(17)--质因数分解