理解进程创建、可执行文件的加载和进程执行、进程切换,重点理解分析fork、execve和进程切换

学号后三位:491

原创作品,转载请注明出处

参考连接https://github.com/mengning/linuxkern

4000

el/

阅读理解task_struct数据结构

什么是进程

- 进程是程序的一个执行实例

- 进程是正在执行的程序

- 进程是能分配处理器并由处理器执行的实体

为了管理进程,操作系统必须对每个进程所做的事情进行清楚的描述,为此,操作系统使用数据结构来代表处理不同的实体,这个数据结构就是通常所说的进程描述符或进程控制块(PCB

)。在Linux中,task_struct

其实就是通常所说的PCB

。所属的头文件#include <sched.h>

每个进程都会被分配一个task_struct

结构,它包含了这个进程的所有信息,在任何时候操作系统都能够跟踪这个结构的信息。

task_struct结构中主要包含以下内容:

- 状态信息:如就绪、执行等状态

- 链接信息:用来描述进程之间的家庭关系,例如指向父进程、子进程、兄弟进程等PCB的指针 各种标识符,如进程标识符、用户及组标识符等

- 时间和定时器信息:进程使用CPU时间的统计等 调度信息:调度策略、进程优先级、剩余时间片大小等

- 处理机环境信息:处理器的各种寄存器以及堆栈情况等

- 虚拟内存信息:描述每个进程所拥有的地址空间

struct task_struct{

pid_t pid; //进程id

uid_t uid,euid;

gid_t gid,egid;

volatile long state; //进程状态,0 running(运行/就绪);1/2 均等待态,分别响应/不响应异步信号;4 僵尸态,Linux特有,为生命周期已终止,但PCB未释放;8 暂停态,可被恢复

int exit_state; //退出的状态

unsigned int rt_priority; //调度优先级

unsigned int policy; //调度策略

struct list_head tasks;

struct task_struct *real_parent;

struct task_struct *parent;

struct list_head children,sibling;

struct fs_struct *fs; //进程与文件系统管理,进程工作的目录与根目录

struct files_struct *files; //进程对所有打开文件的组织,存储指向文件的句柄们

struct mm_struct *mm; //内存管理组织,存储了进程在用户空间不同的地址空间,可能存的数据,可能代码段

struct signal_struct *signal; //进程间通信机制--信号

struct sighand_struct *sighand; //指向进程

cputime_t utime, stime; //进程在用户态、内核态下所经历的节拍数

struct timespec start_time; //进程创建时间

struct timespec real_start_time; //包括睡眠时间的创建时间

}

分析fork函数对应的内核处理过程do_fork

-

fork、vfork和clone三个系统调用都可以创建一个新进程,而且都是通过调用do_fork来实现进程的创建

具体过程如下:

fork() -> sys_clone() -> do_fork() -> dup_task_struct() -> copy_process() -> copy_thread() -> ret_from_fork()

long do_fork(unsigned long clone_flags,

unsigned long stack_start,

unsigned long stack_size,

int __user *parent_tidptr,

int __user *child_tidptr)

{

struct task_struct *p;

int trace = 0;

long nr;

// ...

// 复制进程描述符,返回创建的task_struct的指针

p = copy_process(clone_flags, stack_start, stack_size,

child_tidptr, NULL, trace);

if (!IS_ERR(p)) {

struct completion vfork;

struct pid *pid;

trace_sched_process_fork(current, p);

// 取出task结构体内的pid

pid = get_task_pid(p, PIDTYPE_PID);

nr = pid_vnr(pid);

if (clone_flags & CLONE_PARENT_SETTID)

put_user(nr, parent_tidptr);

// 如果使用的是vfork,那么必须采用某种完成机制,确保父进程后运行

if (clone_flags & CLONE_VFORK) {

p->vfork_done = &vfork;

init_completion(&vfork);

get_task_struct(p);

}

// 将子进程添加到调度器的队列,使得子进程有机会获得CPU

wake_up_new_task(p);

// ...

// 如果设置了 CLONE_VFORK 则将父进程插入等待队列,并挂起父进程直到子进程释放自己的内存空间

// 保证子进程优先于父进程运行

if (clone_flags & CLONE_VFORK) {

if (!wait_for_vfork_done(p, &vfork))

ptrace_event_pid(PTRACE_EVENT_VFORK_DONE, pid);

}

put_pid(pid);

} else {

nr = PTR_ERR(p);

}

return nr;

}

-

do_fork处理了以下内容

(1)调用

copy_process,将当期进程复制一份出来为子进程,并且为子进程设置相应地上下文信息。

(2)初始化

vfork的完成处理信息(如果是

vfork调用)

(3)调用

wake_up_new_task,将子进程放入调度器的队列中,此时的子进程就可以被调度进程选中,得以运行。

(4)如果是

vfork调用,需要阻塞父进程,知道子进程执行

exec

-

进程的创建

1、

do_fork()流程

首先调用

copy_process()为子进程复制出一份进程信息,如果是

vfork()则初始化完成处理信息;

然后调用

wake_up_new_task将子进程加入调度器,为之分配CPU,如果是

vfork(),则父进程等待子进程完成

exec替换自己的地址空间

2、

copy_process()流程

首先调用

dup_task_struct()复制当前的

task_struct,检查进程数是否超过限制;

接着初始化自旋锁、挂起信号、CPU 定时器等;

然后调用

sched_fork初始化进程数据结构,并把进程状态设置为

TASK_RUNNING,复制所有进程信息,包括文件系统、信号处理函数、信号、内存管理等;

调用

copy_thread()初始化子进程内核栈,为新进程分配并设置新的

pid

3、

dup_task_struct()流程

调用

alloc_task_struct_node()分配一个

task_struct节点;

调用

alloc_thread_info_node()分配一个

thread_info节点,其实是分配了一个

thread_union联合体,将栈底返回给

ti;

最后将栈底的值

ti赋值给新节点的栈。

4、

copy_thread的流程

获取子进程寄存器信息的存放位置

对子进程的

thread.sp赋值,将来子进程运行,这就是子进程的

esp寄存器的值。

如果是创建内核线程,那么它的运行位置是

ret_from_kernel_thread,将这段代码的地址赋给

thread.ip,之后准备其他寄存器信息,退出

将父进程的寄存器信息复制给子进程。

将子进程的

eax寄存器值设置为0,所以fork调用在子进程中的返回值为0.

子进程从

ret_from_fork开始执行,所以它的地址赋给

thread.ip,也就是将来的

eip寄存器。

5、新进程从

ret_from_fork处开始执行,子进程的运行是由这几处保证的

dup_task_struct中为其分配了新的堆栈

copy_process中调用了

sched_fork,将其置为

TASK_RUNNING

copy_thread中将父进程的寄存器上下文复制给子进程,这是非常关键的一步,这里保证了父子进程的堆栈信息是一致的。

将

ret_from_fork的地址设置为

eip寄存器的值,这是子进程的第一条指令。

问题:如何创建一个新进程

通过调用

do_fork来实现进程的创建;

复制父进程

PCB–task_struct来创建一个新进程,要给新进程分配一个新的内核堆栈;

修改复制过来的进程数据,比如

pid、进程链表等等执行

copy_p 1b023 rocess和

copy_thread

使用gdb跟踪分析一个fork系统调用内核处理函数do_fork

1.启动MenuOS

cd LinuxKernel

rm -rf menu

git clone https://github.com/mengning/menu.git

cd menu

mv test_fork.c test.c

make rootfs

2.进入gdb调试模式(在LinuxKernel文件夹下执行以下命令)

gdb

file linux-3.18.6/vmlinux

target remote:1234

在以下位置设置断点

b sys_clone

b do_fork

b dup_task_struct

b copy_process

b copy_thread

b ret_from_for

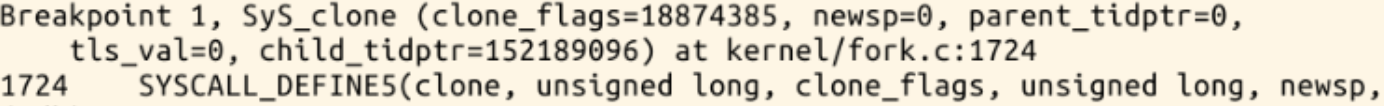

运行后首先停在sys_clone处:

然后到do_fork:

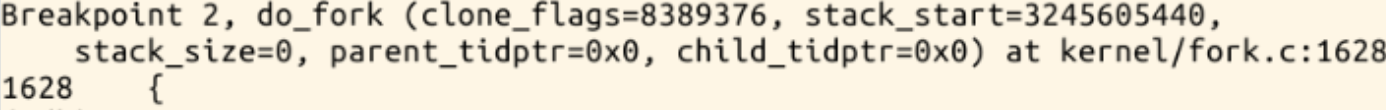

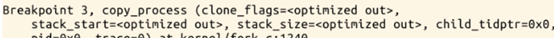

再到copy_process

进入copy_thread

在copy_thread中,我们可以查看p的值

理解编译链接的过程和ELF可执行文件格式

动态链接库(Dynamic Linked Library): Windows为应用程序提供了丰富的函数调用,这些函数调用都包含在动态链接库中。其中有3个最重要的DLL,Kernel32.dll,它包含用于管理内存、进程和线程的各个函数;User32.dll,它包含用于执行用户界面任务(如窗口的创建和消息的传送)的各个函数;GDI32.dll,它包含用于画图和显示文本的各个函数。

静态库(Static Library):

函数和数据被编译进一个二进制文件(通常扩展名为.LIB)。在使用静态库的情况下,在编译链接可执行文件时,链接器从库中复制这些函数和数据并把它们和应用程序的其它模块组合起来创建最终的可执行文件(.EXE文件)。

ELF文件由4部分组成,分别是ELF头(ELF header)、程序头表(Program header table)、节(Section)和节头表(Section header table)。实际上,一个文件中不一定包含全部内容,而且他们的位置也未必如同所示这样安排,只有ELF头的位置是固定的,其余各部分的位置、大小等信息由ELF头中的各项值来决定。

编程使用exec*库函数加载一个可执行文件,动态链接分为可执行程序装载时动态链接和运行时动态链接

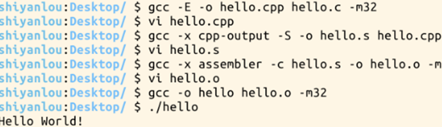

第一步:先编辑一个hello.c

#include <stdio.h>

#include <stdlib.h>

int main()

{

printf("Hello World!\n");

return 0;

}

第二步:生成预处理文件hello.cpp(预处理负责把include的文件包含进来及宏替换等工作)

第三步:编译成汇编代码hello.s

第四步:编译成目标代码,得到二进制文件hello.o

第五步:链接成可执行文件hello,(它是二进制文件)

第六步:运行一下./hello

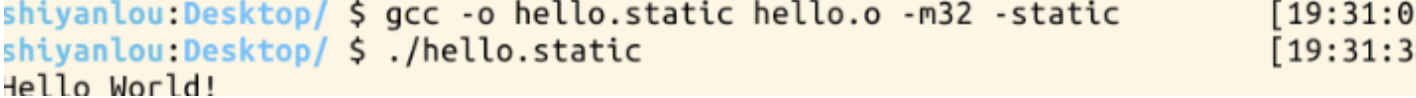

我们也可以静态编译,(是完全把所有需要执行所依赖的东西放到程序内部)

gcc -o hello.static hello.o -m32 -static

hello.static 也是ELF格式文件,运行一下hello.static ./hello.static

静态链接方式:在程序运行之前完成所有的组装工作,生成一个可执行的目标文件

动态链接方式:在程序已经为了执行被装载入内存之后完成链接工作,并且在内存中一般只保留该编译单元的一份拷贝

动态链接库的两种链接方法:

装载时动态链接

运行时动态链接

使用gdb跟踪分析一个execve系统调用内核处理函数do_execve

1、设置断点

2、中断情况如下

do_execve代码如下

int do_execve(struct filename *filename,

const char __user *const __user *__argv,

const char __user *const __user *__envp)

{

struct user_arg_ptr argv = { .ptr.native = __argv };

struct user_arg_ptr envp = { .ptr.native = __envp };

//调用do_execve_common

return do_execve_common(filename, argv, envp);

}

特别关注新的可执行程序是从哪里开始执行的?为什么execve系统调用返回后新的可执行程序能顺利执行?对于静态链接的可执行程序和动态链接的可执行程序execve系统调用返回时会有什么不同?

新的可执行程序通过修改内核堆栈eip作为新程序的起点,从new_ip开始执行后start_thread把返回到用户态的位置从int 0x80的下一条指令变成新加载的可执行文件的入口位置。

当执行到execve系统调用时,进入内核态,用execve()加载的可执行文件覆盖当前进程的可执行程序。当execve系统调用返回时,返回新的可执行程序的执行起点(main函数),所以execve系统调用返回后新的可执行程序能顺利执行。execve系统调用返回时,如果是静态链接,elf_entry指向可执行文件规定的头部(main函数对应的位置0x8048***);如果需要依赖动态链接库,elf_entry指向动态链接器的起点。动态链接主要是由动态链接器ld来完成的。

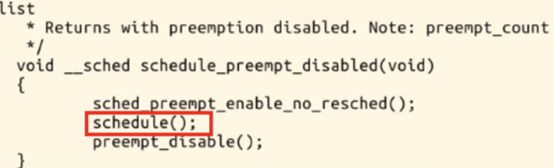

理解Linux系统中进程调度的时机,可以在内核代码中搜索schedule()函数,看都是哪里调用了schedule(),判断我们课程内容中的总结是否准确;

调用地方:

中断处理过程(包括时钟中断、I/O中断、系统调用和异常)中,直接调用schedule(),或者返回用户态时根据need_resched标记调用schedule()

内核线程可以直接调用schedule()进行进程切换,也可以在中断处理过程中进行调度,也就是说内核线程作为一类的特殊的进程可以主动调度,也可以被动调度;

用户态进程无法实现主动调度,仅能通过陷入内核态后的某个时机点进行调度,即在中断处理过程中进行调度。

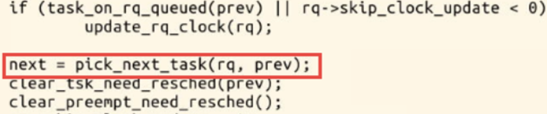

使用gdb跟踪分析一个schedule()函数 ,验证您对Linux系统进程调度与进程切换过程的理解;

首先设几个断点分别是schedule,pick_next_task,context_switch,__switch_to

schdule调用和函数

两个重要的函数context_switch和pick_next_task函数都在__schedule函数中

pick_next_task

context_switch

分析switch_to中的汇编代码,理解进程上下文的切换机制,以及与中断上下文切换的关系;

1.关键函数的调用关系

schedule() --> context_switch() --> switch_to --> __switch_to()

2.汇编代码分析:

asm volatile("pushfl\n\t" /* 保存当前进程的标志位 */

"pushl %%ebp\n\t" /* 保存当前进程的堆栈基址EBP */

"movl %%esp,%[prev_sp]\n\t" /* 保存当前栈顶ESP */

"movl %[next_sp],%%esp\n\t" /* 把下一个进程的栈顶放到esp寄存器中,完成了内核堆栈的切换,从此往下压栈都是在next进程的内核堆栈中。 */

"movl $1f,%[prev_ip]\n\t" /* 保存当前进程的EIP */

"pushl %[next_ip]\n\t" /* 把下一个进程的起点EIP压入堆栈 */

__switch_canary

"jmp __switch_to\n" /* 因为是函数所以是jmp,通过寄存器传递参数,寄存器是prev-a,next-d,当函数执行结束ret时因为没有压栈当前eip,所以需要使用之前压栈的eip,就是pop出next_ip。 */

"1:\t" /* 认为next进程开始执行。 */

"popl %%ebp\n\t" /* restore EBP */

"popfl\n" /* restore flags */

/* output parameters 因为处于中断上下文,在内核中

prev_sp是内核堆栈栈顶

prev_ip是当前进程的eip */

: [prev_sp] "=m" (prev->thread.sp),

[prev_ip] "=m" (prev->thread.ip), //[prev_ip]是标号

"=a" (last),

/* clobbered output registers: */

"=b" (ebx), "=c" (ecx), "=d" (edx),

"=S" (esi), "=D" (edi)

__switch_canary_oparam

/* input parameters:

next_sp下一个进程的内核堆栈的栈顶

next_ip下一个进程执行的起点,一般是$1f,对于新创建的子进程是ret_from_fork*/

: [next_sp] "m" (next->thread.sp),

[next_ip] "m" (next->thread.ip),

/* regparm parameters for __switch_to(): */

[prev] "a" (prev),

[next] "d" (next)

__switch_canary_iparam

: /* reloaded segment registers */

"memory");

} while (0)

switch_to实现了进程之间的真正切换:

首先在当前进程prev的内核栈中保存esi,edi及ebp寄存器的内容。

然后将prev的内核堆栈指针ebp存入prev->thread.esp中。

把将要运行进程next的内核栈指针next->thread.esp置入esp寄存器中

将popl指令所在的地址保存在prev->thread.eip中,这个地址就是prev下一次被调度

通过jmp指令(而不是call指令)转入一个函数__switch_to()

恢复next上次被调离时推进堆栈的内容。从现在开始,next进程就成为当前进程而真正开始执行

总结

Linux系统的一般执行过程

最一般的情况:正在运行的用户态进程X切换到运行用户态进程Y的过程

(1)正在运行的用户态进程X

(2)发生中断——save cs:eip/esp/eflags(current) to kernel stack,then load cs:eip(entry of a specific ISR) and ss:esp(point to kernel stack).

(3)SAVE_ALL //保存现场

(4)中断处理过程中或中断返回前调用了schedule(),其中的switch_to做了关键的进程上下文切换

(5)标号1之后开始运行用户态进程Y(这里Y曾经通过以上步骤被切换出去过因此可以从标号1继续执行)

(6)restore_all //恢复现场

(7)iret - pop cs:eip/ss:esp/eflags from kernel stack

(8)继续运行用户态进程Y

- 理解进程创建、可执行文件的加载和进程执行进程切换,重点理解分析fork、execve和进程切换

- Linux操作系统分析-lab2-进程的创建与可执行程序的加载

- Linux操作系统分析(2)- 进程的创建与可执行程序的加载

- 进程的创建与可执行文件的加载

- Linux操作系统分析(二)进程的创建与可执行程序的加载

- 关于fork进程创建和进程上下文切换时现场保存的个人理解

- 深入理解Linux之进程的创建和可执行程序的加载

- 关于fork&exec之进程的创建和可执行程序的加载过程

- 【Linux操作系统分析】进程的创建与可执行程序的加载

- 进程的创建与可执行文件的加载

- JavaScript的执行原理,很多人都理解错了:在js被加载后,其实就将js代码执行了一遍,在内存中创建了所有js文件中的变量。而不是激发了某个js方法后,再去相应的js文件中去执行,是去内存中执行

- 【Linux操作系统分析】进程的创建与可执行程序的加载

- Linux操作系统分析-(2)进程的创建与可执行程序的加载

- 进程信号Linux操作系统分析(2)- 进程的创建与可执行程序的加载

- Linux进程启动过程分析do_execve(可执行程序的加载和运行)---Linux进程的管理与调度(十一)

- Linux操作系统分析之进程的创建与可执行程序的加载

- Linux操作系统分析(2)- 进程的创建与可执行程序的加载

- Linux进程-fork创建新进程之文件分析

- Linux操作系统分析-lab2-进程的创建与可执行程序的加载

- Linux操作系统分析(2)- 进程的创建与可执行程序的加载