吴恩达深度学习与神经网络课程学习——logistic回归神经网络计算过程向量化

logistic回归神经网络计算过程向量化

有了对之前对logistic回归神经网络计算过程,现在讨论向量化的运算,向量化运算对于大数据的运算

有着很重要的作用,向量化计算提供了并行运算,大大加快了运算速度。想要了解之前的logistic回归

神经网络计算过程可以访问以下我的另外一篇博客https://blog.csdn.net/jmu_sxc/article/details/84638106

向量化实现的工具是python和nunpy,里面的库提供了很多的并行运算,特别是对于矩阵的运算。

所谓的向量化就是将可以并行处理的数据或者运算,通过将数据组织成矩阵,在矩阵进行相关运算。

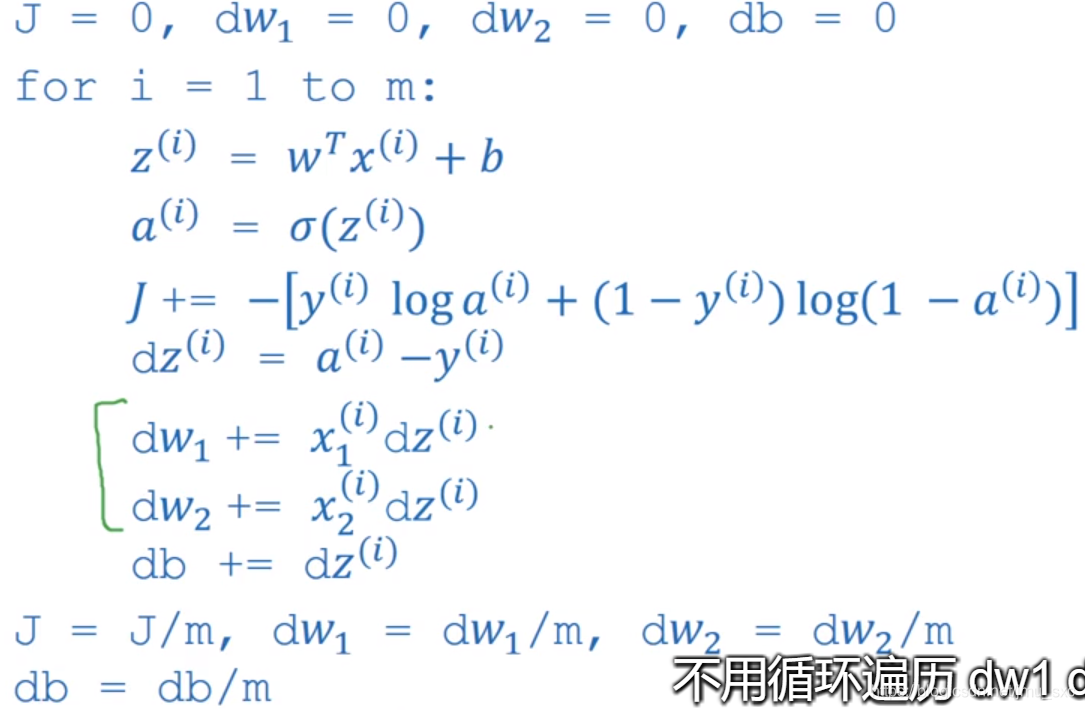

下图是logistic回归对于m个样本的计算过程:

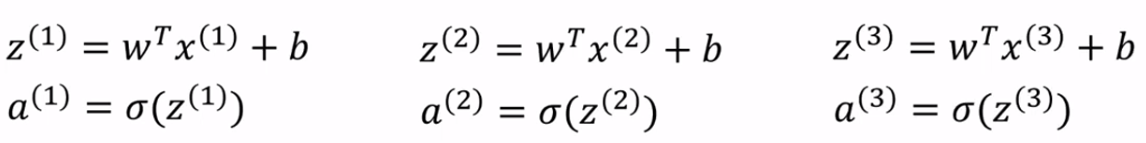

找到可并行处理的计算是z=wT*x+b;a=sigmod(z)

..........

..........

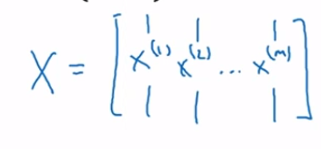

数据x表示每个样本的特征,比如图像的三通道的像素组成一个列向量:

我们用X表示m个样本的所有特征,行数是n_x:每个样本的特征个数

列数是m表示样本的数量。

对样本向量化

对权值w向量化:w可以扩充成一个用矩阵表示,维度根据情况修改

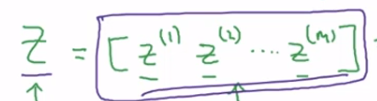

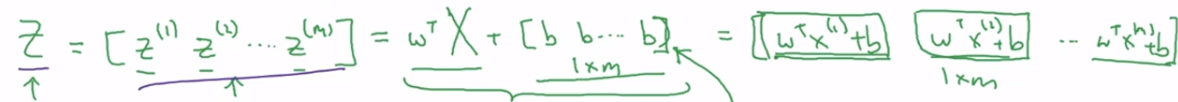

对z向量化:用Z表示z的矩阵

最后表示成Z=wT*X+b,python代码:Z=np.dot(w.T,X)+b;

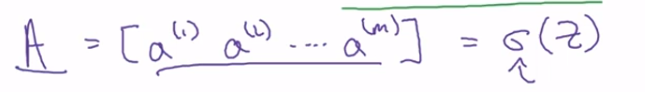

类似地用A表示a的矩阵:

对偏导数dz,dw向量化:用矩阵向量表示所有样本中的dz,每个元素表示一个样本的dz,对矩阵的所

有元素相加np.sum(dz)。db如下图;dw矩阵将矩阵X于dz矩阵的转置相乘。而dw表示一个dw1,dw2,

dw3...的集合,该向量的运算满足dw矩阵的意义。

这样向量化后的运算如下:

(1)Z=wT*X+b,

(2)A=sigmod(Z)

(3)dz=A-Y Y表示m个样本标签的向量化

(4)dw=(1/m)*X*dz.T

(5)db=(1/m)*sum(dz)

以上是运算过程向量化后的公式,这些公式代替了之前的for循环遍历运算,上面的公式一样完成了对于

m个样本的处理,即完成了前向传播和反向传播。如果在这些公式的外层加上一层迭代次数的循环,这样

一般就表示了神经网络的整体的计算过程。

- 吴恩达神经网络和深度学习课程自学笔记(六)之优化算法

- 吴恩达神经网络和深度学习课程自学笔记(七)之超参数调试,Batch正则化和程序框架

- 吴恩达(Andrew Ng)深度学习工程师笔记 - 第一门课-神经网络和深度学习-第一周深度学习概论-第六节:课程资源

- 吴恩达 深度学习第三周 浅层神经网络 logistic_regression python代码实现

- 吴恩达深度学习笔记(16)-神经网络的表示与输出计算

- 吴恩达Coursera深度学习课程 DeepLearning.ai 提炼笔记(1-2)-- 神经网络基础

- 吴恩达Coursera深度学习课程 DeepLearning.ai 提炼笔记(1-4)-- 深层神经网络(转载)

- 吴恩达神经网络和深度学习课程自学笔记(八)之机器学习策略

- 吴恩达Coursera深度学习课程 DeepLearning.ai 提炼笔记(1-2)-- 神经网络基础

- 吴恩达深度学习课程笔记之神经网络基础

- coursera 吴恩达 -- 第一课 神经网络和深度学习 :第二周课后习题 Logistic Regression with a Neural Network mindset

- 吴恩达神经网络和深度学习课程自学笔记(二)之神经网络基础

- 深度学习入门(二) 线性回归、逻辑回归、正则化过程、神经网络简介

- 《吴恩达深度学习工程师系列课程之——神经网络和深度学习》学习笔记

- 神经网络和深度学习-第二周神经网络基础-第三节:Logistic 回归损失函数

- 吴恩达Coursera深度学习课程 DeepLearning.ai 提炼笔记(1-4)-- 深层神经网络

- 神经网络和深度学习-第二周神经网络基础-第三节:Logistic 回归损失函数

- 吴恩达深度学习课程笔记 1.2什么是神经网络?

- 吴恩达-神经网络和深度学习课程-学习心得(一)

- 吴恩达Coursera深度学习课程 DeepLearning.ai 提炼笔记(5-1)-- 循环神经网络