论文笔记《Hierachical Attention Networks for Document Classification》

2018-10-13 16:39

369 查看

这两天读了论文1《Hierachical Attention Networks for Document Classification》

和论文2《Bidirectional Long Short-Term Memory Networks for Relation Classification》

为啥会读这两篇文章呢,是因为在10号整理最近所读的文章的时候查到了我的方向的中文论文,有一篇提及是由上述两篇文章所引申而来的。加上一直想实现一个稍复杂的LSTM的分类任务(已经实现了一个很小的例子,想进一步的了解相关知识),顿时就有了兴趣。

论文1:

本文贡献

- 本文提出了类似于,词-句子-文章结构的层次模型。

- 本文提出了用用在单词和句子上面的注意力机制,使得在构成句子和文章表示的时候,可以区分不同的重要度。

借鉴意义

- 这篇文章的实验部分对数据集的介绍比较详细,有详细的对比实验和说明

- Model configuration and training 部分,稍稍详细,对实验或由帮助。但遗憾的是,没有部分代码的共享(哈哈)。

- 本文的baseline也是比 4000 较多的,实验部分的对比,可以作为一个借鉴。

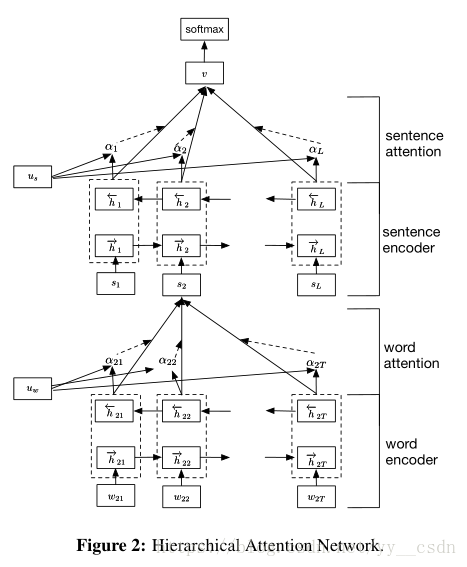

模型

上模型图:

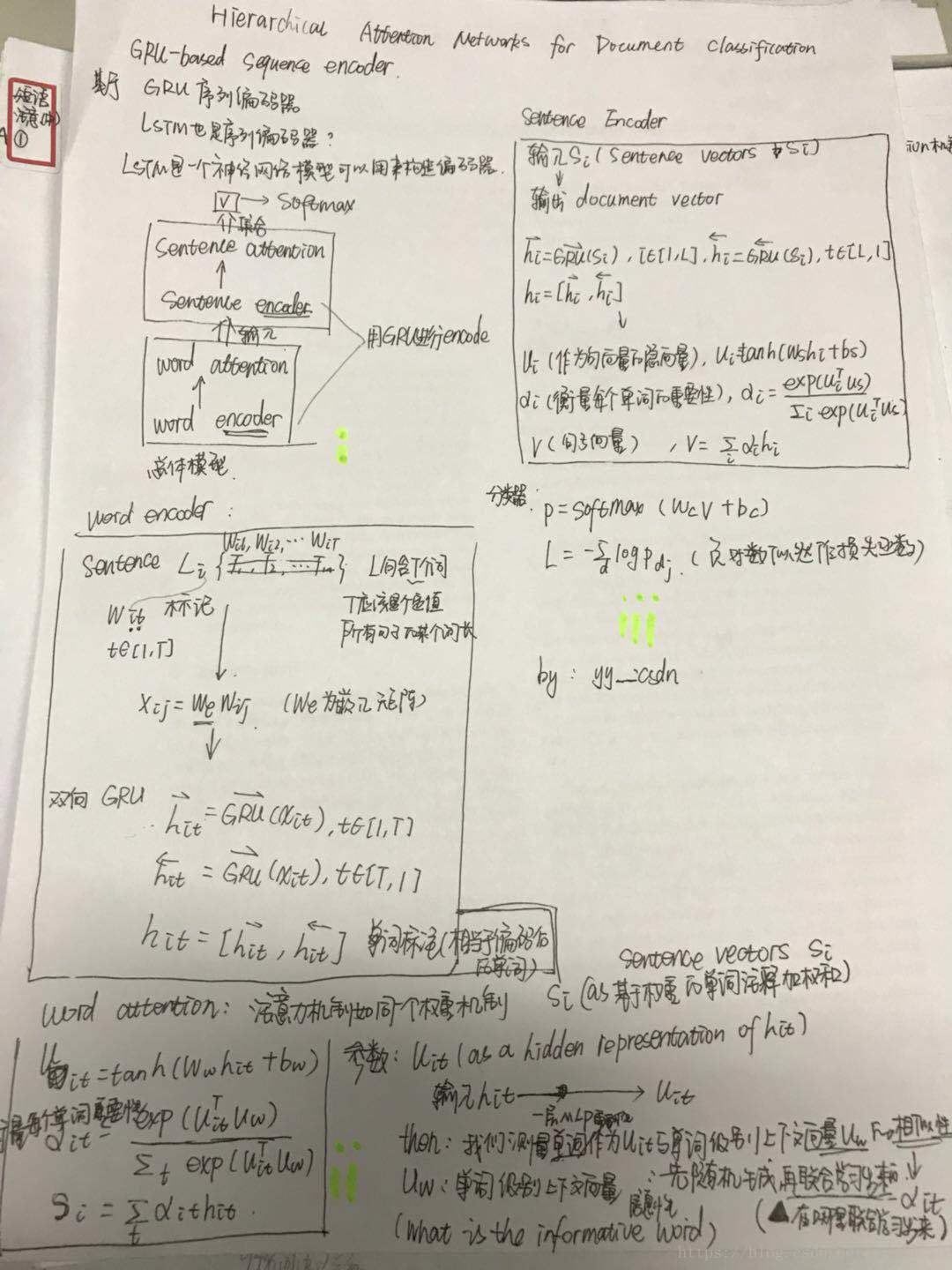

上我的理解图:

顺序为i,ii,iii

encode部分用的是基于GRU的序列编码器

关于lstm和gru的区别:

参考,找个时间完善这篇文章。

https://www.geek-share.com/detail/2715162244.html

相关文章推荐

- 1606.End--to-End Comparative Attention Networks for Person Re-identification 论文笔记

- 论文笔记之:Fully Convolutional Attention Localization Networks: Efficient Attention Localization for Fine-Grained Recognition

- 论文笔记:Residual Attention Network for Image Classification

- 【论文笔记】Convolutional Neural Networks for Sentence Classification

- Hierarchical Attention Network for Document Classification阅读笔记

- 论文笔记:Multi-Scale Dense Networks for Resource Efficient Image Classification

- [深度学习论文笔记][Video Classification] Beyond Short Snippets: Deep Networks for Video Classification

- deeplearning论文学习笔记(1)Convolutional Neural Networks for Sentence Classification

- Attention-over-Attention Neural Networks for Reading Comprehension论文笔记

- Implementation of Hierarchical Attention Networks for Document Classification的讲解与Tensorflow实现

- [置顶] 论文笔记--Appearance-and-Relation Networks for Video Classification

- 【DRCN阅读】Deep Reconstruction-Classification Networks for Unsupervised Domain Adaptation. 论文笔记

- Appearance-and-Relation Networks for Video Classification论文笔记 (ARTnet)

- 【论文阅读笔记】MULTI-SCALE DENSE NETWORKS FOR RESOURCE EFFICIENT IMAGE CLASSIFICATION

- 论文笔记|Spatial Pyramid Pooling in Deep Convolutional Networks for Visual Recognition

- [深度学习论文笔记][Semantic Segmentation] Recurrent Convolutional Neural Networks for Scene Labeling

- 论文笔记之:Semi-supervised Classification with Graph Convolutional Networks

- 论文笔记之:Spatially Supervised Recurrent Convolutional Neural Networks for Visual Object Tracking

- 论文阅读笔记-Segmentation-Aware Convolutional Networks Using Local Attention Masks

- 论文笔记《Learning Multi-Domain Convolutional Neural Networks for Visual Tracking》