Python3环境安装Scrapy爬虫框架过程及常见错误

2018-03-30 00:00

1001 查看

摘要: python 爬虫 scrapy 环境

Scrapy依赖的库比较多,至少需要依赖库有Twisted 14.0,lxml 3.4,pyOpenSSL 0.14。而在不同平台环境又各不相同,所以在安装之前最好确保把一些基本库安装好,尤其是Windows。

腾讯云有Windows、Linux多个版本系统,在这里分别介绍。

Anaconda是包含了常用的数据科学库的Python发行版本,如果没有安装,可以到https://www.continuum.io/downloads下载对应平台的包安装。

如果已经安装,那么可以轻松地通过

安装命令如下:

最好的安装方式是通过wheel文件来安装,http://www.lfd.uci.edu/~gohlke/pythonlibs/,从该网站找到lxml的相关文件。假如是Python3.5版本,WIndows 64位系统,那就找到lxml‑3.7.2‑cp35‑cp35m‑win_amd64.whl 这个文件并下载,然后通过pip安装。

下载之后,运行如下命令安装:

即可完成lxml的安装,其他文件替换文件名即可。

安装zope.interface

到官方网站https://pypi.python.org/pypi/zope.interface#downloads下载对应版本的wheel文件,然后pip安装。比如Python 3.5版本,Windows 64位系统,就下载zope.interface-4.3.3-cp35-cp35m-win_amd64.whl。

然后安装wheel文件即可,命令如下:

其他版本替换文件名即可。

安装pyOpenSSL

官方网站下载wheel文件,https://pypi.python.org/pypi/pyOpenSSL#downloads,如当前最新版本名称是pyOpenSSL-16.2.0-py2.py3-none-any.whl,下载后安装即可。

安装Twisted

同理,http://www.lfd.uci.edu/~gohlke/pythonlibs/#twisted下载wheel文件,利用pip安装即可。

如Python 3.5版本,Windows 64位系统,下载

Twisted‑17.1.0‑cp35‑cp35m‑win_amd64.whl,然后pip安装。

安装pywin32

从官方网站 https://sourceforge.net/projects/pywin32/files/pywin32/Build%20220/ 下载对应版本的安装包安装即可。

1.在http://sourceforge.net/projects/pywin32/files/pywin32/ 上下载对应的版本进行安装,对build221,220,219均进行了尝试(分别对应了python3.5.3,3.5.1+,3.5.0a版本,在进行安装时,不能正确寻找到python的安装目录,并将所搜索到的方法均进行尝试后仍然不能解决,遂放弃,可能是跟我使用的python版本有问题吧(未验证)。

2.在http://www.lfd.uci.edu/~gohlke/pythonlibs/#pyhook下载了.whl文件,使用pip 安装后发现其中有文件缺失,不能正常使用。

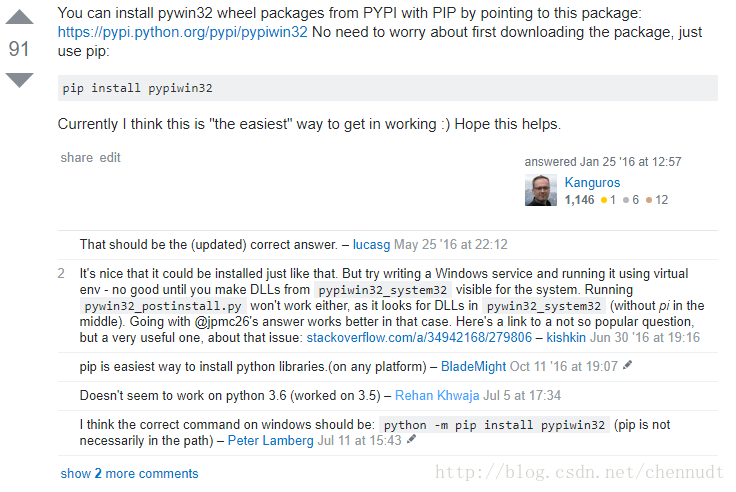

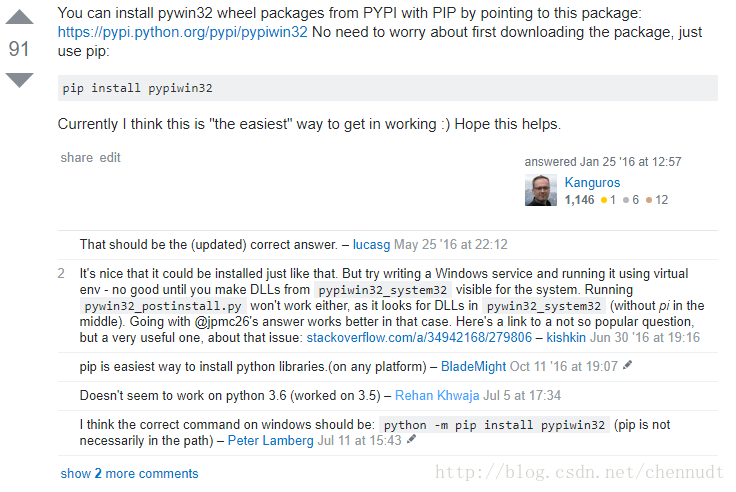

3.这是我成功的方法,经过搜索和向人请教后,在https://stackoverflow.com/questions/4863056/how-to-install-pywin32-module-in-windows-7找到这样一段话:

于是在cmd中使用python -m pip install pypiwin32进行安装,成功解决。

因为我寻找到这个解决办法耗费了一定时间,在中文资料中暂时没找到第三种解决方案的描述,因此分享出来,希望对大家有用。

安装Scrapy

最后安装Scrapy即可,依然使用pip,命令如下:

确保一些必须的类库已经安装,运行如下命令:

安装Scrapy

利用pip安装Scrapy即可,运行如下命令:

首先确保一些必须的类库已经安装,运行如下命令:

安装Scrapy

利用pip安装Scrapy即可,运行如下命令:

虽然腾讯云没有Mac系统,不过在这里还是加上MacOS的安装。

在Mac上构建Scrapy的依赖库需要C编译器以及开发头文件,它一般由Xcode提供,运行如下命令安装即可:

安装Scrapy

利用pip安装Scrapy即可,运行如下命令:

six包版本过低,six包是一个提供兼容Python2和Python3的库,升级six包即可。

c/_cffi_backend.c:15:17: fatal error: ffi.h: No such file or directory

缺少Libffi这个库。什么是libffi?“FFI” 的全名是 Foreign Function Interface,通常指的是允许以一种语言编写的代码调用另一种语言的代码。而Libffi库只提供了最底层的、与架构相关的、完整的”FFI”。

安装相应的库即可。

Ubuntu、Debian:

CentOS、RedHat:

ImportError: No module named 'cryptography'

这是缺少加密的相关组件,利用pip安装即可。

ImportError: No module named 'packaging'

缺少packaging这个包,它提供了Python包的核心功能,利用pip安装即可。

ImportError: No module named 'appdirs'

缺少appdirs这个包,它用来确定文件目录,利用pip单独安装即可。

Scrapy安装介绍

Scrapy的安装有多种方式,它支持Python2.7版本及以上或Python3.3版本及以上。下面说明Python3环境下的安装过程。Scrapy依赖的库比较多,至少需要依赖库有Twisted 14.0,lxml 3.4,pyOpenSSL 0.14。而在不同平台环境又各不相同,所以在安装之前最好确保把一些基本库安装好,尤其是Windows。

腾讯云有Windows、Linux多个版本系统,在这里分别介绍。

各平台安装简介

Anaconda

这种方法是一种比较简单的安装Scrapy的方法(尤其是对Windows来说),你可以使用该方法安装,也可以选用下文中专用平台的安装方法。Anaconda是包含了常用的数据科学库的Python发行版本,如果没有安装,可以到https://www.continuum.io/downloads下载对应平台的包安装。

如果已经安装,那么可以轻松地通过

conda命令安装Scrapy。

安装命令如下:

conda install Scrapy

Windows

安装lxml最好的安装方式是通过wheel文件来安装,http://www.lfd.uci.edu/~gohlke/pythonlibs/,从该网站找到lxml的相关文件。假如是Python3.5版本,WIndows 64位系统,那就找到lxml‑3.7.2‑cp35‑cp35m‑win_amd64.whl 这个文件并下载,然后通过pip安装。

下载之后,运行如下命令安装:

pip3 install wheel pip3 install lxml‑3.7.2‑cp35‑cp35m‑win_amd64.whl

即可完成lxml的安装,其他文件替换文件名即可。

安装zope.interface

到官方网站https://pypi.python.org/pypi/zope.interface#downloads下载对应版本的wheel文件,然后pip安装。比如Python 3.5版本,Windows 64位系统,就下载zope.interface-4.3.3-cp35-cp35m-win_amd64.whl。

然后安装wheel文件即可,命令如下:

pip3 install zope.interface-4.3.3-cp35-cp35m-win_amd64.whl

其他版本替换文件名即可。

安装pyOpenSSL

官方网站下载wheel文件,https://pypi.python.org/pypi/pyOpenSSL#downloads,如当前最新版本名称是pyOpenSSL-16.2.0-py2.py3-none-any.whl,下载后安装即可。

pip3 install pyOpenSSL-16.2.0-py2.py3-none-any.whl

安装Twisted

同理,http://www.lfd.uci.edu/~gohlke/pythonlibs/#twisted下载wheel文件,利用pip安装即可。

如Python 3.5版本,Windows 64位系统,下载

Twisted‑17.1.0‑cp35‑cp35m‑win_amd64.whl,然后pip安装。

pip3 install Twisted‑17.1.0‑cp35‑cp35m‑win_amd64.whl

安装pywin32

从官方网站 https://sourceforge.net/projects/pywin32/files/pywin32/Build%20220/ 下载对应版本的安装包安装即可。

1.在http://sourceforge.net/projects/pywin32/files/pywin32/ 上下载对应的版本进行安装,对build221,220,219均进行了尝试(分别对应了python3.5.3,3.5.1+,3.5.0a版本,在进行安装时,不能正确寻找到python的安装目录,并将所搜索到的方法均进行尝试后仍然不能解决,遂放弃,可能是跟我使用的python版本有问题吧(未验证)。

2.在http://www.lfd.uci.edu/~gohlke/pythonlibs/#pyhook下载了.whl文件,使用pip 安装后发现其中有文件缺失,不能正常使用。

3.这是我成功的方法,经过搜索和向人请教后,在https://stackoverflow.com/questions/4863056/how-to-install-pywin32-module-in-windows-7找到这样一段话:

于是在cmd中使用python -m pip install pypiwin32进行安装,成功解决。

因为我寻找到这个解决办法耗费了一定时间,在中文资料中暂时没找到第三种解决方案的描述,因此分享出来,希望对大家有用。

安装Scrapy

最后安装Scrapy即可,依然使用pip,命令如下:

pip3 install Scrapy

CentOS、RedHat、Fedora

依赖库安装确保一些必须的类库已经安装,运行如下命令:

sudo yum groupinstall development tools sudo yum install python34-devel epel-release libxslt-devel libxml2-devel openssl-devel

安装Scrapy

利用pip安装Scrapy即可,运行如下命令:

pip3 install Scrapy

Ubuntu、Debian、Deepin

依赖库安装首先确保一些必须的类库已经安装,运行如下命令:

sudo apt-get install build-essential python3-dev libssl-dev libffi-dev libxml2 libxml2-dev libxslt1-dev zlib1g-dev

安装Scrapy

利用pip安装Scrapy即可,运行如下命令:

pip3 install Scrapy

虽然腾讯云没有Mac系统,不过在这里还是加上MacOS的安装。

Mac OS

依赖库安装在Mac上构建Scrapy的依赖库需要C编译器以及开发头文件,它一般由Xcode提供,运行如下命令安装即可:

xcode-select --install

安装Scrapy

利用pip安装Scrapy即可,运行如下命令:

pip3 install Scrapy

验证

安装之后,在命令行下输入scrapy,如果出现类似下方的结果,就证明Scrapy安装成功。

常见错误

pkg_resources.VersionConflict: (six 1.5.2 (/usr/lib/python3/dist-packages), Requirement.parse('six>=1.6.0'))six包版本过低,six包是一个提供兼容Python2和Python3的库,升级six包即可。

sudo pip3 install -U six

c/_cffi_backend.c:15:17: fatal error: ffi.h: No such file or directory

缺少Libffi这个库。什么是libffi?“FFI” 的全名是 Foreign Function Interface,通常指的是允许以一种语言编写的代码调用另一种语言的代码。而Libffi库只提供了最底层的、与架构相关的、完整的”FFI”。

安装相应的库即可。

Ubuntu、Debian:

sudo apt-get install build-essential libssl-dev libffi-dev python3-dev

CentOS、RedHat:

sudo yum install gcc libffi-devel python-devel openssl-devel

ImportError: No module named 'cryptography'

这是缺少加密的相关组件,利用pip安装即可。

sudo pip3 install cryptography

ImportError: No module named 'packaging'

缺少packaging这个包,它提供了Python包的核心功能,利用pip安装即可。

sudo pip3 install packaging

ImportError: No module named 'appdirs'

缺少appdirs这个包,它用来确定文件目录,利用pip单独安装即可。

sudo pip3 install appdirs

相关文章推荐

- Python3环境安装Scrapy爬虫框架过程及常见错误

- Python3环境安装Scrapy爬虫框架过程及常见错误

- Python3环境安装Scrapy爬虫框架过程及常见错误

- Python3环境安装Scrapy爬虫框架

- Python3环境安装PySpider爬虫框架过程

- Window环境下安装基于Python的Scrapy网络爬虫框架

- Python爬虫之Scrapy框架Windows环境安装

- Windows环境下安装Python的爬虫框架Scrapy

- 腾讯云主机Python3环境安装PySpider爬虫框架过程

- [读书笔记]python爬虫-scrapy安装过程常见问题及解决方法

- 【Python】Python34环境下安装爬虫框架scrapy实战篇!

- Python爬虫进阶三之Scrapy框架安装配置

- Python爬虫教程——进阶一之爬虫框架Scrapy安装配置

- Python爬虫框架Scrapy 学习笔记 1 ----- 环境搭建

- Python爬虫进阶一之爬虫框架Scrapy安装配置

- 静觅 » Python爬虫进阶三之Scrapy框架安装配置

- [Python]Python爬虫之Scrapy框架安装配置

- Python爬虫进阶三之Scrapy框架安装配置

- Python爬虫进阶三之Scrapy框架安装配置

- Python爬虫进阶一之爬虫框架Scrapy安装配置