机器学习性能度量指标:AUC

2018-01-27 15:38

1066 查看

在IJCAI 于2015年举办的竞赛:Repeat Buyers Prediction Competition 中,

很多参赛队伍在最终的Slides展示中都表示使用了 AUC 作为评估指标:

那么,AUC是什么呢?

AUC是一个机器学习性能度量指标,只能用于二分类模型的评价。(拓展二分类模型的其他评价指标:logloss、accuracy、precision)

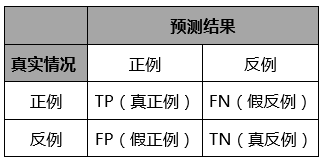

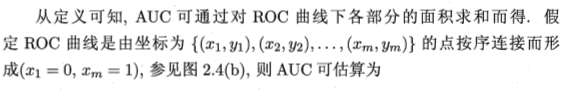

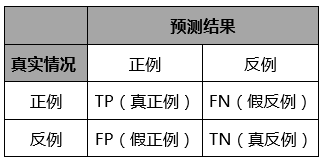

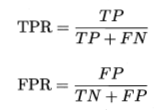

对于二分类问题,可将样例根据其真实类别与学习器预测类别的组合划分为真正例(true positive)、假正例(false positive)、真反例(true negative)、假反例(false negative)四种情形,令 TP、FP、TN、FN分别表示其对应的样例数,则显然有 TP+FP+TN+FN=样例总数。

分类结果的“混淆矩阵”(confusion matrix)如下表所示:

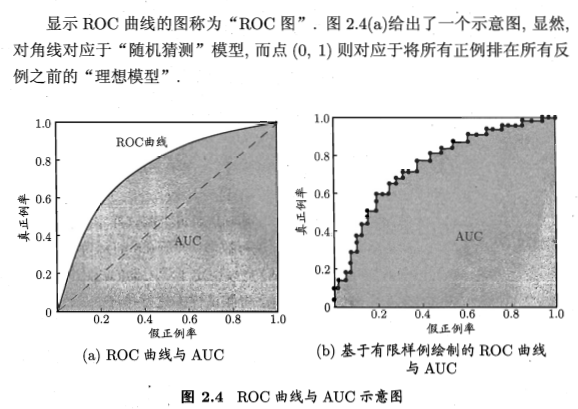

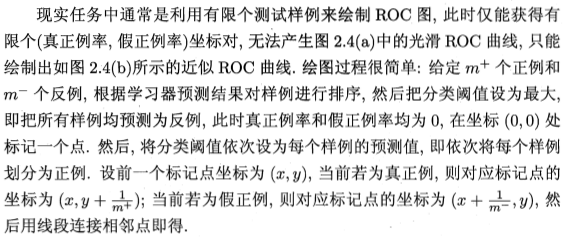

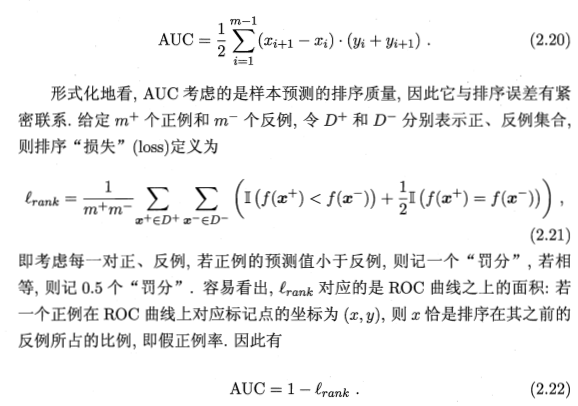

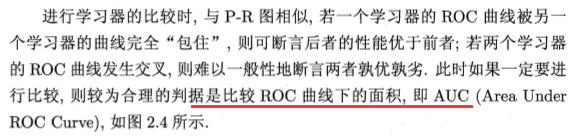

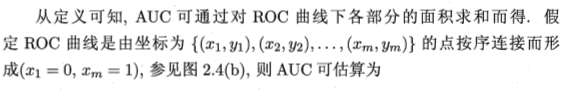

AUC全称:Area under ROC curve

AUC的物理意义为任取一对例和负例,正例得分大于负例得分的概率,AUC越大,表明方法效果越好。

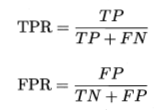

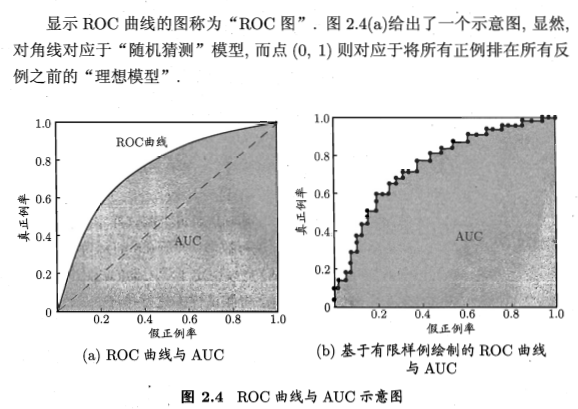

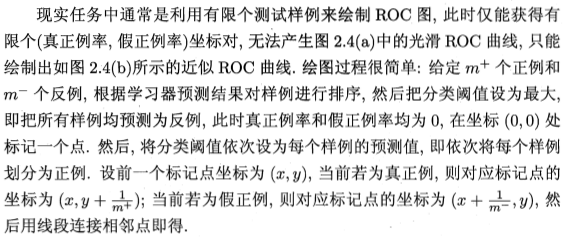

ROC全称为“受试者工作特征”(Receiver Operating Characteristic )曲线,源于二战中用于敌机检测的雷达信号分析技术。根据学习器的预测结果对样例进行排序,按此顺序逐个把样本作为正例进行预测,每次计算出两个重要量的值,分别以它们为横、纵坐标作图,就得到了“ROC”曲线,纵轴是“真正例率”(True Positive Rate,TPR),横轴是“假正例率”(False Positive Rate,FPR):

IJCAI-15比赛相关:

IJCAI-15 Dataset 数据集来自天猫(阿里云天池)。

论文名称:Identifying Repeat Buyers by Ensemble Learning with Historical Behavioral Features

作者:Shaohua jiang, Yunlei Mu, Qingyu Fan

会议期刊:IJCAI workshop

论文链接:http://socinf2015.isistan.unicen.edu.ar/winners

【Reference】

1. 周志华.机器学习[M].北京:清华大学出版社,2016.

很多参赛队伍在最终的Slides展示中都表示使用了 AUC 作为评估指标:

那么,AUC是什么呢?

AUC是一个机器学习性能度量指标,只能用于二分类模型的评价。(拓展二分类模型的其他评价指标:logloss、accuracy、precision)

对于二分类问题,可将样例根据其真实类别与学习器预测类别的组合划分为真正例(true positive)、假正例(false positive)、真反例(true negative)、假反例(false negative)四种情形,令 TP、FP、TN、FN分别表示其对应的样例数,则显然有 TP+FP+TN+FN=样例总数。

分类结果的“混淆矩阵”(confusion matrix)如下表所示:

AUC全称:Area under ROC curve

AUC的物理意义为任取一对例和负例,正例得分大于负例得分的概率,AUC越大,表明方法效果越好。

ROC全称为“受试者工作特征”(Receiver Operating Characteristic )曲线,源于二战中用于敌机检测的雷达信号分析技术。根据学习器的预测结果对样例进行排序,按此顺序逐个把样本作为正例进行预测,每次计算出两个重要量的值,分别以它们为横、纵坐标作图,就得到了“ROC”曲线,纵轴是“真正例率”(True Positive Rate,TPR),横轴是“假正例率”(False Positive Rate,FPR):

IJCAI-15比赛相关:

IJCAI-15 Dataset 数据集来自天猫(阿里云天池)。

论文名称:Identifying Repeat Buyers by Ensemble Learning with Historical Behavioral Features

作者:Shaohua jiang, Yunlei Mu, Qingyu Fan

会议期刊:IJCAI workshop

论文链接:http://socinf2015.isistan.unicen.edu.ar/winners

【Reference】

1. 周志华.机器学习[M].北京:清华大学出版社,2016.

相关文章推荐

- 机器学习之分类性能度量指标 : ROC曲线、AUC值、正确率、召回率

- 【机器学习】分类性能度量指标 : ROC曲线、AUC值、正确率、召回率、敏感度、特异度

- 机器学习性能指标精确率、召回率、F1值、ROC、PRC与AUC

- 机器学习知识点(三十六)分类器性能度量指标f1-score

- 机器学习性能评估指标(精确率、召回率、ROC、AUC)

- 机器学习性能评估指标(精确率、召回率、ROC、AUC)

- 【机器学习-西瓜书】二、性能度量:召回率;P-R曲线;F1值;ROC;AUC

- 机器学习之分类性能度量指标 : ROC曲线、AUC值、正确率、召回率

- 机器学习之分类模型的性能度量

- 机器学习常见评价指标:AUC、Precision、Recall、F-measure、Accuracy

- RMSE、MAPE、准确率、召回率、F1、ROC、AUC数据挖掘中的性能指标总结

- 度量Web性能的关键指标

- 机器学习: 性能度量

- 机器学习实战笔记(Python实现)-07-模型评估与分类性能度量

- 机器学习性能评估指标

- 机器学习中分类器的性能评价指标

- 机器学习笔记十五:分类问题的性能度量(混淆矩阵,正确率,召回率,ROC,AUC)

- scikit-learn中评估分类器性能的度量,像混淆矩阵、ROC、AUC等

- 机器学习:分类算法性能指标之ROC曲线

- 机器学习性能评估指标