计算机视觉标准数据集整理—COCO数据集

2018-01-24 11:44

295 查看

COCO数据集

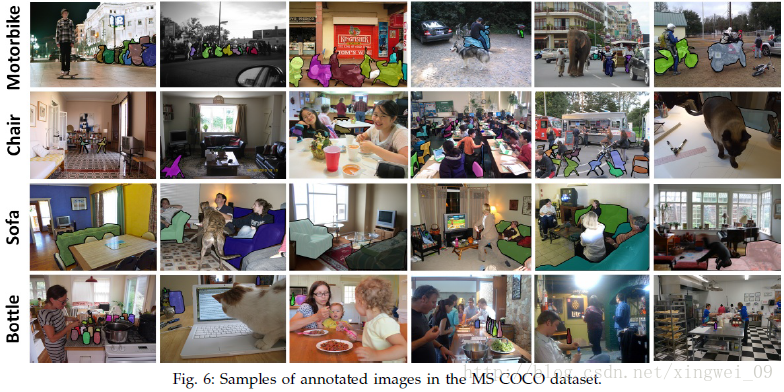

COCO数据集由微软赞助,其对于图像的标注信息不仅有类别、位置信息,还有对图像的语义文本描述,COCO数据集的开源使得近两三年来图像分割语义理解取得了巨大的进展,也几乎成为了图像语义理解算法性能评价的“标准”数据集。Google的开源show and tell生成模型就是在此数据集上测试的。这个数据集以scene understanding为目标,主要从复杂的日常场景中截取,图像中的目标通过精确的segmentation进行位置的标定。图像包括91类目标,328,000影像和2,500,000个label。

该数据集主要解决3个问题:目标检测,目标之间的上下文关系,目标的2维上的精确定位。数据集的对比示意图:

COCO数据集有91类,虽然比ImageNet和SUN类别少,但是每一类的图像多,这有利于获得更多的每类中位于某种特定场景的能力,对比PASCAL VOC,其有更多类和图像。

COCO数据集分两部分发布,前部分于2014年发布,后部分于2015年,2014年版本:82,783 training, 40,504 validation, and 40,775 testing images,有270k的segmented people和886k的segmented object;2015年版本:165,482 train, 81,208 val, and81,434 test images。

职责

目标检测

输出目标物的边框即可(using bounding box output),也就是我们常说的目标检测(object detection)了;要求把目标物从图像中分割出来(object segmentation output),即我们所说的图像语义分割(Semantic image segmentation);

图像标注(COCOCaptioning Challenge)

具体说来就是一句话准确描述图片上的信息(producingimage captions that are informative and accurate)。那这个怎么评分呢?目前是靠人工评分。

人体关键点检测(COCOKeypoint Challenge)

比赛要求是找到人在哪,然后定位到人体的一些关键点位置(Thekeypoint challenge involves simultaneously detecting people and localizingtheir keypoints)。

相关文章推荐

- 计算机视觉标准数据集整理—PASCAL VOC数据集

- 计算机视觉标准数据集整理—CIFAR-100数据集

- 计算机视觉标准数据集整理

- 计算机视觉标准数据集整理—人脸识别/检测数据集

- 计算机视觉标准数据集整理

- 计算机视觉标准数据集整理—ImageNet数据集

- 计算机视觉标准数据集整理—Caltech数据集

- 以下是computer vision:algorithm and application计算机视觉算法与应用这本书中附录里关于计算机视觉的一些测试数据集和源码站点,我整理了下,加了点中文注解

- 以下是computer vision:algorithm and application计算机视觉算法与应用这本书中附录里关于计算机视觉的一些测试数据集和源码站点,我整理了下,加了点中文注解

- 以下是computer vision:algorithm and application计算机视觉算法与应用这本书中附录里关于计算机视觉的一些测试数据集和源码站点,我整理了下,加了点中文注解

- Image & Vision Group 链接 有计算机视觉的测试公开的标准数据集

- 以下是computer vision:algorithm and application计算机视觉算法与应用这本书中附录里关于计算机视觉的一些测试数据集和源码站点,我整理了下,加了点中文注解

- 自己整理的计算机视觉领域稍微容易中的期刊(第一版)

- 计算机视觉的一些测试数据集和源码站点

- 计算机视觉投稿期刊整理

- 计算机视觉的一些测试数据集和源码站点

- 开发各种信息管理系统的标准演示数据都帮你整理好了,少了录入演示\测试\模拟数据的烦恼了[提供下载]

- 数据挖掘数据集下载搜集整理版

- 计算机视觉与图像处理学习笔记(三)opencv的基本数据类型与简单图像处理函数