Python爬虫抓取贴吧所有标题

2017-12-23 10:14

423 查看

这段代码用于获取指定贴吧下指定页数的所有标题。

原代码不知道是使用哪位仁兄的,已经不记得了,稍微修改了下,请求超时时长为7s,并且把抓取到的文本保存到txt文档中。

工作环境:python 2.7

操作系统:mac os

完整代码如下:

#!/usr/bin/env python

#coding:utf-8

import urllib2

import re

import sys

reload(sys)

sys.setdefaultencoding('utf8')

global titles

#加载页面内容

def load_page(url):

'''

发送url请求

返回url请求的静态html页面

:param url:

:return:

'''

try:

user_agent = "Mozilla/5.0 (Macintosh; U; Intel Mac OS X 10_6_8; en-us) AppleWebKit/534.50 (KHTML, like Gecko) Version/5.1 Safari/534.50"

headers = {"User-Agent" : user_agent}

request = urllib2.Request(url,headers = headers)

response = urllib2.urlopen(request,timeout=7)

html = response.read()

#print html

#print "--------------------------"

getTitle(html)

except Exception,e:

print str(e)

#生成url地址,加载页面内容

def tieba_spider(url,startPage,endPage):

for i in range(startPage,endPage + 1):

page = (i - 1) * 50

my_url = url + str(page)

load_page(my_url)

print "--------第%d页----------" % i

#获得贴吧的标题

def getTitle(html):

global titles

info = re.findall(r'class="j_th_tit ">(.*?)</a>',html,re.S)

for titleList in info:

print titleList

print "---------------"

titles.write(" ".join(info))

if __name__ == '__main__':

url = "http://tieba.baidu.com/f?kw=%E8%BD%AC%E5%9F%BA%E5%9B%A0&ie=utf-8&pn="

startPage = 1

endPage = 731

global titles

titles = open('tiebaTitles.txt','w')

tieba_spider(url, startPage, endPage)

titles.close()

print "---------------------结束------------------"

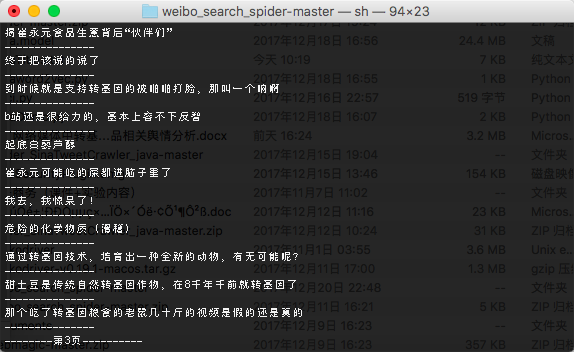

程序截图:

原代码不知道是使用哪位仁兄的,已经不记得了,稍微修改了下,请求超时时长为7s,并且把抓取到的文本保存到txt文档中。

工作环境:python 2.7

操作系统:mac os

完整代码如下:

#!/usr/bin/env python

#coding:utf-8

import urllib2

import re

import sys

reload(sys)

sys.setdefaultencoding('utf8')

global titles

#加载页面内容

def load_page(url):

'''

发送url请求

返回url请求的静态html页面

:param url:

:return:

'''

try:

user_agent = "Mozilla/5.0 (Macintosh; U; Intel Mac OS X 10_6_8; en-us) AppleWebKit/534.50 (KHTML, like Gecko) Version/5.1 Safari/534.50"

headers = {"User-Agent" : user_agent}

request = urllib2.Request(url,headers = headers)

response = urllib2.urlopen(request,timeout=7)

html = response.read()

#print html

#print "--------------------------"

getTitle(html)

except Exception,e:

print str(e)

#生成url地址,加载页面内容

def tieba_spider(url,startPage,endPage):

for i in range(startPage,endPage + 1):

page = (i - 1) * 50

my_url = url + str(page)

load_page(my_url)

print "--------第%d页----------" % i

#获得贴吧的标题

def getTitle(html):

global titles

info = re.findall(r'class="j_th_tit ">(.*?)</a>',html,re.S)

for titleList in info:

print titleList

print "---------------"

titles.write(" ".join(info))

if __name__ == '__main__':

url = "http://tieba.baidu.com/f?kw=%E8%BD%AC%E5%9F%BA%E5%9B%A0&ie=utf-8&pn="

startPage = 1

endPage = 731

global titles

titles = open('tiebaTitles.txt','w')

tieba_spider(url, startPage, endPage)

titles.close()

print "---------------------结束------------------"

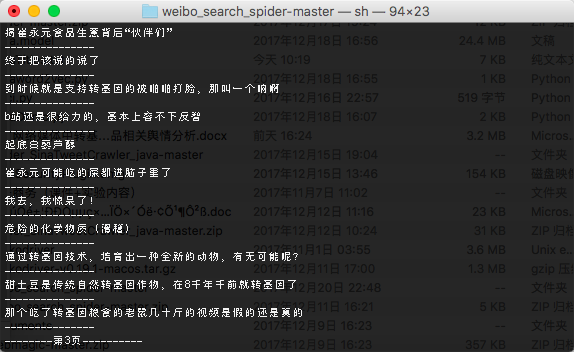

程序截图:

相关文章推荐

- Python2.7 自动抓取某贴吧所有帖子的图片

- Python 抓取贴吧里某楼主所有的帖子

- 小爬虫,抓取某贴吧内所有帖子的图片

- python抓取51CTO博客的推荐博客的所有博文,对标题分词存入mongodb中

- 基于python实现的抓取腾讯视频所有电影的爬虫

- Python爬虫框架Scrapy 学习笔记 10.3 -------【实战】 抓取天猫某网店所有宝贝详情

- python爬虫 抓取一个网站的所有网址链接

- Python爬虫入门,抓取应届生求职网北京地区所有职位

- python爬虫爬去贴吧中的所有图片

- python抓取CSDN博客首页的所有博文,对标题分词存入mongodb中

- python抓取月光博客的所有文章并且按照标题分词存入mongodb中

- Python爬虫框架Scrapy 学习笔记 10.2 -------【实战】 抓取天猫某网店所有宝贝详情

- python抓取伯乐在线的所有文章,对标题分词后存入mongodb中

- Python爬虫框架Scrapy 学习笔记 10.2 -------【实战】 抓取天猫某网店所有宝贝详情

- python爬虫抓取豆瓣所有恐怖片信息(利用多线程和构建免费ip代理池)

- 【Python爬虫基础】抓取知乎页面所有图片

- python3爬虫-爬取新浪新闻首页所有新闻标题

- Python 爬虫获取某贴吧所有成员用户名

- 用python实现的抓取腾讯视频所有电影的爬虫

- [Python] 根据博客园用户名抓取其所有文章的标题及其链接