spark2.2.0集群环境搭建

2017-11-10 01:09

363 查看

1.环境

阿里云弹性云主机两台,一台master,一台slave,操作系统CentOs7.2.1511

spark版本2.2.0,

hadoop版本2.7

scala版本2.11

java版本1.8

2.java安装和环境变量

官网下载linux64位jdk,地址:jdk官网

创建目录,mkdir /usr/java

在该目录下解压jdk,tar -zvxf jdk-8u152-linux-x64.tar.gz

配置环境变量,vim /etc/profile

在最后追加

JAVA_HOME=/usr/java/jdk1.8.0_152

JRE_HOME=/usr/java/jdk1.8.0_152/jre

CLASS_PATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar:$JRE_HOME/lib

PATH=$PATH:$JAVA_HOME/bin:$JRE_HOME/bin

export JAVA_HOME JRE_HOME CLASS_PATH PATH

保存后,运行source /etc/profile使配置立即生效

运行java -version检验环境变量是否生效

3.scala安装和环境变量配置

scala安装配置和java类似,在官网下载scala压缩包,官网地址:scala官网

下载版本为2.11.x,因为spark2.2使用scala2.11版本

创建目录,mkdir /usr/scala

在该目录下解压scala,tar -zvxf scala-2.11.11.tgz

配置环境变量,vim /etc/profile

追加

SCALA_HOME=/usr/scala/scala-2.11.11

修改

PATH=$PATH:$JAVA_HOME/bin:$JRE_HOME/bin:$SCALA_HOME/bin:

export JAVA_HOME JRE_HOME SCALA_HOME CLASS_PATH PATH

保存后,运行source /etc/profile使配置立即生效

运行scala -version检验环境变量是否生效

4.网络和域名配置

修改主机名称,vim /etc/sysconfig/network ,追加HOSTNAME=master或运行命令hostname master(临时生效);(若为ubuntu系统,则vim /etc/hostname,直接修改名字)

配置主机和ip的映射,vim /etc/hosts 增加172.18.110.172(内网ip) master和172.18.110.173(内网ip) slave1

5.ssh免密登录

参考点击打开链接。(坑点记录:刚开始网上找到ssh秘钥生成方法为dsa算法,生成后登录依然需要输入密码,网上各种方法,如修改文件权限等尝试后依然无效,后来重新搜索发现使用rsa算法生成的秘钥就正常了)

6.spark安装和环境变量配置

在官网下载spark-2.2.0-bin-hadoop2.7.tgz,解压到/opt目录下,为方便操作,ln -s spark-2.2.0-bin-hadoop2.7 spark 创建软连接

接下来,同上操作,配置spark环境变量

vim /etc/profile

追加SPARK_HOME=/opt/spark

修改PATH=$PATH:$JAVA_HOME/bin:$JRE_HOME/bin:$SCALA_HOME/bin:$SPARK_HOME/bin:$SPARK_HOME/sbin:

export JAVA_HOME JRE_HOME SCALA_HOME SPARK_HOME CLASS_PATH PATH

保存后,运行source /etc/profile使配置立即生效

注意:此处同时添加bin和sbin是为了方便操作,因为bin下主要存放spark程序执行命令,sbin下主要存放spark启动等命令

完成后,即可运行spark进行验证,输入命令

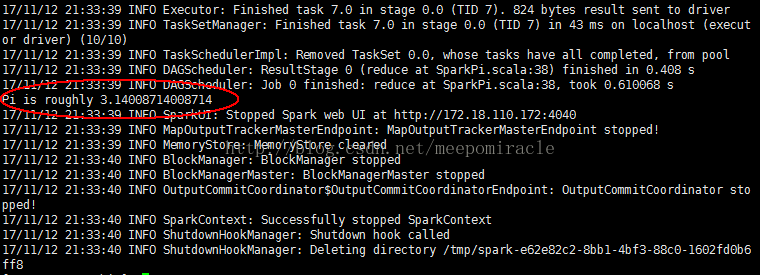

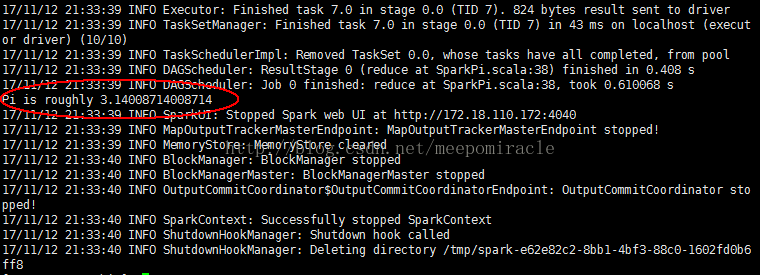

run-example SparkPi 10执行效果如图:

成功使用spark example计算pi,至此,spark单机环境安装完成。

tips:master和slave节点按照同样的方法和步骤,安装和配置一模一样,master和slave节点可以在本地独立运行spark-shell local模式。

阿里云弹性云主机两台,一台master,一台slave,操作系统CentOs7.2.1511

spark版本2.2.0,

hadoop版本2.7

scala版本2.11

java版本1.8

2.java安装和环境变量

官网下载linux64位jdk,地址:jdk官网

创建目录,mkdir /usr/java

在该目录下解压jdk,tar -zvxf jdk-8u152-linux-x64.tar.gz

配置环境变量,vim /etc/profile

在最后追加

JAVA_HOME=/usr/java/jdk1.8.0_152

JRE_HOME=/usr/java/jdk1.8.0_152/jre

CLASS_PATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar:$JRE_HOME/lib

PATH=$PATH:$JAVA_HOME/bin:$JRE_HOME/bin

export JAVA_HOME JRE_HOME CLASS_PATH PATH

保存后,运行source /etc/profile使配置立即生效

运行java -version检验环境变量是否生效

3.scala安装和环境变量配置

scala安装配置和java类似,在官网下载scala压缩包,官网地址:scala官网

下载版本为2.11.x,因为spark2.2使用scala2.11版本

创建目录,mkdir /usr/scala

在该目录下解压scala,tar -zvxf scala-2.11.11.tgz

配置环境变量,vim /etc/profile

追加

SCALA_HOME=/usr/scala/scala-2.11.11

修改

PATH=$PATH:$JAVA_HOME/bin:$JRE_HOME/bin:$SCALA_HOME/bin:

export JAVA_HOME JRE_HOME SCALA_HOME CLASS_PATH PATH

保存后,运行source /etc/profile使配置立即生效

运行scala -version检验环境变量是否生效

4.网络和域名配置

修改主机名称,vim /etc/sysconfig/network ,追加HOSTNAME=master或运行命令hostname master(临时生效);(若为ubuntu系统,则vim /etc/hostname,直接修改名字)

配置主机和ip的映射,vim /etc/hosts 增加172.18.110.172(内网ip) master和172.18.110.173(内网ip) slave1

5.ssh免密登录

参考点击打开链接。(坑点记录:刚开始网上找到ssh秘钥生成方法为dsa算法,生成后登录依然需要输入密码,网上各种方法,如修改文件权限等尝试后依然无效,后来重新搜索发现使用rsa算法生成的秘钥就正常了)

6.spark安装和环境变量配置

在官网下载spark-2.2.0-bin-hadoop2.7.tgz,解压到/opt目录下,为方便操作,ln -s spark-2.2.0-bin-hadoop2.7 spark 创建软连接

接下来,同上操作,配置spark环境变量

vim /etc/profile

追加SPARK_HOME=/opt/spark

修改PATH=$PATH:$JAVA_HOME/bin:$JRE_HOME/bin:$SCALA_HOME/bin:$SPARK_HOME/bin:$SPARK_HOME/sbin:

export JAVA_HOME JRE_HOME SCALA_HOME SPARK_HOME CLASS_PATH PATH

保存后,运行source /etc/profile使配置立即生效

注意:此处同时添加bin和sbin是为了方便操作,因为bin下主要存放spark程序执行命令,sbin下主要存放spark启动等命令

完成后,即可运行spark进行验证,输入命令

run-example SparkPi 10执行效果如图:

成功使用spark example计算pi,至此,spark单机环境安装完成。

tips:master和slave节点按照同样的方法和步骤,安装和配置一模一样,master和slave节点可以在本地独立运行spark-shell local模式。

相关文章推荐

- spark2.2.0搭建standalone集群环境

- spark学习1--centOS7.2下基于hadoop2.7.3的spark2.0集群环境搭建

- 大数据1-hadoop、zookeeper、hbase、spark集群环境搭建

- Linux下搭建spark集群开发环境

- Kafka:ZK+Kafka+Spark Streaming集群环境搭建(二十六)Structured Streaming:WARN clients.NetworkClient: Error while fetching metadata with correlation id 1 : {my-topic=LEADER_NOT_AVAILABLE}

- 如何在虚拟机上搭建并配置一个分布式的 Spark2.2.0 集群

- spark 1.5、hadoop 2.7 集群环境搭建

- Linux下搭建spark集群开发环境

- Spark集群环境的搭建

- Spark 1.6.1分布式集群环境搭建

- Spark集群环境搭建

- spark环境搭建,伪分布式、集群

- Hadoop2.2.0 HA高可用分布式集群搭建(hbase,hive,sqoop,spark)

- spark1.3.0-hadoop2.4集群环境搭建(Standalone)

- spark-1.2.0 集群环境搭建

- DayDayUP_大数据学习课程[2]_spark1.4.1集群环境的搭建

- spark学习7之IDEA下搭建Spark本地编译环境并上传到集群运行

- Spark1.2.1集群环境搭建——Standalone模式

- Spark集群环境的搭建