Scrapy+crontab 定时爬取小说更新推送到手机邮件

2017-07-28 21:25

726 查看

Scrapy+crontab 定时爬取小说更新推送到手机邮件

本人酷爱追火星引力的《逆天邪神》小说,但经常是俩三天才一更,每天打开浏览器查看是否更新贼痛苦。现在利用所学的知识来解决问题。文章分三部分:一、爬取更新 二、发送邮件 三、定时任务。爬虫内容简单,适合scrapy新手,重点在于发送邮件和定时任务。一、爬取更新

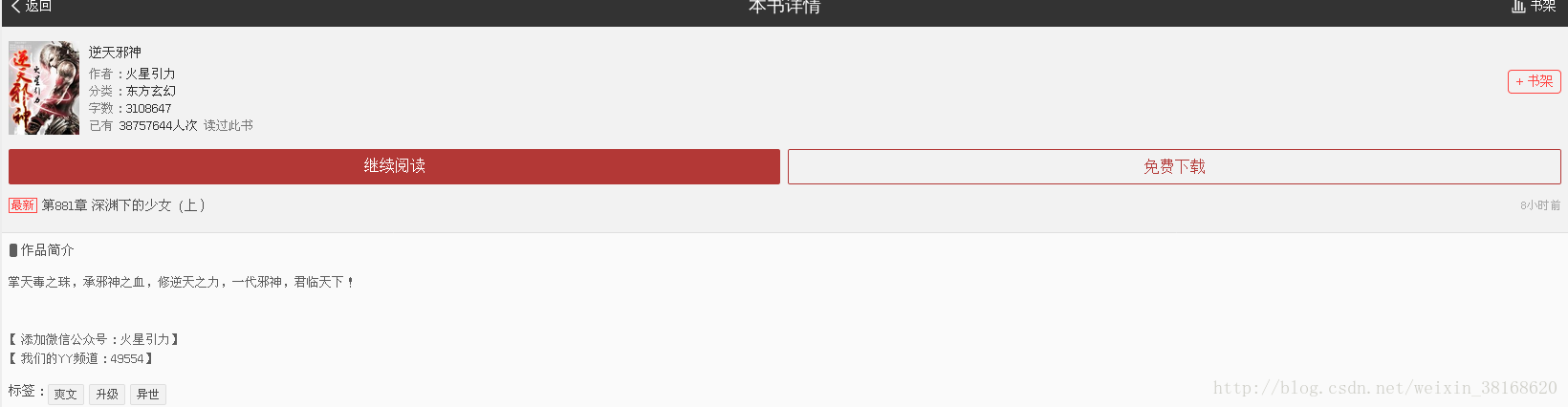

小说地址:http://m.zongheng.com/h5/book?bookid=408586页面图片:

1.创建工程project

选择一个目录:/home/yunge/code/spiders/

执行命令:

scrapy startproject xiaoshuo

2.创建spider

进入工程内,执行命令:

cd /xiaoshuo/xiaoshuo

创建spider,执行命令:

scrapy genspider nitianspider zongheng.com

3.items.py 填空

import scrapy class XiaoshuoItem(scrapy.Item): # define the fields for your item here like: # name = scrapy.Field() chapter=scrapy.Field() updatetime=scrapy.Field()

4.nitiansipder.py

# -*- coding: utf-8 -*-

import scrapy

from xiaoshuo.items import XiaoshuoItem

from scrapy.mail import MailSender

class NitianspiderSpider(scrapy.Spider):

name = 'nitianspider'

allowed_domains = ['zongheng.com']

start_urls = ['http://m.zongheng.com/h5/book?bookid=408586']

def parse(self, response):

item=XiaoshuoItem()

item['chapter']=response.xpath('//span[@class="last_tit"]/text()').extract()[0]

item['updatetime']=response.xpath('//div[@class="time"]/text()').extract()[0]

return item二、发送邮件

5.pipelines.pyfrom scrapy.mail import MailSender

import scrapy

class XiaoshuoPipeline(object):

def process_item(self, item, spider):

with open ('nitianxieshen.txt','r') as fp:

line=fp.readline().split('\t')

if item['chapter']!=line[0]:

Subject=u'小说《逆天邪神》更新啦!!!'

Body=u'更新内容:\n%s\n点击地址:\nhttp://m.zongheng.com/h5/book?bookid=408586'%item['chapter'

mailer=MailSender(smtphost="smtp.163.com",mailfrom="*****@163.com",smtpuser="******@163.com",smtppass="******",smtpport=25)

mailer.send(to=['*******@qq.com'],subject=Subject.encode('utf8'),body=Body.encode('utf8'))

with open('nitianxieshen.txt','w') as fp:

fp.write(item['chapter'].encode('utf8')+'\t')

fp.write(item['updatetime'].encode('utf8')+'\t\n')

return item6.settings.py

在最后一行添加:

ITEM_PIPELINES={'xiaoshuo.pipelines.XiaoshuoPipeline':2}7.执行验证

首先创建文件 nitianxieshen.txt :

vim nitianxieshen.txt

随便写入内容,与爬取的内容不同,方便测试爬虫是否发送邮件成功。

执行命令:

scrapy crawl nitianspider

三、定时任务

8.在目录:/home/yunge/code/spider/xiaoshuo/xiaoshuo/ 下,创建脚本crontab.sh,内容:

cd /home/yunge/code/spiders/xiaoshuo/xiaoshuo/ scrapy crawl nitianspider

9.脚本添加文件执行权限

执行命令:

chmod 774 crontab.sh

10.crontab 添加定时任务

执行命令:

crontab -e

写入:

30 */6 * * * /home/yunge/code/spiders/xiaoshuo/xiaoshuo/crontab.sh

从6:30开始,每隔6个小时执行一次crontab.sh。

11.取消脚本执行后发送电脑邮件

此邮件非爬虫里的邮件,是cron定时任务发送电脑用户(即yunge)的邮件,执行后会在命令端不断提醒。

重新修改:

crontab -e

内容:

30 */6 * * * /home/yunge/code/spiders/xiaoshuo/xiaoshuo/crontab.sh &> /dev/null

到此已经结束了,以后可以美滋滋地看小说了。。。

相关文章推荐

- centos linux 定时任务 定时每天执行php文件更新数据库 crontab

- QuickBI助你成为分析师-邮件定时推送

- app后端设计(3)--短信,邮件,推送服务(2014.12.05更新)

- Google发布手机同步功能,Gmail邮件推送指日可待

- Python +crontab定时备份目录发送邮件

- app后端设计(3)--短信,邮件,推送服务(2014.12.05更新)

- 利用python,shell,crontab实现成绩自动查询和更新邮件提醒

- SPring中quartz的配置(可以用实现邮件定时发送,任务定时执行,网站定时更新等)

- [原创] 使用rpi + crontab + git 定时向bitbucket 推送 照片

- linux下,用crontab定时执行scrapy任务

- 关于crontab定时任务执行失败发送报错邮件的问题

- Linux_git定时更新代码脚本(crontab)

- 手机网页开发学习(不定时更新)

- 手机没有推送更新系统,如何更新到 iOS 11

- 在mac下用crontab来定时执行scrapy爬虫命令

- Linux定时 crontab 更新数据库

- linux下使用crontab设置scrapy爬虫定时抓取数据

- 关于手机官方系统推送更新出错的解决方案

- Python Scrapy爬虫入门 - 使用Crontab实现Scrapy爬虫的定时执行

- 手机号码正则表达式写法【不定时更新】