大数据平台搭建-kafka集群的搭建

2017-07-11 18:11

826 查看

本系列文章主要阐述大数据计算平台相关框架的搭建,包括如下内容:

基础环境安装

zookeeper集群的搭建

kafka集群的搭建

hadoop/hbase集群的搭建

spark集群的搭建

flink集群的搭建

elasticsearch集群的搭建

alluxio集群的搭建

更多内容请阅读官网 http://kafka.apache.org/documentation.html#introduction

地址:http://kafka.apache.org/downloads,选择kafka_2.11-0.10.2.1.tgz版本

解压安装

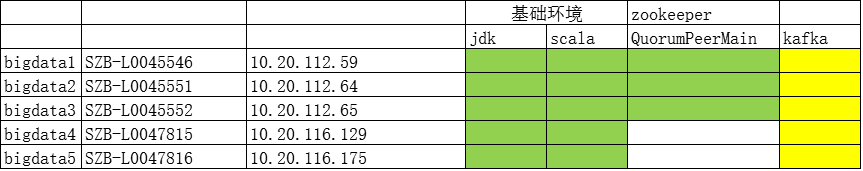

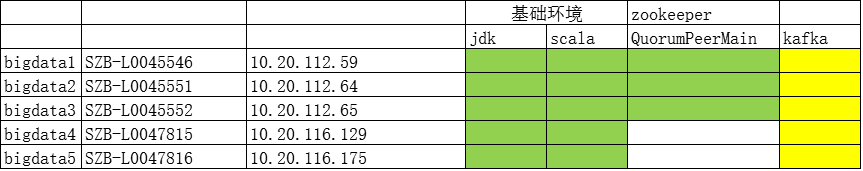

本文环境列表

直接在服务器10.20.112.59上解压

配置更改

编辑kafka server配置文件

vi /wls/oracle/kafka/config/server.properties

主要是如下几项:

kafka集群

修改server.properties

不同集群broker.id 和host.name 不一样,根据实际情况配置。

修改默认配置文件中的

broker.id(每台服务器均不同)

port(如果是伪集群,则端口号需要改变)

host.name

advertised.host.name

zookeeper.connect(所有集群的ip均需要说明)

log.dirs

以服务器SZB-L0045546,则其server.properties需更改的配置如下:

而集群另外4台服务器中的broker.id、host.name,advertised.host.name和SZB-L0045546的保持不同即可。同时集群中的服务器需要为kafka日志建立相关目录

启动和验证

依次启动集群中的kafka,执行脚本如下:

创建topic

显示创建的topic

向TEST中写入消息

从topic TEST中消费数据

基础环境安装

zookeeper集群的搭建

kafka集群的搭建

hadoop/hbase集群的搭建

spark集群的搭建

flink集群的搭建

elasticsearch集群的搭建

alluxio集群的搭建

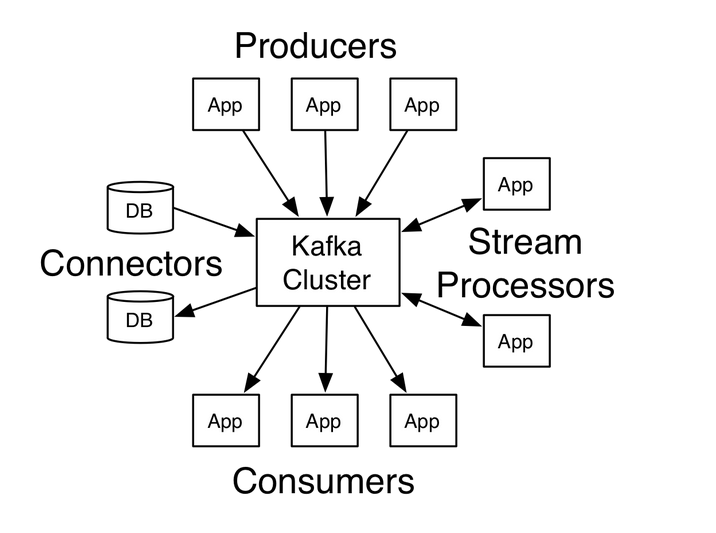

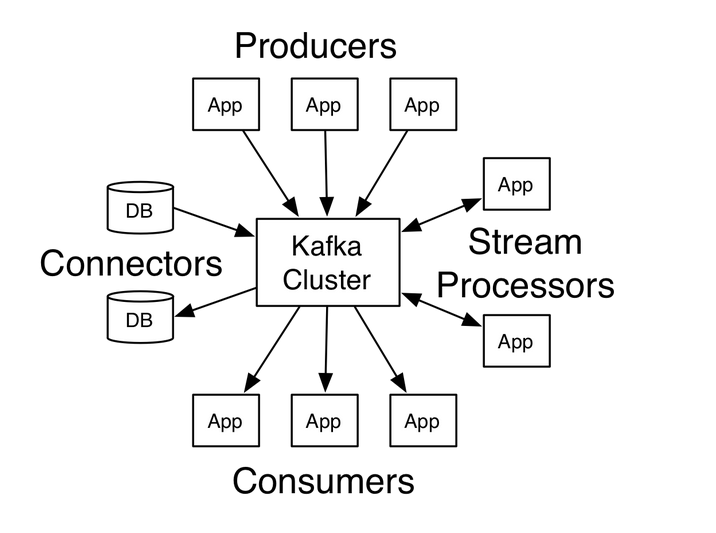

1.kafak简介

Kafka是一个分布式、分区的、多副本的、多订阅者的消息队列,以高吞吐量著称,主要用于实时数据的传输和处理,总体架构如下

更多内容请阅读官网 http://kafka.apache.org/documentation.html#introduction

2.kafka安装

下载地址:http://kafka.apache.org/downloads,选择kafka_2.11-0.10.2.1.tgz版本

解压安装

本文环境列表

直接在服务器10.20.112.59上解压

cd ~ tar -zxvf kafka_2.11-0.10.2.1.tgz.gz mv kafka_2.11-0.10.2.1 kafka

配置更改

编辑kafka server配置文件

vi /wls/oracle/kafka/config/server.properties

主要是如下几项:

kafka集群

修改server.properties

不同集群broker.id 和host.name 不一样,根据实际情况配置。

修改默认配置文件中的

broker.id(每台服务器均不同)

port(如果是伪集群,则端口号需要改变)

host.name

advertised.host.name

zookeeper.connect(所有集群的ip均需要说明)

log.dirs

以服务器SZB-L0045546,则其server.properties需更改的配置如下:

broker.id=1 port=9092 host.name=SZB-L0045546 advertised.host.name=10.20.112.59 zookeeper.connection=SZB-L0045546:2181,SZB-L0045551:2181,SZB-L0045552:2181/kafka log.dirs=/wls/oracle/bigdata/kafka/kafka-logs-1,/wls/oracle/bigdata/kafka/kafka-logs-2,/wls/oracle/bigdata/kafka/kafka-logs-3

而集群另外4台服务器中的broker.id、host.name,advertised.host.name和SZB-L0045546的保持不同即可。同时集群中的服务器需要为kafka日志建立相关目录

mkdir -p /wls/oracle/bigdata/kafka/kafka-logs-1 mkdir -p /wls/oracle/bigdata/kafka/kafka-logs-2 mkdir -p /wls/oracle/bigdata/kafka/kafka-logs-3

启动和验证

依次启动集群中的kafka,执行脚本如下:

cd wls/oracle/bigdata/kafka/logs nohup /wls/oracle/kafka/bin/kafka-server-start.sh /wls/oracle/kafka/config/server.properties >> /wls/oracle/bigdata/kafka/logs/kafka.out 2&1 &

创建topic

/wls/oracle/kafka/bin/kafka-topics.sh --zookeeper 10.20.112.59:2181,10.20.112.64:2181,10.20.112.65:2181,10.20.116.129:2181,10.20.116.175:2181/kafka --create --topic TEST --replication-factor 2 --partitions 3

显示创建的topic

/wls/oracle/kafka/bin/kafka-topics.sh --zookeeper 10.20.112.59:2181,10.20.112.64:2181,10.20.112.65:2181,10.20.116.129:2181,10.20.116.175:2181/kafka --list

向TEST中写入消息

/wls/oracle/kafka/bin/kafka-console-producer.sh --broker-list 10.20.112.59:2181,10.20.112.64:2181,10.20.112.65:2181,10.20.116.129:2181,10.20.116.175:2181/kafka --topic TEST

从topic TEST中消费数据

/wls/oracle/kafka/bin/kafka-console-consumer.sh --bootstrap-server 10.20.112.59:2181,10.20.112.64:2181,10.20.112.65:2181,10.20.116.129:2181,10.20.116.175:2181/kafka --topic TEST --from-beginning

相关文章推荐

- 大数据平台CDH集群离线搭建

- Spark项目之电商用户行为分析大数据平台之(二)CentOS7集群搭建

- Kafka:ZK+Kafka+Spark Streaming集群环境搭建(二十五)Structured Streaming:同一个topic中包含一组数据的多个部分,按照key它们拼接为一条记录(以及遇到的问题)。

- Spark项目之电商用户行为分析大数据平台之(三)大数据集群的搭建

- 朝花夕拾之--大数据平台CDH集群离线搭建

- 大数据平台 Hadoop 的分布式集群环境搭建

- 大数据平台之CDH集群离线搭建

- 13,数据挖掘环境搭建-kafka集群安装

- 大数据统计分析平台之一、Kafka单机搭建

- 大数据平台Hadoop的分布式集群环境搭建

- 搭建最简单的实时数据平台kafka-->storm

- 大数据平台搭建-spark集群安装

- kafka集群搭建以及运行kafka监控平台kmonitor

- 大数据_Kafka_搭建Kafka伪集群(本地集群)

- Kafka:ZK+Kafka+Spark Streaming集群环境搭建(二十二)Spark Streaming接收流数据及使用窗口函数

- 大数据 --> Kafka集群搭建

- 朝花夕拾之--大数据平台CDH集群离线搭建

- 大数据平台搭建-hadoop/hbase集群的搭建

- kafka入门:简介、使用场景、设计原理、主要配置及集群搭建 (转)