MPI之聚合通信collective communication-广播

2017-04-12 21:03

204 查看

一、前言

点对点的通信学习已经通过一个案例完成了,现在开始新的一节:collective communication。聚合通信是在通信子中的所有的进程都参与的通信方式。

二、聚合与同步

1、同步

对于所有的进程来说,聚合通信必然包含了一个同步点。也就是说所有的进程必须在他们又一次执行新动作之前都到达某个点。这跟GPU中线程同步的概念很相似,很好理解。如果n个线程或者进程不遵守这个规矩,那么就会发生有的线程或者进程正在写某几个寄存器的数据,而本应该都在写或者等待都写完再读取的几个进程或者线程却在此时读取了另外几个寄存器的数据,那么我想这样数据没有人敢用。

MPI_Barrier就是这样的一个函数,他确保除非所有的进程同时调用,否则他不会拒绝任何进程通过这个节点。

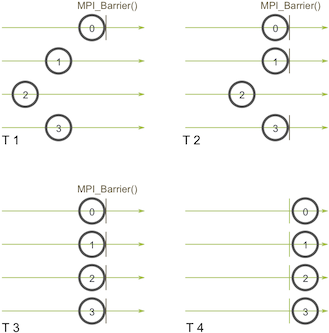

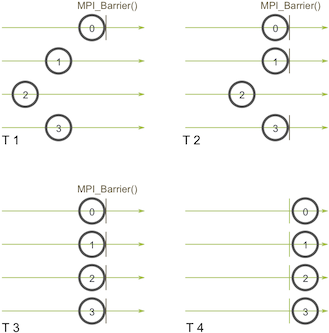

T1,T2时刻,都只有部分的进程再call MPI_Barrier,此时是没有什么鸟用的,只有当T3时刻时,才会通过。

最后,如果没有MPI_Barrier,那么任何聚合通信都是浮云。

2、广播

广播机制:

一个进程将相同的数据发送给通信子中所有的进程。

该机制最主要的应用是将输入数据发送给并行程序,或者将配置参数发送给所有的进程。

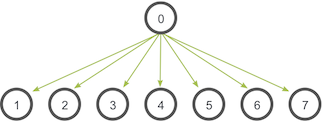

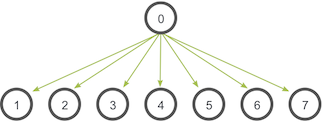

上图中,0号线程是根进程,他保存有最原始的数据的拷贝,其他所有的进程接收这些数据的拷贝。

MPI_Bcast

虽然根进程和接收进程执行的是不同的任务,但是他们调用的是一样的MPI_Bcast函数。当根进程调用的时候,void* data会被发送到其他所有的进程中,如果是其他接收进程调用MPI_Bcast函数,void* data就会被根进程中的数据初始化。

实际上可以用MPI_Send 和 MPI_Recv 来实现,很naive

上述实现有个问题:假设每个进程只有一个输入输出的网络连接,那么该程序就只有一个网络连接去让0号进程去给所有的进程发送数据。

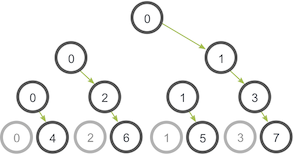

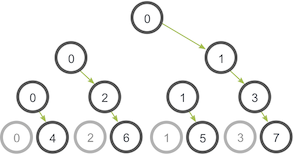

更聪明的一种做法是树状通信算法:

0号进程发送数据给1号进程,然后0号进程也发送数据给2号进程在树的第二级上。不同的是1号进程现在也将数据发送给3号进程,2号进程将数据发送给6号进程。

根据上述思想自定义实现

明天再写。。。

点对点的通信学习已经通过一个案例完成了,现在开始新的一节:collective communication。聚合通信是在通信子中的所有的进程都参与的通信方式。

二、聚合与同步

1、同步

对于所有的进程来说,聚合通信必然包含了一个同步点。也就是说所有的进程必须在他们又一次执行新动作之前都到达某个点。这跟GPU中线程同步的概念很相似,很好理解。如果n个线程或者进程不遵守这个规矩,那么就会发生有的线程或者进程正在写某几个寄存器的数据,而本应该都在写或者等待都写完再读取的几个进程或者线程却在此时读取了另外几个寄存器的数据,那么我想这样数据没有人敢用。

MPI_Barrier就是这样的一个函数,他确保除非所有的进程同时调用,否则他不会拒绝任何进程通过这个节点。

MPI_Barrier(MPI_Comm communicator)

T1,T2时刻,都只有部分的进程再call MPI_Barrier,此时是没有什么鸟用的,只有当T3时刻时,才会通过。

最后,如果没有MPI_Barrier,那么任何聚合通信都是浮云。

2、广播

广播机制:

一个进程将相同的数据发送给通信子中所有的进程。

该机制最主要的应用是将输入数据发送给并行程序,或者将配置参数发送给所有的进程。

上图中,0号线程是根进程,他保存有最原始的数据的拷贝,其他所有的进程接收这些数据的拷贝。

MPI_Bcast

MPI_Bcast( void* data,//数据 int count,//数据个数 MPI_Datatype datatype, int root,//根进程编号 MPI_Comm communicator)

虽然根进程和接收进程执行的是不同的任务,但是他们调用的是一样的MPI_Bcast函数。当根进程调用的时候,void* data会被发送到其他所有的进程中,如果是其他接收进程调用MPI_Bcast函数,void* data就会被根进程中的数据初始化。

实际上可以用MPI_Send 和 MPI_Recv 来实现,很naive

void my_bcast(void* data, int count, MPI_Datatype datatype, int root,

MPI_Comm communicator) {

int world_rank;

MPI_Comm_rank(communicator, &world_rank);//进程编号

int world_size;

MPI_Comm_size(communicator, &world_size);//获取进程个数

if (world_rank == root) {//找到根进程

// If we are the root process, send our data to everyone

int i;

for (i = 0; i < world_size; i++) {

if (i != world_rank) {

MPI_Send(data, count, datatype, i, 0, communicator);//向非根进程发送数据

}

}

} else {//非根进程接收数据

// If we are a receiver process, receive the data from the root

MPI_Recv(data, count, datatype, root, 0, communicator,

MPI_STATUS_IGNORE);

}

}上述实现有个问题:假设每个进程只有一个输入输出的网络连接,那么该程序就只有一个网络连接去让0号进程去给所有的进程发送数据。

更聪明的一种做法是树状通信算法:

0号进程发送数据给1号进程,然后0号进程也发送数据给2号进程在树的第二级上。不同的是1号进程现在也将数据发送给3号进程,2号进程将数据发送给6号进程。

根据上述思想自定义实现

明天再写。。。

相关文章推荐

- MPI之聚合通信collective communication-广播

- MPI之聚合通信collective communication-广播

- MPI之聚合通信collective communication-广播

- MPI之聚合通信collective communication-广播

- MPI之聚合通信collective communication-广播

- MPI之聚合通信collective communication-广播

- MPI之聚合通信collective communication-广播

- MPI之聚合通信collective communication-广播

- MPI之聚合通信collective communication-广播

- MPI之聚合通信collective communication-广播

- MPI之聚合通信collective communication-广播

- MPI之聚合通信-Scatter,Gather,Allgather

- MPI聚合通信之MPI_Barrier函数

- MPI之聚合通信-Scatter,Gather,Allgather

- MPI聚合通信之MPI_Bcast函数

- MPI之聚合通信-Scatter,Gather,Allgather

- MPI聚合通信之MPI_Gather函数

- MPI之聚合通信-Scatter,Gather,Allgather

- [MPI] MPI 组通信程序设计 -- 广播

- MPI学习-聚合通信