StackGAN: Text to Photo-realistic Image Synthesis with Stacked Generative Adversarial Networks 论文笔记

2017-01-05 17:19

826 查看

StackGAN: Text to Photo-realistic Image Synthesis with Stacked Generative Adversarial Networks

本文将利用 GANs 进行高质量图像生成,分为两个阶段进行,coarse to fine 的过程。据说可以生成 256*256 的高清图像。

基于文本生成对应图像的工作已经有了,比如说 Attribute2Image,以及 最开始的基于文本生成图像的文章等等。

Stacked Generated Adversarial Networks.

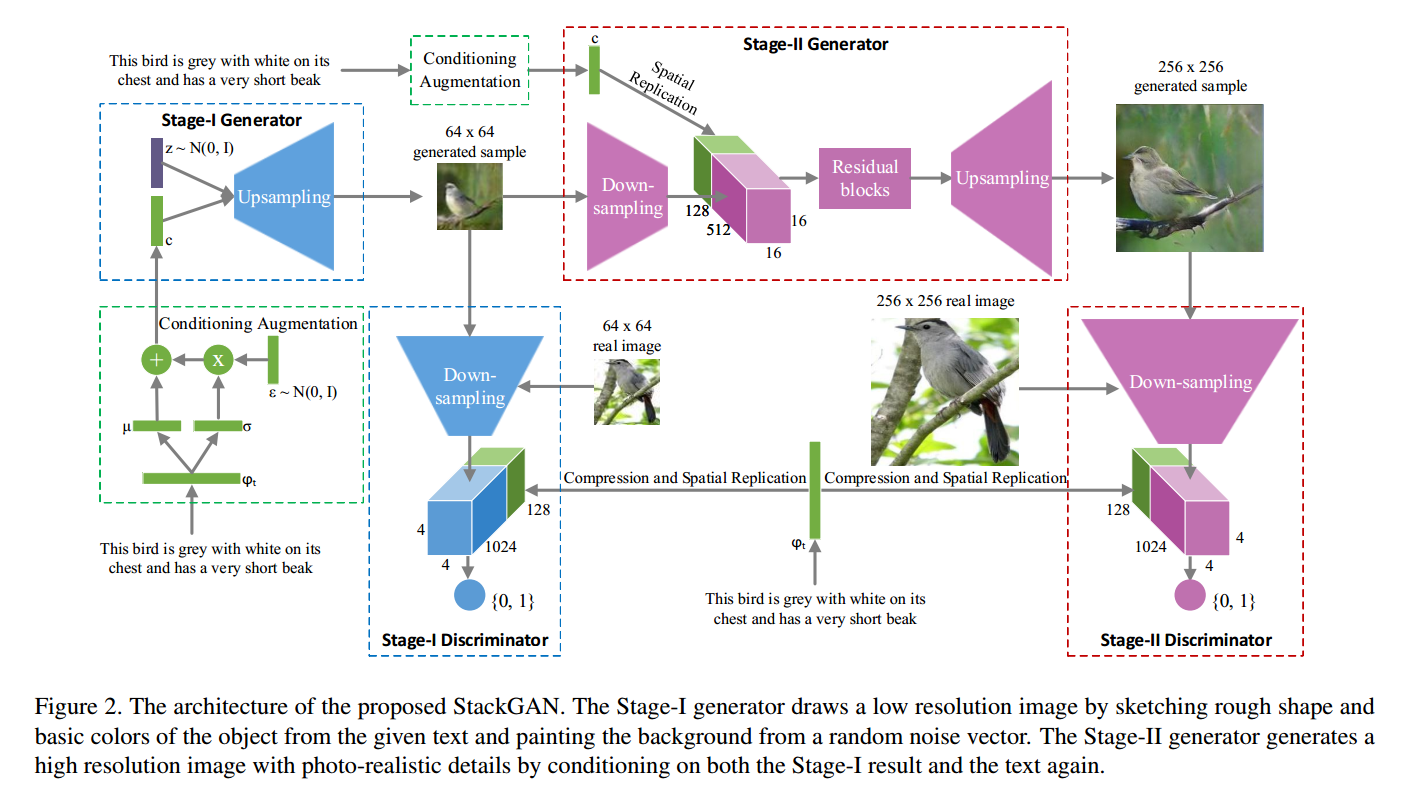

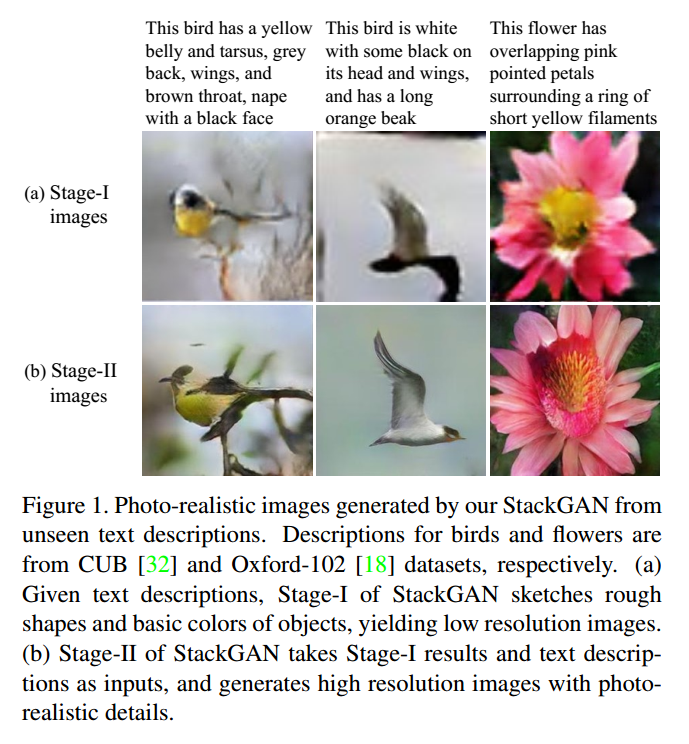

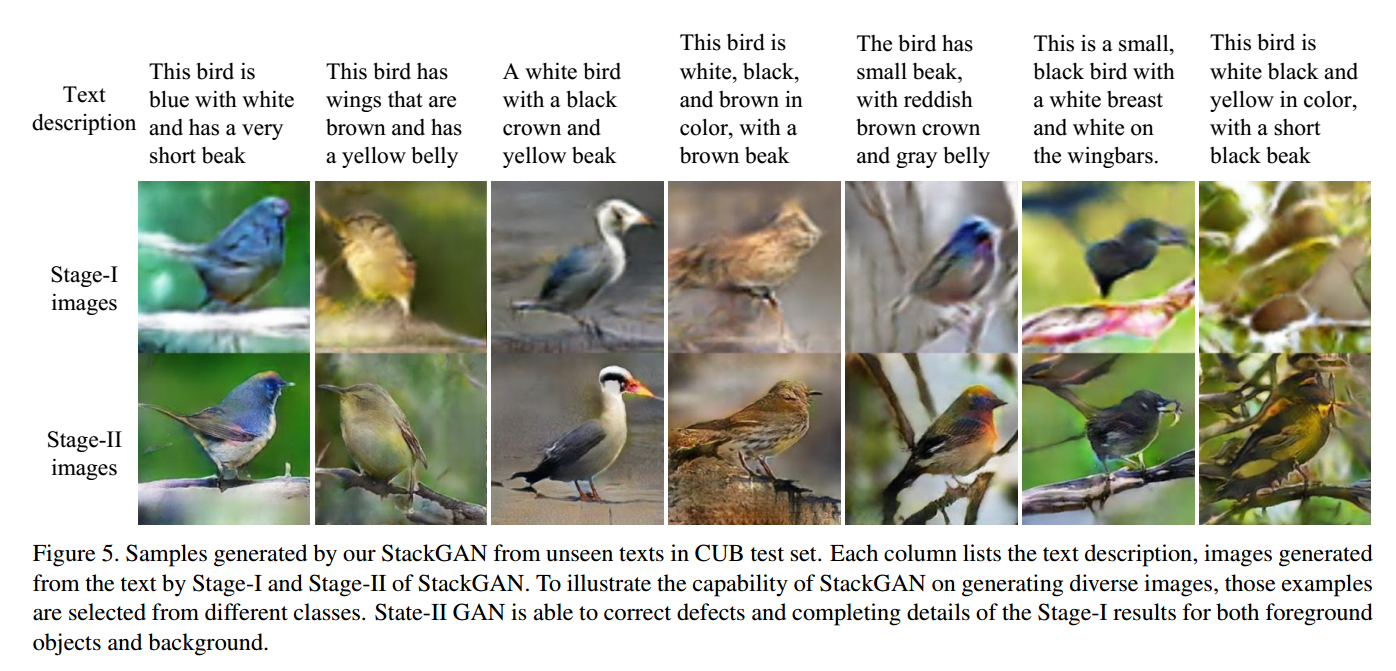

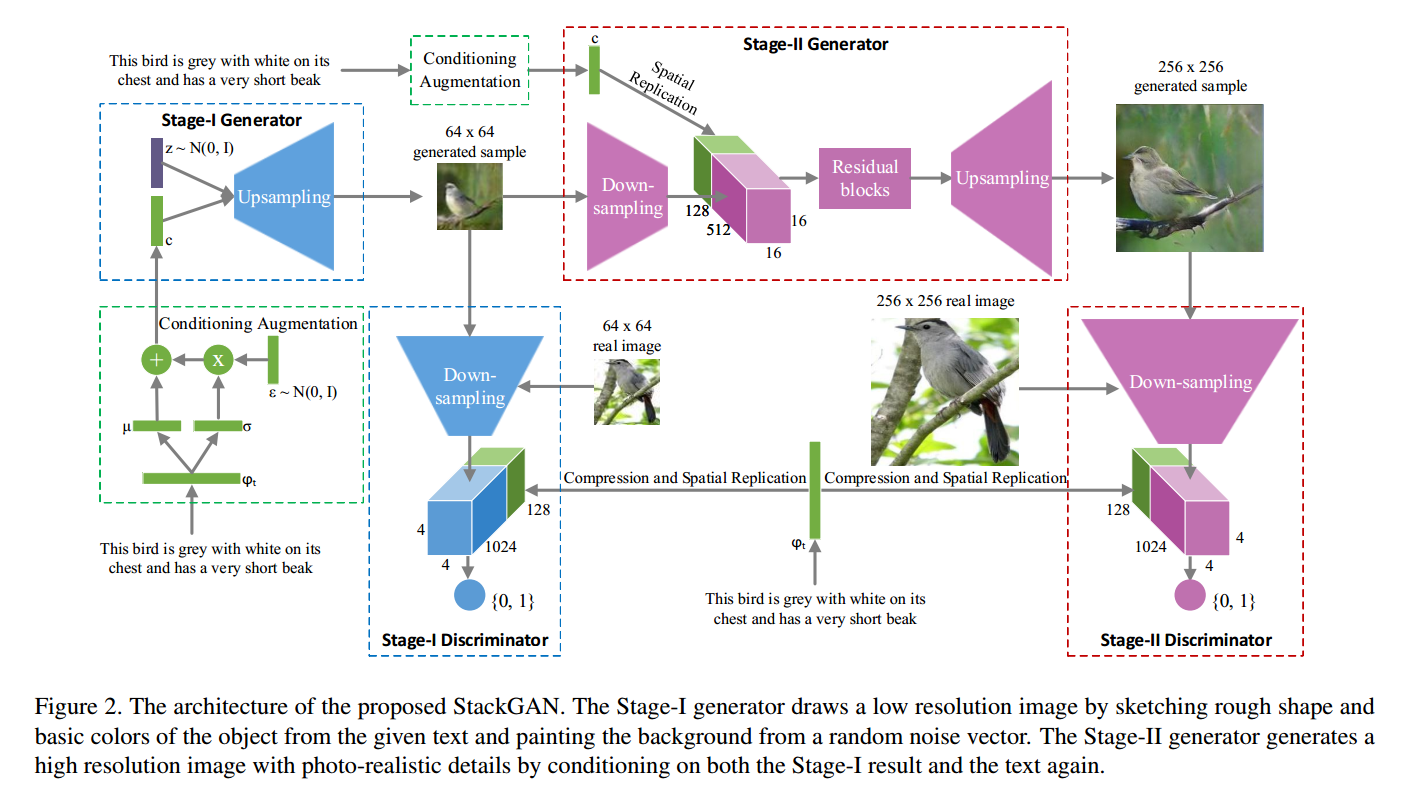

所涉及到的两个阶段分别为:

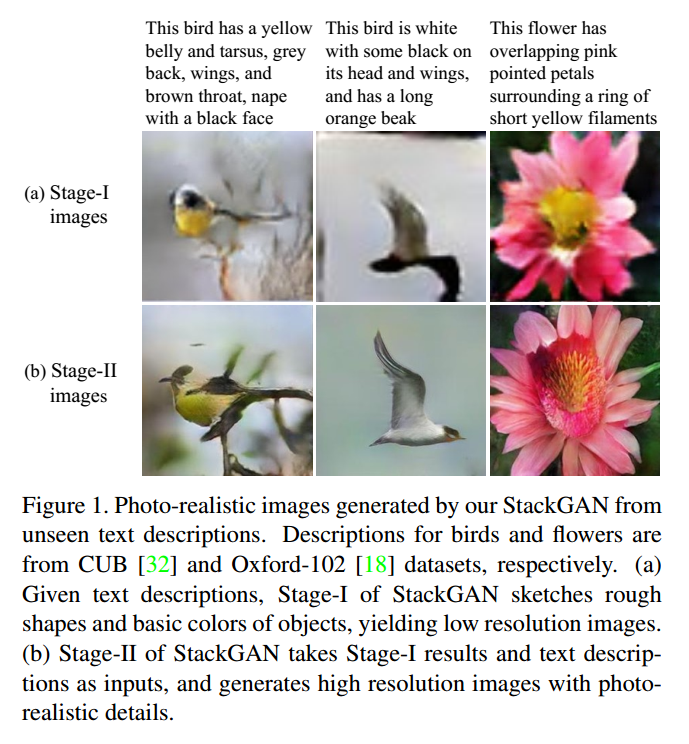

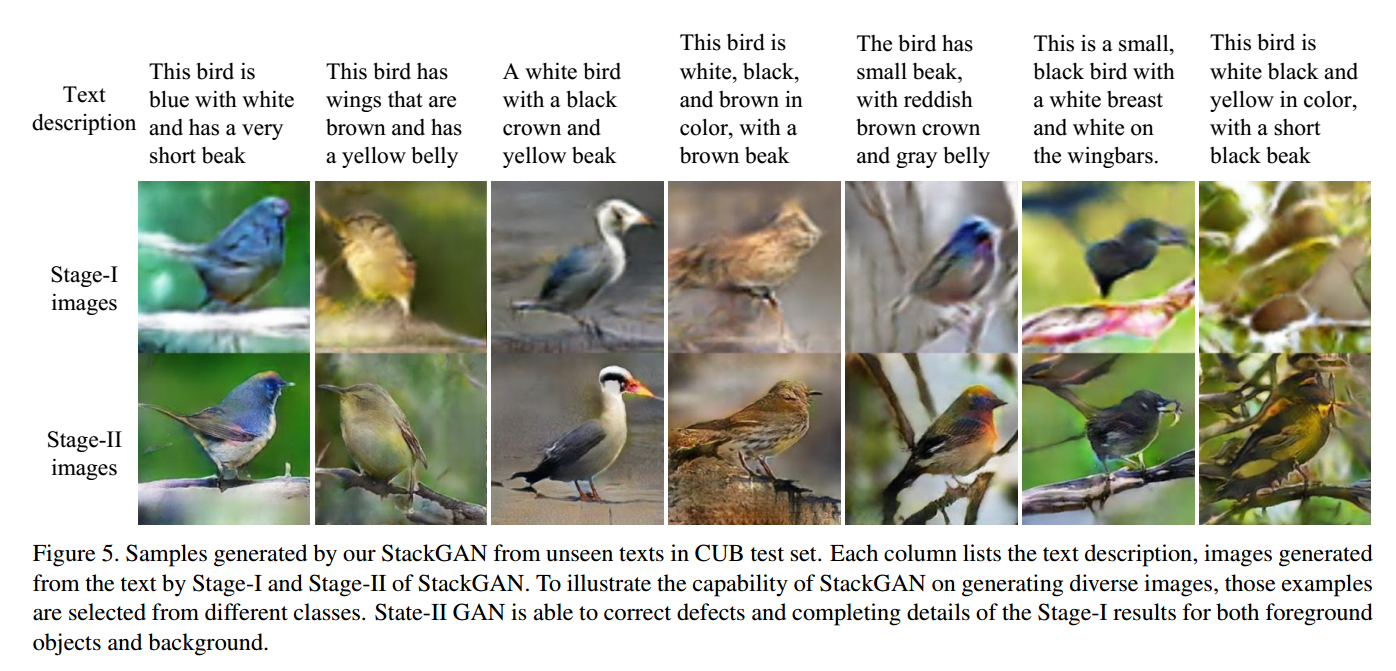

Stage-I GAN:基于文本描述,我们得到初始的形状,基础的色彩;然后从随机 noise 绘出背景分布,产生低分辨率的图像;

Stage-II GAN:通过在此的结合文本描述,进行图像的细致化绘制,产生高质量的 Image。

为了缓解条件文本描述 t 产生的高维的 latent space,但是有限的训练数据,可能导致 latent data manifold 的非连续性,

这对于训练产生器来说,可能不是很好。

为了解决这个问题,作者引入了 条件增强技术 来产生更多的条件变量。从一个独立的高斯分布 N 中随机的采样 latent variables,其均值 $\mu$ 和 对角协方差矩阵 是 text embedding 的函数。所提出的公式可以进一步的提升对小的扰动的鲁棒性,并且在给定少量 image-text pairs 的条件下,产生更多的训练样本。为了进一步的提升平滑性,给产生器的目标函数,添加了一个正则化项:

其中,上式就是 标准高斯分布 和 条件高斯分布的 KL-散度。

基于高斯条件变量 c0,阶段一的 GAN 迭代的进行两个目标函数的训练:

第二个阶段的 GAN 和第一阶段的非常类似。

不同的地方,在于产生器不再以 noise Z 作为输入,而是 s0 = G0(z,c0)。

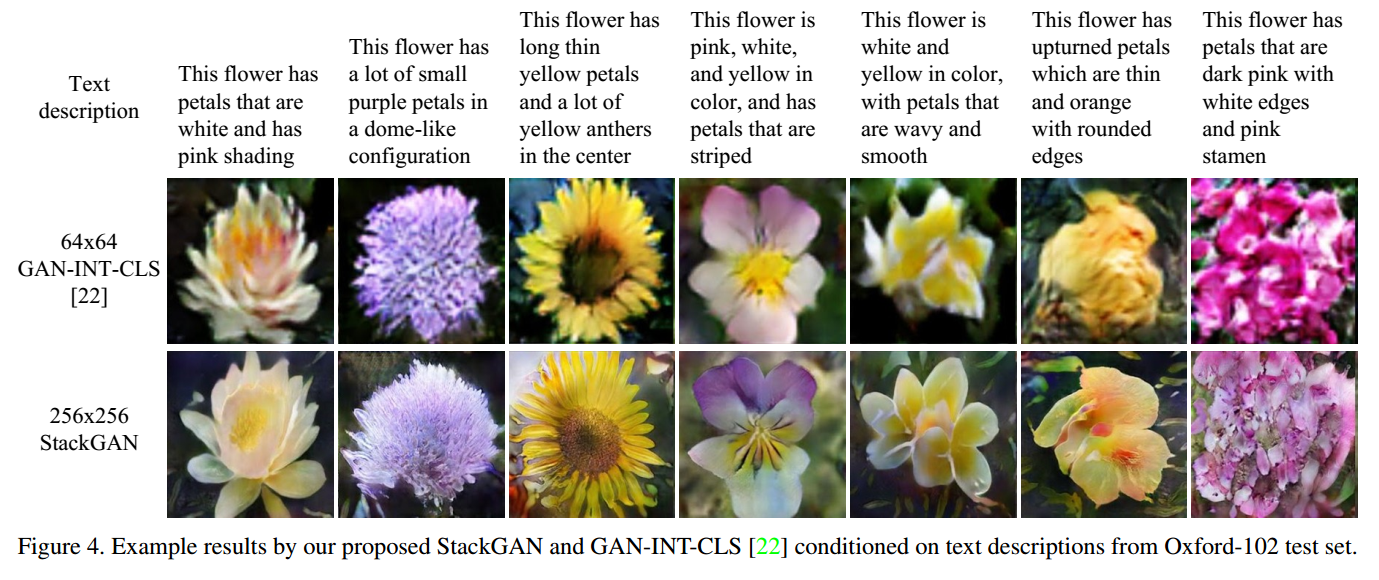

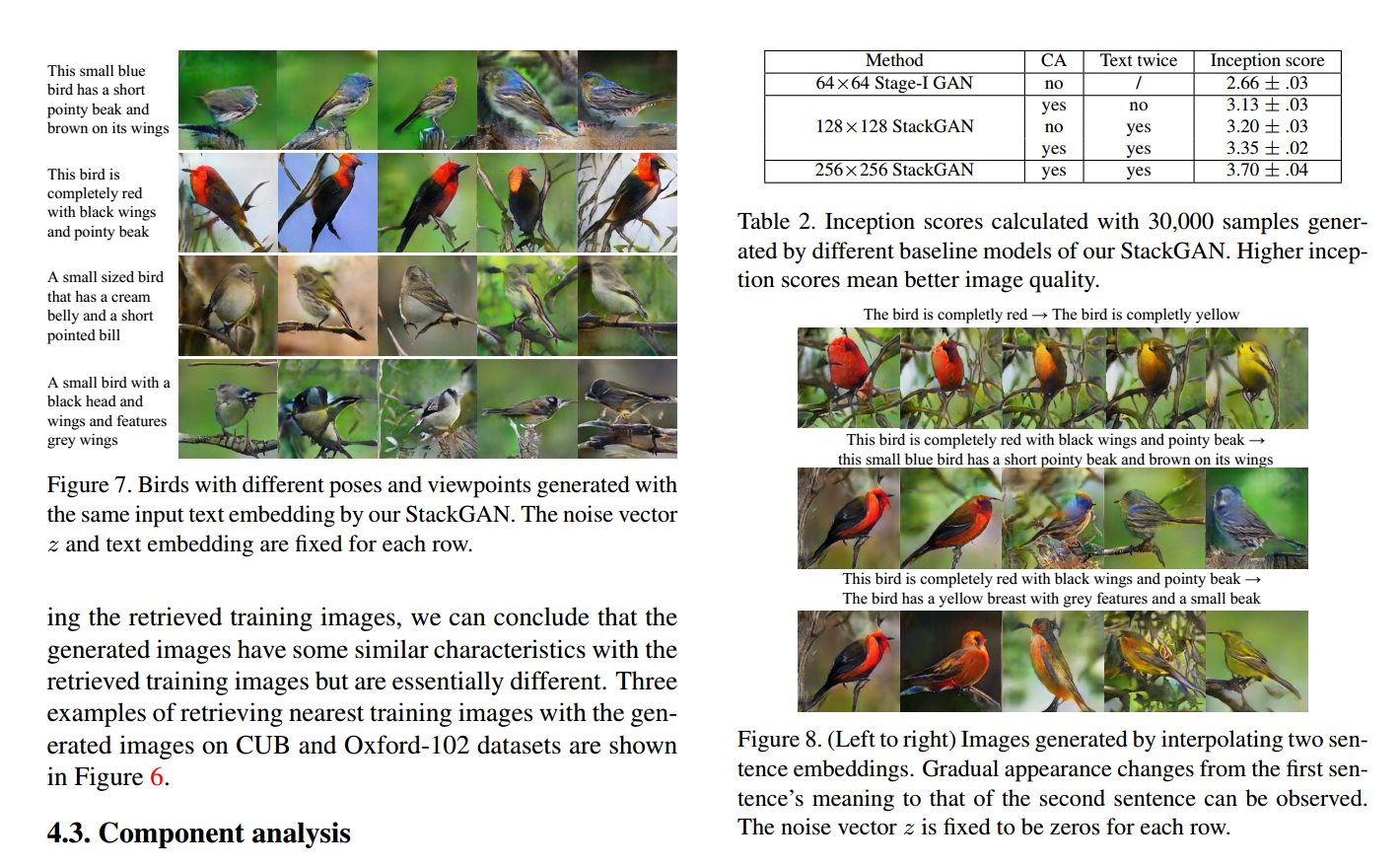

整体来说,个人感觉并没有太多的创新,不过这个实验结果,的确是非常 impressive。

本文将利用 GANs 进行高质量图像生成,分为两个阶段进行,coarse to fine 的过程。据说可以生成 256*256 的高清图像。

基于文本生成对应图像的工作已经有了,比如说 Attribute2Image,以及 最开始的基于文本生成图像的文章等等。

Stacked Generated Adversarial Networks.

所涉及到的两个阶段分别为:

Stage-I GAN:基于文本描述,我们得到初始的形状,基础的色彩;然后从随机 noise 绘出背景分布,产生低分辨率的图像;

Stage-II GAN:通过在此的结合文本描述,进行图像的细致化绘制,产生高质量的 Image。

为了缓解条件文本描述 t 产生的高维的 latent space,但是有限的训练数据,可能导致 latent data manifold 的非连续性,

这对于训练产生器来说,可能不是很好。

为了解决这个问题,作者引入了 条件增强技术 来产生更多的条件变量。从一个独立的高斯分布 N 中随机的采样 latent variables,其均值 $\mu$ 和 对角协方差矩阵 是 text embedding 的函数。所提出的公式可以进一步的提升对小的扰动的鲁棒性,并且在给定少量 image-text pairs 的条件下,产生更多的训练样本。为了进一步的提升平滑性,给产生器的目标函数,添加了一个正则化项:

其中,上式就是 标准高斯分布 和 条件高斯分布的 KL-散度。

基于高斯条件变量 c0,阶段一的 GAN 迭代的进行两个目标函数的训练:

第二个阶段的 GAN 和第一阶段的非常类似。

不同的地方,在于产生器不再以 noise Z 作为输入,而是 s0 = G0(z,c0)。

整体来说,个人感觉并没有太多的创新,不过这个实验结果,的确是非常 impressive。

相关文章推荐

- 论文笔记之:Generative Adversarial Text to Image Synthesis

- 论文笔记:Precomputed Real-Time Texture Synthesis with Markovian Generative Adversarial Networks

- Image-to-Image Translation with Conditional Adversarial Networks论文学习

- 论文笔记之:Semi-Supervised Learning with Generative Adversarial Networks

- 《Generative Adversarial Text to Image Synthesis》阅读理解

- 论文阅读之:Photo-Realistic Single Image Super-Resolution Using a Generative Adversarial Network

- Generative Adversarial Text to Image Synthesis --- 根据文字描述生成对应的图片

- 论文笔记之:UNSUPERVISED REPRESENTATION LEARNING WITH DEEP CONVOLUTIONAL GENERATIVE ADVERSARIAL NETWORKS

- 每日论文Photo-Realistic Single Image Super-Resolution Using a Generative Adversarial Network

- 每日论文image-to-Image Translation with Conditional Adversarial Networks

- 《Photo-Realistic Single Image Super-Resolution Using a Generative Adversarial Network》阅读笔记

- Image-to-Image Translation with Conditional Adversarial Networks 论文翻译

- ICCV2017论文“Unpaired Image-to-Image Translation using Cycle-Consistent Adversarial Networks” 阅读笔记

- 论文笔记:unsupervised representation learning with deep convolutional generative adversarial networks

- 论文笔记之:Deep Generative Image Models using a Laplacian Pyramid of Adversarial Networks

- 『论文阅读』Image-to-Image Translation with Conditional Adversarial Networks

- 《Photo-Realistic Single Image Super-Resolution Using a Generative Adversarial Network》阅读笔记

- 《Photo-Realistic Single Image Super-Resolution Using a Generative Adversarial Network》阅读笔记

- 论文引介 | StackGAN: Stacked Generative Adversarial Networks

- 经典计算机视觉论文笔记——《ImageNet Classification with Deep Convolutional Neural Networks》