再次理解线性回归与梯度下降

2016-12-07 15:17

134 查看

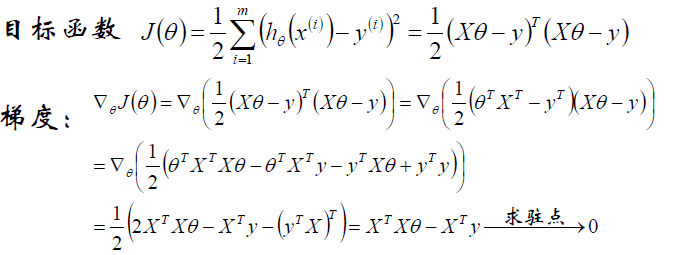

首先,给出目标函数:

目的就是使得J(Θ)最小。

还知道,Θ是未知量,目的就是求什么样的Θ能使目标函数J(Θ)最小。下面有两种方法:

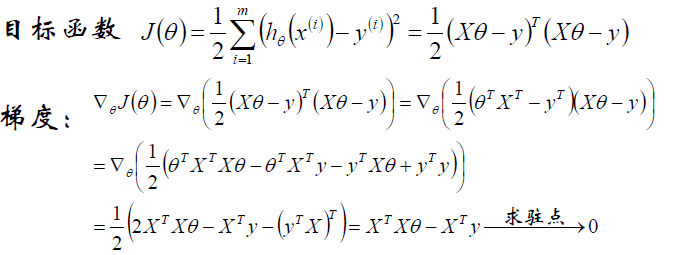

(1)直接通过解析式,解除出Θ。

原式对Θ求导数,找驻点。

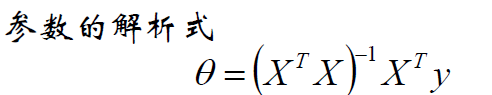

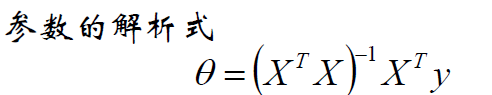

这样能得出Θ得参数解析式:

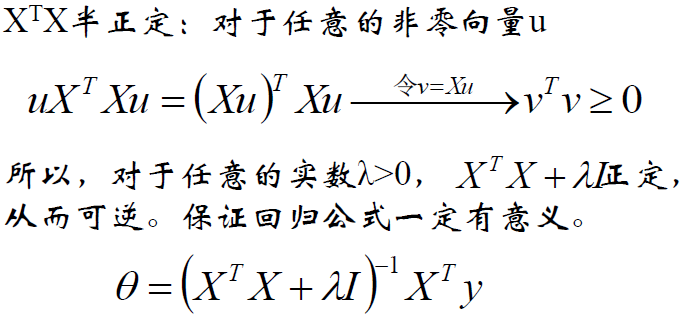

若XTX不可逆,这是数学上的解释,也可以解释为防止过拟合,所以增加了λ扰动。

这里还要补充两个知识点:

另外:ΘTAΘ(A为可逆矩阵)对Θ求偏导,结果为2AΘ。

以上是Θ的解析式求解。

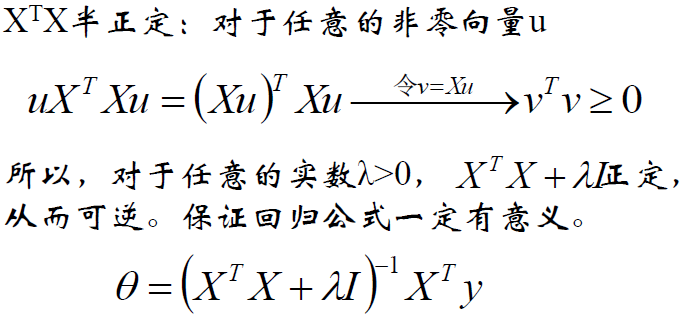

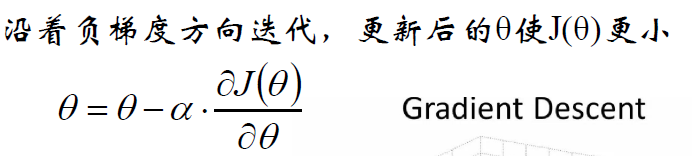

(2)梯度下降法

依然关注这个目标函数。

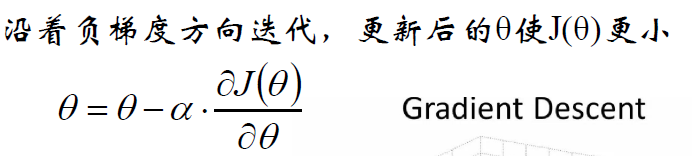

梯度下降的本质是:start with some Θ,keep change Θ to reduce J(Θ)。

那怎么change Θ来达到目的呢?

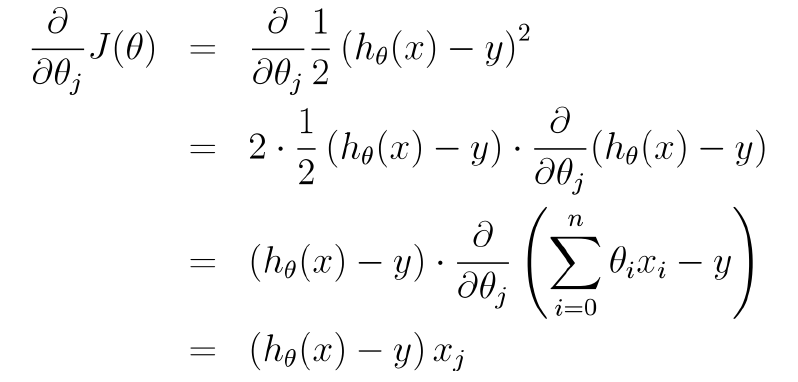

还看目标函数,为了mini J(Θ),对Θ求偏导找驻点,但驻点不好找,找J(Θ)关于Θ下降最快的方向也行啊。

这就是那个方向,梯度方向。

然后有:

现在突然有个问题,为什么这么更新Θ能使J(Θ)最小呢?

待解决。

目的就是使得J(Θ)最小。

还知道,Θ是未知量,目的就是求什么样的Θ能使目标函数J(Θ)最小。下面有两种方法:

(1)直接通过解析式,解除出Θ。

原式对Θ求导数,找驻点。

这样能得出Θ得参数解析式:

若XTX不可逆,这是数学上的解释,也可以解释为防止过拟合,所以增加了λ扰动。

这里还要补充两个知识点:

另外:ΘTAΘ(A为可逆矩阵)对Θ求偏导,结果为2AΘ。

以上是Θ的解析式求解。

(2)梯度下降法

依然关注这个目标函数。

梯度下降的本质是:start with some Θ,keep change Θ to reduce J(Θ)。

那怎么change Θ来达到目的呢?

还看目标函数,为了mini J(Θ),对Θ求偏导找驻点,但驻点不好找,找J(Θ)关于Θ下降最快的方向也行啊。

这就是那个方向,梯度方向。

然后有:

现在突然有个问题,为什么这么更新Θ能使J(Θ)最小呢?

待解决。

相关文章推荐

- Java 集合框架的再次理解

- 从信号的维度再次理解香农公式,进而发问,人类到底生活在几维空间中?

- 第一节 线性回归和梯度下降

- 对深拷贝与浅拷贝的再次理解

- Proxy 动态代理再次理解

- 再次理解js中的call函数

- mybatis的再次深入理解

- 斯坦福机器学习笔记01 - 线性回归和梯度下降

- 再次理解——命令模式

- C语言之指针的再次理解

- 浅拷贝&深拷贝的再次理解

- IOS 代理的再次理解 = = (两种情况讨论)(要理解委托是委托本来自己要做的事情)

- mysq数据库再次理解

- 再次图文理解Android 中Activity的启动模式

- 再次理解按值和按引用传递类型

- 从更规范的概念描述再次理解数据库范式

- 学习笔记---再次理解事件和委托

- 最新回归算法理解、实现及应用(1)线性回归

- 对深拷贝与浅拷贝的再次理解

- 再次理解JSON数据