python爬虫笔记 --------scrapy框架(2)

2016-11-10 23:01

405 查看

Scrapy入门:

1、创建项目

开始爬取之前,进入打算存储代码的目录,运行:scrapy startproject tutorial

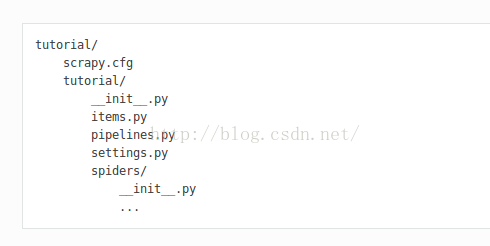

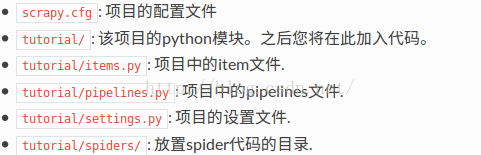

该命令将会创建包含下列内容的

tutorial目录:

这些文章分别是:

2、定义Item

Item 是保存爬取到的数据的容器;其使用方法和python字典类似,并且提供了额外保护机制来避免拼写错误导致的未 定义字段错误。

编辑

tutorial目录中的

items.py文件:

import scrapy class DmozItem(scrapy.Item): title = scrapy.Field() link = scrapy.Field() desc = scrapy.Field()

3、编写第一个爬虫(Spider)

Spider是用户编写用于从单个网站(或者一些网站)爬取数据的类。编写以下Spider代码,保存在

tutorial/spiders目录下的

dmoz_spider.py文件中:

import scrapy

class DmozSpider(scrapy.spider.Spider):

name="dmoz"

allowed_domains=["dmoz.org"]

start_urls=[

"http://www.dmoz.org/Computers/Programming/Languages/Python/Books/"

"http://www.dmoz.org/Computers/Programming/Languages/Python/Resources/"

]

defparse(self,response):

filename=response.url.split("/")[-2]

with open(filename,'wb') as f:

f.write(response.body)name: 用于区别Spider。该名字必须是唯一的,您不可以为不同的Spider设定相同的名字。

allowed_domains:可选。包含了spider允许爬取的域名(domain)列表(list)。

start_urls:

包含了Spider在启动时进行爬取的url列表。因此,第一个被获取到的页面将是其中之一。

后续的URL则 从初始的URL获取到的数据中提取。

parse:是spider的一个方法。被调用时,每个初始URL完成下载后生成的

Response对象将会作为唯一

的参数传递给该函数。该方法负责解析返回的数据(response data),提取数据(生成item)以及生成需

要进一步处理的URL的

Response对象。

执行时发生的事情:Scrapy为Spider的

start_urls属性中的每个URL创建了 scrapy.Request对象,

并将

parse方法作为回调函数(callback)赋值给了Request。

Request对象经过调度,执行生成

scrapy.http.Request

对象并送回给spider

parse方法。

4、爬取

进入根目录执行下面命令启动spider:scrapy crawl dmoz

dmoz为Spider中name属性

先写到这里吧,希望能一天天地进步。

相关文章推荐

- Python爬虫框架Scrapy 学习笔记 10.2 -------【实战】 抓取天猫某网店所有宝贝详情

- Python爬虫框架Scrapy 学习笔记 10.2 -------【实战】 抓取天猫某网店所有宝贝详情

- 【实战\聚焦Python分布式爬虫必学框架Scrapy 打造搜索引擎项目笔记】第2章 windows下搭建开发环境

- python 爬虫 学习笔记(一)Scrapy框架入门

- Python爬虫框架Scrapy 学习笔记 10.3 -------【实战】 抓取天猫某网店所有宝贝详情

- 【实战\聚焦Python分布式爬虫必学框架Scrapy 打造搜索引擎项目笔记】第4章 scrapy爬取知名技术文章网站(1)

- 【实战\聚焦Python分布式爬虫必学框架Scrapy 打造搜索引擎项目笔记】第5章 scrapy爬取知名问答网站(1)

- 学习python 中的scrapy爬虫框架艰辛路,不推荐看,主要纪录自己学习笔记的

- Python爬虫框架Scrapy 学习笔记 5 ------- 使用pipelines过滤敏感词

- 【实战\聚焦Python分布式爬虫必学框架Scrapy 打造搜索引擎项目笔记】第3章 爬虫基础知识回顾

- python爬虫框架scrapy学习笔记

- Python爬虫框架Scrapy 学习笔记 9 ----selenium

- Python的Scrapy爬虫框架简单学习笔记

- Python的Scrapy爬虫框架简单学习笔记

- 【python爬虫】scrapy框架笔记(一):创建工程,使用scrapy shell,xpath

- 【实战\聚焦Python分布式爬虫必学框架Scrapy 打造搜索引擎项目笔记】第5章 scrapy爬取知名问答网站(2)

- 【实战\聚焦Python分布式爬虫必学框架Scrapy 打造搜索引擎项目笔记】第4章 scrapy爬取知名技术文章网站(2)

- python爬虫框架scrapy学习笔记

- 【实战\聚焦Python分布式爬虫必学框架Scrapy 打造搜索引擎项目笔记】第1章 课程介绍

- Python爬虫框架Scrapy 学习笔记 4 ------- 第二个Scrapy项目