Spark,Hello World

2016-06-27 20:43

253 查看

首先下载Spark并解压缩到/apphome目录,/apphome/spark-1.6.1-bin-hadoop2.6

进入到这个目录后执行如下命令:bin/spark-shell

Spark 启动成功。

来实现第一个例子:

在spark shell 中依次输入如下命令:

需要说明的是每输入一行,回车后,都会有对应的日志出现。README.md是在/apphome/spark-1.6.1-bin-hadoop2.6 目录下面的。

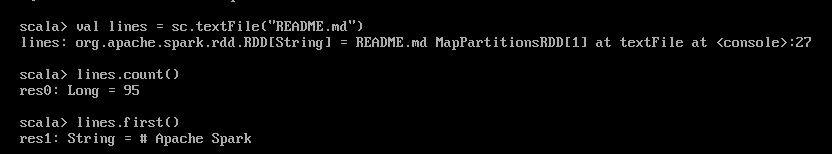

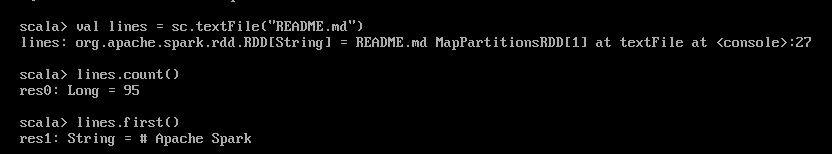

截图如下:

第一行是加载README.md文件到spark中。

第二行是统计README.md文件的行数。

第三行是返回README.md文件的第一行。

到此,入门实例结束。很简单吧~

进入到这个目录后执行如下命令:bin/spark-shell

Spark 启动成功。

来实现第一个例子:

在spark shell 中依次输入如下命令:

val lines = sc.textFile("README.md")

lines.count()

lines.first()需要说明的是每输入一行,回车后,都会有对应的日志出现。README.md是在/apphome/spark-1.6.1-bin-hadoop2.6 目录下面的。

截图如下:

第一行是加载README.md文件到spark中。

第二行是统计README.md文件的行数。

第三行是返回README.md文件的第一行。

到此,入门实例结束。很简单吧~

相关文章推荐

- Spark RDD API详解(一) Map和Reduce

- 使用spark和spark mllib进行股票预测

- Spark随谈——开发指南(译)

- Spark,一种快速数据分析替代方案

- eclipse 开发 spark Streaming wordCount

- Understanding Spark Caching

- ClassNotFoundException:scala.PreDef$

- Windows 下Spark 快速搭建Spark源码阅读环境

- Spark中将对象序列化存储到hdfs

- 使用java代码提交Spark的hive sql任务,run as java application

- Spark机器学习(一) -- Machine Learning Library (MLlib)

- Spark机器学习(二) 局部向量 Local-- Data Types - MLlib

- Spark机器学习(三) Labeled point-- Data Types

- Spark初探

- Spark Streaming初探

- Spark本地开发环境搭建

- 搭建hadoop/spark集群环境

- Spark HA部署方案

- Spark HA原理架构图

- spark内存概述