使用Ceph作为OpenStack的后端存储

2016-04-16 16:09

585 查看

概述

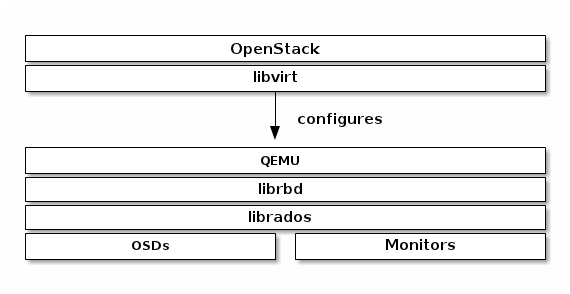

libvirt配置了librbd的QEMU接口,通过它可以在OpenStack中使用Ceph块存储。Ceph块存储是集群对象,这意味着它比独立的服务器有更好的性能。

在OpenStack中使用Ceph块设备,必须首先安装QEMU,libvirt和OpenStack,下图描述了 OpenStack和Ceph技术层次结构:

/article/3537570.html 我翻译的官方文档,仅供参考 ^

^。

系统规划

OpenStack集群:

控制节点:openstack(controller)192.168.1.131

计算节点:compute

192.168.1.132

存储节点:storage

192.168.1.133

Ceph集群:monitor、mds、osd0 节点:openstack(controller)192.168.1.131

osd1:compute 192.168.1.132

osd2:storage 192.168.1.133

系统架构:

配置过程

Important:由于这里将两套集群服务部署在了同一组节点上,所以配置过程中省略了一些关于Ceph集群的配置。创建存储池

?

在OpenStack节点执行如下命令:

?

?

在nova-compute节点创建一个临时的密钥副本:

?

编辑 /etc/glance/glance-api.conf并添加如下内容:

?

?

配置Cinder

在openstack节点和storage节点编辑 /etc/cinder/cinder.conf配置文件并添加如下内容:?

?

为了挂载Cinder设备(普通设备或可引导卷),必须指明使用的用户及UUID。libvirt将使用期在Ceph集群中进行连接和验证:

?

?

在每个计算节点,编辑 /etc/nova/nova.conf 在 [libvirt] 标签添加:

?

?

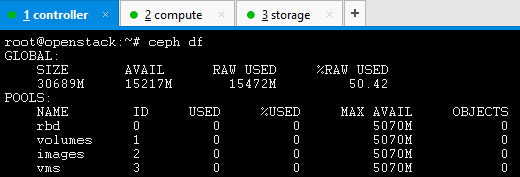

Ceph后端存储状况:

Ceph不支持从qcow2格式的镜像引导,所以创建一个raw格式的镜像:

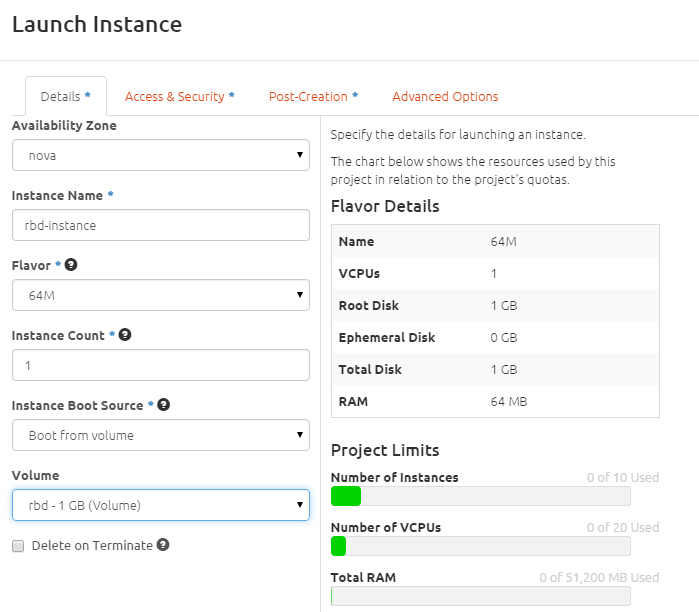

创建一个可引导卷:

从可引导卷创建一个实例:

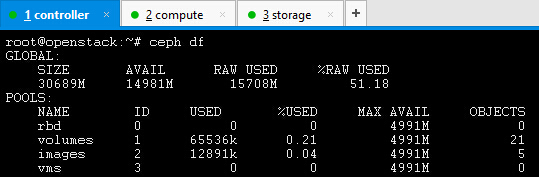

查看Ceph存储状况:

相关文章推荐

- operator =注意事项

- linux mysql 忘记密码怎么办

- Linux3个time的比较与inode

- 基于Nginx1.9+LuaJIT+Kafka的点播监控系统实战(上海卓越智慧树网点播监控系统)

- LINUX 下查看GPU信息

- 处理tomcat不必要的日志

- 声明!!!!!

- 动态库的使用方法

- 高可用性dataguard搭建和日常维护工作

- Linux服务管理

- nginx 一二事(1) - 简单图片服务器解决方案

- linux之学习live555视频笔记

- 理解 Linux 的硬链接与软链接

- Linux 顶层目录结构

- JAVA技术开发规范(3)——JASMP平台技术架构

- 每天一个linux命令(5):rmdir

- squid 代理服务

- Linux(妙算)串口通信

- web服务器搭建之ngrok篇

- nginx 父子进程通信 channel