SPARK入门-下载与运行

2016-02-18 00:00

148 查看

摘要: 今天开始学习SPARK, 记录一下在运行spark时候遇到的问题。

spark下载

地址:http://spark.apache.org/downloads.html

其中package type选项我选的是Pre-built for Hadoop 2.4 and later

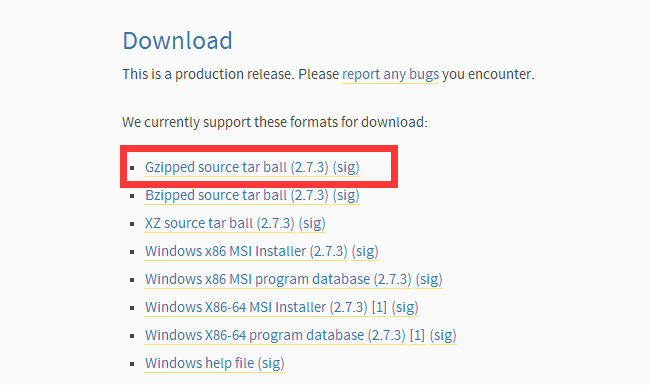

下载点击如下图中的红框链接,下载下来以后直接解压即可

运行准备--jdk和python

我用的是红帽5.4系统,jdk1.6,python2.4,结果就悲剧了,启动显示报“无法找到主类”的错误,这是因为jdk版本低

后又报python语法错误,python的版本也低。

所以更新了jdk到1.7,python更新到2.7 就ok了,我在官网下的jdk后缀是gz,手动改成tar.gz就可以正常解压了

这里说一下python更新版本的方法:

首先下载python安装包,地址如下:

https://www.python.org/download/releases/2.7.3/

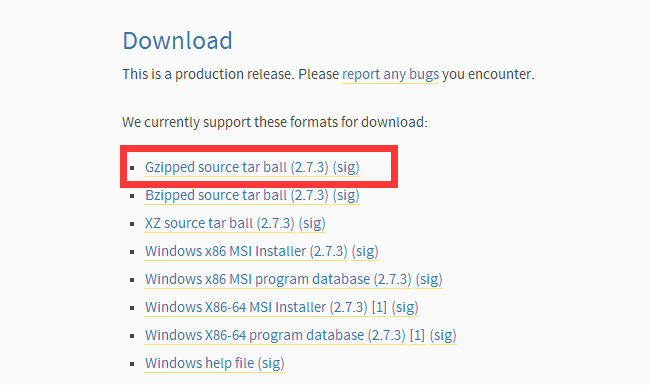

选择红框内连接进行下载:

下载后,先解压,然后按照如下步骤操作:

1) 创建一个新路径:mkdir /usr/local/python27

2 ) 进入你的解压目录(我直接解压到了python27),也就是在python27目录下:cd Python-2.7.3

3 )依次执行如下命令:

./configure --prefix=/usr/local/python27

make

make install

4) 此时没有覆盖老版本,再将原来/usr/bin/python链接改为别的名字

mv /usr/bin/python /usr/bin/python_old

ln -s /usr/local/python27/bin/python2 /usr/bin/python

5) ok,输入python,回车,会发现python的版本已经是2.7.3

启动spark

进入spark安装目录下的bin目录执行:./pyspark (这是用python方式,还可以用scala),经过一番折腾,终于看到那个“spark”图形了

spark下载

地址:http://spark.apache.org/downloads.html

其中package type选项我选的是Pre-built for Hadoop 2.4 and later

下载点击如下图中的红框链接,下载下来以后直接解压即可

运行准备--jdk和python

我用的是红帽5.4系统,jdk1.6,python2.4,结果就悲剧了,启动显示报“无法找到主类”的错误,这是因为jdk版本低

后又报python语法错误,python的版本也低。

所以更新了jdk到1.7,python更新到2.7 就ok了,我在官网下的jdk后缀是gz,手动改成tar.gz就可以正常解压了

这里说一下python更新版本的方法:

首先下载python安装包,地址如下:

https://www.python.org/download/releases/2.7.3/

选择红框内连接进行下载:

下载后,先解压,然后按照如下步骤操作:

1) 创建一个新路径:mkdir /usr/local/python27

2 ) 进入你的解压目录(我直接解压到了python27),也就是在python27目录下:cd Python-2.7.3

3 )依次执行如下命令:

./configure --prefix=/usr/local/python27

make

make install

4) 此时没有覆盖老版本,再将原来/usr/bin/python链接改为别的名字

mv /usr/bin/python /usr/bin/python_old

ln -s /usr/local/python27/bin/python2 /usr/bin/python

5) ok,输入python,回车,会发现python的版本已经是2.7.3

启动spark

进入spark安装目录下的bin目录执行:./pyspark (这是用python方式,还可以用scala),经过一番折腾,终于看到那个“spark”图形了

相关文章推荐

- Spark RDD API详解(一) Map和Reduce

- 使用spark和spark mllib进行股票预测

- Spark随谈——开发指南(译)

- Spark,一种快速数据分析替代方案

- eclipse 开发 spark Streaming wordCount

- Understanding Spark Caching

- ClassNotFoundException:scala.PreDef$

- Windows 下Spark 快速搭建Spark源码阅读环境

- Spark中将对象序列化存储到hdfs

- Spark初探

- Spark Streaming初探

- Spark本地开发环境搭建

- 搭建hadoop/spark集群环境

- spark内存概述

- Spark Shuffle之Hash Shuffle

- Spark Shuffle之Sort Shuffle

- Spark Shuffle之Tungsten Sort Shuffle

- 编译Spark 1.5.2

- 问题记录:[Ambari]

- 整合Kafka到Spark Streaming——代码示例和挑战