python利用cookie登录网站进行访问

2014-12-19 13:46

465 查看

在写爬虫的时候遇到需要登录才能访问的网站往往很令人头疼,伪装成浏览器访问神马的也许又会遇到网站采取的加密措施,不胜麻烦!然而,如果换一种思路,先用浏览器登录你想访问的网站,再在浏览器的控制台里找到该网站的cookie,然后利用这个cookie进行带cookie的访问,无疑是短时间内解决此问题的好办法。但是我们都知道cookie的有效期并不长,所以可能第二天你就必须重新查看新的cookie。

下面以登录豆瓣为例。。。

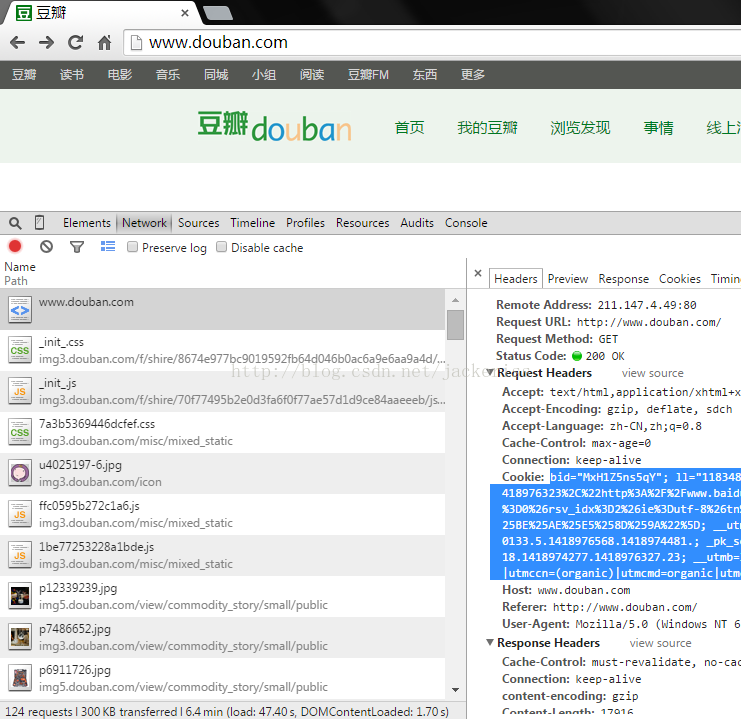

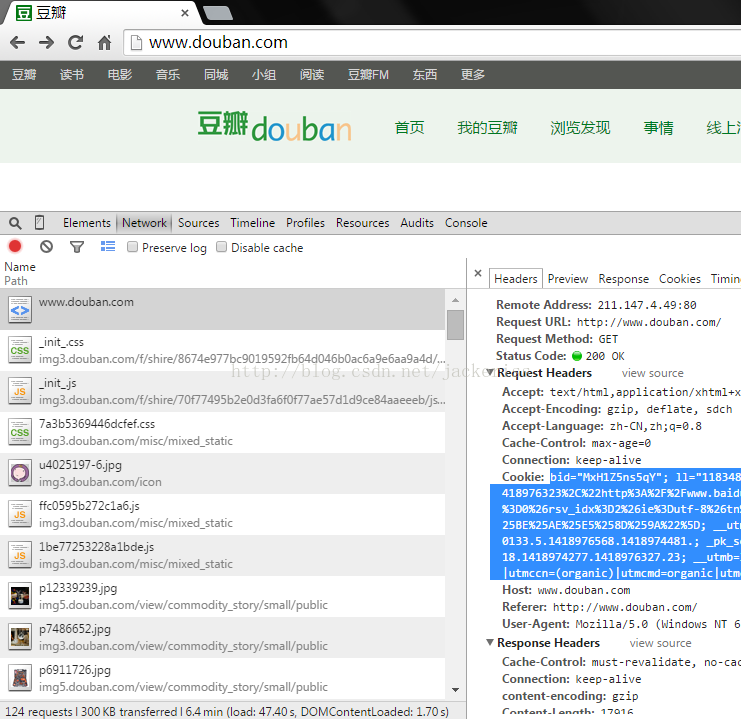

关于cookie怎么查看,请看下图:

首先登录豆瓣首页,然后按F12调出浏览器的控制台,点击Network这一项。这时候你按F5刷新一下页面,就会发现有好多东西在传来传去的。到最上面找到www.douban.com这一项,会发现里面就有cookie这一项(就是蓝色的我选中的部分,这些信息有些是隐私,绝对不能泄露),将这些复制到你的程序中即可。(我使用的是Chrome浏览器,其他浏览器查看cookie的方式可能都大同小异)

下面以登录豆瓣为例。。。

#coding=gbk

import urllib2

HEADERS = {"cookie": ''}#里面写你在www.douban.com的cookie

url = 'http://www.douban.com/'

req = urllib2.Request(url, headers=HEADERS)

text = urllib2.urlopen(req).read()

if "首页设置".decode("gbk").encode("utf8") in text and "说句话".decode("gbk").encode("utf8") in text:

print "登陆成功!"

else:

print "登录失败!"关于cookie怎么查看,请看下图:

首先登录豆瓣首页,然后按F12调出浏览器的控制台,点击Network这一项。这时候你按F5刷新一下页面,就会发现有好多东西在传来传去的。到最上面找到www.douban.com这一项,会发现里面就有cookie这一项(就是蓝色的我选中的部分,这些信息有些是隐私,绝对不能泄露),将这些复制到你的程序中即可。(我使用的是Chrome浏览器,其他浏览器查看cookie的方式可能都大同小异)

相关文章推荐

- python利用cookie登录网站进行访问

- python以post方式登录csdn网站,并以cookie方式访问个人信息

- python 利用浏览器 Cookie 模拟登录的用户访问知乎

- [python 爬虫学习]利用cookie模拟网站登录

- python爬虫笔记之用cookie访问需要登录的网站

- python 利用selenium模拟登录帐号验证网站并获取cookie

- python 利用selenium模拟登录帐号验证网站并获取cookie

- 利用Cookie自动登录别人的网站

- Python 自动登录网站(处理Cookie)

- servlet之利用cookie进行自动登录

- Python手动构造Cookie模拟登录后获取网站页面内容

- 利用DefaultHttpClient实现代理访问,和登录CAS并且写cookie

- selenium之python自动化测试系列:使用chrome或firefox的已存在的cookie访问网站

- [python和大数据-1]利用爬虫登录知乎进行BFS搜索抓取用户信息本地mysql分析【PART1】

- 模拟用户登录保存cookie,利用cookie访问

- 关于通过Cookie进行网站自动登录的安全问题

- 利用python并发模块进行网站的状态检测

- Python 自动登录网站(处理Cookie)

- 安卓课程表(解决利用Httpclient登录获得cookie继续访问但网页仍提示无权限请登录的问题)

- python模拟登录微博网站利用urllib2 和 cookie