【Spark亚太研究院系列丛书】Spark实战高手之路-第一章 构建Spark集群(第五步)(3)

2014-10-10 10:03

357 查看

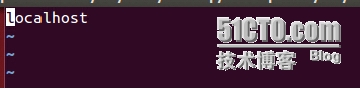

第四步修改配置文件slaves,如下所示:

我们设置Hadoop集群中的从节点为SparkWorker1和SparkWorker2,把slaves文件的内容修改为:

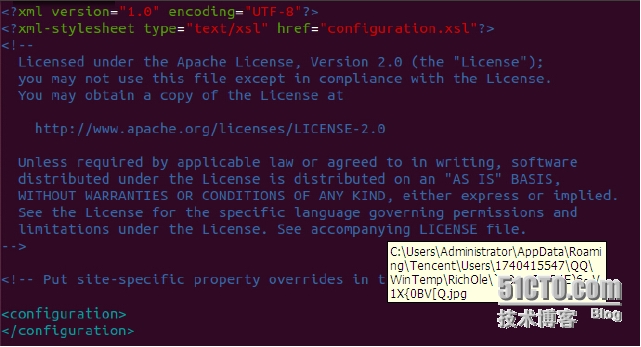

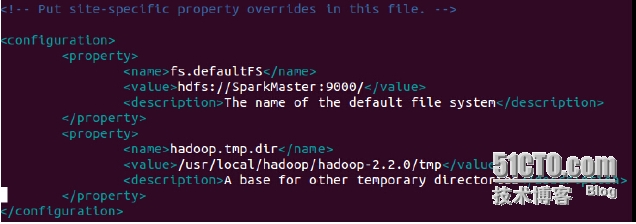

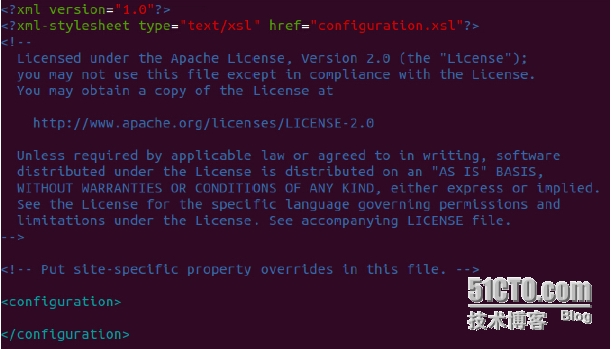

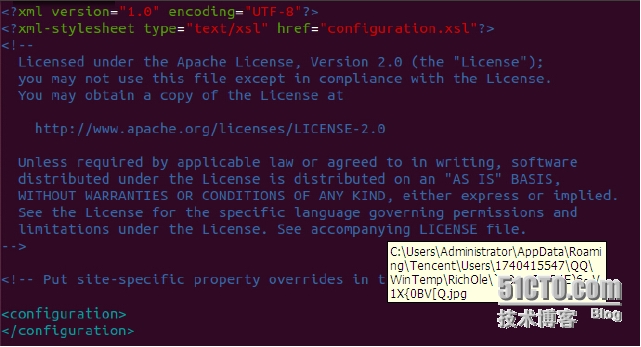

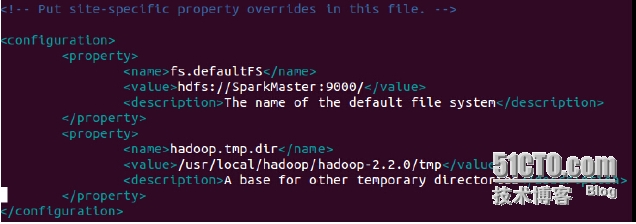

第五步修改配置文件core-site.xml,如下所示:

把core-site.xml文件的内容修改为:

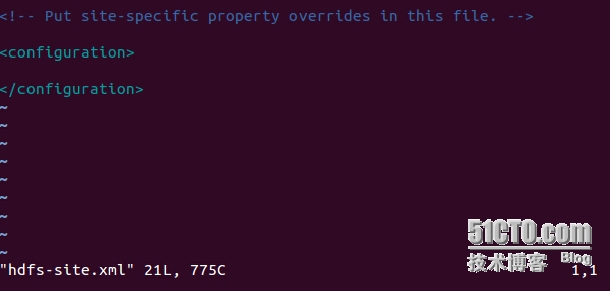

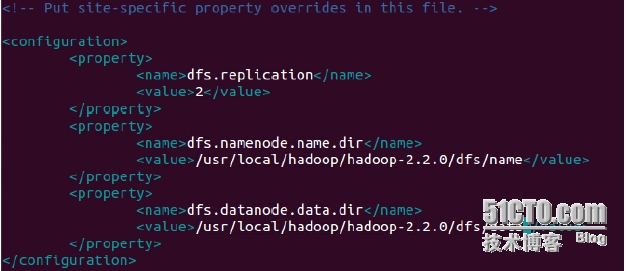

上述是core-site.xml文件的最小化配置,core-site.xml各项配置可参考:http://hadoop.apache.org/docs/r2.2.0/hadoop-project-dist/hadoop-hdfs/hdfs-default.xml第六步修改配置文件hdfs-site.xml,如下所示:

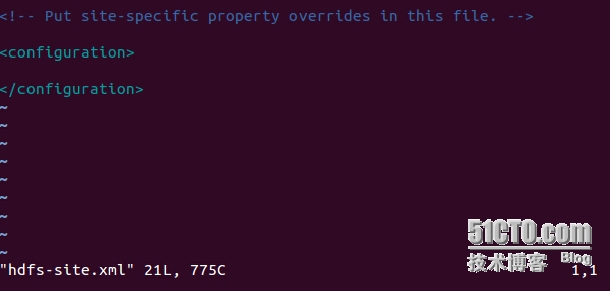

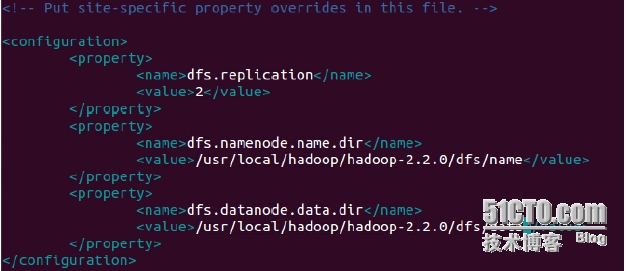

把hdfs-site.xml文件的内容修改为:

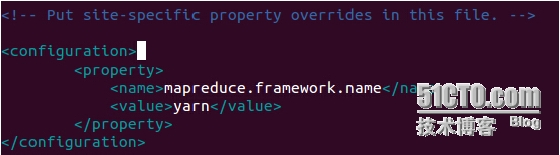

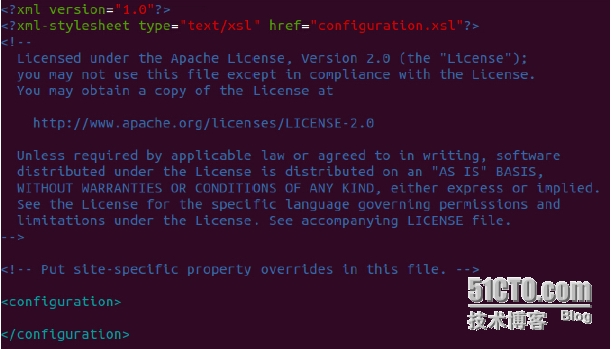

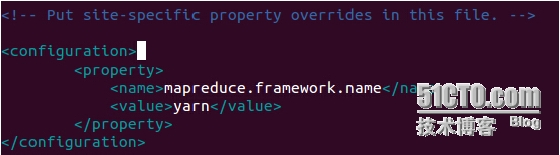

上述是hdfs-site.xml文件的最小化配置,hdfs-site.xml各项配置课参考:http://hadoop.apache.org/docs/r2.2.0/hadoop-project-dist/hadoop-hdfs/hdfs-default.xml第七步修改配置文件mapred-site.xml,如下所示:拷贝一份mapred-site.xml.template命名为mapred-site.xml,打开mapred-site.xml

把mapred-site.xml文件的内容修改为:

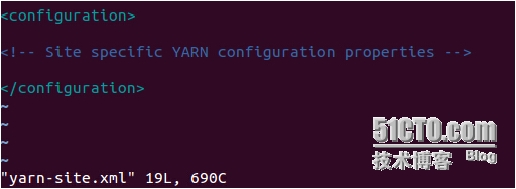

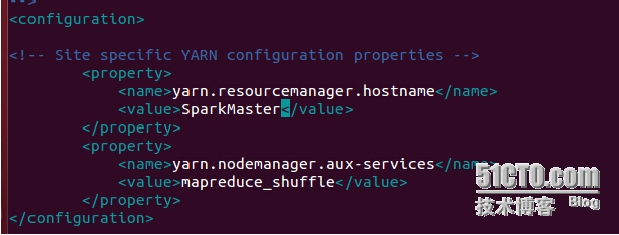

上述是mapred-site.xml最小化配置,mapred-site.xml各项配置可参考:http://hadoop.apache.org/docs/r2.2.0/hadoop-mapreduce-client/hadoop-mapreduce-client-core/mapred-default.xml第七步修改配置文件yarn-site.xml,如下所示:

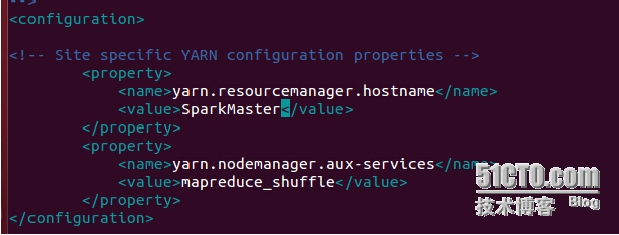

把yarn-site.xml的内容修改为:

上述内容是yarn-site.xml的最小化配置,yarn-site.xml文件配置的各项内容可以参考:http://hadoop.apache.org/docs/r2.2.0/hadoop-yarn/hadoop-yarn-common/yarn-default.xml

本文出自 “Spark亚太研究院” 博客,请务必保留此出处http://rockyspark.blog.51cto.com/2229525/1561969

我们设置Hadoop集群中的从节点为SparkWorker1和SparkWorker2,把slaves文件的内容修改为:

第五步修改配置文件core-site.xml,如下所示:

把core-site.xml文件的内容修改为:

上述是core-site.xml文件的最小化配置,core-site.xml各项配置可参考:http://hadoop.apache.org/docs/r2.2.0/hadoop-project-dist/hadoop-hdfs/hdfs-default.xml第六步修改配置文件hdfs-site.xml,如下所示:

把hdfs-site.xml文件的内容修改为:

上述是hdfs-site.xml文件的最小化配置,hdfs-site.xml各项配置课参考:http://hadoop.apache.org/docs/r2.2.0/hadoop-project-dist/hadoop-hdfs/hdfs-default.xml第七步修改配置文件mapred-site.xml,如下所示:拷贝一份mapred-site.xml.template命名为mapred-site.xml,打开mapred-site.xml

把mapred-site.xml文件的内容修改为:

上述是mapred-site.xml最小化配置,mapred-site.xml各项配置可参考:http://hadoop.apache.org/docs/r2.2.0/hadoop-mapreduce-client/hadoop-mapreduce-client-core/mapred-default.xml第七步修改配置文件yarn-site.xml,如下所示:

把yarn-site.xml的内容修改为:

上述内容是yarn-site.xml的最小化配置,yarn-site.xml文件配置的各项内容可以参考:http://hadoop.apache.org/docs/r2.2.0/hadoop-yarn/hadoop-yarn-common/yarn-default.xml

本文出自 “Spark亚太研究院” 博客,请务必保留此出处http://rockyspark.blog.51cto.com/2229525/1561969

相关文章推荐

- 【Spark亚太研究院系列丛书】Spark实战高手之路-第一章 构建Spark集群(第五步)(4)

- 【Spark亚太研究院系列丛书】Spark实战高手之路-第一章 构建Spark集群(第五步)(5)

- 【Spark亚太研究院系列丛书】Spark实战高手之路-第一章 构建Spark集群(第五步)(10)

- 【Spark亚太研究院系列丛书】Spark实战高手之路-第一章 构建Spark集群(第五步)(1)

- 【Spark亚太研究院系列丛书】Spark实战高手之路-第一章 构建Spark集群(第五步)(4)

- 【Spark亚太研究院系列丛书】Spark实战高手之路-第一章 构建Spark集群(第五步)(11)

- 【Spark亚太研究院系列丛书】Spark实战高手之路-第一章 构建Spark集群(第五步)(13)

- 【Spark亚太研究院系列丛书】Spark实战高手之路-第一章 构建Spark集群(第五步)(11)

- 【Spark亚太研究院系列丛书】Spark实战高手之路-第一章 构建Spark集群(第五步)(8)

- 【Spark亚太研究院系列丛书】Spark实战高手之路-第一章 构建Spark集群(第五步)(2)

- 【Spark亚太研究院系列丛书】Spark实战高手之路-第一章 构建Spark集群(第五步)(2)

- 【Spark亚太研究院系列丛书】Spark实战高手之路-第一章 构建Spark集群(第五步)(8)

- 【Spark亚太研究院系列丛书】Spark实战高手之路-第一章 构建Spark集群(第五步)(9)

- 【Spark亚太研究院系列丛书】Spark实战高手之路-第一章 构建Spark集群(第五步)(3)

- 【Spark亚太研究院系列丛书】Spark实战高手之路-第一章 构建Spark集群(第五步)(5)

- 【Spark亚太研究院系列丛书】Spark实战高手之路-第一章 构建Spark集群(第五步)(7)

- 【Spark亚太研究院系列丛书】Spark实战高手之路-第一章 构建Spark集群(第五步)(4)

- 【Spark亚太研究院系列丛书】Spark实战高手之路-第一章 构建Spark集群(第五步)(12)

- 【Spark亚太研究院系列丛书】Spark实战高手之路-第一章 构建Spark集群(第五步)(1)

- 【Spark亚太研究院系列丛书】Spark实战高手之路-第一章 构建Spark集群(第五步)(12)