LINUX下多路径(multi-path)介绍及使用

2011-01-11 00:52

991 查看

一、什么是多路径 普通的电脑主机都是一个硬盘挂接到一个总线上,这里是一对一的关系。而到了有光纤组成的SAN环境,或者由iSCSI组成的IPSAN环境,由于主机和存储通过了光纤交换机或者多块网卡及IP来连接,这样的话,就构成了多对多的关系。也就是说,主机到存储可以有多条路径可以选择。主机到存储之间的IO由多条路径可以选择。每个主机到所对应的存储可以经过几条不同的路径,如果是同时使用的话,I/O流量如何分配?其中一条路径坏掉了,如何处理?还有在操作系统的角度来看,每条路径,操作系统会认为是一个实际存在的物理盘,但实际上只是通向同一个物理盘的不同路径而已,这样是在使用的时候,就给用户带来了困惑。多路径软件就是为了解决上面的问题应运而生的。 多路径的主要功能就是和存储设备一起配合实现如下功能:

1.故障的切换和恢复

2.IO流量的负载均衡

3.磁盘的虚拟化

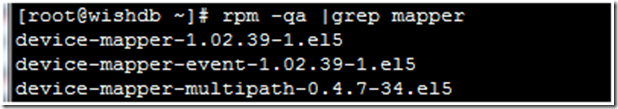

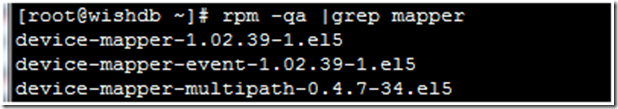

由于多路径软件是需要和存储在一起配合使用的,不同的厂商基于不同的操作系统,都提供了不同的版本。并且有的厂商,软件和硬件也不是一起卖的,如果要使用多路径软件的话,可能还需要向厂商购买license才行。比如EMC公司基于linux下的多路径软件,就需要单独的购买license。好在, RedHat和Suse的2.6的内核中都自带了免费的多路径软件包,并且可以免费使用,同时也是一个比较通用的包,可以支持大多数存储厂商的设备,即使是一些不是出名的厂商,通过对配置文件进行稍作修改,也是可以支持并运行的很好的。 二、Linux下multipath介绍,需要以下工具包: 在CentOS 5中,最小安装系统时multipath已经被安装,查看multipath是否安装如下:

1、device-mapper-multipath:即multipath-tools。主要提供multipathd和multipath等工具和 multipath.conf等配置文件。这些工具通过device mapper的ioctr的接口创建和配置multipath设备(调用device-mapper的用户空间库。创建的多路径设备会在/dev /mapper中)。

2、 device-mapper:主要包括两大部分:内核部分和用户部分。内核部分主要由device mapper核心(dm.ko)和一些target driver(md-multipath.ko)。核心完成设备的映射,而target根据映射关系和自身特点具体处理从mappered device 下来的i/o。同时,在核心部分,提供了一个接口,用户通过ioctr可和内核部分通信,以指导内核驱动的行为,比如如何创建mappered device,这些divece的属性等。linux device mapper的用户空间部分主要包括device-mapper这个包。其中包括dmsetup工具和一些帮助创建和配置mappered device的库。这些库主要抽象,封装了与ioctr通信的接口,以便方便创建和配置mappered device。multipath-tool的程序中就需要调用这些库。

3、dm-multipath.ko和dm.ko:dm.ko是device mapper驱动。它是实现multipath的基础。dm-multipath其实是dm的一个target驱动。

4、scsi_id: 包含在udev程序包中,可以在multipath.conf中配置该程序来获取scsi设备的序号。通过序号,便可以判断多个路径对应了同一设备。这个是多路径实现的关键。scsi_id是通过sg驱动,向设备发送EVPD page80或page83 的inquery命令来查询scsi设备的标识。但一些设备并不支持EVPD 的inquery命令,所以他们无法被用来生成multipath设备。但可以改写scsi_id,为不能提供scsi设备标识的设备虚拟一个标识符,并输出到标准输出。multipath程序在创建multipath设备时,会调用scsi_id,从其标准输出中获得该设备的scsi id。在改写时,需要修改scsi_id程序的返回值为0。因为在multipath程序中,会检查该直来确定scsi id是否已经成功得到。

三、multipath在CentOS 5中的基本配置过程:

1、安装和加载多路径软件包

# yum –y install device-mapper device-mapper-multipath # chkconfig –level 2345 multipathd on #设置成开机自启动multipathd # lsmod |grep dm_multipath #来检查安装是否正常

如果模块没有加载成功请使用下列命初始化DM,或重启系统

---Use the following commands to initialize and start DM for the first time:

# modprobe dm-multipath

# modprobe dm-round-robin

# service multipathd start

# multipath –v2

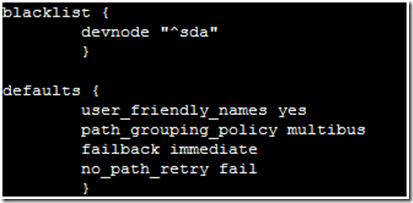

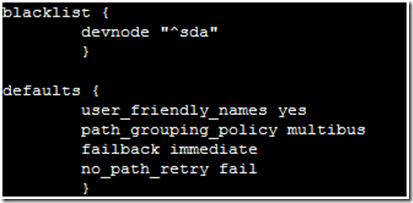

2、配置multipath: Multipath的配置文件是/etc/multipath.conf , 如需要multipath正常工作只需要如下配置即可:(如果需要更加详细的配置,请看本文后续的介绍) blacklist { devnode "^sda" } defaults { user_friendly_names yes path_grouping_policy multibus failback immediate no_path_retry fail } # vi /etc/multipath.conf

3、multipath基本操作命令

# /etc/init.d/multipathd start #开启mulitipath服务

# multipath -F #删除现有路径

# multipath -v2 #格式化路径

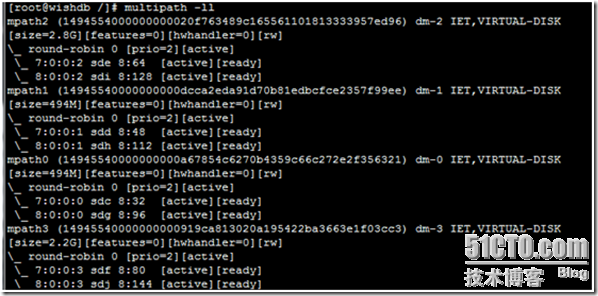

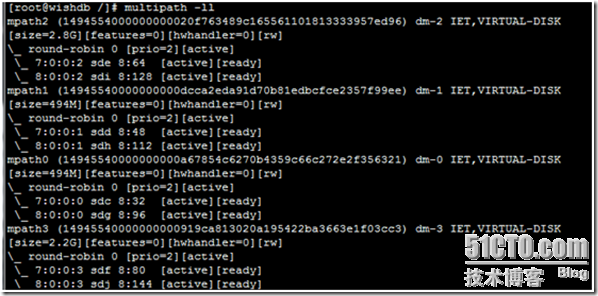

# multipath -ll #查看多路径

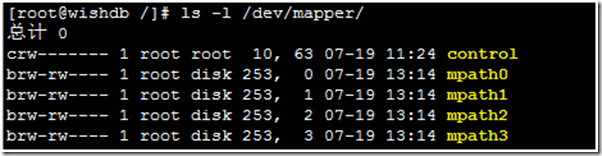

如果配置正确的话就会在/dev/mapper/目录下多出mpath0、mpath1等之类设备。

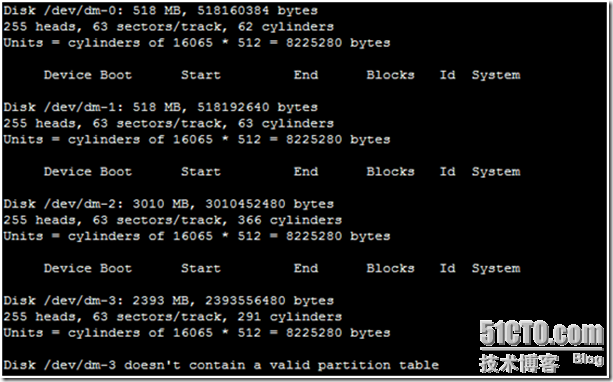

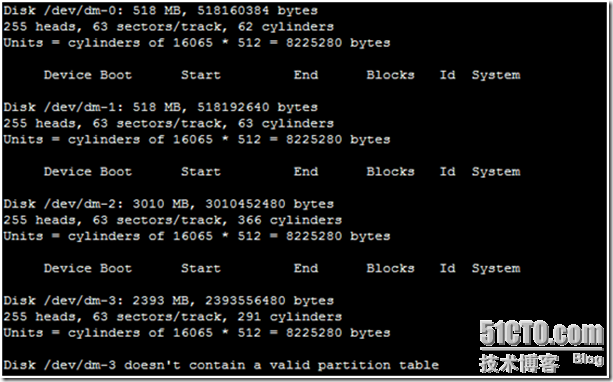

用fdisk -l命令可以看到多路径软件创建的磁盘,如下图中的/dev/dm-[0-3]

4、multipath磁盘的基本操作

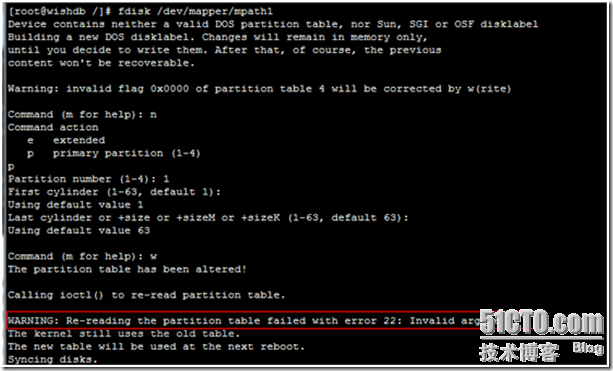

要对多路径软件生成的磁盘进行操作直接操作/dev/mapper/目录下的磁盘就行. 在对多路径软件生成的磁盘进行分区之前最好运行一下pvcreate命令: # pvcreate /dev/mapper/mpath0 # fdisk /dev/mapper/mpath0

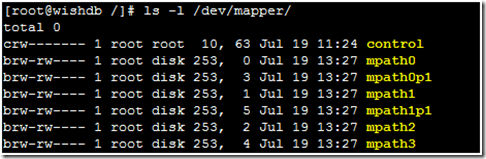

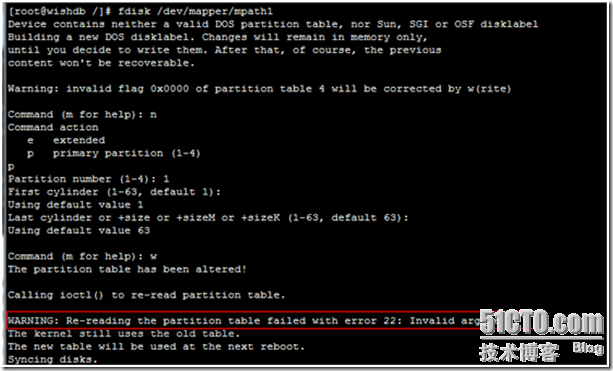

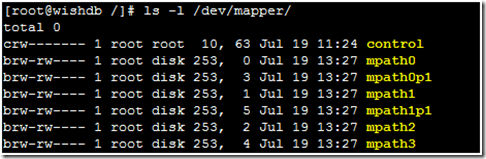

用fdisk对多路径软件生成的磁盘进行分区保存时会有一个报错,此报错不用理会。 fdisk对多路径软件生成的磁盘进行分区之后,所生成的磁盘分区并没有马上添加到/dev/目录下,此时我们要重启IPSAN或者FCSAN的驱动,如果是用iscsi-initiator来连接IPSAN的重启ISCSI服务就可以发现所生成的磁盘分区了 # service iscsi restart # ls -l /dev/mapper/

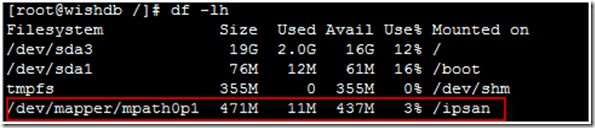

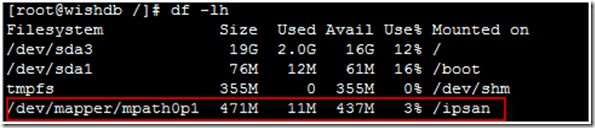

如上图中的mpath0p1和mpath1p1就是我们对multipath磁盘进行的分区 # mkfs.ext3 /dev/mapper/mpath0p1 #对mpath1p1分区格式化成ext3文件系统 # mount /dev/mapper/mpath0p1 /ipsan/ #挂载mpath1p1分区

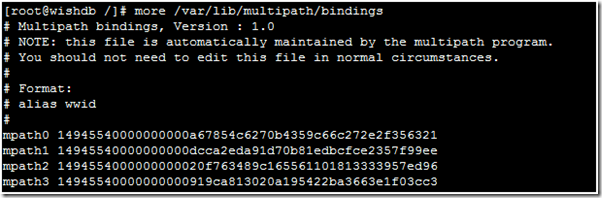

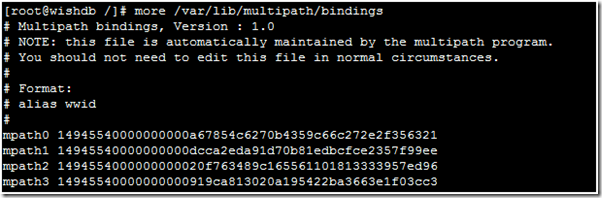

四、multipath的高有配置 以上都是用multipath的默认配置来完成multipath的配置,比如映射设备的名称,multipath负载均衡的方法都是默认设置。那有没有按照我们自己定义的方法来配置multipath呢,当可以。 1、multipath.conf文件的配置 接下来的工作就是要编辑/etc/multipath.conf的配置文件 multipath.conf主要包括blacklist、multipaths、devices三部份的配置 blacklist配置 blacklist { devnode "^sda" } Multipaths部分配置multipaths和devices两部份的配置。 multipaths { multipath { wwid **************** #此值multipath -v3可以看到 alias iscsi-dm0 #映射后的别名,可以随便取 path_grouping_policy multibus #路径组策略 path_checker tur #决定路径状态的方法 path_selector "round-robin 0" #选择那条路径进行下一个IO操作的方法 } } Devices部分配置 devices { device { vendor "iSCSI-Enterprise" #厂商名称 product "Virtual disk" #产品型号 path_grouping_policy multibus #默认的路径组策略 getuid_callout "/sbin/scsi_id -g -u -s /block/%n" #获得唯一设备号使用的默认程序 prio_callout "/sbin/acs_prio_alua %d" #获取有限级数值使用的默认程序 path_checker readsector0 #决定路径状态的方法 path_selector "round-robin 0" #选择那条路径进行下一个IO操作的方法 failback immediate #故障恢复的模式 no_path_retry queue #在disable queue之前系统尝试使用失效路径的次数的数值 rr_min_io 100 #在当前的用户组中,在切换到另外一条路径之前的IO请求的数目 } } 如下是一个完整的配置文件 blacklist { devnode "^sda" } defaults { user_friendly_names no } multipaths { multipath { wwid 14945540000000000a67854c6270b4359c66c272e2f356321 alias iscsi-dm0 path_grouping_policy multibus path_checker tur path_selector "round-robin 0" } multipath { wwid 14945540000000000dcca2eda91d70b81edbcfce2357f99ee alias iscsi-dm1 path_grouping_policy multibus path_checker tur path_selector "round-robin 0" } multipath { wwid 1494554000000000020f763489c165561101813333957ed96 alias iscsi-dm2 path_grouping_policy multibus path_checker tur path_selector "round-robin 0" } multipath { wwid 14945540000000000919ca813020a195422ba3663e1f03cc3 alias iscsi-dm3 path_grouping_policy multibus path_checker tur path_selector "round-robin 0" } } devices { device { vendor "iSCSI-Enterprise" product "Virtual disk" path_grouping_policy multibus getuid_callout "/sbin/scsi_id -g -u -s /block/%n" path_checker readsector0 path_selector "round-robin 0" } } 获取wwid的方法: (1)默认情况下,将使用 /var/lib/multipath/bindings 内的配置设定具体每个多路径设备名,如果在/etc/multipath.conf中有设定各wwid 别名,别名会覆盖此设定。

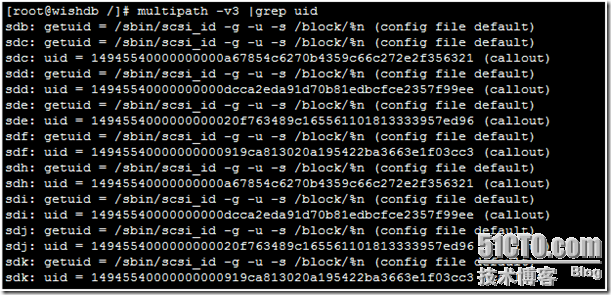

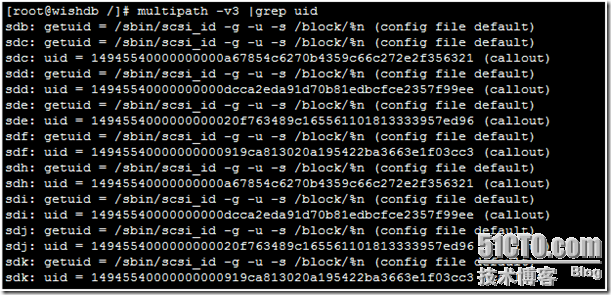

(2)# multipath -v3命令查找

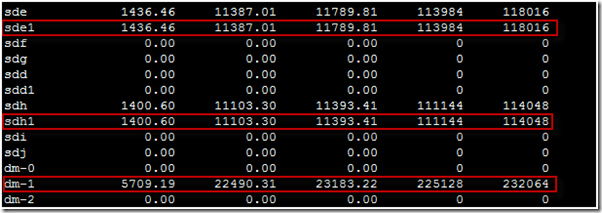

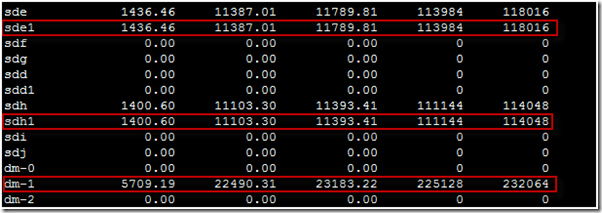

2、负载均衡测试 使用dd命令来对设备进行写操作,并同时通过iostat来查看I/0状态,命令及输出如下:

# dd if=/dev/zero of=/dev/mapper/iscsi-dm1p1

开启另外一个终端用以下命令查看IO情况 # iostat 10 10

通过上述输出,我们看到,在对/dev/mapper/iscsi-dm1p1读写时,实际上是通过对/dev/md-1包含的当前active的所有设备,即/dev/sde1,/dev/shl这2条路径来完成对实际的LUN的写过程。 3、路径切换测试 首先,我们拔掉服务器上一根网线,经过不到10秒,我们看到:MPIO成功地从上述“失败”的路径/dev/sel切换到了另外一条路径/dev/sdh1上。本文出自 “王者之根” 博客,请务必保留此出处http://rootking.blog.51cto.com/2619611/476212

1.故障的切换和恢复

2.IO流量的负载均衡

3.磁盘的虚拟化

由于多路径软件是需要和存储在一起配合使用的,不同的厂商基于不同的操作系统,都提供了不同的版本。并且有的厂商,软件和硬件也不是一起卖的,如果要使用多路径软件的话,可能还需要向厂商购买license才行。比如EMC公司基于linux下的多路径软件,就需要单独的购买license。好在, RedHat和Suse的2.6的内核中都自带了免费的多路径软件包,并且可以免费使用,同时也是一个比较通用的包,可以支持大多数存储厂商的设备,即使是一些不是出名的厂商,通过对配置文件进行稍作修改,也是可以支持并运行的很好的。 二、Linux下multipath介绍,需要以下工具包: 在CentOS 5中,最小安装系统时multipath已经被安装,查看multipath是否安装如下:

1、device-mapper-multipath:即multipath-tools。主要提供multipathd和multipath等工具和 multipath.conf等配置文件。这些工具通过device mapper的ioctr的接口创建和配置multipath设备(调用device-mapper的用户空间库。创建的多路径设备会在/dev /mapper中)。

2、 device-mapper:主要包括两大部分:内核部分和用户部分。内核部分主要由device mapper核心(dm.ko)和一些target driver(md-multipath.ko)。核心完成设备的映射,而target根据映射关系和自身特点具体处理从mappered device 下来的i/o。同时,在核心部分,提供了一个接口,用户通过ioctr可和内核部分通信,以指导内核驱动的行为,比如如何创建mappered device,这些divece的属性等。linux device mapper的用户空间部分主要包括device-mapper这个包。其中包括dmsetup工具和一些帮助创建和配置mappered device的库。这些库主要抽象,封装了与ioctr通信的接口,以便方便创建和配置mappered device。multipath-tool的程序中就需要调用这些库。

3、dm-multipath.ko和dm.ko:dm.ko是device mapper驱动。它是实现multipath的基础。dm-multipath其实是dm的一个target驱动。

4、scsi_id: 包含在udev程序包中,可以在multipath.conf中配置该程序来获取scsi设备的序号。通过序号,便可以判断多个路径对应了同一设备。这个是多路径实现的关键。scsi_id是通过sg驱动,向设备发送EVPD page80或page83 的inquery命令来查询scsi设备的标识。但一些设备并不支持EVPD 的inquery命令,所以他们无法被用来生成multipath设备。但可以改写scsi_id,为不能提供scsi设备标识的设备虚拟一个标识符,并输出到标准输出。multipath程序在创建multipath设备时,会调用scsi_id,从其标准输出中获得该设备的scsi id。在改写时,需要修改scsi_id程序的返回值为0。因为在multipath程序中,会检查该直来确定scsi id是否已经成功得到。

三、multipath在CentOS 5中的基本配置过程:

1、安装和加载多路径软件包

# yum –y install device-mapper device-mapper-multipath # chkconfig –level 2345 multipathd on #设置成开机自启动multipathd # lsmod |grep dm_multipath #来检查安装是否正常

如果模块没有加载成功请使用下列命初始化DM,或重启系统

---Use the following commands to initialize and start DM for the first time:

# modprobe dm-multipath

# modprobe dm-round-robin

# service multipathd start

# multipath –v2

2、配置multipath: Multipath的配置文件是/etc/multipath.conf , 如需要multipath正常工作只需要如下配置即可:(如果需要更加详细的配置,请看本文后续的介绍) blacklist { devnode "^sda" } defaults { user_friendly_names yes path_grouping_policy multibus failback immediate no_path_retry fail } # vi /etc/multipath.conf

3、multipath基本操作命令

# /etc/init.d/multipathd start #开启mulitipath服务

# multipath -F #删除现有路径

# multipath -v2 #格式化路径

# multipath -ll #查看多路径

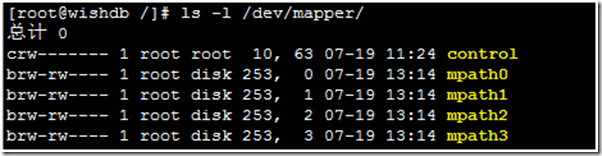

如果配置正确的话就会在/dev/mapper/目录下多出mpath0、mpath1等之类设备。

用fdisk -l命令可以看到多路径软件创建的磁盘,如下图中的/dev/dm-[0-3]

4、multipath磁盘的基本操作

要对多路径软件生成的磁盘进行操作直接操作/dev/mapper/目录下的磁盘就行. 在对多路径软件生成的磁盘进行分区之前最好运行一下pvcreate命令: # pvcreate /dev/mapper/mpath0 # fdisk /dev/mapper/mpath0

用fdisk对多路径软件生成的磁盘进行分区保存时会有一个报错,此报错不用理会。 fdisk对多路径软件生成的磁盘进行分区之后,所生成的磁盘分区并没有马上添加到/dev/目录下,此时我们要重启IPSAN或者FCSAN的驱动,如果是用iscsi-initiator来连接IPSAN的重启ISCSI服务就可以发现所生成的磁盘分区了 # service iscsi restart # ls -l /dev/mapper/

如上图中的mpath0p1和mpath1p1就是我们对multipath磁盘进行的分区 # mkfs.ext3 /dev/mapper/mpath0p1 #对mpath1p1分区格式化成ext3文件系统 # mount /dev/mapper/mpath0p1 /ipsan/ #挂载mpath1p1分区

四、multipath的高有配置 以上都是用multipath的默认配置来完成multipath的配置,比如映射设备的名称,multipath负载均衡的方法都是默认设置。那有没有按照我们自己定义的方法来配置multipath呢,当可以。 1、multipath.conf文件的配置 接下来的工作就是要编辑/etc/multipath.conf的配置文件 multipath.conf主要包括blacklist、multipaths、devices三部份的配置 blacklist配置 blacklist { devnode "^sda" } Multipaths部分配置multipaths和devices两部份的配置。 multipaths { multipath { wwid **************** #此值multipath -v3可以看到 alias iscsi-dm0 #映射后的别名,可以随便取 path_grouping_policy multibus #路径组策略 path_checker tur #决定路径状态的方法 path_selector "round-robin 0" #选择那条路径进行下一个IO操作的方法 } } Devices部分配置 devices { device { vendor "iSCSI-Enterprise" #厂商名称 product "Virtual disk" #产品型号 path_grouping_policy multibus #默认的路径组策略 getuid_callout "/sbin/scsi_id -g -u -s /block/%n" #获得唯一设备号使用的默认程序 prio_callout "/sbin/acs_prio_alua %d" #获取有限级数值使用的默认程序 path_checker readsector0 #决定路径状态的方法 path_selector "round-robin 0" #选择那条路径进行下一个IO操作的方法 failback immediate #故障恢复的模式 no_path_retry queue #在disable queue之前系统尝试使用失效路径的次数的数值 rr_min_io 100 #在当前的用户组中,在切换到另外一条路径之前的IO请求的数目 } } 如下是一个完整的配置文件 blacklist { devnode "^sda" } defaults { user_friendly_names no } multipaths { multipath { wwid 14945540000000000a67854c6270b4359c66c272e2f356321 alias iscsi-dm0 path_grouping_policy multibus path_checker tur path_selector "round-robin 0" } multipath { wwid 14945540000000000dcca2eda91d70b81edbcfce2357f99ee alias iscsi-dm1 path_grouping_policy multibus path_checker tur path_selector "round-robin 0" } multipath { wwid 1494554000000000020f763489c165561101813333957ed96 alias iscsi-dm2 path_grouping_policy multibus path_checker tur path_selector "round-robin 0" } multipath { wwid 14945540000000000919ca813020a195422ba3663e1f03cc3 alias iscsi-dm3 path_grouping_policy multibus path_checker tur path_selector "round-robin 0" } } devices { device { vendor "iSCSI-Enterprise" product "Virtual disk" path_grouping_policy multibus getuid_callout "/sbin/scsi_id -g -u -s /block/%n" path_checker readsector0 path_selector "round-robin 0" } } 获取wwid的方法: (1)默认情况下,将使用 /var/lib/multipath/bindings 内的配置设定具体每个多路径设备名,如果在/etc/multipath.conf中有设定各wwid 别名,别名会覆盖此设定。

(2)# multipath -v3命令查找

2、负载均衡测试 使用dd命令来对设备进行写操作,并同时通过iostat来查看I/0状态,命令及输出如下:

# dd if=/dev/zero of=/dev/mapper/iscsi-dm1p1

开启另外一个终端用以下命令查看IO情况 # iostat 10 10

通过上述输出,我们看到,在对/dev/mapper/iscsi-dm1p1读写时,实际上是通过对/dev/md-1包含的当前active的所有设备,即/dev/sde1,/dev/shl这2条路径来完成对实际的LUN的写过程。 3、路径切换测试 首先,我们拔掉服务器上一根网线,经过不到10秒,我们看到:MPIO成功地从上述“失败”的路径/dev/sel切换到了另外一条路径/dev/sdh1上。本文出自 “王者之根” 博客,请务必保留此出处http://rootking.blog.51cto.com/2619611/476212

相关文章推荐

- LINUX下多路径(multi-path)介绍及使用

- LINUX下多路径(multi-path)介绍及使用

- LINUX下多路径(multi-path)介绍及使用

- LINUX下多路径(multi-path)介绍及使用

- LINUX下多路径(multi-path)介绍及使用

- LINUX下多路径(multi-path)介绍及使用 【转载】

- ceph存储 LINUX下多路径(multi-path)介绍及使用

- LINUX下多路径(multi-path)介绍及使用

- LINUX下多路径(multi-path)介绍及使用

- LINUX下多路径(multi-path)介绍及使用

- LINUX下多路径(multi-path)介绍及使用

- LINUX下多路径(multi-path)介绍及使用

- LINUX下多路径(multi-path)介绍及使用

- LINUX下多路径(multi-path)介绍及使用

- LINUX下多路径(multi-path)介绍及使用

- LINUX下多路径(multi-path)介绍及使用

- LINUX下多路径(multi-path)介绍及使用

- LINUX下多路径(multi-path)介绍及使用

- 多路径(multi-path)介绍及使用 (hp刀片机适用)

- Linux多路径的使用及介绍