Python | 其实爬虫也有套路(附赠书获奖名单)

2021-01-03 20:34

447 查看

写在前面

咸鱼的第二次自费赠书活动已经完美落幕,谢谢大家的支持。

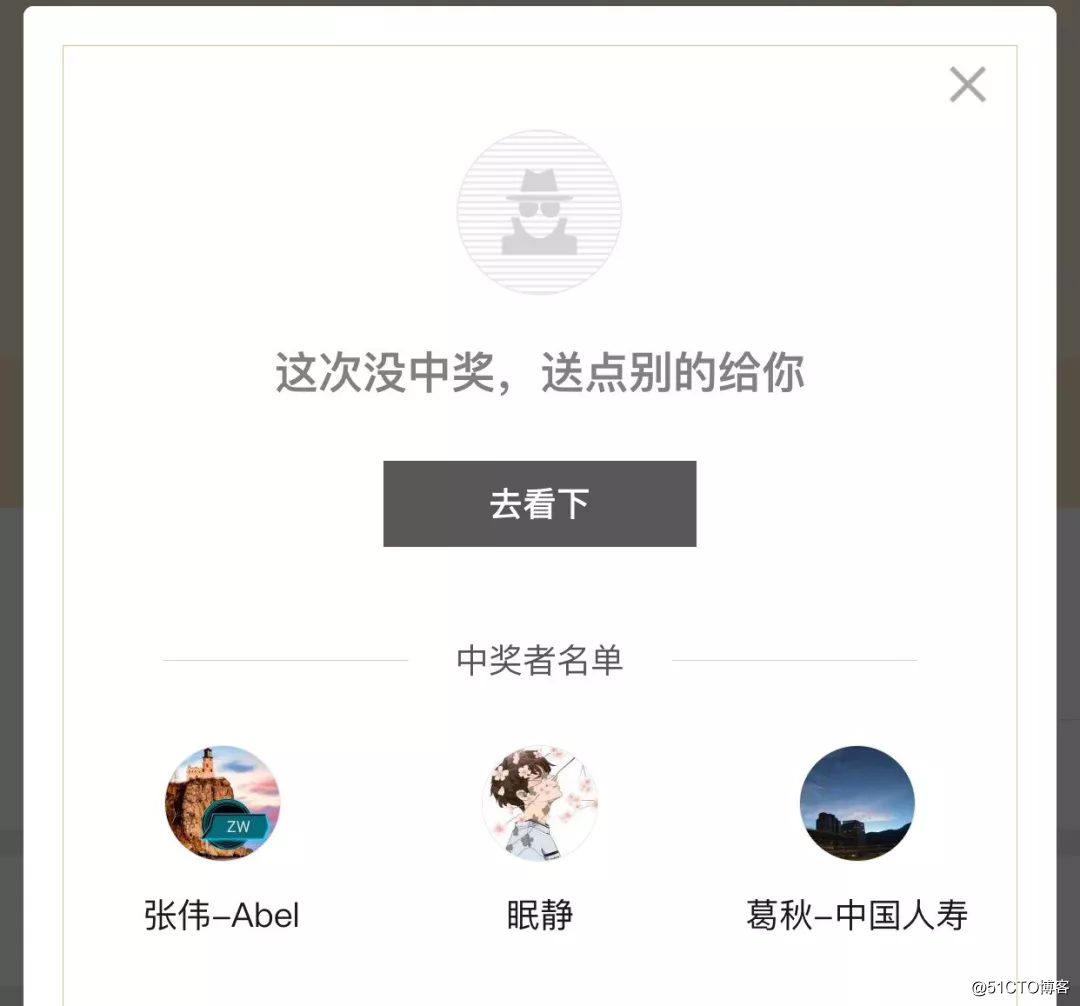

本次获奖的幸运儿是:

请以上三位朋友在72小时内联系我选书,逾期没有联系我的,就只好送给其他小伙伴了。

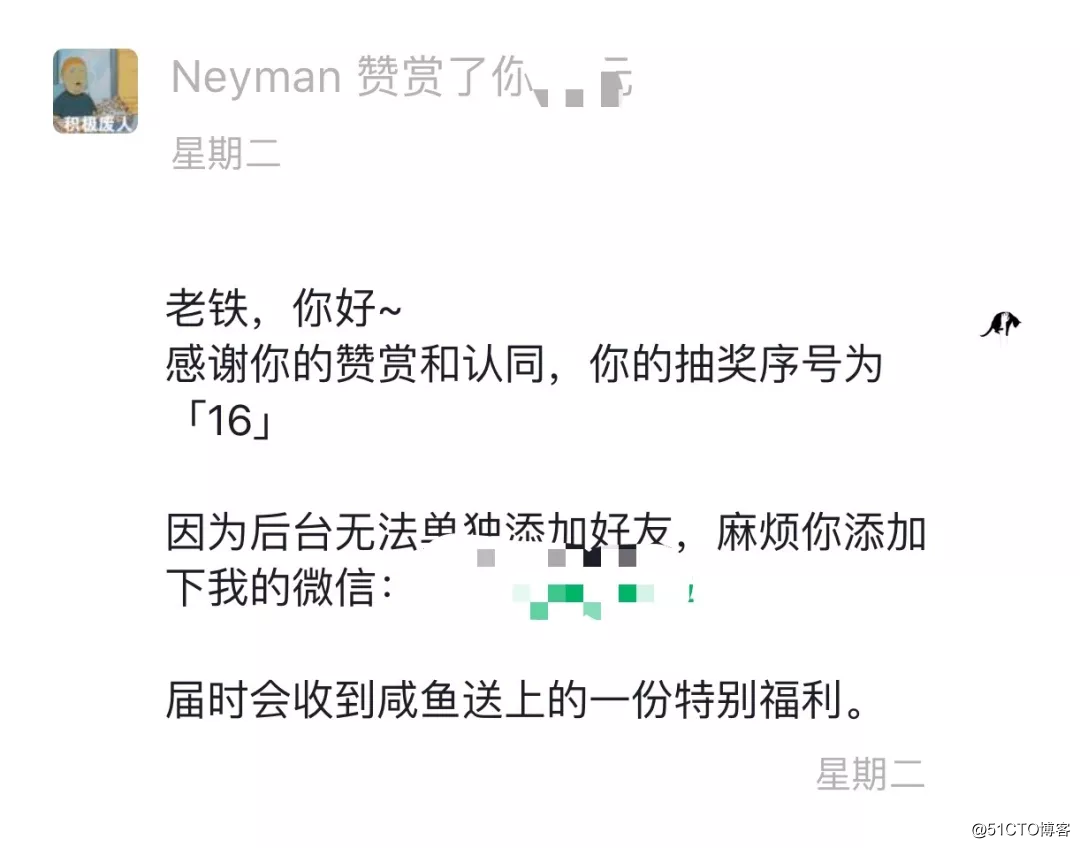

赞赏送书活动也完美落幕了,感谢28位小伙伴的打赏,希望你们能喜欢咸鱼送出的铁粉福利。下次送书,你懂得~

赞赏送书截图

通用爬虫套路

在刚刚接触Python爬虫的时候常常会有无从下手的感觉,于是咸鱼整理了简单爬虫的通用套路,没有思路的时候看一下吧。

准备url

1 . 准备start url

-

页码总数不确定,规律不明显

-

通过代码提取下一页地址

使用xpath提取url

- 寻找url地址,部分参数在当前页面中,比如当前页码数和总页码数,使用这两个参数构建url

2 . 准备url list

-

页码总数清楚

-

url 地址规律明显

发送请求,获取响应

-

添加随机user-agent,反反爬虫

-

添加随机代理ip,反反爬虫

-

在对方判断我们是爬虫之后应该添加更多的headers字段,包含cookie

-

cookie的处理可以使用session来解决

-

准备一堆能用的cookie,组成cookie池。

-

如果不登录

-

准备刚刚开始能够成功请求的cookie,即接收对方网站设置在response的cookie

- 如果登录

- 准备多个账号

- 使用程序获取每个账号的cookie

- 请求登录之后才能访问的网站随机选择上一步获取的cookie

提取数据

1 . 确定数据的位置

-

如果数据在当前的url地址中

-

提取的是列表页中的数据

直接请求列表页的url地址,不用进入详情页

提取详情页的数据

1.确定url

2.发送请求

3.提取数据

如果数据不在当前的url地址中

在其他响应中,寻找数据的位置

在network中从上而下找

使用chrome中的过滤条件,选择除了js,css, image之外的按钮

2 . 数据的提取

-

xpath,从html中提取整块的数据,先分组,之后每一组在提取

-

re,提取max_time,html等

- json

保存数据

-

保存在本地json ,csv,text

- 保存在数据库

推荐阅读

相关文章推荐

- 爬虫 | Scrapy实战腾讯招聘(附赠书获奖名单)

- Python爬虫实现全国失信被执行人名单查询功能示例

- [置顶] 【python 爬虫】全国失信被执行人名单爬虫

- 赠书活动获奖名单 - 2月28日的《使用 Virtual SAN 实现策略驱动的存储设计》

- 《现代体系结构上的UNIX系统》点评赠书获奖名单

- 千篇一律的Python爬虫,大神精心总结的爬虫套路!

- 网易智能公布赠书活动获奖名单:《人工智能简史》抢先得 | 公示

- 【每周一本书】之《Java自然语言处理》(附上期赠书活动获奖名单)

- Python爬虫的基本套路

- Python创意编程活动获奖名单公布啦!!

- 浅谈Python爬虫基本套路

- 《UNIX/Linux网络日志分析与流量监控》点评赠书获奖名单

- 《云数据中心构建实战:核心技术、运维管理、安全与高可用》点评赠书获奖名单

- 《24小时365天不间断服务:服务器/基础设施核心技术》点评赠书获奖名单

- 《IT运维之道》点评赠书活动获奖名单

- Python中文社区光棍节活动获奖名单

- [置顶] 【python 爬虫】全国失信被执行人名单查询功能

- python爬虫爬取幽默笑话网站

- 个人空间岁末大回报活动12月29日获奖名单

- Python微博地点签到大数据实战(三)大数据利器:爬虫