深度学习知识点-持续更新

1、1*1卷积的作用

降低维度和非线性

https://zhuanlan.zhihu.com/p/40050371

https://www.zhihu.com/question/56024942

2、2维和三维卷积

https://www.zhihu.com/question/266352189

3、为什么一个5*5的卷积核可以用两个3*3的卷积核代替,一个7*7的卷积核可以用三个的3*3卷积核代替?

https://www.zhihu.com/question/265791259/answer/298610437

4、感受野

:每一层输出的特征图(feature map)上的像素点在原始图像上映射的区域大小

https://zhuanlan.zhihu.com/p/28492837

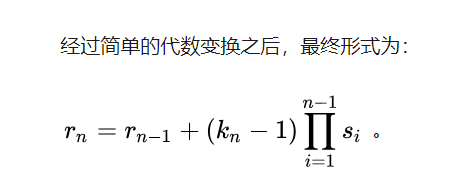

n表示第n个卷积层的kernel_size和stride

感受野的计算公式为:

5、Dilated convolution(空洞卷积和扩张卷积)

参考:https://github.com/vdumoulin/conv_arithmetic

参考:1、https://github.com/vdumoulin/conv_arithmetic 参考这个上面的图

2、https://www.zhihu.com/question/54149221/answer/323880412

3、https://arleyzhang.github.io/articles/47648ee6/

Dilated/Atrous Convolution 或者是 Convolution with holes 从字面上就很好理解,是在标准的 convolution map 里注入空洞,以此来增加 reception field。相比原来的正常convolution,dilated convolution 多了一个 hyper-parameter 称之为 dilation rate 指的是kernel的间隔数量(e.g. 正常的 convolution 是 dilatation rate 1)

6、什么是全连接层?

参考:https://zhuanlan.zhihu.com/p/33841176

1、就是它把特征representation整合到一起,输出为一个值,这样做,有一个什么好处,就是大大减少特征位置对分类带来的影响

2、喵在哪我不管,我只要喵,于是我让filter去把这个喵找到,实际就是把feature map 整合成一个值,这个值大,哦,有喵

这个值小,那就可能没喵,和这个喵在哪关系不大了有没有,鲁棒性有大大增强了有没有,喵喵喵,因为空间结构特性被忽略了,所以全连接层不适合用于在方位上找Pattern的任务,比如segmentation。

3、如果有两层或以上fully connected layer就可以很好地解决非线性问题了

4、全连接层参数特多(可占整个网络参数80%左右),近期一些性能优异的网络模型如ResNet和GoogLeNet等均用全局平均池化(global average pooling,GAP)取代全连接层来融合学到的深度特征

7、为什么使用全局平均池化层?

1、https://zhuanlan.zhihu.com/p/46235425

2、https://www.geek-share.com/detail/2737482560.html

由此就可以比较直观地说明了。这两者合二为一的过程我们可以探索到GAP的真正意义是:对整个网路在结构上做正则化防止过拟合。其直接剔除了全连接层中黑箱的特征,直接赋予了每个channel实际的内别意义。 实践证明其效果还是比较可观的,同时GAP可以实现任意图像大小的输入

8、机器学习性能评估指标

1、https://www.zhihu.com/question/19645541

2、http://charleshm.github.io/2016/03/Model-Performance/

- 深度学习算法索引(持续更新)

- 机器学习、深度学习、计算机视觉、自然语言处理及应用案例——干货分享(持续更新……)

- 深度学习参考文献及资料【持续更新】

- 深度学习代码(持续更新中)

- 深度学习常规概念(持续更新)

- 深度学习相关文章(持续更新)

- Qt学习重要知识点简记---控件使用篇(持续更新)

- IOS学习中的一些小知识点总结(持续更新)

- 深度学习资料汇总(持续更新)

- 深度学习-面试知识点总结(日更五题 早更新晚温习)

- javascript学习笔记---注意知识点(持续更新)

- py3+tensorflow+opencv基于深度学习制作人脸识别系统学习历程(持续更新)

- 深度学习的Image Inpainting (图像修复)论文推荐(持续更新) (转)

- 深度学习环境安装(持续更新)

- 我的JAVA学习笔记(记下一些容易忘记的知识点)持续更新

- 深度学习(持续更新)之(一)深度学习的介绍与历史

- 机器学习语料,深度学习语料,神经网络语料,nlp语料,机器视觉语料,持续更新

- 深度学习的Image Inpainting (图像修复)论文推荐(持续更新) (转)

- CNN:关于深度学习之CNN经典论文原文(1950~2018)简介、下载地址大全(非常有价值)之持续更新(吐血整理)

- linux/shell 深度学习、人工智能常用指令合集(持续更新中)