深度学习中的正则化技术--DropOut&DropConnect

上次的有L1,L2范数正则化,这次介绍 DropOut及其衍生出来的DropConnect

L1,L2范数正则化与 DropOut正则化的原理有本质上的不同

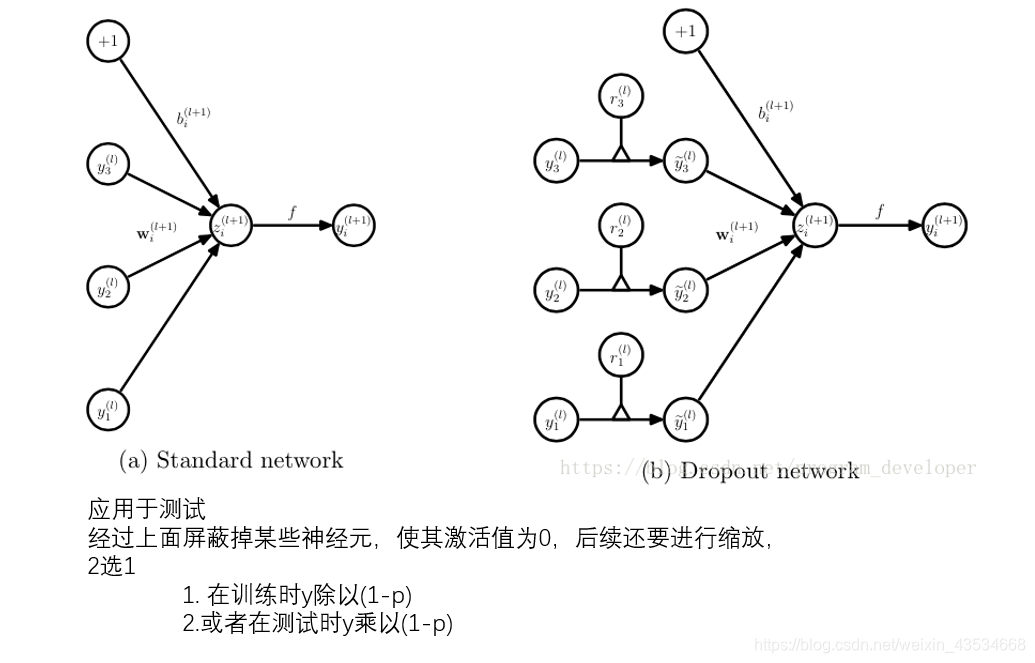

Drout的原理是

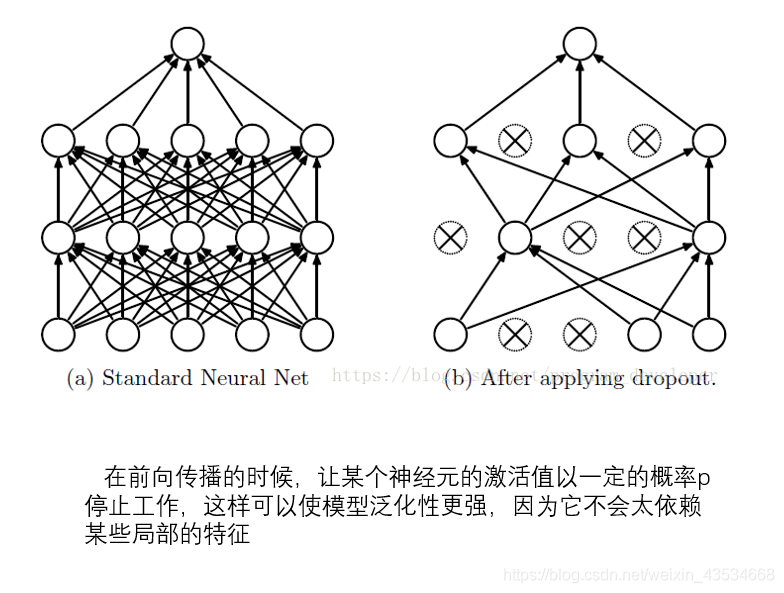

dropout是在经过激活函数之后,再经过一个函数用于控制是否输出,不输出的概率是p

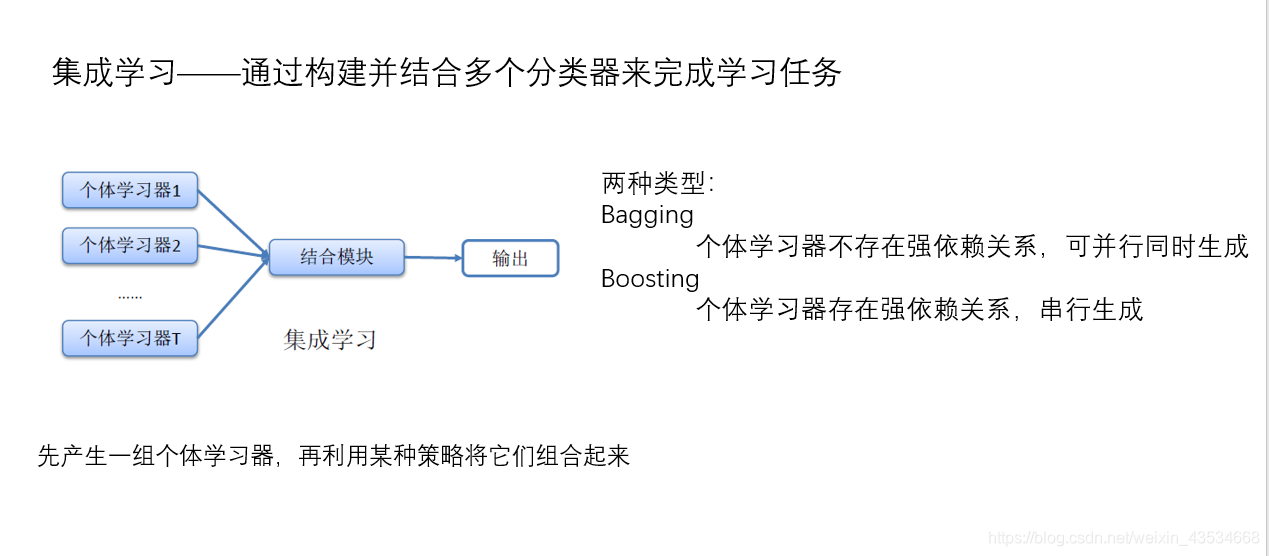

dropout对于提升性能有很大提升,最主要的观点是从集成学习的角度解释的

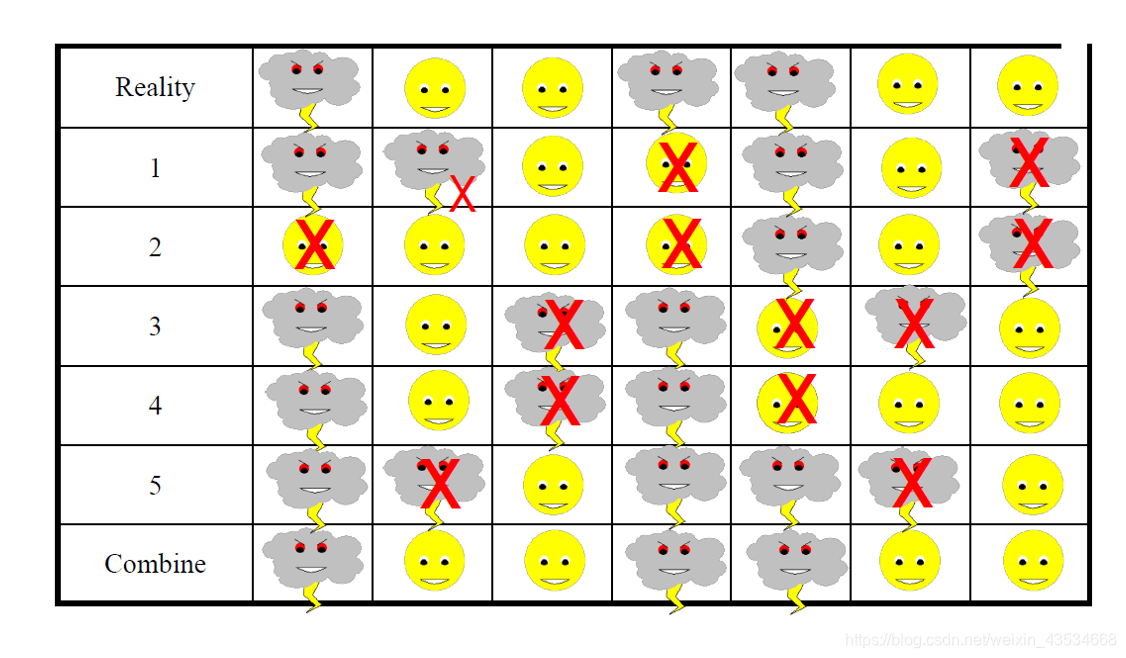

以天气预报为例,预测未来7天的天气,5个分类器同时独立进行预测,每个都有误差,但是将五个分类器的结果按照少数服从多数的原则进行归纳,得到的最后结果与现实生活的天气状况完全一致

Dropout可以看成是又许多共享权重的小网络组成的bagging模型

为了使得训练的结果能够用于测试、应用,还应当对数据进行处理,可以在训练的时候就改,也可以在测试、应用的时候改。经过1,2中的任一个即可,道理也比较容易懂

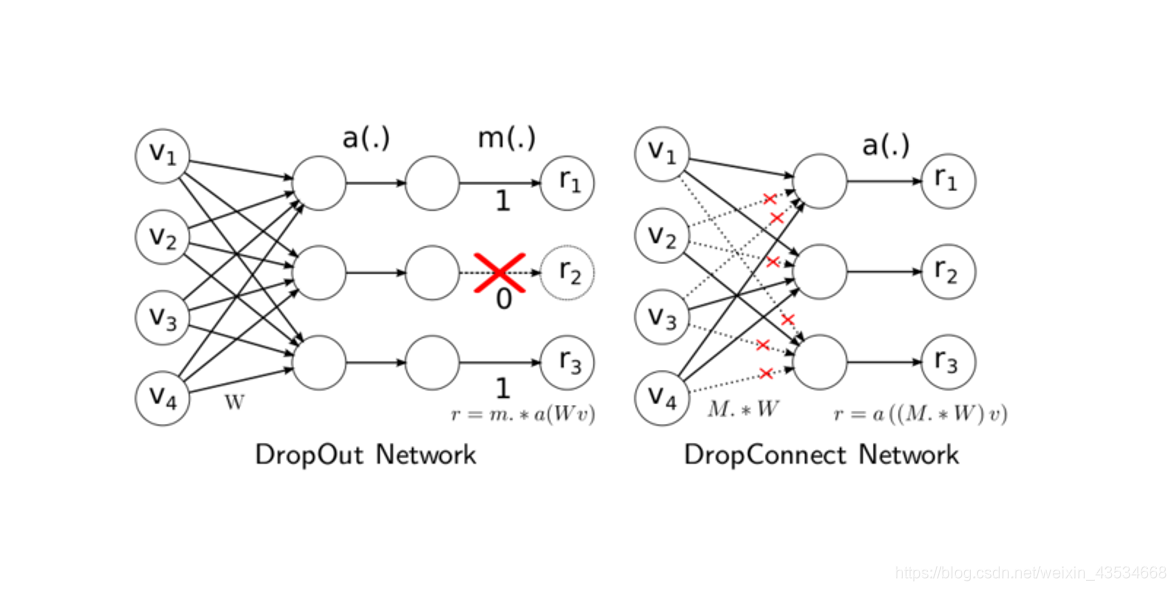

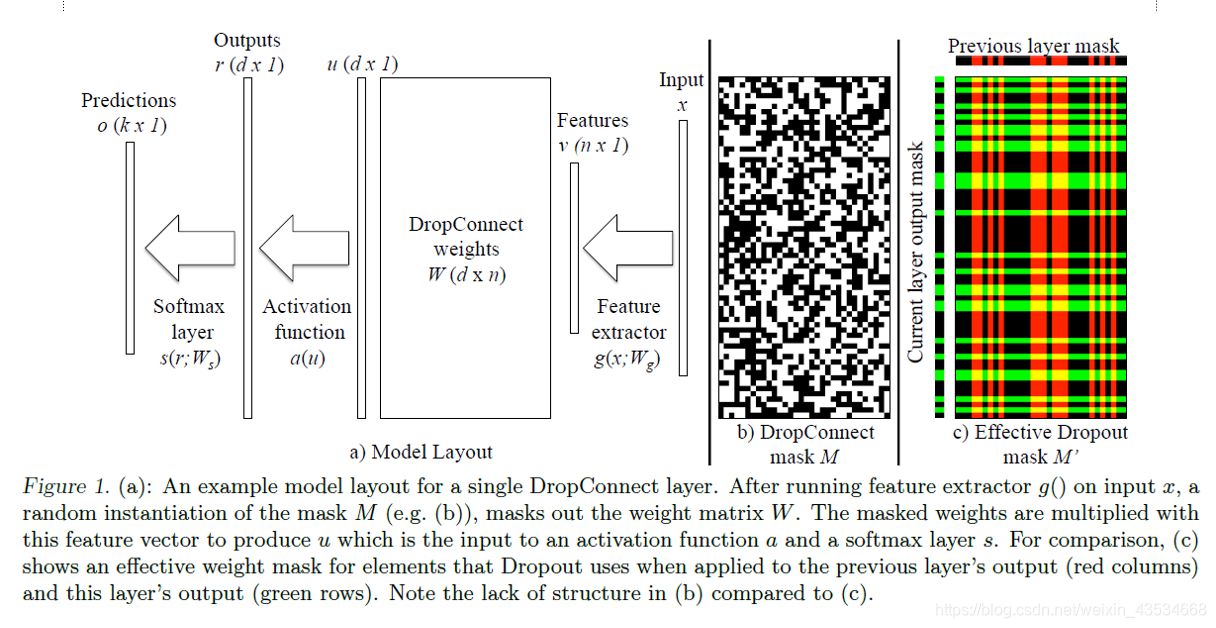

Dropout是在激活函数之后控制是否输出,而Dropconnect是在输出之后控制任意两个结点的连接关系,Dropconnect的颗粒度更小,效果也会更好,输入到下一层之后再经过激活函数,相比dropout计算都是有效的

b,c展示了上一层输出和下一层输出的关系,明显Dropconnect的颗粒度更小

效果展示,横线是在不使用dropout的情况下mnist的错误数量。可以看到输入层DropOut20%+隐藏层DropOut50%的效果比只DropOut50%隐藏层结点的效果要好,使用比不使用的效果要好

下面比较Dropout和DropConnect的性能,一般来说Dropconnect的性能比Dropout的效果好点。然而,并不是完全呈这种关系,有时还和激活函数有关

诶,神经网络就是佛系,都没有人解释清楚出原理,效果怎么好就怎么来吧。佛系调参

- 深度学习(dropout 和 maxout 技术)

- 深度学习的实用技巧——L2正则化、Dropout正则化、梯度检验

- 神经网络的Dropout正则化

- 深度学习(二十二)Dropout浅层理解与实现

- 机器学习中正则化方法简介:L1和L2正则化(regularization)、数据集扩增、dropout

- 正则化方法:L1和L2 regularization、数据集扩增、dropout

- 正则化方法:L1和L2 regularization、数据集扩增、dropout

- 深度学习:欠拟合、过拟合、正则化,BN ,L1/L2 范数正则化、bagging集成,dropout

- 深度学习(dropout)

- 深度学习小白——神经网络3(数据预处理,dropout,正则化)

- [一种通用的正则化方法Dropout] 深入理解Dropout正则化思想和实现方法

- 深度学习(一)——MP神经元模型, BP算法, 神经元激活函数, Dropout

- 深度学习(二十二)Dropout浅层理解

- 正则化,数据集扩增,Dropout

- 神经网络九:Regularization(正则化)与Dropout

- dropout和L1,L2正则化的理解笔记

- 正则化方法:L1和L2 regularization、数据集扩增、dropout

- Regularization(正则化)与Dropout

- 正则化方法:L1和L2 regularization、数据集扩增、dropout

- 神经网络的Dropout正则化