Scrapy模拟登录GitHub

2018-07-08 15:57

295 查看

d:

进入D盘

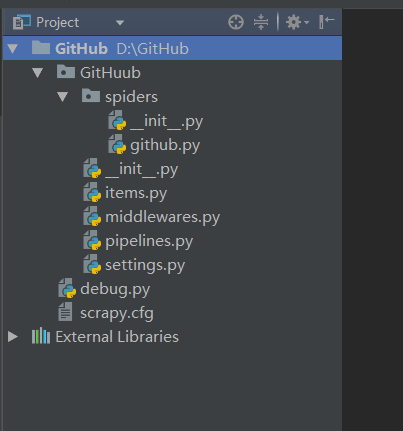

scrapy startproject GitHub

创建项目

scrapy genspider github github.com

创建爬虫

编辑github.py:

# -*- coding: utf-8 -*-

import scrapy

from scrapy import Request, FormRequest

class GithubSpider(scrapy.Spider):

name = 'github'

allowed_domains = ['github.com']

headers = {

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8',

'Accept-Encoding': 'gzip, deflate, br',

'Accept-Language': 'zh-CN,zh;q=0.8,en-US;q=0.5,en;q=0.3',

'Connection': 'keep-alive',

'Referer': 'https://github.com/',

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:52.0) Gecko/20100101 Firefox/52.0',

'Content-Type': 'application/x-www-form-urlencoded'

}

# 请求头

def start_requests(self):

# 重写start_requests方法

urls = ['https://github.com/login']

for url in urls:

yield Request(url, meta={'cookiejar': 1}, callback=self.github_login)

# 通过meta传入cookiejar特殊key,爬取url作为参数传给回调函数

# meta:字典格式的元数据

# cookiejar:是meta的一个特殊的key,通过cookiejar参数可以支持多个会话对某网站进行爬取

# 可以对cookie做标记1, 2, 3, 4......这样scrapy就维持了多个会话

def github_login(self, response):

authenticity_token = response.xpath(".//*[@id='login']/form/input[2]/@value").extract_first()

# 首先从源码中获取到authenticity_token的值

return FormRequest.from_response(

response,

url='https://github.com/session',

meta={'cookiejar': response.meta['cookiejar']},

headers=self.headers,

formdata={

'authenticity_token': authenticity_token,

'commit': 'Sign in',

'login': '526861348@qq.com',

'password': 'caihong@1234',

'utf8': '✓'

},

callback=self.github_after,

dont_click=True

# dont_click如果是True,表单数据将被提交,而不需要单击任何元素

)

def github_after(self, response):

home_page = response.xpath(".//*[@id='dashboard']/div[2]/div[1]/nav/a[1]/text()").extract()

# 获取登录成功后页面中的文本“Browse activity”

if 'Browse activity' in home_page:

self.logger.info('登录成功!')

# 如果含有“Browse activity”,则打印登录成功

else:

self.logger.error('登录失败!')

新建debug.py调试脚本:

# -*- coding: utf-8 -*-

from scrapy import cmdline

cmdline.execute('scrapy crawl github'.split())

修改settings.py配置文件:

第23行修改为:

# Obey robots.txt rules

ROBOTSTXT_OBEY = False

# 遵循Robots协议

相关文章推荐

- Scrapy框架学习(五)----Request、Response介绍及模拟GitHub登录

- 通过scrapy,从模拟登录开始爬取知乎的问答数据

- 在scrapy上使用cookie模拟登录

- scrapy 模拟登录后再抓取

- Scrapy模拟登录知乎

- Scrapy——模拟登陆爬取github issues

- scrapy模拟登录微博

- Scrapy解决模拟登录问题

- scrapy模拟登录微博

- GitHub 模拟登录

- 使用requests和scrapy模拟知乎登录

- 【Scrapy】 采用 requests 模拟 Oauth2.0 登录 开源中国社区

- session或scrapy实现模拟登录知乎

- 用scrapy 模拟知乎的登录过程

- Scrapy框架学习 - 模拟登录的实现方式

- scrapy模拟登录新浪微博

- scrapy模拟登录新浪微博

- Scrapy模拟登录抓数据基本应用

- python3下使用scrapy实现模拟用户登录与cookie存储—— 中级篇(百度云俱乐部)

- 运维学python之爬虫高级篇(六)scrapy模拟登陆GitHub和51cto