redis 单机模拟 cluster集群

一、redis-cluster设计

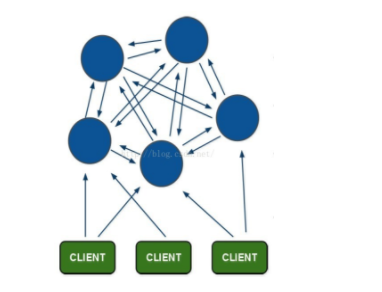

Redis集群搭建的方式有多种,例如使用zookeeper等,但从redis 3.0之后版本支持redis-cluster集群,Redis-Cluster采用无中心结构,每个节点保存数据和整个集群状态,每个节点都和其他所有节点连接。其redis-cluster架构图如下:

其结构特点:

1、所有的redis节点彼此互联(PING-PONG机制),内部使用二进制协议优化传输速度和带宽。

2、节点的fail是通过集群中超过半数的节点检测失效时才生效。

3、客户端与redis节点直连,不需要中间proxy层.客户端不需要连接集群所有节点,连接集群中任何一个可用节点即可。

4、redis-cluster把所有的物理节点映射到[0-16383]slot上(不一定是平均分配),cluster 负责维护node<->slot<->value。

5、Redis集群预分好16384个桶,当需要在 Redis 集群中放置一个 key-value 时,根据 CRC16(key) mod 16384的值,决定将一个key放到哪个桶中。

1、redis cluster节点分配

现在我们是三个主节点分别是:A, B, C 三个节点,它们可以是一台机器上的三个端口,也可以是三台不同的服务器。那么,采用哈希槽 (hash slot)的方式来分配16384个slot 的话,它们三个节点分别承担的slot 区间是:

节点A覆盖0-5460;

节点B覆盖5461-10922;

节点C覆盖10923-16383.

获取数据:

如果存入一个值,按照redis cluster哈希槽的算法: CRC16('key')384 = 6782。 那么就会把这个key 的存储分配到 B 上了。同样,当我连接(A,B,C)任何一个节点想获取'key'这个key时,也会这样的算法,然后内部跳转到B节点上获取数据

新增一个主节点:

新增一个节点D,redis cluster的这种做法是从各个节点的前面各拿取一部分slot到D上,我会在接下来的实践中实验。大致就会变成这样:

节点A覆盖1365-5460

节点B覆盖6827-10922

节点C覆盖12288-16383

节点D覆盖0-1364,5461-6826,10923-12287

同样删除一个节点也是类似,移动完成后就可以删除这个节点了。

2、Redis Cluster主从模式

redis cluster 为了保证数据的高可用性,加入了主从模式,一个主节点对应一个或多个从节点,主节点提供数据存取,从节点则是从主节点拉取数据备份,当这个主节点挂掉后,就会有这个从节点选取一个来充当主节点,从而保证集群不会挂掉。

上面那个例子里, 集群有ABC三个主节点, 如果这3个节点都没有加入从节点,如果B挂掉了,我们就无法访问整个集群了。A和C的slot也无法访问。

所以我们在集群建立的时候,一定要为每个主节点都添加了从节点, 比如像这样, 集群包含主节点A、B、C, 以及从节点A1、B1、C1, 那么即使B挂掉系统也可以继续正确工作。

B1节点替代了B节点,所以Redis集群将会选择B1节点作为新的主节点,集群将会继续正确地提供服务。 当B重新开启后,它就会变成B1的从节点。

不过需要注意,如果节点B和B1同时挂了,Redis集群就无法继续正确地提供服务了。

二、redis集群的搭建

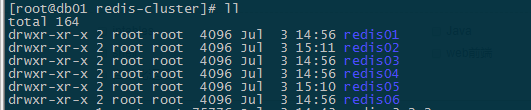

集群中至少应该有奇数个节点,所以至少有三个节点,每个节点至少有一个备份节点,所以下面使用6节点(主节点、备份节点由redis-cluster集群确定)。

1、安装redis

# tar xf redis-3.2.5.tar.gz

# cd redis-3.2.5/

# make

# make install PREFIX=/usr/local/redis-cluster

# cd /usr/local/redis-cluster/

# mv bin redis01

# cd redis01

从解压后后目录里 复制一份redis.conf 到 redis01目录下

修改内容:

cluster-enabled yes #开启cluster,去掉注释 cluster-config-file nodes.conf cluster-node-timeout 15000 appendonly yes

复制六份,修改对应的端口号

2、安装redis-trib所需的 ruby脚本

复制redis解压文件src下的redis-trib.rb文件到redis-cluster目录

[root@db01 redis-cluster]# cp /soft/redis-3.2.5/src/redis-trib.rb ./

安装ruby环境

[root@localhost redis-cluster]# yum install ruby [root@localhost redis-cluster]# yum install rubygems

安装redis-trib.rb运行依赖的ruby的包redis-3.2.2.gem,下载

[root@localhost redis-cluster]# gem install redis-3.2.2.gem

3、启动所有的redis节点

可以写一个命令脚本start-all.sh

[root@db01 redis-cluster]# cat start-all.sh cd redis01 ./redis-server redis.conf cd ../redis02 ./redis-server redis.conf cd ../redis03 ./redis-server redis.conf cd ../redis04 ./redis-server redis.conf cd ../redis05 ./redis-server redis.conf cd ../redis06 ./redis-server redis.conf cd ..

[root@localhost redis-cluster]# chmod +x start-all.sh [root@localhost redis-cluster]# ./start-all.sh

[root@localhost redis-cluster]# ps -ef | grep redis

root 4547 1 0 23:12 ? 00:00:00 ./redis-server 127.0.0.1:7001 [cluster]

root 4551 1 0 23:12 ? 00:00:00 ./redis-server 127.0.0.1:7002 [cluster]

root 4555 1 0 23:12 ? 00:00:00 ./redis-server 127.0.0.1:7003 [cluster]

root 4559 1 0 23:12 ? 00:00:00 ./redis-server 127.0.0.1:7004 [cluster]

root 4563 1 0 23:12 ? 00:00:00 ./redis-server 127.0.0.1:7005 [cluster]

root 4567 1 0 23:12 ? 00:00:00 ./redis-server 127.0.0.1:7006 [cluster]

root 4840 4421 0 23:26 pts/1 00:00:00 grep --color=auto redis

可以看到redis的6个节点已经启动成功

杀死全部的节点:

pkill -9 redis

4、使用redis-trib.rb创建集群

[root@localhost redis-cluster]# ./redis-trib.rb create --replicas 1 127.0.0.1:7001 127.0.0.1:7002 127.0.0.1:7003 127.0.0.1:7004 127.0.0.1:7005 127.0.0.1:7006

使用create命令 --replicas 1 参数表示为每个主节点创建一个从节点,其他参数是实例的地址集合。

>>> Creating cluster >>> Performing hash slots allocation on 6 nodes... Using 3 masters: 127.0.0.1:7001 127.0.0.1:7002 127.0.0.1:7003 Adding replica 127.0.0.1:7004 to 127.0.0.1:7001 Adding replica 127.0.0.1:7005 to 127.0.0.1:7002 Adding replica 127.0.0.1:7006 to 127.0.0.1:7003 M: dfd510594da614469a93a0a70767ec9145aefb1a 127.0.0.1:7001 slots:0-5460 (5461 slots) master M: e02eac35110bbf44c61ff90175e04d55cca097ff 127.0.0.1:7002 slots:5461-10922 (5462 slots) master M: 4385809e6f4952ecb122dbfedbee29109d6bb234 127.0.0.1:7003 slots:10923-16383 (5461 slots) master S: ec02c9ef3acee069e8849f143a492db18d4bb06c 127.0.0.1:7004 replicates dfd510594da614469a93a0a70767ec9145aefb1a S: 83e5a8bb94fb5aaa892cd2f6216604e03e4a6c75 127.0.0.1:7005 replicates e02eac35110bbf44c61ff90175e04d55cca097ff S: 10c097c429ca24f8720986c6b66f0688bfb901ee 127.0.0.1:7006 replicates 4385809e6f4952ecb122dbfedbee29109d6bb234 Can I set the above configuration? (type 'yes' to accept): yes >>> Nodes configuration updated >>> Assign a different config epoch to each node >>> Sending CLUSTER MEET messages to join the cluster Waiting for the cluster to join...... >>> Performing Cluster Check (using node 127.0.0.1:7001) M: dfd510594da614469a93a0a70767ec9145aefb1a 127.0.0.1:7001 slots:0-5460 (5461 slots) master M: e02eac35110bbf44c61ff90175e04d55cca097ff 127.0.0.1:7002 slots:5461-10922 (5462 slots) master M: 4385809e6f4952ecb122dbfedbee29109d6bb234 127.0.0.1:7003 slots:10923-16383 (5461 slots) master M: ec02c9ef3acee069e8849f143a492db18d4bb06c 127.0.0.1:7004 slots: (0 slots) master replicates dfd510594da614469a93a0a70767ec9145aefb1a M: 83e5a8bb94fb5aaa892cd2f6216604e03e4a6c75 127.0.0.1:7005 slots: (0 slots) master replicates e02eac35110bbf44c61ff90175e04d55cca097ff M: 10c097c429ca24f8720986c6b66f0688bfb901ee 127.0.0.1:7006 slots: (0 slots) master replicates 4385809e6f4952ecb122dbfedbee29109d6bb234 [OK] All nodes agree about slots configuration. >>> Check for open slots... >>> Check slots coverage... [OK] All 16384 slots covered.

上面显示创建成功,有3个主节点,3个从节点,每个节点都是成功连接状态。

3个主节点[M]以及分配的哈希卡槽如下:

M: dfd510594da614469a93a0a70767ec9145aefb1a 127.0.0.1:7001 slots:0-5460 (5461 slots) master M: e02eac35110bbf44c61ff90175e04d55cca097ff 127.0.0.1:7002 slots:5461-10922 (5462 slots) master M: 4385809e6f4952ecb122dbfedbee29109d6bb234 127.0.0.1:7003 slots:10923-16383 (5461 slots) master

3个从节点[S]以及附属的主节点如下:

S: ec02c9ef3acee069e8849f143a492db18d4bb06c 127.0.0.1:7004 replicates dfd510594da614469a93a0a70767ec9145aefb1a S: 83e5a8bb94fb5aaa892cd2f6216604e03e4a6c75 127.0.0.1:7005 replicates e02eac35110bbf44c61ff90175e04d55cca097ff S: 10c097c429ca24f8720986c6b66f0688bfb901ee 127.0.0.1:7006 replicates 4385809e6f4952ecb122dbfedbee29109d6bb234

以上集群安装成功了

三、redis集群的测试

1、测试存取值

客户端连接集群redis-cli需要带上 -c ,redis-cli -c -p 端口号

[root@localhost redis01]# ./redis-cli -c -p 7001 127.0.0.1:7001> set name andy -> Redirected to slot [5798] located at 127.0.0.1:7002 OK 127.0.0.1:7002> get name "andy" 127.0.0.1:7002>

根据redis-cluster的key值分配,name应该分配到节点7002[5461-10922]上,上面显示redis cluster自动从7001跳转到了7002节点。

我们可以测试一下7006从节点获取name值

[root@localhost redis06]# ./redis-cli -c -p 7006 127.0.0.1:7006> get name -> Redirected to slot [5798] located at 127.0.0.1:7002 "andy" 127.0.0.1:7002>

7006位7003的从节点,从上面也是自动跳转至7002获取值,这也是redis cluster的特点,它是去中心化,每个节点都是对等的,连接哪个节点都可以获取和设置数据。

四、集群

节点选举

现在模拟将7001节点挂掉,按照redis-cluster原理会选举会将 7001的从节点7004选举为主节点。

[root@db01 redis-cluster]# ps -ef |grep redis root 12614 1 0 14:55 ? 00:00:04 ./redis-server 127.0.0.1:7002 [cluster] root 12618 1 0 14:55 ? 00:00:04 ./redis-server 127.0.0.1:7002 [cluster] root 12622 1 0 14:55 ? 00:00:04 ./redis-server 127.0.0.1:7003 [cluster] root 12626 1 0 14:55 ? 00:00:04 ./redis-server 127.0.0.1:7004 [cluster] root 12630 1 0 14:55 ? 00:00:04 ./redis-server 127.0.0.1:7005 [cluster] root 12634 1 0 14:55 ? 00:00:04 ./redis-server 127.0.0.1:7006 [cluster] root 13370 8793 0 16:08 pts/0 00:00:00 grep --color=auto redis

kill -9 12614

在查看集群中的7001节点

[root@db01 redis-cluster]# ./redis-trib.rb check 127.0.0.1:7004 >>> Performing Cluster Check (using node 127.0.0.1:7004) M: d8ab0ba1c7c8db0aa8512c4a1ccfe5f0bf248841 127.0.0.1:7004 slots:0-5460 (5461 slots) master 0 additional replica(s) S: b03cf52d5423b3076269bbd1824bcb9dc38931e9 127.0.0.1:7005 slots: (0 slots) slave replicates 86a2ad43cc81025505e6b6abb9672f0d9e560711 M: 86a2ad43cc81025505e6b6abb9672f0d9e560711 127.0.0.1:7002 slots:5461-10922 (5462 slots) master 1 additional replica(s) S: d79c9cc52fb5ce4315bed3532ef92f09dffb985d 127.0.0.1:7006 slots: (0 slots) slave replicates 1507d656f4fbd049502397c71b2be16c8c6c2a23 M: 1507d656f4fbd049502397c71b2be16c8c6c2a23 127.0.0.1:7003 slots:10923-16383 (5461 slots) master 1 additional replica(s) [OK] All nodes agree about slots configuration. >>> Check for open slots... >>> Check slots coverage... [OK] All 16384 slots covered.

可以看到集群连接不了7001节点,重定向到附近节点7002获取到 key对应的值

[root@db01 redis01]# ./redis-cli -c -p 7001 127.0.0.1:7001> get name -> Redirected to slot [5798] located at 127.0.0.1:7002 "andy" 127.0.0.1:7002>

将7001重新加入集群后,发现 与他对应的7004 已经变成master而7001变成了salve

[root@db01 redis01]# ./redis-server redis.conf [root@db01 redis01]# cd .. [root@db01 redis-cluster]# ./redis-trib.rb check 127.0.0.1:7001 >>> Performing Cluster Check (using node 127.0.0.1:7001) S: 6317ce2a62d55fa610673ff5be094a369efdf7f1 127.0.0.1:7001 slots: (0 slots) slave replicates d8ab0ba1c7c8db0aa8512c4a1ccfe5f0bf248841 M: d8ab0ba1c7c8db0aa8512c4a1ccfe5f0bf248841 127.0.0.1:7004 slots:0-5460 (5461 slots) master 1 additional replica(s) M: 86a2ad43cc81025505e6b6abb9672f0d9e560711 127.0.0.1:7002 slots:5461-10922 (5462 slots) master 1 additional replica(s) S: d79c9cc52fb5ce4315bed3532ef92f09dffb985d 127.0.0.1:7006 slots: (0 slots) slave replicates 1507d656f4fbd049502397c71b2be16c8c6c2a23 M: 1507d656f4fbd049502397c71b2be16c8c6c2a23 127.0.0.1:7003 slots:10923-16383 (5461 slots) master 1 additional replica(s) S: b03cf52d5423b3076269bbd1824bcb9dc38931e9 127.0.0.1:7005 slots: (0 slots) slave replicates 86a2ad43cc81025505e6b6abb9672f0d9e560711 [OK] All nodes agree about slots configuration. >>> Check for open slots... >>> Check slots coverage... [OK] All 16384 slots covered.

- redis集群(单机模拟)动态添加、删除节点

- Linux下redis-cluster单机集群安装方法

- Redis集群环境的搭建(从单机模拟到真正的集群搭建)

- redis-cluster集群单机搭建

- redis集群(单机6节点实现)

- redis-集群(cluster)扫盲篇(一)

- Linux Redis-Cluster集群搭建与使用

- redis 集群性能测试以及与单机性能对比

- redis 学习笔记(6)-cluster集群搭建

- 在Linux上单机模拟Oracle 10g RAC集群

- Redis基本概念、基本使用与单机集群部署

- redis单机及其集群的搭建

- centos6搭建redis集群搭建(单机多节点)

- redis(9)、redis集群之redis Cluster使用

- redis之(十六)redis的cluster集群环境的搭建,转载

- redis 3.0 cluster 集群 学习之路篇(资料汇总)

- CentOS搭建redis-cluster集群

- Redis集群 redis cluster in 3.0

- redis单机及集群部署

- Redis集群环境搭建-cluster模式