神经网络常用激活函数总结

2018-05-23 21:04

337 查看

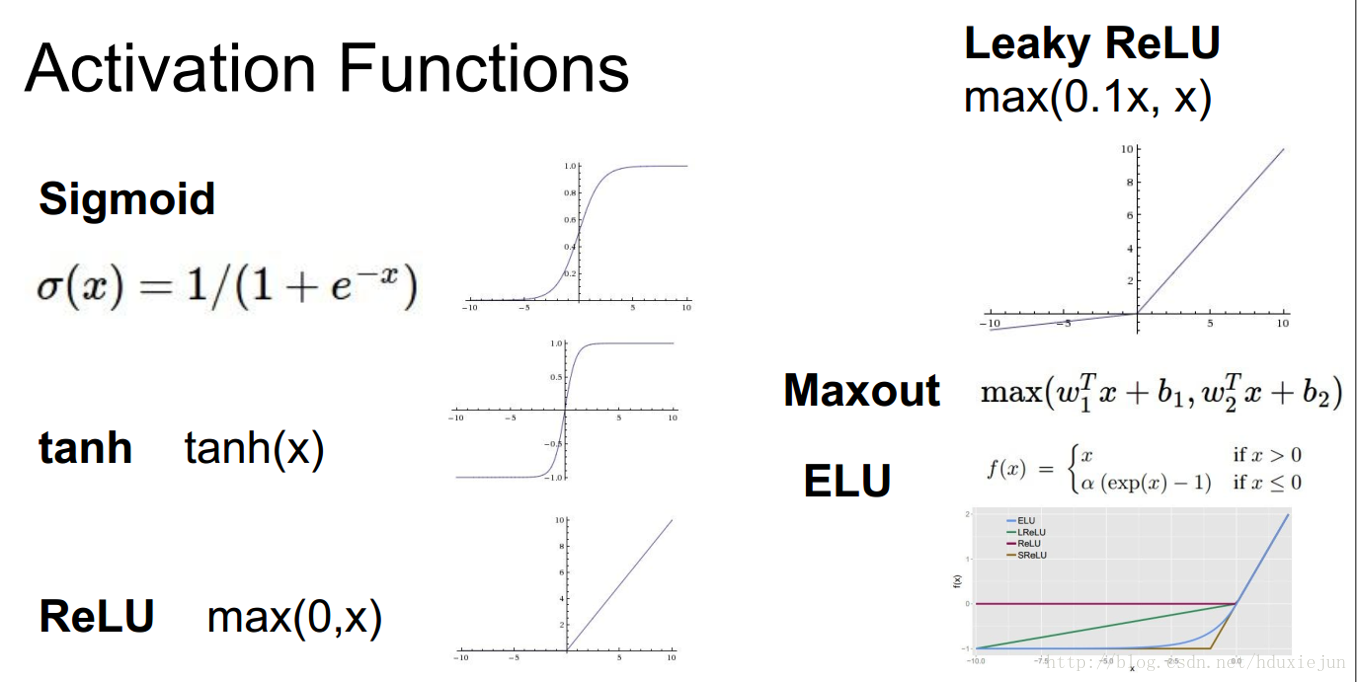

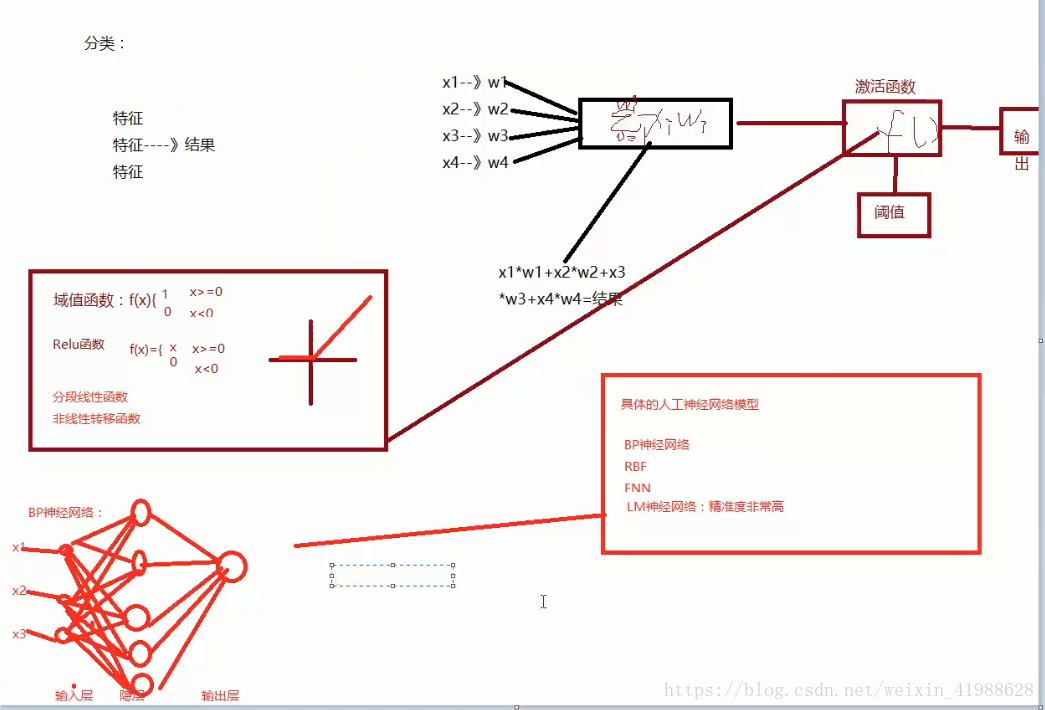

神经网络中如果不加入激活函数,其一定程度可以看成线性表达,最后的表达能力不好,如果加入一些非线性的激活函数,整个网络中就引入了非线性部分,增加了网络的表达能力。目前比较流行的激活函数主要分为以下7种:

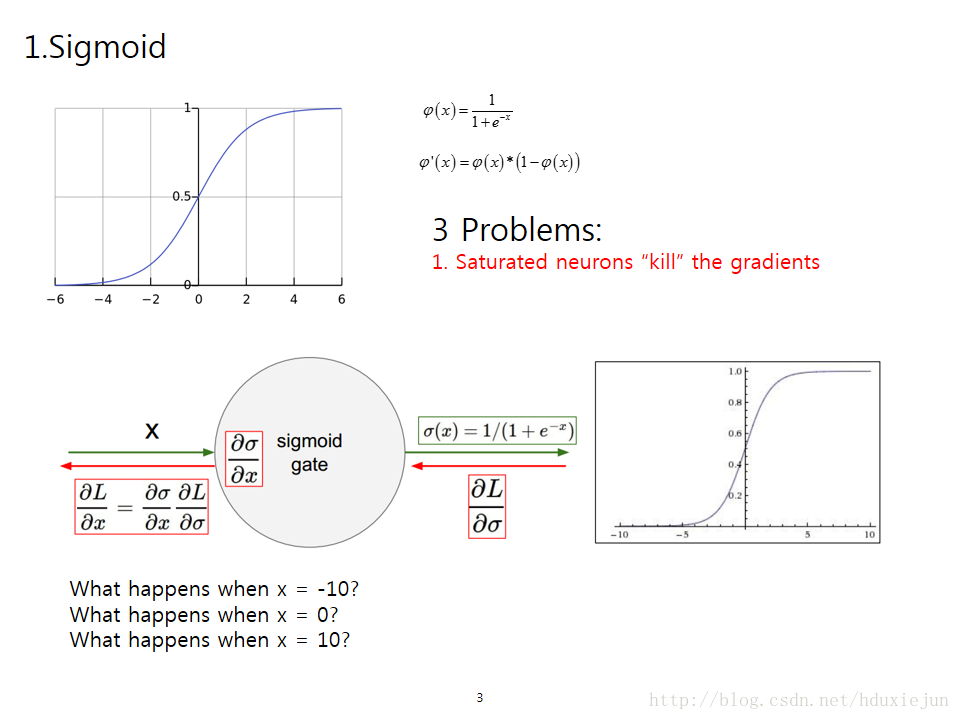

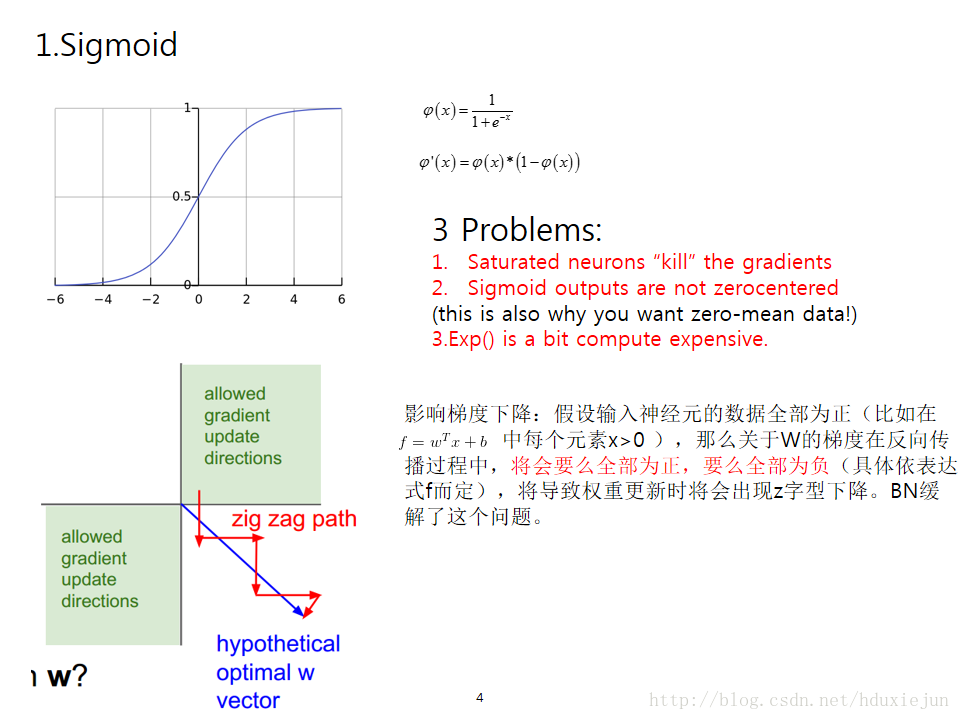

1.sigmoid

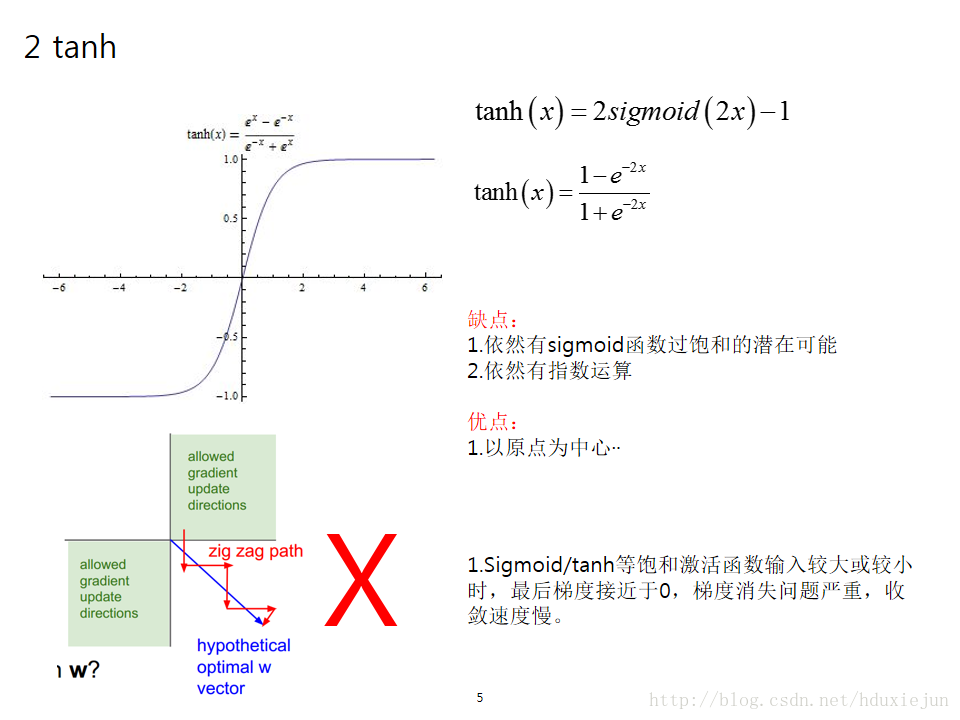

2.tanh

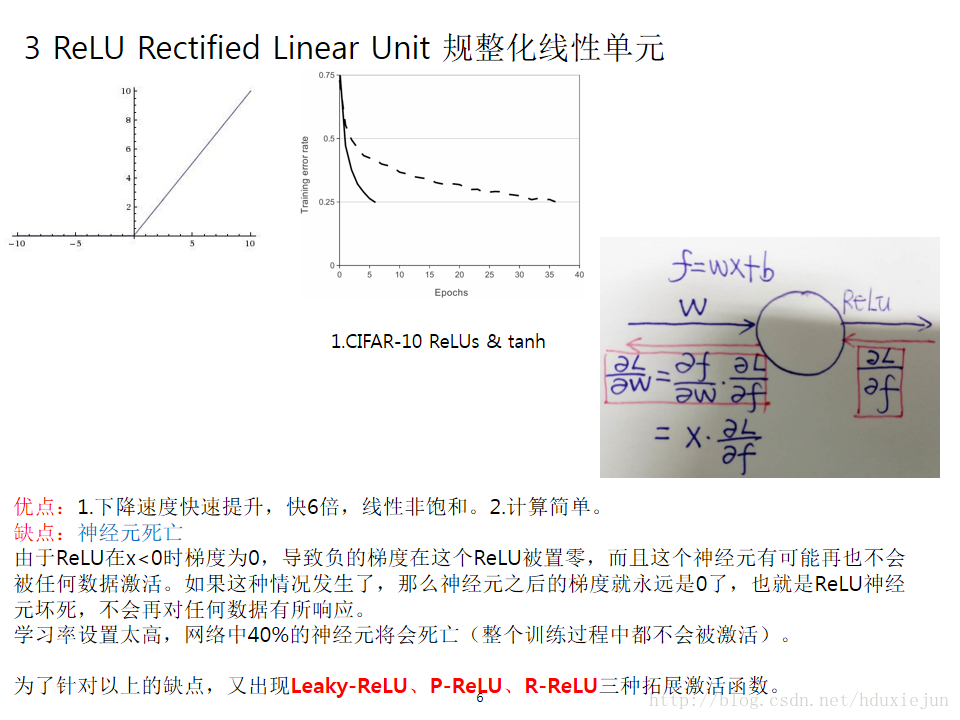

3.ReLu

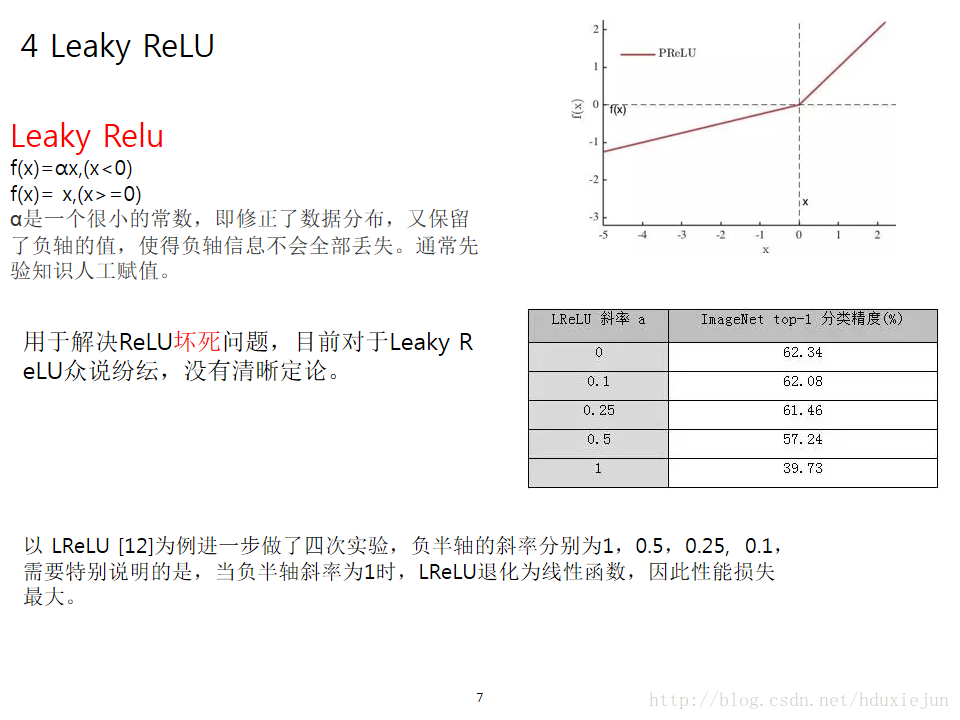

4.Leaky ReLu

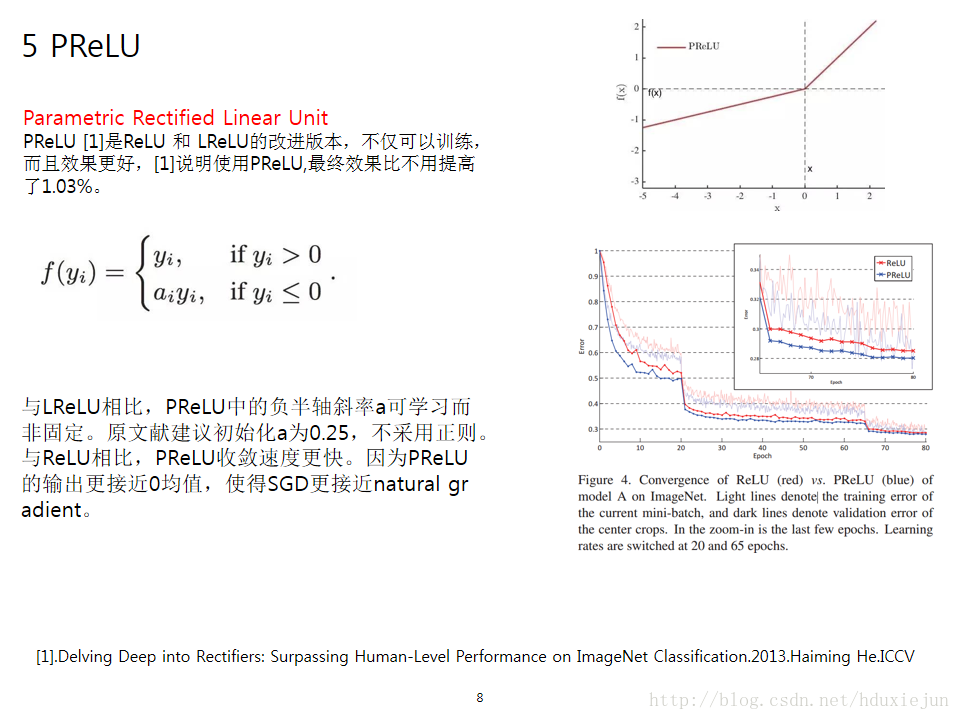

5.PReLu

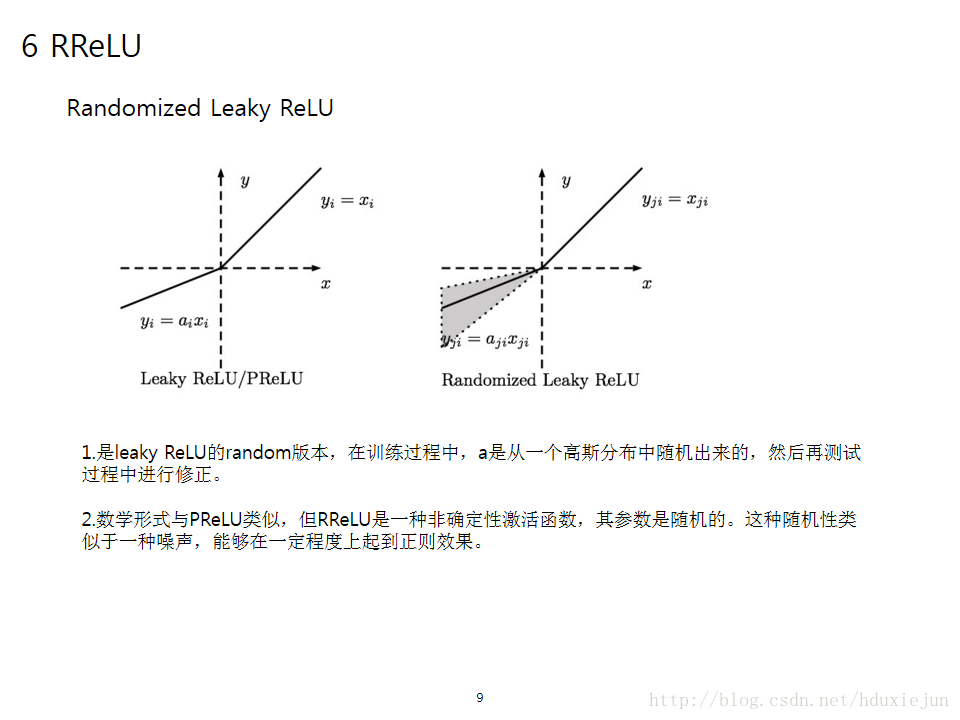

6.RReLu

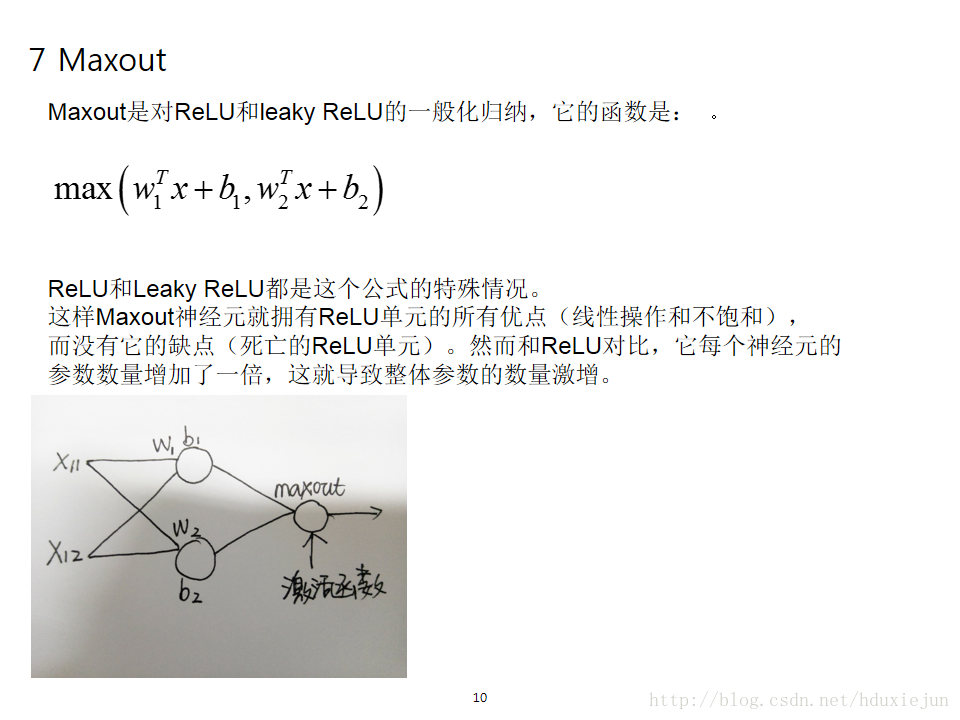

7 Maxout

8 SELU

总结

是ELU的改进版本,参考文献:

[ReLu]:Rectifier Nonlinearities Improve Neural Network Acoustic Models

[PRelu]:Delving Deep into Rectifiers:Surpassing Human-Level Performance on ImageNet Classification

相关文章推荐

- 深度学习/神经神经网络常用激活函数总结

- 机器学习总结(七):基本神经网络、BP算法、常用激活函数对比

- 神经网络五:常用的激活函数

- cs231n 卷积神经网络与计算机视觉 5 神经网络基本结构 激活函数总结

- 神经网络激活函数总结

- 神经网络的激活函数总结

- 神经网络激活函数总结

- 神经网络常用激活函数

- 神经网络常用激活函数及其应用举例

- 神经网络常用激活函数对比:sigmoid VS sofmax(附python源码)

- 正则化方法总结和常用的激活函数

- 【深度学习技术】卷积神经网络常用激活函数总结

- 神经网络之激活函数面面观

- 神经网络中的激活函数

- Linux socket 网络编程常用函数总结

- 深度学习神经网络激活函数的优点

- 神经网络-激活函数对比

- 深度学习小白——神经网络1(激活函数)

- python绘制神经网络中的Sigmoid和Tanh激活函数图像(附代码)

- 机器学习09--神经网络的激活函数(Activation Function)及python代码实现