构建多层卷积网络

2018-04-07 18:49

274 查看

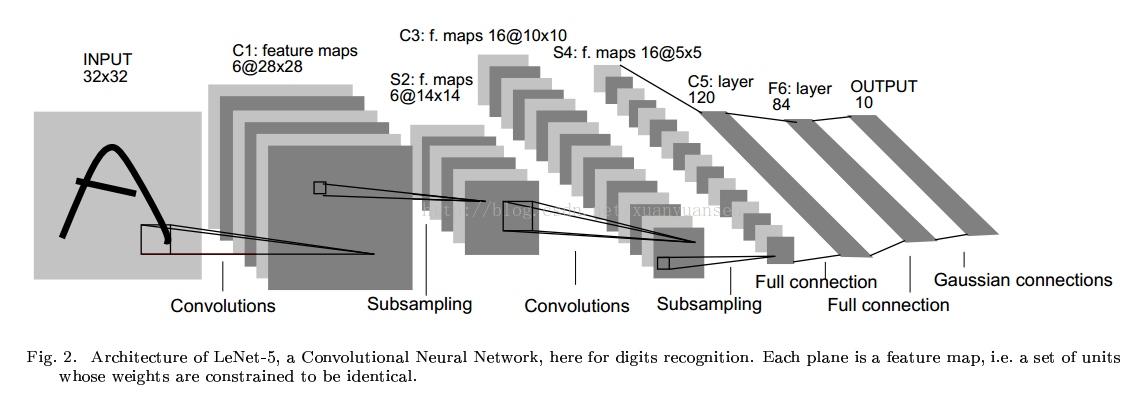

首先给大家来一张卷积神经网络的结构图

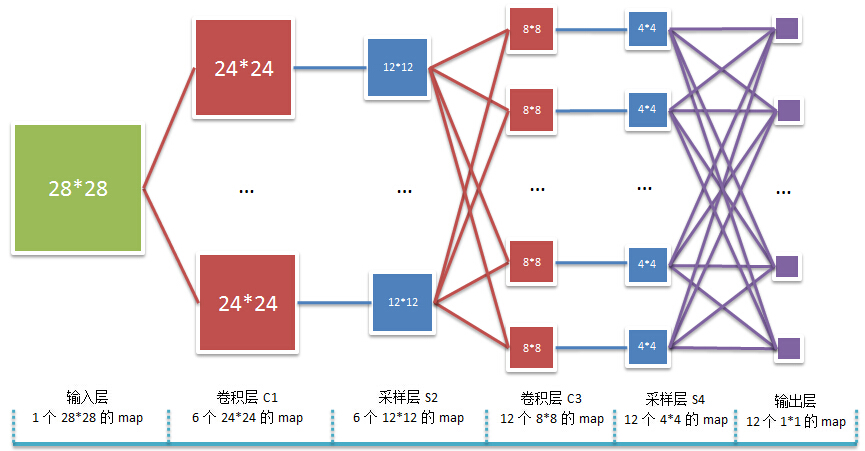

下面这张比较易懂

接下来具体以构建多层卷积神经网络为主,大家可以作为参考。

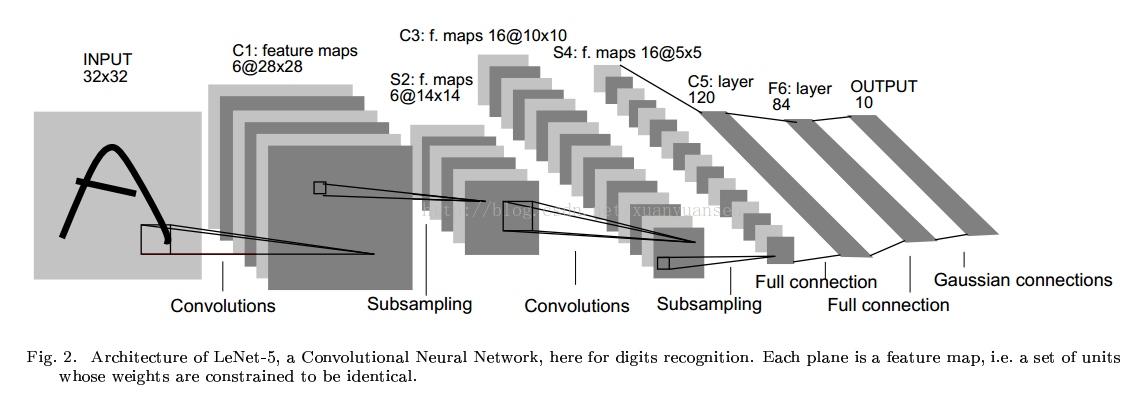

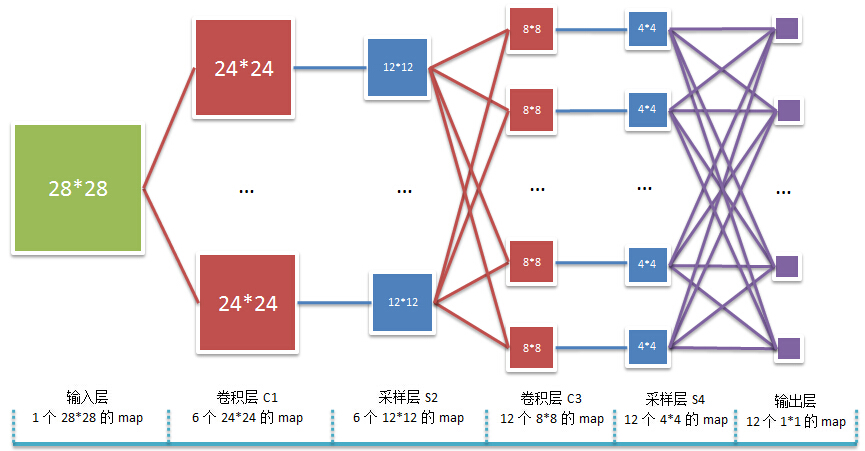

下面这张比较易懂

接下来具体以构建多层卷积神经网络为主,大家可以作为参考。

权重初始化

为了创建模型,需要创建大量的权重和偏置项。使用的是ReLU神经元,所以使用一个较小的正数来初始化偏置项,避免神经元节点输出恒为0。定义两个函数进行初始化。def weight_variable(shape): initial = tf.truncated_normal(shape,stddev = 0.1) return tf.Variable(initial) def bias_variable(shape): initial = tf.constant(0.1,shape = shape) return tf.Variable(initial)

卷积和池化

卷积使用1步长,0边距的模板,保证输入和输出是同一个大小。我们的池化用简单的2x2大小的模板做max pooling。def conv2d(x,W): return tf.nn.conv2d(x,W,strides = [1,1,1,1],padding = 'SAME') def max_pool_2x2(x): return tf.nn.max_pool(x,ksize=[1,2,2,1],strides=[1,2,2,1],padding='SAME')

第一层卷积

第一层卷积是由一个卷积接一个max pooling完成。卷积在每个5x5的patch中算出32个特征。卷积的权重张量形状是[5,5,1,32],前两个是patch的大小,接着是输入的通道数目,最后的是输出的通道数目,每一个输出通道都有一个偏置量。W_conv1 = weight_variable([5,5,1,32]) b_conv1 = bias_variable([32])把x_image和权值向量进行卷积,加上偏置项,然后用ReLU激活函数,进行max pooling。

h_conv1 = tf.nn. relu(conv2d(x_image,W_conv1) + b_conv1) h_pool1 = max_pool_2x2(h_conv1)

第二层卷积

第二层中,每个5x5的patch会得到64个特征。W_conv2 = weight_variable([5,5,32,64]) b_conv2 = bias_variable([64]) h_conv2 = tf.nn.relu(conv2d(h_pool1,W_conv2)+b_conv2) h_pool2 = max_pool_2x2(h_conv2)

密集连接层

图片尺寸减小到7x7,加入一个有1024个神经元的全连接层,用于处理整个图片。把池化层输出的张量reshape成一些向量,乘上权重矩阵,加上偏置,然后对其使用Relu。W_fc1 = weight_variable([7 * 7 * 64,1024]) b_fc1 = bias_variable([1024]) h_pool2_flat = tf.reshape(h_pool2,[-1,7 * 7 * 64]) h_fc1 = tf.nn.relu(tf.matmul(h_pool2_flat,W_fc1) + b_fc1)

Dropout

为了减少过拟合,在输出层前加入dropout.用一个placeholder代表一个神经元的输出在dropout中保持不变的概率。在训练过程启用,在测试过程关闭。keep_prob = tf.placeholder("float")

h_fc1_drop = tf.nn.dropout(h_fc1,keep_prob)输出层

添加一个softmax层。W_fc2 = weight_variable([1024,10]) b_fc2 = bias_variable([10]) y_conv = tf.nn.softmax(tf.matmul(h_fc1_drop,W_fc2) + b_fc2)

训练和评估模型

cross_entropy = -tf.reduce_sum(y * tf.log(y_conv))

train_step = tf.train.AdamOptimizer(1e-4).minimize(cross_entropy)

correct_prediction = tf.equal(tf.argmax(y_conv,1),tf.argmax(y_,1))

accuracy = tf.reduce_mean(tf.cast(correct_prediction,"float"))

sess.run(tf.initialize_all_variables())

for i in range(20000):

batch = mnist.train.next_batch(50)

if i % 100 == 0:

train_accuracy = accuracy.eval(feed_dict = {x:batch[0],y_:batch[1],keep_prob:0.5})

print "step % d,training accuracy % g" % (i,train_accuracy)

train_step.run(feed_dict = {x:batch[0],y_:batch[1],keep_prob:0.5})

print "test accuracy % g" % accuracy.eval(feed_dict={x:mnist.test.image,y_:mnist.test.labels,keep_prob:1.0})

相关文章推荐

- 使用Keras快速构建集成卷积网络模型

- 神经网络入门之构建多层网络

- 在浏览器中进行深度学习:TensorFlow.js (六)构建一个卷积网络 Convolutional Network

- tensorflow1.1/构建深度卷积神经网络识别物体识别

- TensorFlow学习笔记(1)对多层卷积网络识别MNIST(MNIST进阶)的理解

- Deep learning:三十六(关于构建深度卷积SAE网络的一点困惑)

- Tensorflow学习——MNIST多层卷积网络解决方案

- 基于TensorFlow解决手写数字识别的Softmax方法、多层卷积网络方法和前馈神经网络方法

- (五)神经网络入门之构建多层网络

- TensorFlow学习--创建多层卷积网络

- 学习笔记CB009:人工神经网络模型、手写数字识别、多层卷积网络、word2vec

- Deep learning:三十六(关于构建深度卷积SAE网络的一点困惑)

- Tensorflow学习笔记(四)——深入MNIST(多层卷积网络)

- 构建多层交换与可扩展的企业网络(CCNP)

- 目前的研究兴趣-----构建多层交换网络

- tensorflow多层卷积网络入门

- Tensorflow 构建一个多层cnn网络,附注释。

- 构建AIX环境下的RAC之--配置网络(2)

- Juniper:努力为用户构建高性能网络

- 利用OpenVSwitch构建多主机Docker网络