如何判断爬虫采集内容是否违法?

2018-01-12 20:59

447 查看

前言

随着大数据和人工智能的火爆,网络爬虫也被大家熟知起来;随之也出现一个问题,网络爬虫违法吗?符合道德吗?本文将详细介绍网络爬虫是否违法,希望帮助你解决爬虫是否违法带来的困扰。网络爬虫大多数情况都不违法

网络爬虫在大多数情况中都不违法,其实我们生活中几乎每天都在爬虫应用,如百度,你在百度中搜索到的内容几乎都是爬虫采集下来的(百度自营的产品除外,如百度知道、百科等),所以网络爬虫作为一门技术,技术本身是不违法的,且在大多数情况下你都可以放心大 胆的使用爬虫技术。当然也有特殊情况,请看下一章节。哪些情况下网络爬虫采集数据后具备法律风险

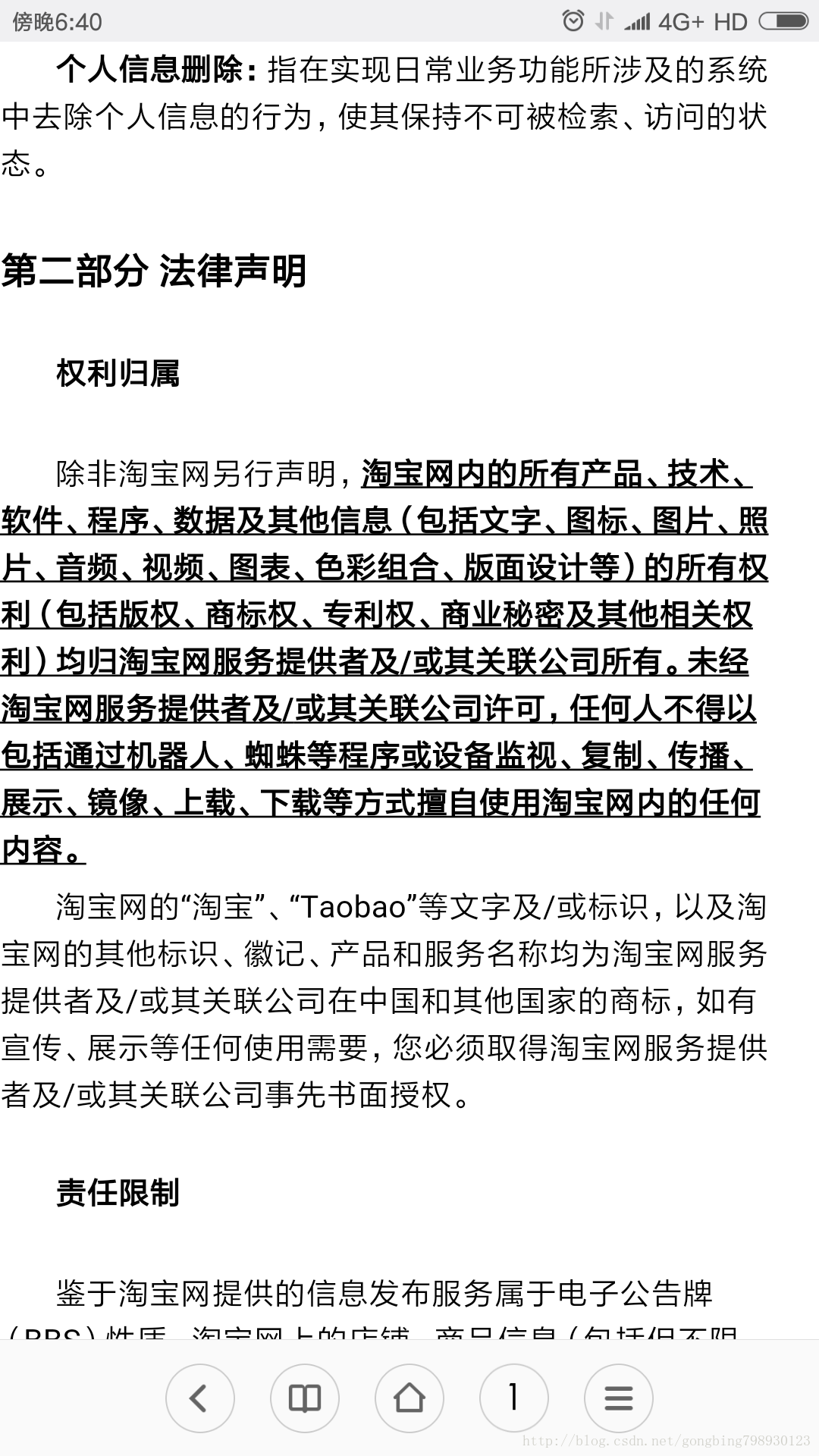

1.当采集的站点有声明禁止爬虫采集或者转载商业化时。

法律声明-禁止爬虫采集条款示例(图)

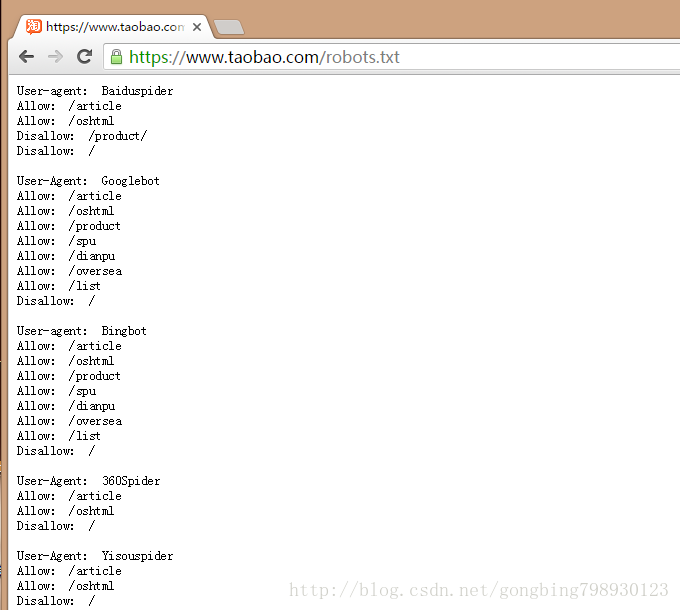

2.当网站声明了rebots协议

rebots协议简介

Robots协议(也称为爬虫协议、机器人协议等)的全称是“网络爬虫排除标准”(Robots Exclusion Protocol),网站通过Robots协议告诉爬虫哪些页面可以抓取,哪些页面不能抓取。robots.txt文件是一个文本文件,使用任何一个常见的文本编辑器,比如Windows系统自带的Notepad,就可以创建和编辑它。robots.txt是一个协议,而不是一个命令。robots.txt是搜索引擎中访问网站的时候要查看的第一个文件。robots.txt文件告诉蜘蛛程序在服务器上什么文件是可以被查看的。

如何查看采集的内容是的有rebots协议

其实方法很简单。你想查看的话就在IE上打http://你的网址/robots.txt要是说查看分析robots的话有专业的相关工具 站长工具就可以!

rebots协议示例图

总结

了解法律风险总是好的,免得以后掉进坑中了自己还不知道;毕竟没必要为了某件事或者某份工作影响自己的前程。关注微信公众号:DT数据技术博文 或 DtDataInfo ,有更多爬虫、大数据、人工智能干货等着你,下一节将分享,《工作需要老板让你用爬虫采集法律风险内容怎么办?》

相关文章推荐

- 如何判断两个char*所含内容是否相等

- java中如何判断String中的内容是否为数字?

- C#基础之如何判断两个文件内容是否相同

- 如何判断输入的内容中是否包含emoji表情

- 如何判断文件内容是否相同

- php判断访客是否是搜索引擎蜘蛛和向访客和爬虫显示不同的内容

- C# 如何判断两个文件内容是否相同的方法

- 如何判断一个对象的内容是否为空

- python:如何判断字符串中的内容是否都为数字

- java中如何判断String中的内容是否为数字?

- vc CListCtrl 如何判断列表中的内容是否被选中

- PHP,如何判断mysql语句是否有返回值、是否有内容

- vc CListCtrl 如何判断列表中的内容是否被选中?如何获取CListCtrl当前选中的行

- IFIX中如何判断历史采集是否停止

- 如何判断EditText的内容是否是正确IP格式

- GDI+如何判断一个点是否在区域内

- java 如何判断导入表格某列是否有重复数据

- 如何判断我的电脑是否为通过UEFI模式启动

- js如何判断输入是否为正整数、浮点数等数字的函数

- 如何判断一个整数数组中是否有重复元素?要求时间复杂度O(n),空间复杂度O(1)