python 爬虫系列(0) --- 初识网络爬虫

2017-09-02 00:00

681 查看

爬虫的几种尺寸

| 规模 | 小规模,数据量小,爬取速度不明显 | 中规模,数据规模大,爬取速度明显 | 大规模,搜索引擎,爬取速度关键 |

|---|---|---|---|

| 作用 | 爬取网页,玩转网页 | 爬取网站、系列网站 | 爬取全网 |

| 使用库 | Requests库 | Scrapy库 | 定制开发 |

爬虫带来的问题

对服务器的骚扰问题可能因为信息的产权造成法律问题

对个人用户隐私形成泄露

爬虫的的限制

来源审查:判断User-Agent检查来访http协议头的User-Agent域,只响应浏览器或者友好爬虫的的访问。

发布公告:Robots协议

告知所有爬虫网站的爬取策略,要求爬虫遵守。

Robots协议

Robots Exclusion Standrad 网络爬虫抓排除标准作用:网站告知网络爬虫哪些页面可以抓取,哪些不行。

形式:在网站的根目录下放置robots.txt文件。

robots协议基本语法

User-Agent:* #爬虫名称 Disallow:/ #网站根目录正则匹配

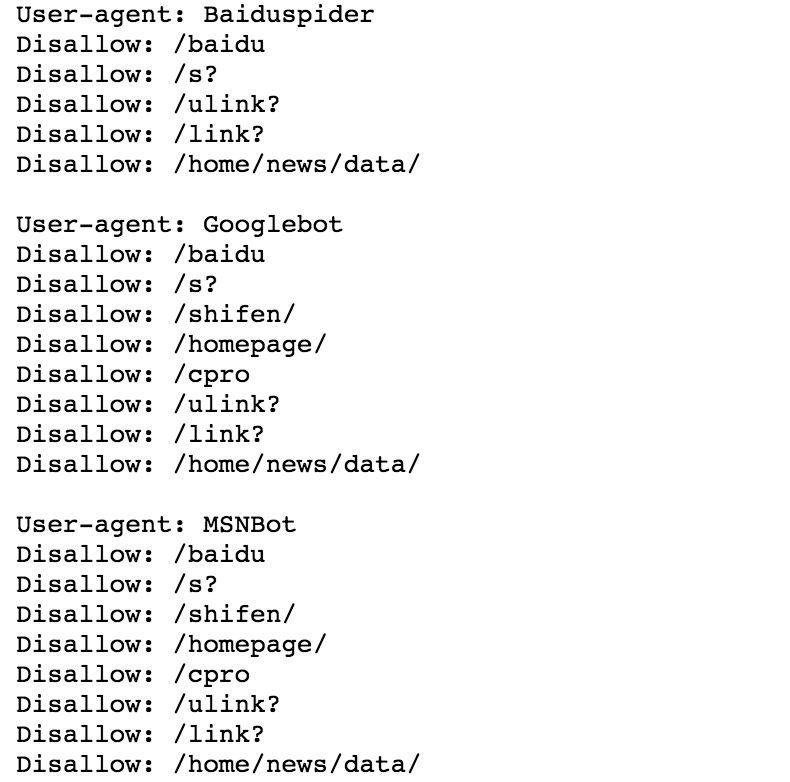

百度的robots.txt 部分截图样式

robots协议的使用

网络爬虫: 自动或者人工识别robots.txt,再进行内容爬取

约束性: Robots协议是建议而非约束性的,网络爬虫可以不遵守,但存在法律风险。

相关文章推荐

- 基于python3.4.3的Requests2.18.4爬虫学习系列之一 安装及初识

- python网络爬虫系列教程——python网络数据爬虫误区,让你的爬虫更像人类

- python网络爬虫之初识网络爬虫

- Python网络爬虫——1、初识网络爬虫

- Python爬虫系列(一)初期学习爬虫的拾遗与总结(6.8更)

- python3 网络爬虫(一)反爬虫之我见

- Python爬虫系列之----Scrapy(五)网页提取的三种方式(正则,Beautiful Soup,Lxml)

- python爬虫系列(六):强大的beautifulsoup

- [Python]网络爬虫(六):一个简单的百度贴吧的小爬虫

- Python爬虫系列之----Scrapy(七)使用IP代理池

- 初识python 学习笔记系列1

- Python爬虫系列(三)多线程爬取斗图网站(皮皮虾,我们上车)

- python网络爬虫系列教程——python中BeautifulSoup4库应用全解

- [Python]网络爬虫(11):亮剑!爬虫框架小抓抓Scrapy闪亮登场!

- 手把手教你学python第十八讲(初识爬虫)

- python网络爬虫系列教程——python中requests库应用全解

- 【python系列】python初识

- python爬虫学习系列教程

- python网络爬虫系列教程——PhantomJS包应用全解

- [Python]网络爬虫(12):爬虫框架Scrapy的第一个爬虫示例入门教程