maven学习笔记:使用eclipse的maven插件创建scala_spark项目

2017-08-25 10:45

309 查看

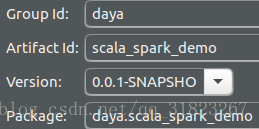

新建项目

新建maven项目:

右键项目,添加scala特性,这会自动添加scala依赖包:

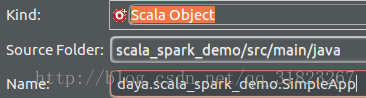

新建scala对象(注意此处项目的默认文件夹名是java而不是scala):

代码:

package daya.scala_spark_demo

import org.apache.spark.SparkContext

import org.apache.spark.SparkContext._

import org.apache.spark.SparkConf

object SimpleApp {

def main(args: Array[String]): Unit = {

val logFile = "/home/daya/test.txt"

val conf = new SparkConf().setAppName("Simple Application")

val sc = new SparkContext("local[1]","SimpleApp",conf) //本地模式

val logData = sc.textFile(logFile, 2).cache()

val numAs = logData.filter(line => line.contains("a")).count()

val numBs = logData.filter(line => line.contains("b")).count()

println("Lines with a: %s, Lines with b: %s".format(numAs, numBs))

}

}编译配置

修改pom.xml文件:<dependency> <groupId>junit</groupId> <artifactId>junit</artifactId> <version>4.12</version> <scope>test</scope> </dependency> <dependency> <groupId>org.apache.spark</groupId> <artifactId>spark-core_2.11</artifactId> <version>2.2.0</version> </dependency>

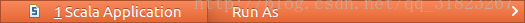

运行

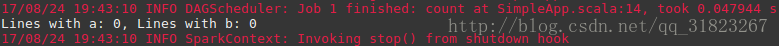

输出:

相关文章推荐

- maven学习笔记:使用eclipse的maven插件创建java_spark项目

- maven学习笔记:命令行模式创建scala_spark项目并运行程序

- [使用心得]maven2之m2eclipse使用手册之六使用Maven2插件创建一个简单的SSH2项目之jetty篇(三)

- 使用Eclipse自带的Maven插件创建Web项目时报错:Could not resolve archetype org.apache.maven.archetypes:maven-archetyp

- Scala学习10之在eclipse下使用maven对spark和adam中的scalatest进行测试

- [使用心得]maven2之m2eclipse使用手册之六使用Maven2插件创建一个简单的SSH2项目之glassfish篇(一)

- 标准版eclipse配置J2EE插件,使用maven创建web项目(spring JDBC)

- Eclipse创建包含Scala的Maven工程_Spark学习demo

- 使用Eclipse自带的Maven插件创建Web项目时报错:

- Maven学习总结(七)——eclipse中使用Maven创建Web项目

- Eclipse使用Maven插件创建Web项目时出错:Could not resolve archetype org.apache.maven.archetypes

- Maven学习总结(二)—— eclipse中使用Maven创建Web项目

- 使用Eclipse自带的Maven插件创建Web项目时报错:

- 使用Eclipse自带的Maven插件创建Web项目时报错: Could not resolve archetype org.apache.maven.archetypes:maven-arche

- Maven学习总结(7)——eclipse中使用Maven创建Web项目

- Maven学习总结(七)——eclipse中使用Maven创建Web项目

- 使用eclipse+tomcat+maven插件创建web项目

- 使用Eclipse自带的Maven插件创建Web项目时报错:

- Maven学习总结(7)——eclipse中使用Maven创建Web项目