PyCharm配置Spark开发环境

2016-12-20 19:59

225 查看

mac版

伪分布式

首先安装py4j

在 ~/.bash_profile 里添加:

#Spark environment configs

export SPARK_HOME=/usr/local/Cellar/apache-spark/1.6.0/libexec

export PATH=$PATH:${SPARK_HOME}/bin

#Python environment configs

PYTHONPATH=/Users/xiaocong/Envs/py/bin/python

PYTHONPATH=$SPARK_HOME/libexec/python:$SPARK_HOME/libexec/python/build:$PYTHONPATH

export PYTHONPATH=$SPARK_HOME/libexec/python/:$SPARK_HOME/libexec/python/lib/py4j-0.9-src.zip:$PYTHONPATH

export PATH="/usr/local/sbin:$PATH"

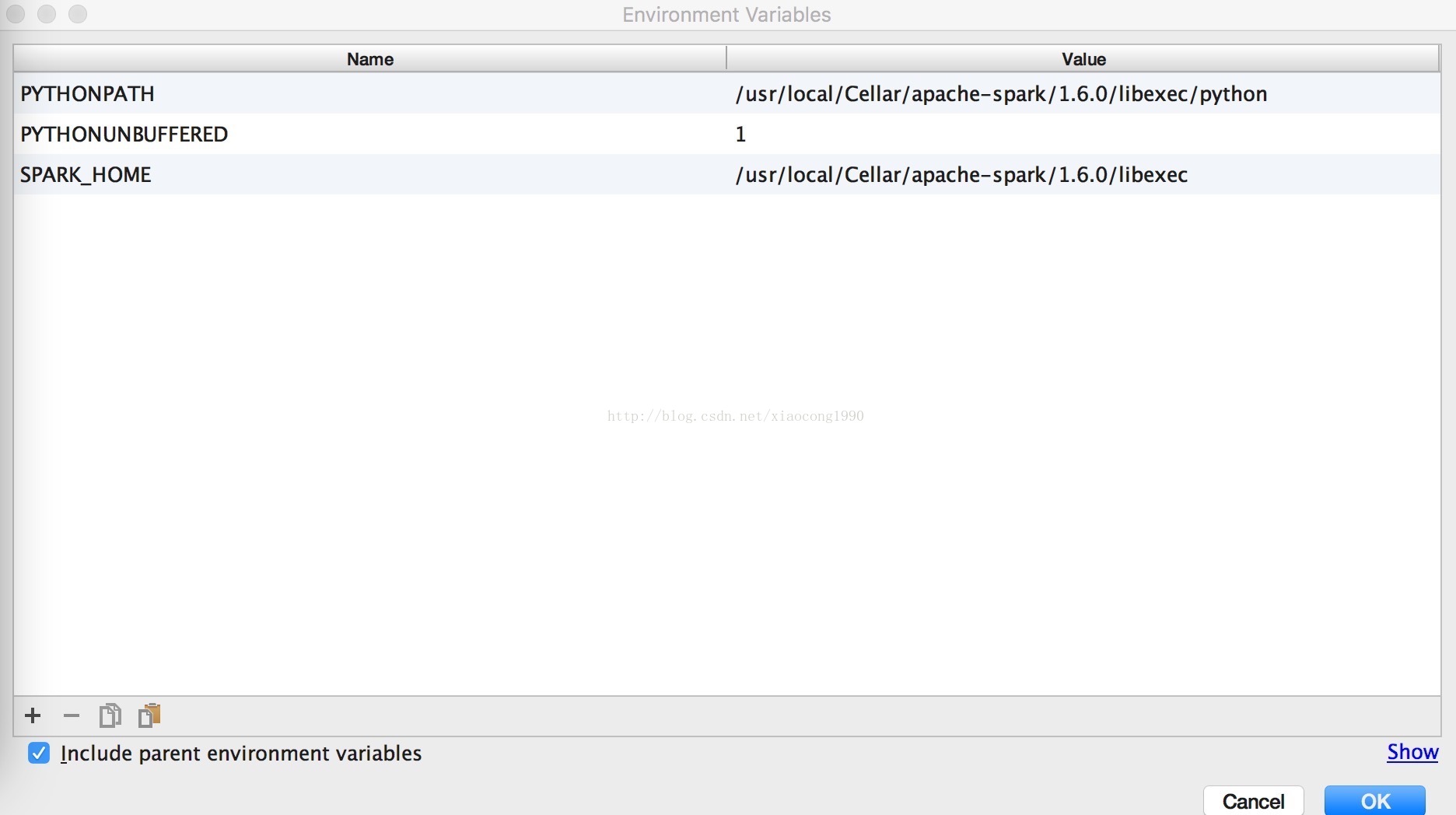

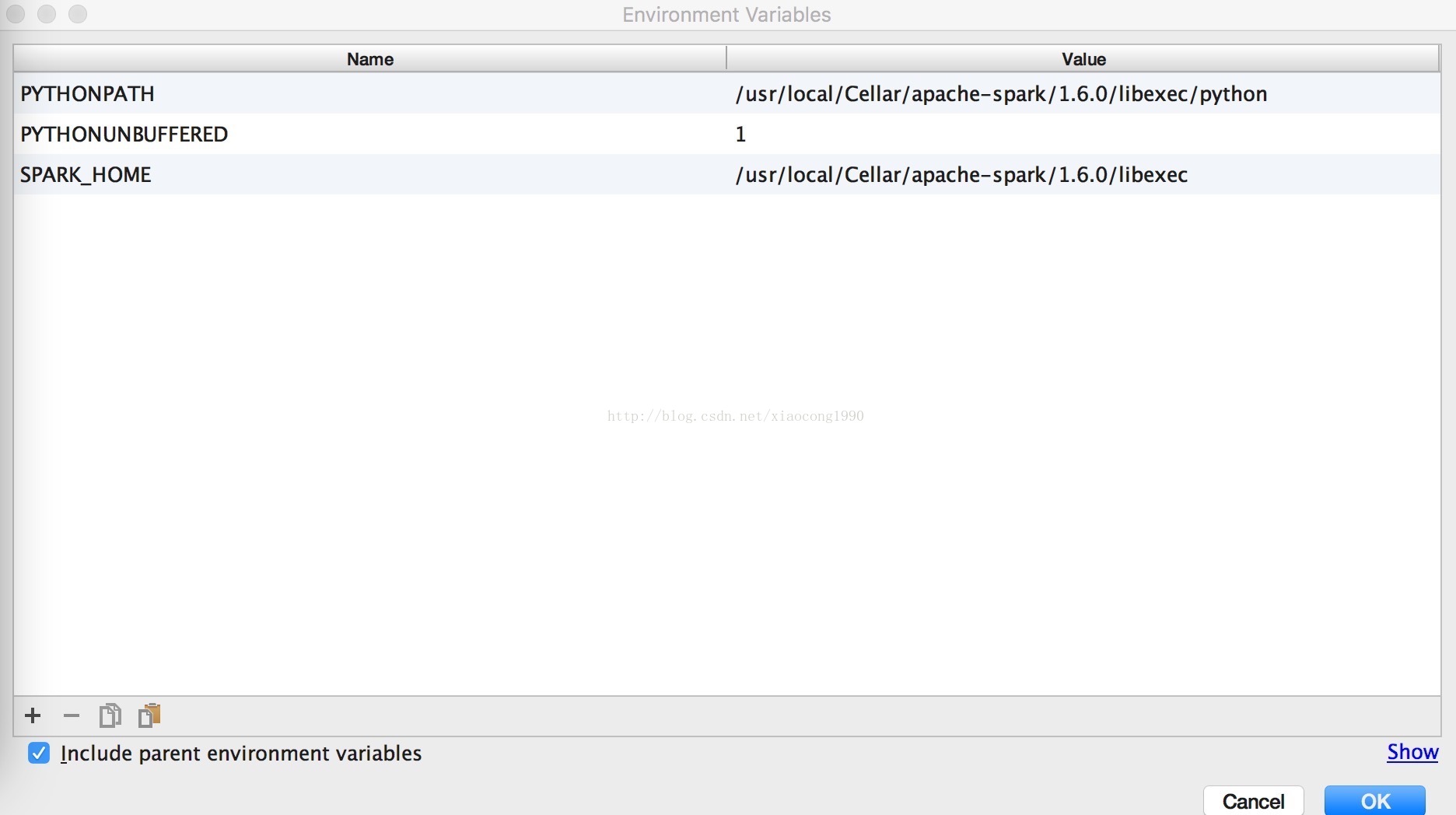

打开PyCharm,创建一个Project。然后选择"Run"->"Edit Configurations"->"Environment variables"

增加SPARK_HOME目录和PYTHONPATH目录。

其中,SPARK_HOME:Spark安装目录

PYTHONPATH:Spark安装目录下的Python目录

试运行:

from pyspark import SparkConf,SparkContext

sc=SparkContext("local[2]","first")

user_data=sc.textFile("u.user")

user_fields=user_data.map(lambda line:line.split("|"))

print user_fields

伪分布式

首先安装py4j

在 ~/.bash_profile 里添加:

#Spark environment configs

export SPARK_HOME=/usr/local/Cellar/apache-spark/1.6.0/libexec

export PATH=$PATH:${SPARK_HOME}/bin

#Python environment configs

PYTHONPATH=/Users/xiaocong/Envs/py/bin/python

PYTHONPATH=$SPARK_HOME/libexec/python:$SPARK_HOME/libexec/python/build:$PYTHONPATH

export PYTHONPATH=$SPARK_HOME/libexec/python/:$SPARK_HOME/libexec/python/lib/py4j-0.9-src.zip:$PYTHONPATH

export PATH="/usr/local/sbin:$PATH"

打开PyCharm,创建一个Project。然后选择"Run"->"Edit Configurations"->"Environment variables"

增加SPARK_HOME目录和PYTHONPATH目录。

其中,SPARK_HOME:Spark安装目录

PYTHONPATH:Spark安装目录下的Python目录

试运行:

from pyspark import SparkConf,SparkContext

sc=SparkContext("local[2]","first")

user_data=sc.textFile("u.user")

user_fields=user_data.map(lambda line:line.split("|"))

print user_fields

相关文章推荐

- 连接远程linux spark 配置windows 下pycharm开发环境

- 使用PyCharm配置Spark的Python开发环境(基础)

- 使用PyCharm配置Spark的Python开发环境

- 在CentOS中部署Python和配置PyCharm开发环境

- 在CentOS中配置PyCharm开发环境

- spark+hive win7开发环境配置

- pycharm 配置虚拟开发环境

- windows下spark开发环境配置

- 在eclipse中配置spark 0.9.1源码的开发环境

- 在CentOS中部署Python和配置PyCharm开发环境

- 配置spark开发环境1——资源准备

- spark eclipse 本地开发环境配置 以及应注意的问题

- Spark开发环境配置(windows/Intellij IDEA 篇)

- Spark开发环境及源码阅读环境配置

- Spark开发环境的配置

- spark+hive+hdfs windows开发环境配置:

- spark:配置Idea开发环境--14

- openfire-spark 二次开发-(二)运行环境配置

- PyQt5+python3+pycharm开发环境配置

- 配置spark开发环境2——安装centos